- ubuntu12.04环境下使用kvm ioctl接口实现最简单的虚拟机

- Ubuntu 通过无线网络安装Ubuntu Server启动系统后连接无线网络的方法

- 在Ubuntu上搭建网桥的方法

- ubuntu 虚拟机上网方式及相关配置详解

CFSDN坚持开源创造价值,我们致力于搭建一个资源共享平台,让每一个IT人在这里找到属于你的精彩世界.

这篇CFSDN的博客文章python面向对象多线程爬虫爬取搜狐页面的实例代码由作者收集整理,如果你对这篇文章有兴趣,记得点赞哟.

首先我们需要几个包:requests, lxml, bs4, pymongo, redis 。

1. 创建爬虫对象,具有的几个行为:抓取页面,解析页面,抽取页面,储存页面 。

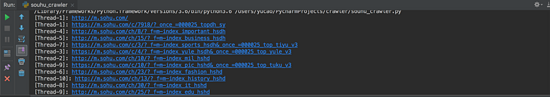

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

|

class

Spider(

object

):

def

__init__(

self

):

# 状态(是否工作)

self

.status

=

SpiderStatus.IDLE

# 抓取页面

def

fetch(

self

, current_url):

pass

# 解析页面

def

parse(

self

, html_page):

pass

# 抽取页面

def

extract(

self

, html_page):

pass

# 储存页面

def

store(

self

, data_dict):

pass

|

2. 设置爬虫属性,没有在爬取和在爬取中,我们用一个类封装, @unique使里面元素独一无二,Enum和unique需要从 enum里面导入:

|

1

2

3

4

|

@unique

class

SpiderStatus(Enum):

IDLE

=

0

WORKING

=

1

|

3. 重写多线程的类:

|

1

2

3

4

5

6

7

8

|

class

SpiderThread(Thread):

def

__init__(

self

, spider, tasks):

super

().__init__(daemon

=

True

)

self

.spider

=

spider

self

.tasks

=

tasks

def

run(

self

):

while

True

:

pass

|

4. 现在爬虫的基本结构已经做完了,在main函数创建tasks, Queue需要从queue里面导入:

|

1

2

3

4

5

6

7

8

9

10

11

12

13

|

def

main():

# list没有锁,所以使用Queue比较安全, task_queue=[]也可以使用,Queue 是先进先出结构, 即 FIFO

task_queue

=

Queue()

# 往队列放种子url, 即搜狐手机端的url

task_queue.put(

'http://m.sohu,com/'

)

# 指定起多少个线程

spider_threads

=

[SpiderThread(Spider(), task_queue)

for

_

in

range

(

10

)]

for

spider_thread

in

spider_threads:

spider_thread.start()

# 控制主线程不能停下,如果队列里有东西,任务不能停, 或者spider处于工作状态,也不能停

while

task_queue.empty()

or

is_any_alive(spider_threads):

pass

print

(

'Over'

)

|

4-1. 而 is_any_threads则是判断线程里是否有spider还活着,所以我们再写一个函数来封装一下

|

1

2

3

|

def

is_any_alive(spider_threads):

return

any

([spider_thread.spider.status

=

=

SpiderStatus.WORKING

for

spider_thread

in

spider_threads])

|

5. 所有的结构已经全部写完,接下来就是可以填补爬虫部分的代码,在SpiderThread(Thread)里面,开始写爬虫运行 run 的方法,即线程起来后,要做的事情:

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

|

def

run(

self

):

while

True

:

# 获取url

current_url

=

self

.tasks_queue.get()

visited_urls.add(current_url)

# 把爬虫的status改成working

self

.spider.status

=

SpiderStatus.WORKING

# 获取页面

html_page

=

self

.spider.fetch(current_url)

# 判断页面是否为空

if

html_page

not

in

[

None

, '']:

# 去解析这个页面, 拿到列表

url_links

=

self

.spider.parse(html_page)

# 把解析完的结构加到 self.tasks_queue里面来

# 没有一次性添加到队列的方法 用循环添加算求了

for

url_link

in

url_links:

self

.tasks_queue.put(url_link)

# 完成任务,状态变回IDLE

self

.spider.status

=

SpiderStatus.IDLE

|

6. 现在可以开始写 Spider()这个类里面的四个方法,首先写fetch()抓取页面里面的: 。

|

1

2

3

4

5

6

7

8

9

10

|

@Retry

()

def

fetch(

self

, current_url,

*

, charsets

=

(

'utf-8'

, ), user_agent

=

None

, proxies

=

None

):

thread_name

=

current_thread().name

print

(f

'[{thread_name}]: {current_url}'

)

headers

=

{

'user-agent'

: user_agent}

if

user_agent

else

{}

resp

=

requests.get(current_url,

headers

=

headers, proxies

=

proxies)

# 判断状态码,只要200的页面

return

decode_page(resp.content, charsets) \

if

resp.status_code

=

=

200

else

None

|

6-1. decode_page是我们在类的外面封装一个解码的函数:

|

1

2

3

4

5

6

7

8

9

10

|

def

decode_page(page_bytes, charsets

=

(

'utf-8'

,)):

page_html

=

None

for

charset

in

charsets:

try

:

page_html

=

page_bytes.decode(charset)

break

except

UnicodeDecodeError:

pass

# logging.error('Decode:', error)

return

page_html

|

6-2. @retry是装饰器,用于重试, 因为需要传参,在这里我们用一个类来包装, 所以最后改成@Retry()

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

|

# retry的类,重试次数3次,时间5秒(这样写在装饰器就不用传参数类), 异常

class

Retry(

object

):

def

__init__(

self

,

*

, retry_times

=

3

, wait_secs

=

5

, errors

=

(Exception, )):

self

.retry_times

=

retry_times

self

.wait_secs

=

wait_secs

self

.errors

=

errors

# call 方法传参

def

__call__(

self

, fn):

def

wrapper(

*

args,

*

*

kwargs):

for

_

in

range

(

self

.retry_times):

try

:

return

fn(

*

args,

*

*

kwargs)

except

self

.errors as e:

# 打日志

logging.error(e)

# 最小避让 self.wait_secs 再发起请求(最小避让时间)

sleep((random()

+

1

)

*

self

.wait_secs)

return

None

return

wrapper()

|

7. 接下来写解析页面的方法,即 parse()

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

|

# 解析页面

def

parse(

self

, html_page,

*

, domain

=

'm.sohu.com'

):

soup

=

BeautifulSoup(html_page,

'lxml'

)

url_links

=

[]

# 找body的有 href 属性的 a 标签

for

a_tag

in

soup.body.select(

'a[href]'

):

# 拿到这个属性

parser

=

urlparse(a_tag.attrs[

'href'

])

netloc

=

parser.netloc

or

domain

scheme

=

parser.scheme

or

'http'

netloc

=

parser.netloc

or

'm.sohu.com'

# 只爬取 domain 底下的

if

scheme !

=

'javascript'

and

netloc

=

=

domain:

path

=

parser.path

query

=

'?'

+

parser.query

if

parser.query

else

''

full_url

=

f

'{scheme}://{netloc}{path}{query}'

if

full_url

not

in

visited_urls:

url_links.append(full_url)

return

url_links

|

7-1. 我们需要在SpiderThread()的 run方法里面,在 。

|

1

|

current_url

=

self

.tasks_queue.get()

|

下面添加 。

|

1

|

visited_urls.add(current_url)

|

在类外面再添加一个 。

|

1

|

visited_urls

=

set

()去重

|

8. 现在已经能开始抓取到相应的网址.

总结 。

以上所述是小编给大家介绍的python面向对象多线程爬虫爬取搜狐页面的实例代码,希望对大家有所帮助,如果大家有任何疑问请给我留言,小编会及时回复大家的。在此也非常感谢大家对我网站的支持! 。

原文链接:https://www.tuicool.com/articles/URva2ey 。

最后此篇关于python面向对象多线程爬虫爬取搜狐页面的实例代码的文章就讲到这里了,如果你想了解更多关于python面向对象多线程爬虫爬取搜狐页面的实例代码的内容请搜索CFSDN的文章或继续浏览相关文章,希望大家以后支持我的博客! 。

我在字符串中有一个大词。例子白 Wine 额外优惠。 我想在第一行使用“White”,在第二行使用“wine extra offer”。使用下面的代码: string value="White win

我想在无符号中执行一些算术运算,需要取负整数的绝对值,比如 do_some_arithmetic_in_unsigned_mode(int some_signed_value) { unsign

我正在努力使用 data.table 来总结向量函数的结果,这在 ddply 中很容易。 问题 1:使用带有矢量输出的(昂贵的)函数聚合 dt dt[ , as.list(quantile(x)),

我有两个分数列表; 说 A = [ 1/212, 5/212, 3/212, ... ] 和 B = [ 4/143, 7/143, 2/143, ... ] . 如果我们定义 A' = a[0] *

我已经使用 numpy 从 csv 文件中获取数据。 numpy 数组的尺寸为:100*20。我如何取列的平均值(比如 col 3,5,8)并用包含这 3 个 cols 平均值的新列替换它们 如果

在 Rust 中取任意数的 n 次根的最佳方法是什么?例如,num crate 只允许取整数类型的第 n 个主根,即 floor'ed 或 ceil'ed 值......如何最好地接近实际值? 最佳答

看起来这应该很容易,但我很困惑。我已经掌握了使用 dplyr 进行编程的大致技巧0.7,但为此苦苦挣扎:How do Iprogram in dplyr我想要编程的变量是否是一个字符串? 我正在抓取数

在 Rust 中取任意数的 n 次根的最佳方法是什么?例如,num crate 只允许取整数类型的第 n 个主根,即 floor'ed 或 ceil'ed 值......如何最好地接近实际值? 最佳答

我有一个 pandas 数据框,其中有一列名为“coverage”。对于一系列特定索引值,我想获取前 100 行的平均“覆盖率”值。例如,对于索引位置 1001,我想要第 901-1000 行的平均“

import pandas as pd data = {'date': ['1998-03-01', '2001-04-01','1998-06-01','2001-08-01','2001-05-0

我有一个包含 100 个数字的 NSArray。我想创建一个 5 个数字的 NSArray。第二个数组中的第一个数字是第一个数组中前 20 个数字的平均值。第二个数字是第一个数组中第二组 20 个数字

我该怎么做?我试过 abs() 但它只适用于整数。有内置的方法吗? CGFloat flo = -123; abs(flo) 返回 0 最佳答案 使用 fabs() CGFloat f = -123.

我正在采用以下计算的 log2: tl_out.a.bits.size := log2Ceil(s1_row * s2_column * 4.U) 其中,s1_row 和 s2_column 是 UI

如何从 m 个元素集合中取出 n 个元素,以便在元素用完时从头开始? List list = new List() {1, 2, 3, 4, 5, 6, 7, 8, 9, 10}; List newL

我已经完成了研究,但似乎找不到有关该主题的足够文档。 在 Object streams 上尝试一些代码时,我注意到将 BufferedOutputStream 放入 ObjectOutputStrea

我需要计算数据中连续时间组之间的差异,如下所示 from io import StringIO import pandas as pd strio = StringIO("""\

我在 Mongo 数据库中有以下文档: { _id: 1, question: "Blue or red?", __v: 0, votes: [9, 5] } 我想在后

好吧,宇宙中一定有人知道这个问题的答案。 我已经在这里问过这个问题,但仍然没有解决方案。 我需要保留和换行 div 中的文本。到目前为止,我很难想出解决方案。我找到的最佳解决方案并不适用于所有浏览器。

我正在尝试采用 3 个单独的整数输入(年、月、日)并采用这 3 个条目并从中形成一个日期对象,以便我可以使用它来比较其他日期。 这是我目前所拥有的,不知从何而来: public void compar

在我的 IOS 项目中,我有一个包含该函数的自定义 Logger 类(单例) - (void)log:(NSString *)domain logLevel:(int)level logMessage

我是一名优秀的程序员,十分优秀!