- ubuntu12.04环境下使用kvm ioctl接口实现最简单的虚拟机

- Ubuntu 通过无线网络安装Ubuntu Server启动系统后连接无线网络的方法

- 在Ubuntu上搭建网桥的方法

- ubuntu 虚拟机上网方式及相关配置详解

CFSDN坚持开源创造价值,我们致力于搭建一个资源共享平台,让每一个IT人在这里找到属于你的精彩世界.

这篇CFSDN的博客文章关于tensorflow softmax函数用法解析由作者收集整理,如果你对这篇文章有兴趣,记得点赞哟.

如下所示:

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

|

def

softmax(logits, axis

=

None

, name

=

None

, dim

=

None

):

"""Computes softmax activations.

This function performs the equivalent of

softmax = tf.exp(logits) / tf.reduce_sum(tf.exp(logits), axis)

Args:

logits: A non-empty `Tensor`. Must be one of the following types: `half`,

`float32`, `float64`.

axis: The dimension softmax would be performed on. The default is -1 which

indicates the last dimension.

name: A name for the operation (optional).

dim: Deprecated alias for `axis`.

Returns:

A `Tensor`. Has the same type and shape as `logits`.

Raises:

InvalidArgumentError: if `logits` is empty or `axis` is beyond the last

dimension of `logits`.

"""

axis

=

deprecation.deprecated_argument_lookup(

"axis"

, axis,

"dim"

, dim)

if

axis

is

None

:

axis

=

-

1

return

_softmax(logits, gen_nn_ops.softmax, axis, name)

|

softmax函数的返回结果和输入的tensor有相同的shape,既然没有改变tensor的形状,那么softmax究竟对tensor做了什么?

答案就是softmax会以某一个轴的下标为索引,对这一轴上其他维度的值进行 激活 + 归一化处理.

一般来说,这个索引轴都是表示类别的那个维度(tf.nn.softmax中默认为axis=-1,也就是最后一个维度) 。

举例:

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

|

def

softmax(X, theta

=

1.0

, axis

=

None

):

"""

Compute the softmax of each element along an axis of X.

Parameters

----------

X: ND-Array. Probably should be floats.

theta (optional): float parameter, used as a multiplier

prior to exponentiation. Default = 1.0

axis (optional): axis to compute values along. Default is the

first non-singleton axis.

Returns an array the same size as X. The result will sum to 1

along the specified axis.

"""

# make X at least 2d

y

=

np.atleast_2d(X)

# find axis

if

axis

is

None

:

axis

=

next

(j[

0

]

for

j

in

enumerate

(y.shape)

if

j[

1

] >

1

)

# multiply y against the theta parameter,

y

=

y

*

float

(theta)

# subtract the max for numerical stability

y

=

y

-

np.expand_dims(np.

max

(y, axis

=

axis), axis)

# exponentiate y

y

=

np.exp(y)

# take the sum along the specified axis

ax_sum

=

np.expand_dims(np.

sum

(y, axis

=

axis), axis)

# finally: divide elementwise

p

=

y

/

ax_sum

# flatten if X was 1D

if

len

(X.shape)

=

=

1

: p

=

p.flatten()

return

p

c

=

np.random.randn(

2

,

3

)

print

(c)

# 假设第0维是类别,一共有里两种类别

cc

=

softmax(c,axis

=

0

)

# 假设最后一维是类别,一共有3种类别

ccc

=

softmax(c,axis

=

-

1

)

print

(cc)

print

(ccc)

|

结果:

|

1

2

3

4

5

6

7

8

9

|

c:

[[

-

1.30022268

0.59127472

1.21384177

]

[

0.1981082

-

0.83686108

-

1.54785864

]]

cc:

[[

0.1826746

0.80661068

0.94057075

]

[

0.8173254

0.19338932

0.05942925

]]

ccc:

[[

0.0500392

0.33172426

0.61823654

]

[

0.65371718

0.23222472

0.1140581

]]

|

可以看到,对axis=0的轴做softmax时,输出结果在axis=0轴上和为1(eg: 0.1826746+0.8173254),同理在axis=1轴上做的话结果的axis=1轴和也为1(eg: 0.0500392+0.33172426+0.61823654).

这些值是怎么得到的呢?

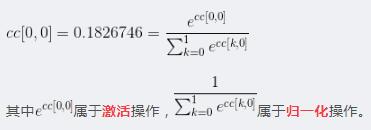

以cc为例(沿着axis=0做softmax):

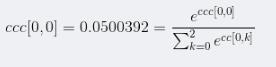

以ccc为例(沿着axis=1做softmax):

知道了计算方法,现在我们再来讨论一下这些值的实际意义:

cc[0,0]实际上表示这样一种概率: P( label = 0 | value = [-1.30022268 0.1981082] = c[*,0] ) = 0.1826746 。

cc[1,0]实际上表示这样一种概率: P( label = 1 | value = [-1.30022268 0.1981082] = c[*,0] ) = 0.8173254 。

ccc[0,0]实际上表示这样一种概率: P( label = 0 | value = [-1.30022268 0.59127472 1.21384177] = c[0]) = 0.0500392 。

ccc[0,1]实际上表示这样一种概率: P( label = 1 | value = [-1.30022268 0.59127472 1.21384177] = c[0]) = 0.33172426 。

ccc[0,2]实际上表示这样一种概率: P( label = 2 | value = [-1.30022268 0.59127472 1.21384177] = c[0]) = 0.61823654 。

将他们扩展到更多维的情况:假设c是一个[batch_size , timesteps, categories]的三维tensor 。

output = tf.nn.softmax(c,axis=-1) 。

那么 output[1, 2, 3] 则表示 P(label =3 | value = c[1,2] ) 。

以上这篇关于tensorflow softmax函数用法解析就是小编分享给大家的全部内容了,希望能给大家一个参考,也希望大家多多支持我.

原文链接:https://blog.csdn.net/zongza/article/details/88016668 。

最后此篇关于关于tensorflow softmax函数用法解析的文章就讲到这里了,如果你想了解更多关于关于tensorflow softmax函数用法解析的内容请搜索CFSDN的文章或继续浏览相关文章,希望大家以后支持我的博客! 。

我想将模型及其各自训练的权重从 tensorflow.js 转换为标准 tensorflow,但无法弄清楚如何做到这一点,tensorflow.js 的文档对此没有任何说明 我有一个 manifest

我有一个运行良好的 TF 模型,它是用 Python 和 TFlearn 构建的。有没有办法在另一个系统上运行这个模型而不安装 Tensorflow?它已经经过预训练,所以我只需要通过它运行数据。 我

当执行 tensorflow_model_server 二进制文件时,它需要一个模型名称命令行参数,model_name。 如何在训练期间指定模型名称,以便在运行 tensorflow_model_s

我一直在 R 中使用标准包进行生存分析。我知道如何在 TensorFlow 中处理分类问题,例如逻辑回归,但我很难将其映射到生存分析问题。在某种程度上,您有两个输出向量而不是一个输出向量(time_t

Torch7 has a library for generating Gaussian Kernels在一个固定的支持。 Tensorflow 中有什么可比的吗?我看到 these distribu

在Keras中我们可以简单的添加回调,如下所示: self.model.fit(X_train,y_train,callbacks=[Custom_callback]) 回调在doc中定义,但我找不到

我正在寻找一种在 tensorflow 中有条件打印节点的方法,使用下面的示例代码行,其中每 10 个循环计数,它应该在控制台中打印一些东西。但这对我不起作用。谁能建议? 谢谢,哈米德雷萨, epsi

我想使用 tensorflow object detection API 创建我自己的 .tfrecord 文件,并将它们用于训练。该记录将是原始数据集的子集,因此模型将仅检测特定类别。我不明白也无法

我在 TensorFlow 中训练了一个聊天机器人,想保存模型以便使用 TensorFlow.js 将其部署到 Web。我有以下内容 checkpoint = "./chatbot_weights.c

我最近开始学习 Tensorflow,特别是我想使用卷积神经网络进行图像分类。我一直在看官方仓库中的android demo,特别是这个例子:https://github.com/tensorflow

我目前正在研究单图像超分辨率,并且我设法卡住了现有的检查点文件并将其转换为 tensorflow lite。但是,使用 .tflite 文件执行推理时,对一张图像进行上采样所需的时间至少是使用 .ck

我注意到 tensorflow 的 api 中已经有批量标准化函数。我不明白的一件事是如何更改训练和测试之间的程序? 批量归一化在测试和训练期间的作用不同。具体来说,在训练期间使用固定的均值和方差。

我创建了一个模型,该模型将 Mobilenet V2 应用于 Google colab 中的卷积基础层。然后我使用这个命令转换它: path_to_h5 = working_dir + '/Tenso

代码取自:- http://adventuresinmachinelearning.com/python-tensorflow-tutorial/ import tensorflow as tf fr

好了,所以我准备在Tensorflow中运行 tf.nn.softmax_cross_entropy_with_logits() 函数。 据我了解,“logit”应该是概率的张量,每个对应于某个像素的

tensorflow 服务构建依赖于大型 tensorflow ;但我已经成功构建了 tensorflow。所以我想用它。我做这些事情:我更改了 tensorflow 服务 WORKSPACE(org

Tensoflow 嵌入层 ( https://www.tensorflow.org/api_docs/python/tf/keras/layers/Embedding ) 易于使用, 并且有大量的文

我正在尝试使用非常大的数据集(比我的内存大得多)训练 Tensorflow 模型。 为了充分利用所有可用的训练数据,我正在考虑将它们分成几个小的“分片”,并一次在一个分片上进行训练。 经过一番研究,我

根据 Sutton 的书 - Reinforcement Learning: An Introduction,网络权重的更新方程为: 其中 et 是资格轨迹。 这类似于带有额外 et 的梯度下降更新。

如何根据条件选择执行图表的一部分? 我的网络有一部分只有在 feed_dict 中提供占位符值时才会执行.如果未提供该值,则采用备用路径。我该如何使用 tensorflow 来实现它? 以下是我的代码

我是一名优秀的程序员,十分优秀!