- ubuntu12.04环境下使用kvm ioctl接口实现最简单的虚拟机

- Ubuntu 通过无线网络安装Ubuntu Server启动系统后连接无线网络的方法

- 在Ubuntu上搭建网桥的方法

- ubuntu 虚拟机上网方式及相关配置详解

CFSDN坚持开源创造价值,我们致力于搭建一个资源共享平台,让每一个IT人在这里找到属于你的精彩世界.

这篇CFSDN的博客文章keras 回调函数Callbacks 断点ModelCheckpoint教程由作者收集整理,如果你对这篇文章有兴趣,记得点赞哟.

整理自keras:https://keras-cn.readthedocs.io/en/latest/other/callbacks/ 。

回调函数Callbacks 。

回调函数是一个函数的合集,会在训练的阶段中所使用。你可以使用回调函数来查看训练模型的内在状态和统计。你可以传递一个列表的回调函数(作为 callbacks 关键字参数)到 Sequential 或 Model 类型的 .fit() 方法。在训练时,相应的回调函数的方法就会被在各自的阶段被调用.

Callback 。

keras.callbacks.Callback() 。

这是回调函数的抽象类,定义新的回调函数必须继承自该类 。

类属性 。

params:字典,训练参数集(如信息显示方法verbosity,batch大小,epoch数) 。

model:keras.models.Model对象,为正在训练的模型的引用 。

回调函数以字典logs为参数,该字典包含了一系列与当前batch或epoch相关的信息.

目前,模型的.fit()中有下列参数会被记录到logs中:

在每个epoch的结尾处(on_epoch_end),logs将包含训练的正确率和误差,acc和loss,如果指定了验证集,还会包含验证集正确率和误差val_acc)和val_loss,val_acc还额外需要在.compile中启用metrics=['accuracy'].

在每个batch的开始处(on_batch_begin):logs包含size,即当前batch的样本数 。

在每个batch的结尾处(on_batch_end):logs包含loss,若启用accuracy则还包含acc 。

ModelCheckpoint 。

keras.callbacks.ModelCheckpoint(filepath, monitor='val_loss', verbose=0, save_best_only=False, save_weights_only=False, mode='auto', period=1) 。

该回调函数将在每个epoch后保存模型到filepath 。

filepath 可以包括命名格式选项,可以由 epoch 的值和 logs 的键(由 on_epoch_end 参数传递)来填充.

参数:

filepath: 字符串,保存模型的路径.

monitor: 被监测的数据。val_acc或这val_loss 。

verbose: 详细信息模式,0 或者 1 。0为不打印输出信息,1打印 。

save_best_only: 如果 save_best_only=True, 将只保存在验证集上性能最好的模型 。

mode: {auto, min, max} 的其中之一。 如果 save_best_only=True,那么是否覆盖保存文件的决定就取决于被监测数据的最大或者最小值。 对于 val_acc,模式就会是 max,而对于 val_loss,模式就需要是 min,等等。 在 auto 模式中,方向会自动从被监测的数据的名字中判断出来.

save_weights_only: 如果 True,那么只有模型的权重会被保存 (model.save_weights(filepath)), 否则的话,整个模型会被保存 (model.save(filepath)).

period: 每个检查点之间的间隔(训练轮数).

代码实现过程:

① 从keras.callbacks导入ModelCheckpoint类 。

from keras.callbacks import ModelCheckpoint 。

② 在训练阶段的model.compile之后加入下列代码实现每一次epoch(period=1)保存最好的参数 。

checkpoint = ModelCheckpoint(filepath, monitor='val_loss', save_weights_only=True,verbose=1,save_best_only=True, period=1) 。

③ 在训练阶段的model.fit之前加载先前保存的参数 。

|

1

2

3

4

|

if

os.path.exists(filepath):

model.load_weights(filepath)

# 若成功加载前面保存的参数,输出下列信息

print

(

"checkpoint_loaded"

)

|

④ 在model.fit添加callbacks=[checkpoint]实现回调 。

|

1

2

3

4

5

6

7

|

model.fit_generator(data_generator_wrap(lines[:num_train], batch_size, input_shape, anchors, num_classes),

steps_per_epoch

=

max

(

1

, num_train

/

/

batch_size),

validation_data

=

data_generator_wrap(lines[num_train:], batch_size, input_shape, anchors, num_classes),

validation_steps

=

max

(

1

, num_val

/

/

batch_size),

epochs

=

3

,

initial_epoch

=

0

,

callbacks

=

[checkpoint])

|

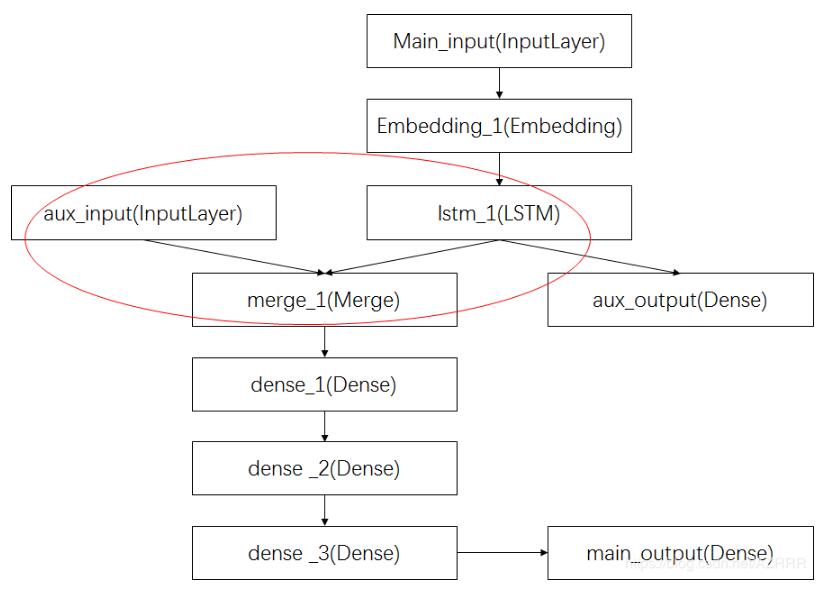

补充知识:keras之多输入多输出(多任务)模型 。

keras多输入多输出模型,以keras官网的demo为例,分析keras多输入多输出的适用.

主要输入(main_input): 新闻标题本身,即一系列词语.

辅助输入(aux_input): 接受额外的数据,例如新闻标题的发布时间等.

该模型将通过两个损失函数进行监督学习.

较早地在模型中使用主损失函数,是深度学习模型的一个良好正则方法.

完整过程图示如下:

其中,红圈中的操作为将辅助数据与LSTM层的输出连接起来,输入到模型中.

代码实现:

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

|

import

keras

from

keras.layers

import

Input

, Embedding, LSTM, Dense

from

keras.models

import

Model

# 定义网络模型

# 标题输入:接收一个含有 100 个整数的序列,每个整数在 1 到 10000 之间

# 注意我们可以通过传递一个 `name` 参数来命名任何层

main_input

=

Input

(shape

=

(

100

,), dtype

=

'int32'

, name

=

'main_input'

)

# Embedding 层将输入序列编码为一个稠密向量的序列,每个向量维度为 512

x

=

Embedding(output_dim

=

512

, input_dim

=

10000

, input_length

=

100

)(main_input)

# LSTM 层把向量序列转换成单个向量,它包含整个序列的上下文信息

lstm_out

=

LSTM(

32

)(x)

# 在这里我们添加辅助损失,使得即使在模型主损失很高的情况下,LSTM层和Embedding层都能被平稳地训练

auxiliary_output

=

Dense(

1

, activation

=

'sigmoid'

, name

=

'aux_output'

)(lstm_out)

# 此时,我们将辅助输入数据与LSTM层的输出连接起来,输入到模型中

auxiliary_input

=

Input

(shape

=

(

5

,), name

=

'aux_input'

)

x

=

keras.layers.concatenate([lstm_out, auxiliary_output])

# 再添加剩余的层

# 堆叠多个全连接网络层

x

=

Dense(

64

, activation

=

'relu'

)(x)

x

=

Dense(

64

, activation

=

'relu'

)(x)

x

=

Dense(

64

, activation

=

'relu'

)(x)

# 最后添加主要的逻辑回归层

main_output

=

Dense(

1

, activation

=

'sigmoid'

, name

=

'main_output'

)(x)

# 定义这个具有两个输入和输出的模型

model

=

Model(inputs

=

[main_input, auxiliary_input], outputs

=

[main_output, auxiliary_output])

# 编译模型时候分配损失函数权重:编译模型的时候,给 辅助损失 分配一个0.2的权重

model.

compile

(optimizer

=

'rmsprop'

, loss

=

'binary_crossentropy'

, loss_weights

=

[

1.

,

0.2

])

# 训练模型:我们可以通过传递输入数组和目标数组的列表来训练模型

model.fit([headline_data, additional_data], [labels, labels], epochs

=

50

, batch_size

=

32

)

# 另外一种利用字典的编译、训练方式

# 由于输入和输出均被命名了(在定义时传递了一个 name 参数),我们也可以通过以下方式编译模型

model.

compile

(optimizer

=

'rmsprop'

,

loss

=

{

'main_output'

:

'binary_crossentropy'

,

'aux_output'

:

'binary_crossentropy'

},

loss_weights

=

{

'main_output'

:

1.

,

'aux_output'

:

0.2

})

# 然后使用以下方式训练:

model.fit({

'main_input'

: headline_data,

'aux_input'

: additional_data},

{

'main_output'

: labels,

'aux_output'

: labels},

epochs

=

50

, batch_size

=

32

)

|

相关参考:https://keras.io/zh/getting-started/functional-api-guide/ 。

以上这篇keras 回调函数Callbacks 断点ModelCheckpoint教程就是小编分享给大家的全部内容了,希望能给大家一个参考,也希望大家多多支持我.

原文链接:https://blog.csdn.net/jieshaoxiansen/article/details/82762922 。

最后此篇关于keras 回调函数Callbacks 断点ModelCheckpoint教程的文章就讲到这里了,如果你想了解更多关于keras 回调函数Callbacks 断点ModelCheckpoint教程的内容请搜索CFSDN的文章或继续浏览相关文章,希望大家以后支持我的博客! 。

我正在研究 learnyounode 的 HTTP 客户端作业。 我想知道为什么控制台记录来自response.on(“end”,callback)的数据仅输出预期输出的最后一部分,而控制台记录来自r

我正在尝试创建一个对象列表(在我的示例中为 List),我在其中使用 json 将对象添加到此列表,但该列表仍为空。这是我的代码: public List readCardsFromJson() {

我有一个 JavaScript 函数“print_something”,它在大约 300 个 jsp 帮助页面中实现。我发现这个“print_something”函数必须被纠正。所以我正在寻找一个不更

有 2 个 HTML 下拉列表,一个用于 12 小时时间,一个用于每小时 5 分钟的时间间隔。 .. 1 .. 12 .. 0 .. 55 .. 一直在尝试使用 if/

我有一个 A 类,我打算在它与设备驱动程序交互时将其放入共享库中。 我有一个 B 类,将来可能是 C、D、E...,它将使用共享库中的 A 类。 我想要在类 A 中设置回调函数的功能,以便当特定事件发

我需要能够在处理完 Observable.next() 之后执行回调。 我有一个组件“A”,它有一个主题使用 Subject.next() 发送通知。我有一个组件“B”,它订阅了 Subject.as

我有一张在顶部和底部单元格下方带有阴影的表格(此处使用 Matt Gallagher 的解决方案:http://cocoawithlove.com/2009/08/adding-shadow-effe

有人可以向我解释一下为什么这段代码有效 renderSquare(i) { return ( this.handleClick(i)} /> ); } 但

我可以让两个不同的客户端监听相同的 WCF 回调并让它们都接收相同的数据而不必进行两次处理吗? 最佳答案 不是真的 - 至少不是直接的。你所描述的听起来很像发布/订阅模式。 WCF 服务基本上在任何给

我是 SignalR 的新手,如果这个问题太明显,我深表歉意,但我在文档中找不到任何答案。 这是我的代码。 /*1*/ actions.client.doActionA = function (r

我有这个应用程序,您可以在其中输入一些文本并按下一个按钮,将此文本添加到自定义小部件中。这是代码: import 'dart:core'; import 'package:flutter/materi

我读到当您还想使用模型回调时不能使用 Keras 进行交叉验证,但是 this post表明这毕竟是可能的。但是,我很难将其纳入我的上下文。 为了更详细地探讨这个问题,我正在关注 machinelea

我尝试在重力表单中提交表单失败后运行一些 jQuery 代码,也就是验证发现错误时。 我尝试使用 Ajax:complete 回调,但它根本不触发。 我尝试运行的代码基本上将监听器添加到选择下拉列表中

我有一个 $image,我 .fadeIn 和 .fadeOut,然后 .remove .fadeOut 完成。这是我的代码: $image .fadeIn() .fadeOut(func

我正在处理一个自定义文件路径类,它应该始终执行一个函数 写入相应的系统文件及其文件对象后 关闭。该函数将文件路径的内容上传到远程位置。 我希望上传功能完全在用户的幕后发生 透视,即用户可以像使用其他任

这里是 javascript 新手,所以回调在我的大脑中仍然有点不确定。 我想做的是:给定一个“菜单”,它是一个 objectId 数组,查询与该 objectId 相对应的每个 foodItem,获

我正在学习回调,我编写了以下代码: var http = require('http'); var str = ""; var count = 2; function jugglingAsync(ca

这是我的困境,我有一系列被调用的函数,我正在使用回调函数在它们完成时执行函数。回调返回一个值并且效果也很好,我的问题是当我向回调添加参数时我无法再访问返回值。这是一个有效的例子: function m

This question already has answers here: Explanation of function pointers (4个答案) 上个月关闭。 如何将函数指针作为参数传递

我无法让以下代码工作。假设 ajax 调用有效,并且 msg['username'] 预设为 'john'。我想我对如何将变量传递给回调感到困惑。编辑:我认为我的主要困惑是如何从 Ajax 中获取“m

我是一名优秀的程序员,十分优秀!