- ubuntu12.04环境下使用kvm ioctl接口实现最简单的虚拟机

- Ubuntu 通过无线网络安装Ubuntu Server启动系统后连接无线网络的方法

- 在Ubuntu上搭建网桥的方法

- ubuntu 虚拟机上网方式及相关配置详解

CFSDN坚持开源创造价值,我们致力于搭建一个资源共享平台,让每一个IT人在这里找到属于你的精彩世界.

这篇CFSDN的博客文章网站渗透常用Python小脚本查询同ip网站由作者收集整理,如果你对这篇文章有兴趣,记得点赞哟.

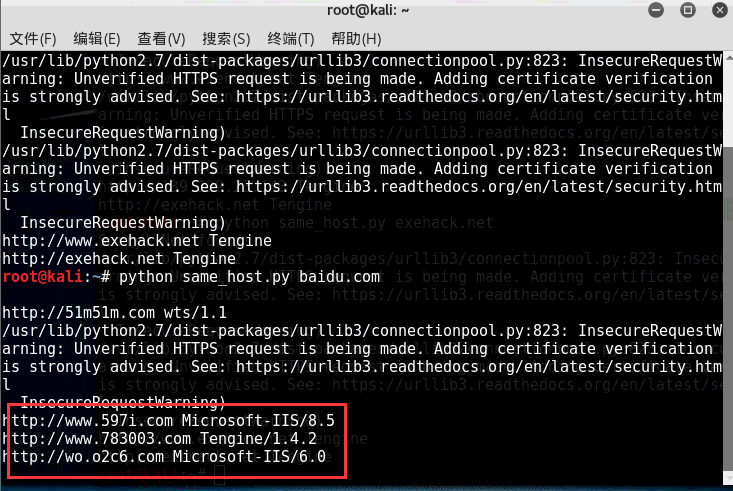

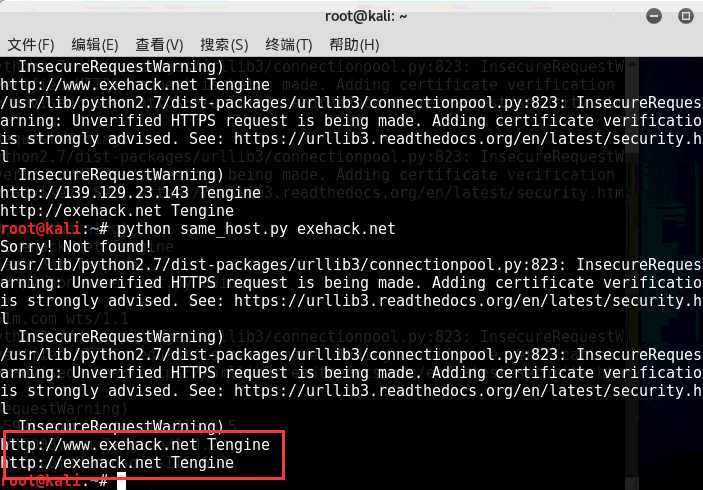

旁站查询来源: http://dns.aizhan.com http://s.tool.chinaz.com/same http://i.links.cn/sameip/ http://www.ip2hosts.com/ 效果图如下: 以百度网站和小残博客为例:

PS:直接调用以上4个旁注接口查询同服服务器域名信息包含服务器类型 比如小残博客使用的是Tengine 。

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

96

97

98

99

100

101

102

103

104

105

106

107

108

109

110

111

112

113

114

115

116

117

118

119

120

121

122

123

124

125

126

127

128

129

130

131

132

133

134

135

136

137

138

139

140

141

|

#!/usr/bin/env python

#encoding: utf-8

import

re

import

sys

import

json

import

time

import

requests

import

urllib

import

requests.packages.urllib3

from

multiprocessing

import

Pool

from

BeautifulSoup

import

BeautifulSoup

requests.packages.urllib3.disable_warnings()

headers

=

{

'User-Agent'

:

'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_7_3) AppleWebKit/535.20 (KHTML, like Gecko) Chrome/19.0.1036.7 Safari/535.20'

}

def

links_ip(host):

'''

查询同IP网站

'''

ip2hosts

=

[]

ip2hosts.append(

"http://"

+

host)

try

:

source

=

requests.get(

'http://i.links.cn/sameip/'

+

host

+

'.html'

, headers

=

headers,verify

=

False

)

soup

=

BeautifulSoup(source.text)

divs

=

soup.findAll(style

=

"word-break:break-all"

)

if

divs

=

=

[]:

#抓取结果为空

print

'Sorry! Not found!'

return

ip2hosts

for

div

in

divs:

#print div.a.string

ip2hosts.append(div.a.string)

except

Exception, e:

print

str

(e)

return

ip2hosts

return

ip2hosts

def

ip2host_get(host):

ip2hosts

=

[]

ip2hosts.append(

"http://"

+

host)

try

:

req

=

requests.get(

'http://www.ip2hosts.com/search.php?ip='

+

str

(host), headers

=

headers,verify

=

False

)

src

=

req.content

if

src.find(

'result'

) !

=

-

1

:

result

=

json.loads(src)[

'result'

]

ip

=

json.loads(src)[

'ip'

]

if

len

(result)>

0

:

for

item

in

result:

if

len

(item)>

0

:

#log(scan_type,host,port,str(item))

ip2hosts.append(item)

except

Exception, e:

print

str

(e)

return

ip2hosts

return

ip2hosts

def

filter

(host):

'''

打不开的网站...

'''

try

:

response

=

requests.get(host, headers

=

headers ,verify

=

False

)

server

=

response.headers[

'Server'

]

title

=

re.findall(r

'<title>(.*?)</title>'

,response.content)[

0

]

except

Exception,e:

#print "%s" % str(e)

#print host

pass

else

:

print

host,server

def

aizhan(host):

ip2hosts

=

[]

ip2hosts.append(

"http://"

+

host)

regexp

=

r

'''<a href="[^']+?([^']+?)/" rel="external nofollow" target="_blank">\1</a>'''

regexp_next

=

r

'''<a href="http://dns.aizhan.com/[^/]+?/%d/" rel="external nofollow" >%d</a>'''

url

=

'http://dns.aizhan.com/%s/%d/'

page

=

1

while

True

:

if

page >

2

:

time.sleep(

1

)

#防止拒绝访问

req

=

requests.get(url

%

(host , page) ,headers

=

headers ,verify

=

False

)

try

:

html

=

req.content.decode(

'utf-8'

)

#取得页面

if

req.status_code

=

=

400

:

break

except

Exception as e:

print

str

(e)

pass

for

site

in

re.findall(regexp , html):

ip2hosts.append(

"http://"

+

site)

if

re.search(regexp_next

%

(page

+

1

, page

+

1

) , html)

is

None

:

return

ip2hosts

break

page

+

=

1

return

ip2hosts

def

chinaz(host):

ip2hosts

=

[]

ip2hosts.append(

"http://"

+

host)

regexp

=

r

'''<a href='[^']+?([^']+?)' target=_blank>\1</a>'''

regexp_next

=

r

'''<a href="javascript:" rel="external nofollow" val="%d" class="item[^"]*?">%d</a>'''

url

=

'http://s.tool.chinaz.com/same?s=%s&page=%d'

page

=

1

while

True

:

if

page >

1

:

time.sleep(

1

)

#防止拒绝访问

req

=

requests.get(url

%

(host , page) , headers

=

headers ,verify

=

False

)

html

=

req.content.decode(

'utf-8'

)

#取得页面

for

site

in

re.findall(regexp , html):

ip2hosts.append(

"http://"

+

site)

if

re.search(regexp_next

%

(page

+

1

, page

+

1

) , html)

is

None

:

return

ip2hosts

break

page

+

=

1

return

ip2hosts

def

same_ip(host):

mydomains

=

[]

mydomains.extend(ip2host_get(host))

mydomains.extend(links_ip(host))

mydomains.extend(aizhan(host))

mydomains.extend(chinaz(host))

mydomains

=

list

(

set

(mydomains))

p

=

Pool()

for

host

in

mydomains:

p.apply_async(

filter

, args

=

(host,))

p.close()

p.join()

if

__name__

=

=

"__main__"

:

if

len

(sys.argv)

=

=

2

:

same_ip(sys.argv[

1

])

else

:

print

(

"usage: %s host"

%

sys.argv[

0

])

sys.exit(

-

1

)

|

大家可以发挥添加或者修改任意查询接口。注意是这个里面的一些思路与代码.

原文链接:https://www.exehack.net/4781.html 。

最后此篇关于网站渗透常用Python小脚本查询同ip网站的文章就讲到这里了,如果你想了解更多关于网站渗透常用Python小脚本查询同ip网站的内容请搜索CFSDN的文章或继续浏览相关文章,希望大家以后支持我的博客! 。

我有三张 table 。表 A 有选项名称(即颜色、尺寸)。表 B 有选项值名称(即蓝色、红色、黑色等)。表C通过将选项名称id和选项名称值id放在一起来建立关系。 我的查询需要显示值和选项的名称,而

在mysql中,如何计算一行中的非空单元格?我只想计算某些列之间的单元格,比如第 3-10 列之间的单元格。不是所有的列...同样,仅在该行中。 最佳答案 如果你想这样做,只能在 sql 中使用名称而

关闭。这个问题需要多问focused 。目前不接受答案。 想要改进此问题吗?更新问题,使其仅关注一个问题 editing this post . 已关闭 7 年前。 Improve this ques

我正在为版本7.6进行Elasticsearch查询 我的查询是这样的: { "query": { "bool": { "should": [ {

关闭。这个问题需要多问focused 。目前不接受答案。 想要改进此问题吗?更新问题,使其仅关注一个问题 editing this post . 已关闭 7 年前。 Improve this ques

是否可以编写一个查询来检查任一子查询(而不是一个子查询)是否正确? SELECT * FROM employees e WHERE NOT EXISTS (

我找到了很多关于我的问题的答案,但问题没有解决 我有表格,有数据,例如: Data 1 Data 2 Data 3

以下查询返回错误: 查询: SELECT Id, FirstName, LastName, OwnerId, PersonEmail FROM Account WHERE lower(PersonEm

以下查询返回错误: 查询: SELECT Id, FirstName, LastName, OwnerId, PersonEmail FROM Account WHERE lower(PersonEm

我从 EditText 中获取了 String 值。以及提交查询的按钮。 String sql=editQuery.getText().toString();// SELECT * FROM empl

我有一个或多或少有效的查询(关于结果),但处理大约需要 45 秒。这对于在 GUI 中呈现数据来说肯定太长了。 所以我的需求是找到一个更快/更高效的查询(几毫秒左右会很好)我的数据表大约有 3000

这是我第一次使用 Stack Overflow,所以我希望我以正确的方式提出这个问题。 我有 2 个 SQL 查询,我正在尝试比较和识别缺失值,尽管我无法将 NULL 字段添加到第二个查询中以识别缺失

什么是动态 SQL 查询?何时需要使用动态 SQL 查询?我使用的是 SQL Server 2005。 最佳答案 这里有几篇文章: Introduction to Dynamic SQL Dynami

include "mysql.php"; $query= "SELECT ID,name,displayname,established,summary,searchlink,im

我有一个查询要“转换”为 mysql。这是查询: select top 5 * from (select id, firstName, lastName, sum(fileSize) as To

通过我的研究,我发现至少从 EF 4.1 开始,EF 查询上的 .ToString() 方法将返回要运行的 SQL。事实上,这对我来说非常有用,使用 Entity Framework 5 和 6。 但

我在构造查询来执行以下操作时遇到问题: 按activity_type_id过滤联系人,仅显示最近事件具有所需activity_type_id或为NULL(无事件)的联系人 表格结构如下: 一个联系人可

如何让我输入数据库的信息在输入数据 5 分钟后自行更新? 假设我有一张 table : +--+--+-----+ |id|ip|count| +--+--+-----+ |

我正在尝试搜索正好是 4 位数字的 ID,我知道我需要使用 LENGTH() 字符串函数,但找不到如何使用它的示例。我正在尝试以下(和其他变体)但它们不起作用。 SELECT max(car_id)

我有一个在 mysql 上运行良好的 sql 查询(查询 + 连接): select sum(pa.price) from user u , purchase pu , pack pa where (

我是一名优秀的程序员,十分优秀!