- ubuntu12.04环境下使用kvm ioctl接口实现最简单的虚拟机

- Ubuntu 通过无线网络安装Ubuntu Server启动系统后连接无线网络的方法

- 在Ubuntu上搭建网桥的方法

- ubuntu 虚拟机上网方式及相关配置详解

CFSDN坚持开源创造价值,我们致力于搭建一个资源共享平台,让每一个IT人在这里找到属于你的精彩世界.

这篇CFSDN的博客文章Pyinstaller打包Scrapy项目的实现步骤由作者收集整理,如果你对这篇文章有兴趣,记得点赞哟.

1.安装pyinstaller 。

2.安装pywin32 。

3.安装其他模块 。

注意点

scrapy用pyinstaller打包不能用 。

|

1

|

cmdline.execute(

'scrapy crawl douban -o test.csv --nolog'

.split())

|

我用的是CrawlerProcess方式来输出 。

举个栗子:

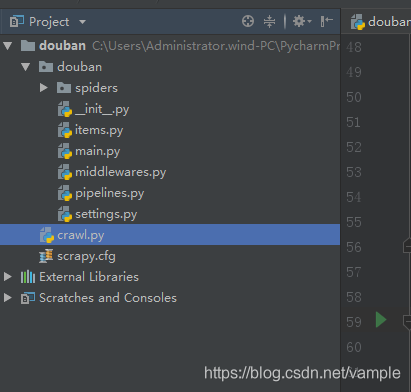

1、在scrapy项目根目录下建一个crawl.py(你可以自己定义)如下图 。

cralw.py代码如下 。

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

|

# -*- coding: utf-8 -*-

from

scrapy.crawler

import

CrawlerProcess

from

scrapy.utils.project

import

get_project_settings

from

douban.spiders.douban_spider

import

Douban_spider

#打包需要的import

import

urllib.robotparser

import

scrapy.spiderloader

import

scrapy.statscollectors

import

scrapy.logformatter

import

scrapy.dupefilters

import

scrapy.squeues

import

scrapy.extensions.spiderstate

import

scrapy.extensions.corestats

import

scrapy.extensions.telnet

import

scrapy.extensions.logstats

import

scrapy.extensions.memusage

import

scrapy.extensions.memdebug

import

scrapy.extensions.feedexport

import

scrapy.extensions.closespider

import

scrapy.extensions.debug

import

scrapy.extensions.httpcache

import

scrapy.extensions.statsmailer

import

scrapy.extensions.throttle

import

scrapy.core.scheduler

import

scrapy.core.engine

import

scrapy.core.scraper

import

scrapy.core.spidermw

import

scrapy.core.downloader

import

scrapy.downloadermiddlewares.stats

import

scrapy.downloadermiddlewares.httpcache

import

scrapy.downloadermiddlewares.cookies

import

scrapy.downloadermiddlewares.useragent

import

scrapy.downloadermiddlewares.httpproxy

import

scrapy.downloadermiddlewares.ajaxcrawl

import

scrapy.downloadermiddlewares.chunked

import

scrapy.downloadermiddlewares.decompression

import

scrapy.downloadermiddlewares.defaultheaders

import

scrapy.downloadermiddlewares.downloadtimeout

import

scrapy.downloadermiddlewares.httpauth

import

scrapy.downloadermiddlewares.httpcompression

import

scrapy.downloadermiddlewares.redirect

import

scrapy.downloadermiddlewares.retry

import

scrapy.downloadermiddlewares.robotstxt

import

scrapy.spidermiddlewares.depth

import

scrapy.spidermiddlewares.httperror

import

scrapy.spidermiddlewares.offsite

import

scrapy.spidermiddlewares.referer

import

scrapy.spidermiddlewares.urllength

import

scrapy.pipelines

import

scrapy.core.downloader.handlers.http

import

scrapy.core.downloader.contextfactory

from

douban.pipelines

import

DoubanPipeline

from

douban.items

import

DoubanItem

import

douban.settings

if

__name__

=

=

'__main__'

:

setting

=

get_project_settings()

process

=

CrawlerProcess(settings

=

setting)

process.crawl(Douban_spider)

process.start()

|

2、在crawl.py目录下pyinstaller crawl.py 生成dist,build(可删)和crawl.spec(可删).

3、在crawl.exe目录下创建文件夹scrapy,然后到自己安装的scrapy文件夹中把VERSION和mime.types两个文件复制到刚才创建的scrapy文件夹中.

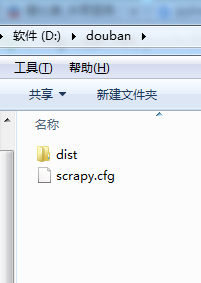

4、发布程序 包括douban/dist 和douban/scrapy.cfg 。

如果没有scrapy.cfg无法读取settings.py和pipelines.py的配置 。

5、在另外一台机器上测试成功 。

6、对于自定义的pipelines和settings,貌似用pyinstaller打包后的 exe无法读取到settings和pipelines,哪位高手看看能解决这个问题???

到此这篇关于Pyinstaller打包Scrapy项目的实现步骤的文章就介绍到这了,更多相关Pyinstaller打包Scrapy内容请搜索我以前的文章或继续浏览下面的相关文章希望大家以后多多支持我! 。

原文链接:https://blog.csdn.net/vample/article/details/86224021 。

最后此篇关于Pyinstaller打包Scrapy项目的实现步骤的文章就讲到这里了,如果你想了解更多关于Pyinstaller打包Scrapy项目的实现步骤的内容请搜索CFSDN的文章或继续浏览相关文章,希望大家以后支持我的博客! 。

我是在项目中使用 keras 的新手。我一直在我的模型中使用generator。 我真的很困惑我应该输入什么值 1) In fit_generator : steps_per_epoch & vali

假设我们有如下情况: A has to give $10 to B. B has to give $20 to C. C has to give $10 to D. 现在这种情况可以简化为: A lo

我正在尝试对特定列(在工作表“OA”中)进行相对引用,我需要在 110 的步骤中检索新工作表中的单元格内容 例如, =OA!$AB217 =OA!$AB327 =OA!$AB437 与其在每个单元格中

我的 PowerShell 控制台启动时间很慢(总是等待超过 5 秒),并且希望获得有关故障排除步骤的建议,以找出瓶颈可能在哪里? 我已经阅读了关于运行脚本的内容,-NoProfile防止模块等加载很

我在 NativeScript 应用程序中使用 slider 小部件,我想知道是否有步骤属性。在我的例子中,小部件代表金钱,我希望以 5 美元的增量滑动。 我查看了文档,但找不到任何对这种情况有帮助的

我在 NativeScript 应用程序中使用 slider 小部件,我想知道是否有步骤属性。在我的例子中,小部件代表金钱,我希望以 5 美元的增量滑动。 我查看了文档,但找不到任何对这种情况有帮助的

这是我的code : &n

为什么 (2) c.ERR(模棱两可)?第一个方法参数 - char ('a') 被扩展为 float => 匹配。 如果找到匹配项,是否无需继续执行第 2 步(装箱/拆箱)或第 3 步(尝试可变参数

我有一个函数,它处理一个包含 6100 个列表项的列表。当列表只有 300 个项目时,该代码可以正常工作。但是立即与 6100 崩溃。有没有一种方法可以遍历这 6100 个项目,一次说 30 个,然后

1.制作PHP安装程序的原理 其实PHP程序的安装原理无非就是将数据库结构和内容导入到相应的数据库中,从这个过程中重新配置连接数据库的参数和文件,为了保证不被别人恶意使用安装文件,当安装

我创建了一个类似于 primeNG page 的步骤组件我想把他放在一个 dynamic dialog 里面但在应用它之后,“第 1 步”和“第 2 步”不会呈现。 查看代码,我发现关键部分是我们打开

我在理解描述的 MixColumns 步骤时遇到问题 here . 我知道扩散,这一切都是有道理的,因为它指出每列都被视为多项式并乘以 GF(2^8) 的模。 但是..乘以GF(2 ^ 8)。尽管域仍

根据我对 TeamCity 工作原理的观察,我注意到在所有步骤执行完毕后评估构建失败条件。这很烦人,因为如果满足任何构建失败条件,我不能有一个不会执行的步骤。 我不是指常见的构建失败条件,例如“至少一

基于这篇试图在我的环境中测试管道代码的帖子。但它给出了以下错误消息。如何修复他的管道代码? ERROR: Unable to find project for artifact copy: test

我参与了一个项目,需要向我的一位同事提供生产数据的子集(日期范围),以进行故障排除。我想将经过清理的生产数据子集插入新的数据库表中我的同事可以访问。请提出实现此目标的最佳方法。 最佳答案 最简单的方法

我有这样的场景: 鉴于我去这个页面 当我输入 cucumber 时 然后我点击 然后我应该看到文字 我不应该看到这条线 如果我运行这个场景,它将执行所有 5 个步骤。但是我想跳过第4步(然后我应该看到

是否有任何功能可以避免 m 文件的绘图输出? 我的意思是我在文件的开头放置了一个函数(如 clc),然后所有绘图函数都被阻止。 最佳答案 您可以使用自己的(嵌套在您的函数内或同一目录中)重载内置绘图函

我是小 cucumber 语言的新手,这在我看来是非常基本的问题,但我找不到答案。 我知道可以在 Gherking 中编写多行步骤参数,如下所示: Given a blog post named "R

即使其中一个步骤失败,有没有办法继续执行 Cucumber Steps。在我当前的设置中,当一个步骤失败时, cucumber 会跳过剩余的步骤......我想知道是否有某种方法可以设置 cucumb

start-step-stop 码是一种数据压缩技术,用于压缩相对较小的数字。 该代码的工作原理如下:它具有三个参数,start、step 和 stop。 Start 确定用于计算前几个数字的位数。

我是一名优秀的程序员,十分优秀!