- ubuntu12.04环境下使用kvm ioctl接口实现最简单的虚拟机

- Ubuntu 通过无线网络安装Ubuntu Server启动系统后连接无线网络的方法

- 在Ubuntu上搭建网桥的方法

- ubuntu 虚拟机上网方式及相关配置详解

CFSDN坚持开源创造价值,我们致力于搭建一个资源共享平台,让每一个IT人在这里找到属于你的精彩世界.

这篇CFSDN的博客文章python爬虫爬取监控教务系统的思路详解由作者收集整理,如果你对这篇文章有兴趣,记得点赞哟.

这几天考了大大小小几门课,教务系统又没有成绩通知功能,为了急切想知道自己挂了多少门,于是我写下这个脚本.

设计思路:

设计思路很简单,首先对已有的成绩进行处理,变为list集合,然后定时爬取教务系统查成绩的页面,对爬取的成绩也处理成list集合,如果newList的长度增加了,就找出增加的部分,并通过邮件通知我.

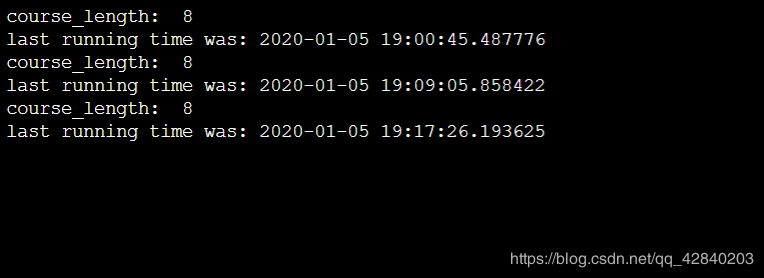

脚本运行效果:

服务器:

发送邮件通知:

代码如下:

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

96

97

98

99

100

101

102

103

104

105

106

107

108

109

110

111

112

113

114

115

116

117

118

119

120

121

122

123

124

|

import

datetime

import

time

from

email.header

import

Header

import

requests

import

re

import

smtplib

from

email.mime.text

import

MIMEText

from

bs4

import

BeautifulSoup

def

listener():

#在这里我通过模拟登陆的方式登陆

#一般来说这里填写的是username跟password

#但我们学校后台将用户名和密码进行了加密

#通过观察浏览器的请求数据跟页面源码猜出学校后台的加密方式

data

=

{

#出于学校安全考虑,这里就不给出加密方式了

'encoded'

:

'xxxxxxxxxxxxxxxxxxx'

}

session

=

requests.Session()

session.post(

'http://jwc.sgu.edu.cn/jsxsd/xk/LoginToXk'

,data

=

data)

#请求2019-2020-1学期的所有成绩

r_data

=

{

'kksj'

:

'2019-2020-1'

,

'kcxz'

: '',

'kcmc'

: '',

'xsfs'

:

'all'

}

r

=

session.post(

'http://jwc.sgu.edu.cn/jsxsd/kscj/cjcx_list'

, data

=

r_data)

#对爬回来数据进行封装

soup

=

BeautifulSoup(r.text,

'html.parser'

)

#返回已有的成绩列表

oldList

=

toList(soup)

max

=

len

(oldList)

#这里用死循环定时爬取成绩页面分析是否分布新成绩

while

(

True

):

#post跟get方式不能乱用,不然数据会出错

r

=

session.post(

'http://jwc.sgu.edu.cn/jsxsd/kscj/cjcx_list'

,data

=

r_data)

soup

=

BeautifulSoup(r.text,

'lxml'

)

#print(soup.prettify())

length

=

len

(soup.find_all(string

=

re.

compile

(

'2019-2020-1'

)))

-

1

print

(

"course_length: "

,length)

if

(r.status_code

=

=

200

and

length !

=

0

):

if

(length >

max

):

#查询新出的成绩列表

newlist

=

toList(soup)

#获取两个列表不同之处,不同的就是新成绩

diflist

=

compareTwoList(oldList, newlist)

oldList

=

newlist

if

diflist

=

=

'':

send(

"unkowned Error"

,

"unkowned Error"

)

else

:

#有新成绩了,发送邮件通知我

send(

'you have new course sorce!!'

, diflist)

max

=

length

print

(

'last running time was:'

,datetime.datetime.now())

#定时作用,500s查一次

time.sleep(

500

)

else

:

# 发送邮件断开连接了 print("had disconnected...")

send(

"your server is disconnected!!!"

,

"your server is disconnected!!!"

)

break

def

send(title,msg):

mail_host

=

'smtp.qq.com'

# 你的qq邮箱名,没有.com

mail_user

=

'你的qq邮箱名,没有.com'

# 密码(部分邮箱为授权码)

mail_pass

=

'授权码'

# 邮件发送方邮箱地址

sender

=

'发送方邮箱地址'

# 邮件接受方邮箱地址,注意需要[]包裹,这意味着你可以写多个邮件地址群发

receivers

=

[

'yoletpig@qq.com'

]

# 设置email信息

# 邮件内容设置

message

=

MIMEText(msg,

'plain'

,

'utf-8'

)

# 邮件主题

message[

'Subject'

]

=

Header(title,

'utf-8'

)

# 发送方信息

message[

'From'

]

=

sender

# 接受方信息

message[

'To'

]

=

receivers[

0

]

# 登录并发送邮件

try

:

# smtpObj = smtplib.SMTP()

# # 连接到服务器

# smtpObj.connect(mail_host, 25)

smtpObj

=

smtplib.SMTP_SSL(mail_host)

# 登录到服务器

smtpObj.login(mail_user, mail_pass)

# 发送

smtpObj.sendmail(

sender,receivers,message.as_string())

# 退出

smtpObj.quit()

print

(

'success'

)

except

smtplib.SMTPException as e:

print

(

'error'

, e)

# 打印错误

def

toList(soup):

flag

=

True

list

=

[]

strs

=

''

#对tr标签下的td进行遍历并取值

for

tr

in

soup.find_all(

'tr'

):

if

flag:

flag

=

False

;

continue

i

=

1

for

td

in

tr.stripped_strings:

if

(i

=

=

1

or

i

=

=

2

):

i

+

=

1

continue

strs

+

=

"_"

+

td

i

+

=

1

list

.append(strs)

strs

=

''

return

list

def

compareTwoList(oldList,newList):

diflist

=

''

for

sub

in

newList:

#判断是否唯一

if

(oldList.count(sub)

=

=

0

):

diflist

=

sub

break

return

diflist

if

__name__

=

=

'__main__'

:

listener()

|

这个脚本不出意外的话要运行到我所有成绩出来为止,但我电脑肯定不会这么多天不关机呀,于是我就将这个脚本放到服务器上运行,如何在ubuntu下运行python文件,大家可以看一下我的另一篇文章: yoletPig的博客:Ubuntu下运行python文件 。

总结 。

以上所述是小编给大家介绍的python爬虫爬取监控教务系统的思路详解,希望对大家有所帮助,如果大家有任何疑问请给我留言,小编会及时回复大家的。在此也非常感谢大家对我网站的支持! 如果你觉得本文对你有帮助,欢迎转载,烦请注明出处,谢谢! 。

原文链接:https://blog.csdn.net/qq_42840203/article/details/103846093 。

最后此篇关于python爬虫爬取监控教务系统的思路详解的文章就讲到这里了,如果你想了解更多关于python爬虫爬取监控教务系统的思路详解的内容请搜索CFSDN的文章或继续浏览相关文章,希望大家以后支持我的博客! 。

大家好,我是汤师爷~ 什么是订单履约系统? 订单履约是从消费者下单支付到收到商品的全流程管理过程,包括订单接收、订单派单、库存分配、仓储管理和物流配送等环节,核心目标是确保商品准时、准确地送达消费

大家好,我是汤师爷~ 今天聊聊促销系统整体规划。 各类促销活动的系统流程,可以抽象为3大阶段: B端促销活动管理:商家运营人员在后台系统中配置和管理促销活动,包括设定活动基本信息、使用规则

全称“Java Virtual Machine statistics monitoring tool”(statistics 统计;monitoring 监控;tool 工具) 用于监控虚拟机的各种运

主要是讲下Mongodb的索引的查看、创建、删除、类型说明,还有就是Explain执行计划的解释说明。 可以转载,但请注明出处。

1>单线程或者单进程 相当于短链接,当accept之后,就开始数据的接收和数据的发送,不接受新的连接,即一个server,一个client 不存在并发。 2>循环服务器和并发服务器

详解 linux中的关机和重启命令 一 shutdown命令 shutdown [选项] 时间 选项: ?

首先,将json串转为一个JObject对象: ? 1

matplotlib官网 matplotlib库默认英文字体 添加黑体(‘SimHei')为绘图字体 代码: plt.rcParams['font.sans-serif']=['SimHei'

在并发编程中,synchronized关键字是常出现的角色。之前我们都称呼synchronized关键字为重量锁,但是在jdk1.6中对synchronized进行了优化,引入了偏向锁、轻量锁。本篇

一般我们的项目中会使用1到2个数据库连接配置,同程艺龙的数据库连接配置被收拢到统一的配置中心,由DBA统一配置和维护,业务方通过某个字符串配置拿到的是Connection对象。

实例如下: ? 1

1. MemoryCahe NetCore中的缓存和System.Runtime.Caching很相似,但是在功能上做了增强,缓存的key支持object类型;提供了泛型支持;可以读缓存和单个缓存

argument是javascript中函数的一个特殊参数,例如下文,利用argument访问函数参数,判断函数是否执行 复制代码 代码如下: <script

一不小心装了一个Redis服务,开了一个全网的默认端口,一开始以为这台服务器没有公网ip,结果发现之后悔之莫及啊 某天发现cpu load高的出奇,发现一个minerd进程 占了大量cpu,googl

今天写这个是为了 提醒自己 编程过程 不仅要有逻辑 思想 还有要规范 代码 这样可读性 1、PHP 编程规范与编码习惯最主要的有以下几点: 1 文件说明 2 funct

摘要:虚拟机安装时一般都采用最小化安装,默认没有lspci工具。一台测试虚拟网卡性能的虚拟机,需要lspci工具来查看网卡的类型。本文描述了在一个虚拟机中安装lspci工具的具体步骤。 由于要测试

1、修改用户进程可打开文件数限制 在Linux平台上,无论编写客户端程序还是服务端程序,在进行高并发TCP连接处理时,最高的并发数量都要受到系统对用户单一进程同时可打开文件数量的限制(这是因为系统

目录 算术运算符 基本四则运算符 增量赋值运算符 自增/自减运算符 关系运算符 逻

如下所示: ? 1

MapperScannerConfigurer之sqlSessionFactory注入方式讲解 首先,Mybatis中的有一段配置非常方便,省去我们去写DaoImpl(Dao层实现类)的时间,这个

我是一名优秀的程序员,十分优秀!