- ubuntu12.04环境下使用kvm ioctl接口实现最简单的虚拟机

- Ubuntu 通过无线网络安装Ubuntu Server启动系统后连接无线网络的方法

- 在Ubuntu上搭建网桥的方法

- ubuntu 虚拟机上网方式及相关配置详解

CFSDN坚持开源创造价值,我们致力于搭建一个资源共享平台,让每一个IT人在这里找到属于你的精彩世界.

这篇CFSDN的博客文章Java实现爬虫给App提供数据(Jsoup 网络爬虫)由作者收集整理,如果你对这篇文章有兴趣,记得点赞哟.

1、需求 。

最近基于 Material Design 重构了自己的新闻 App,数据来源是个问题.

有前人分析了知乎日报、凤凰新闻等 API,根据相应的 URL 可以获取新闻的 JSON 数据。为了锻炼写代码能力,笔者打算爬虫新闻页面,自己获取数据构建 API.

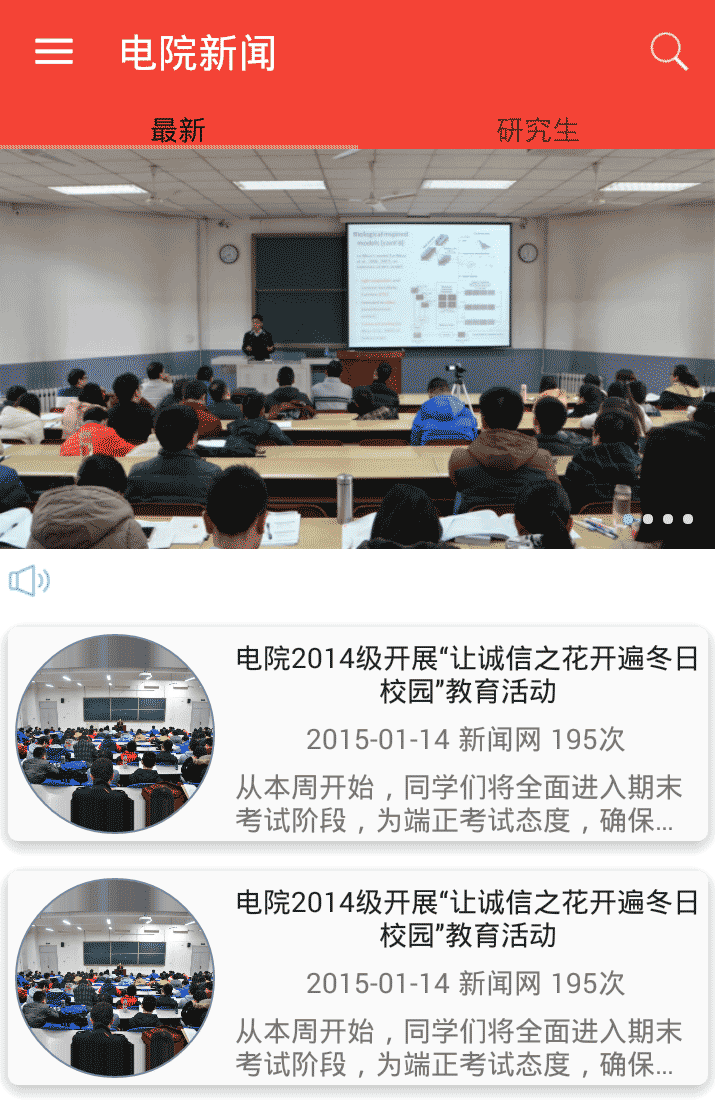

2、效果图 。

下图是原网站的页面 。

爬虫获取了数据,展示到 APP 手机端 。

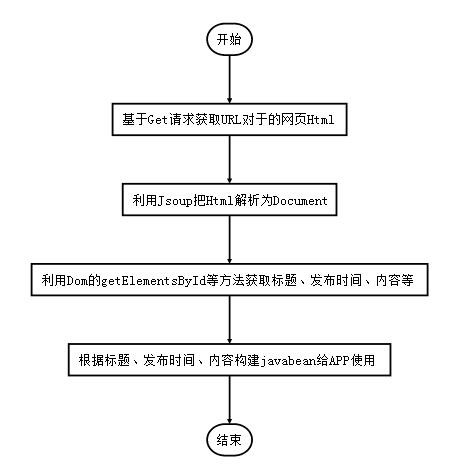

3、爬虫思路 。

关于App 的实现过程可以参看这几篇文章,本文主要讲解一下如何爬虫数据.

Jsoup 简介 。

Jsoup 是一个 Java 的开源HTML解析器,可直接解析某个URL地址、HTML文本内容.

Jsoup主要有以下功能:

4、爬虫过程 。

Get 请求获取网页 HTML 。

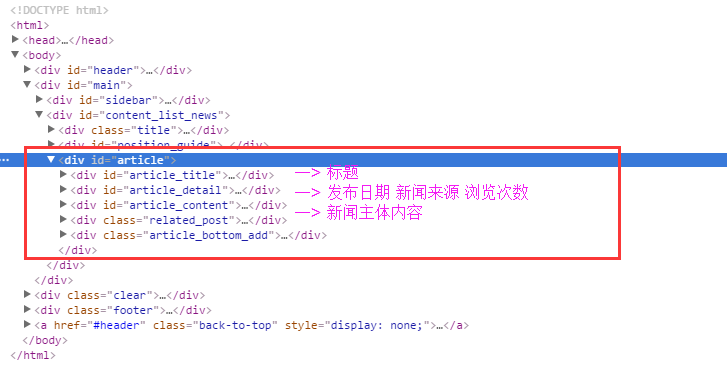

新闻网页Html的DOM树如下所示:

下面这段代码根据指定的 url,用代码获取get 请求返回的 html 源代码.

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

|

public

static

String doGet(String urlStr)

throws

CommonException {

URL url;

String html =

""

;

try

{

url =

new

URL(urlStr);

HttpURLConnection connection = (HttpURLConnection) url.openConnection();

connection.setRequestMethod(

"GET"

);

connection.setConnectTimeout(

5000

);

connection.setDoInput(

true

);

connection.setDoOutput(

true

);

if

(connection.getResponseCode() ==

200

) {

InputStream in = connection.getInputStream();

html = StreamTool.inToStringByByte(in);

}

else

{

throw

new

CommonException(

"新闻服务器返回值不为200"

);

}

}

catch

(Exception e) {

e.printStackTrace();

throw

new

CommonException(

"get请求失败"

);

}

return

html;

}

|

InputStream in = connection.getInputStream();将得到输入流转化为字符串是个普遍需求,我们将其抽象出来,写一个工具方法.

|

1

2

3

4

5

6

7

8

9

10

11

12

13

|

public

class

StreamTool {

public

static

String inToStringByByte(InputStream in)

throws

Exception {

ByteArrayOutputStream outStr =

new

ByteArrayOutputStream();

byte

[] buffer =

new

byte

[

1024

];

int

len =

0

;

StringBuilder content =

new

StringBuilder();

while

((len = in.read(buffer)) != -

1

) {

content.append(

new

String(buffer,

0

, len,

"UTF-8"

));

}

outStr.close();

return

content.toString();

}

}

|

5、解析 HTML 获取标题 。

利用 google 浏览器的审查元素,找出新闻标题对于的html 代码:

|

1

2

3

4

5

6

7

|

<

div

id

=

"article_title"

>

<

h1

>

<

a

href

=

"http://see.xidian.edu.cn/html/news/7428.html"

>

关于举办《经典音乐作品欣赏与人文审美》讲座的通知

</

a

>

</

h1

>

</

div

>

|

我们需要从上面的 HTML 中找出id="article_title"的部分,使用 getElementById(String id) 方法 。

|

1

2

3

4

5

6

7

8

9

|

String htmlStr = HttpTool.doGet(urlStr);

// 将获取的网页 HTML 源代码转化为 Document

Document doc = Jsoup.parse(htmlStr);

Element articleEle = doc.getElementById(

"article"

);

// 标题

Element titleEle = articleEle.getElementById(

"article_title"

);

String titleStr = titleEle.text();

|

6、获取发布日期、信息来源 。

同样找出对于的 HTML 代码 。

|

1

2

3

4

5

6

7

8

9

10

11

|

<

html

>

<

head

></

head

>

<

body

>

<

div

id

=

"article_detail"

>

<

span

> 2015-05-28 </

span

>

<

span

> 来源: </

span

>

<

span

> 浏览次数: <

script

language

=

"JavaScript"

src

=

"http://see.xidian.edu.cn/index.php/news/click/id/7428"

>

</

script

> 477 </

span

>

</

div

>

</

body

>

</

html

>

|

思路也和上面类似,使用 getElementById(String id) 方法找出id="article_detail"为Element,再利用getElementsByTag获取span 部分。因为一共有3个<span> ... </span>,所以返回的是Elements而不是Element.

|

1

2

3

4

5

6

7

8

9

|

// article_detail包括了 2016-01-15 来源: 浏览次数:177

Element detailEle = articleEle.getElementById(

"article_detail"

);

Elements details = detailEle.getElementsByTag(

"span"

);

// 发布时间

String dateStr = details.get(

0

).text();

// 新闻来源

String sourceStr = details.get(

1

).text();

|

7、解析浏览次数 。

如果打印出上面的details.get(2).text(),只会得到 。

浏览次数: 没有浏览次数?为什么呢?

因为浏览次数是JavaScript 渲染出来的, Jsoup爬虫可能仅仅提取HTML内容,得不到动态渲染出的数据。 解决方法有两种 。

如果你访问上面的 urlhttp://see.xidian.edu.cn/index.php/news/click/id/7428,会得到下面的结果 。

|

1

|

document.write(

478

)

|

这个478就是我们需要的浏览次数,我们对上面的url做get 请求,得到返回的字符串,利用正则找出其中的数字.

|

1

2

3

4

5

|

// 访问这个新闻页面,浏览次数会+1,次数是 JS 渲染的

String jsStr = HttpTool.doGet(COUNT_BASE_URL + currentPage);

int

readTimes = Integer.parseInt(jsStr.replaceAll(

"\D+"

,

""

));

// 或者使用下面这个正则方法

// String readTimesStr = jsStr.replaceAll("[^0-9]", "");

|

8、解析新闻内容 。

本来是获取新闻内容纯文字的形式,但后来发现 Android 端也可以显示 CSS 格式,所以后来内容保留了 HTML 格式.

|

1

2

3

4

5

6

|

Element contentEle = articleEle.getElementById(

"article_content"

);

// 新闻主体内容

String contentStr = contentEle.toString();

// 如果用 text()方法,新闻主体内容的 html 标签会丢失

// 为了在 Android 上用 WebView 显示 html,用toString()

// String contentStr = contentEle.text();

|

9、解析图片 Url 。

注意一个网页上大大小小的图片很多,为了只获取新闻正文中的内容,我们最好首先定位到新闻内容的Element,然后再利用getElementsByTag(“img”)筛选出图片.

|

1

2

3

4

5

6

7

8

9

10

11

12

|

Element contentEle = articleEle.getElementById(

"article_content"

);

// 新闻主体内容

String contentStr = contentEle.toString();

// 如果用 text()方法,新闻主体内容的 html 标签会丢失

// 为了在 Android 上用 WebView 显示 html,用toString()

// String contentStr = contentEle.text();

Elements images = contentEle.getElementsByTag(

"img"

);

String[] imageUrls =

new

String[images.size()];

for

(

int

i =

0

; i < imageUrls.length; i++) {

imageUrls[i] = images.get(i).attr(

"src"

);

}

|

10、新闻实体类 JavaBean 。

上面获取了新闻的标题、发布日期、阅读次数、新闻内容等等,我们自然需要构造一个 javabean,把获取的内容封装进实体类中.

- public class ArticleItem {

- private int index;

- private String[] imageUrls;

- private String title;

- private String publishDate;

- private String source;

- private int readTimes;

- private String body;

- public ArticleItem(int index, String[] imageUrls, String title, String publishDate, String source, int readTimes,

- String body) {

- this.index = index;

- this.imageUrls = imageUrls;

- this.title = title;

- this.publishDate = publishDate;

- this.source = source;

- this.readTimes = readTimes;

- this.body = body;

- }

- @Override

- public String toString() {

- return "ArticleItem [index=" + index + ", imageUrls=" + Arrays.toString(imageUrls) + ", title=" + title

- + ", publishDate=" + publishDate + ", source=" + source + ", readTimes=" + readTimes + ", body=" + body

- + "]";

- }

- }

测试 。

。

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

|

public

static

ArticleItem getNewsItem(

int

currentPage)

throws

CommonException {

// 根据后缀的数字,拼接新闻 url

String urlStr = ARTICLE_BASE_URL + currentPage +

".html"

;

String htmlStr = HttpTool.doGet(urlStr);

Document doc = Jsoup.parse(htmlStr);

Element articleEle = doc.getElementById(

"article"

);

// 标题

Element titleEle = articleEle.getElementById(

"article_title"

);

String titleStr = titleEle.text();

// article_detail包括了 2016-01-15 来源: 浏览次数:177

Element detailEle = articleEle.getElementById(

"article_detail"

);

Elements details = detailEle.getElementsByTag(

"span"

);

// 发布时间

String dateStr = details.get(

0

).text();

// 新闻来源

String sourceStr = details.get(

1

).text();

// 访问这个新闻页面,浏览次数会+1,次数是 JS 渲染的

String jsStr = HttpTool.doGet(COUNT_BASE_URL + currentPage);

int

readTimes = Integer.parseInt(jsStr.replaceAll(

"\D+"

,

""

));

// 或者使用下面这个正则方法

// String readTimesStr = jsStr.replaceAll("[^0-9]", "");

Element contentEle = articleEle.getElementById(

"article_content"

);

// 新闻主体内容

String contentStr = contentEle.toString();

// 如果用 text()方法,新闻主体内容的 html 标签会丢失

// 为了在 Android 上用 WebView 显示 html,用toString()

// String contentStr = contentEle.text();

Elements images = contentEle.getElementsByTag(

"img"

);

String[] imageUrls =

new

String[images.size()];

for

(

int

i =

0

; i < imageUrls.length; i++) {

imageUrls[i] = images.get(i).attr(

"src"

);

}

return

new

ArticleItem(currentPage, imageUrls, titleStr, dateStr, sourceStr, readTimes, contentStr);

}

public

static

void

main(String[] args)

throws

CommonException {

System.out.println(getNewsItem(

7928

));

}

|

输出信息 。

|

1

2

3

4

5

6

7

8

|

ArticleItem [index=

7928

,

imageUrls=[/uploads/image/

20160114

/20160114225911_34428.png],

title=电院

2014

级开展“让诚信之花开遍冬日校园”教育活动,

publishDate=

2016

-

01

-

14

,

source=来源: 电影新闻网,

readTimes=

200

,

body=<div id=

"article_content"

>

<p style=

"text-indent:2em;"

align=

"justify"

> <strong><span style=

"font-size:16px;line-height:1.5;"

>西电新闻网讯</span></strong><span style=

"font-size:16px;line-height:1.5;"

> (通讯员</span><strong><span style=

"font-size:16px;line-height:1.5;"

> 丁彤 王朱丹</span></strong><span style=

"font-size:16px;line-height:1.5;"

>...)

|

本文讲解了如何实现Jsoup 网络爬虫,如果文章对您有帮助,那就给个赞吧.

最后此篇关于Java实现爬虫给App提供数据(Jsoup 网络爬虫)的文章就讲到这里了,如果你想了解更多关于Java实现爬虫给App提供数据(Jsoup 网络爬虫)的内容请搜索CFSDN的文章或继续浏览相关文章,希望大家以后支持我的博客! 。

背景: 我最近一直在使用 JPA,我为相当大的关系数据库项目生成持久层的轻松程度给我留下了深刻的印象。 我们公司使用大量非 SQL 数据库,特别是面向列的数据库。我对可能对这些数据库使用 JPA 有一

我已经在我的 maven pom 中添加了这些构建配置,因为我希望将 Apache Solr 依赖项与 Jar 捆绑在一起。否则我得到了 SolarServerException: ClassNotF

interface ITurtle { void Fight(); void EatPizza(); } interface ILeonardo : ITurtle {

我希望可用于 Java 的对象/关系映射 (ORM) 工具之一能够满足这些要求: 使用 JPA 或 native SQL 查询获取大量行并将其作为实体对象返回。 允许在行(实体)中进行迭代,并在对当前

好像没有,因为我有实现From for 的代码, 我可以转换 A到 B与 .into() , 但同样的事情不适用于 Vec .into()一个Vec . 要么我搞砸了阻止实现派生的事情,要么这不应该发

在 C# 中,如果 A 实现 IX 并且 B 继承自 A ,是否必然遵循 B 实现 IX?如果是,是因为 LSP 吗?之间有什么区别吗: 1. Interface IX; Class A : IX;

就目前而言,这个问题不适合我们的问答形式。我们希望答案得到事实、引用资料或专业知识的支持,但这个问题可能会引发辩论、争论、投票或扩展讨论。如果您觉得这个问题可以改进并可能重新打开,visit the

我正在阅读标准haskell库的(^)的实现代码: (^) :: (Num a, Integral b) => a -> b -> a x0 ^ y0 | y0 a -> b ->a expo x0

我将把国际象棋游戏表示为 C++ 结构。我认为,最好的选择是树结构(因为在每个深度我们都有几个可能的移动)。 这是一个好的方法吗? struct TreeElement{ SomeMoveType

我正在为用户名数据库实现字符串匹配算法。我的方法采用现有的用户名数据库和用户想要的新用户名,然后检查用户名是否已被占用。如果采用该方法,则该方法应该返回带有数据库中未采用的数字的用户名。 例子: “贾

我正在尝试实现 Breadth-first search algorithm , 为了找到两个顶点之间的最短距离。我开发了一个 Queue 对象来保存和检索对象,并且我有一个二维数组来保存两个给定顶点

我目前正在 ika 中开发我的 Python 游戏,它使用 python 2.5 我决定为 AI 使用 A* 寻路。然而,我发现它对我的需要来说太慢了(3-4 个敌人可能会落后于游戏,但我想供应 4-

我正在寻找 Kademlia 的开源实现C/C++ 中的分布式哈希表。它必须是轻量级和跨平台的(win/linux/mac)。 它必须能够将信息发布到 DHT 并检索它。 最佳答案 OpenDHT是

我在一本书中读到这一行:-“当我们要求 C++ 实现运行程序时,它会通过调用此函数来实现。” 而且我想知道“C++ 实现”是什么意思或具体是什么。帮忙!? 最佳答案 “C++ 实现”是指编译器加上链接

我正在尝试使用分支定界的 C++ 实现这个背包问题。此网站上有一个 Java 版本:Implementing branch and bound for knapsack 我试图让我的 C++ 版本打印

在很多情况下,我需要在 C# 中访问合适的哈希算法,从重写 GetHashCode 到对数据执行快速比较/查找。 我发现 FNV 哈希是一种非常简单/好/快速的哈希算法。但是,我从未见过 C# 实现的

目录 LRU缓存替换策略 核心思想 不适用场景 算法基本实现 算法优化

1. 绪论 在前面文章中提到 空间直角坐标系相互转换 ,测绘坐标转换时,一般涉及到的情况是:两个直角坐标系的小角度转换。这个就是我们经常在测绘数据处理中,WGS-84坐标系、54北京坐标系

在软件开发过程中,有时候我们需要定时地检查数据库中的数据,并在发现新增数据时触发一个动作。为了实现这个需求,我们在 .Net 7 下进行一次简单的演示. PeriodicTimer .

二分查找 二分查找算法,说白了就是在有序的数组里面给予一个存在数组里面的值key,然后将其先和数组中间的比较,如果key大于中间值,进行下一次mid后面的比较,直到找到相等的,就可以得到它的位置。

我是一名优秀的程序员,十分优秀!