- ubuntu12.04环境下使用kvm ioctl接口实现最简单的虚拟机

- Ubuntu 通过无线网络安装Ubuntu Server启动系统后连接无线网络的方法

- 在Ubuntu上搭建网桥的方法

- ubuntu 虚拟机上网方式及相关配置详解

CFSDN坚持开源创造价值,我们致力于搭建一个资源共享平台,让每一个IT人在这里找到属于你的精彩世界.

这篇CFSDN的博客文章人工智能学习Pytorch教程Tensor基本操作示例详解由作者收集整理,如果你对这篇文章有兴趣,记得点赞哟.

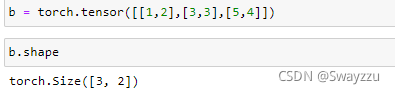

小写字母的tensor接收具体的数据,可以直接按照numpy的方式输入数组.

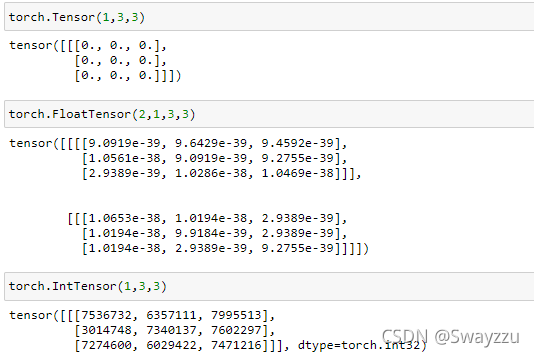

大写字母的可以接收形状,此时会生成随机数,但没有任何规则。可以生成不同的类型.

自动生成的数据有默认类型,FloatTensor,可以使用torch.set_default_tensor_type去修改 。

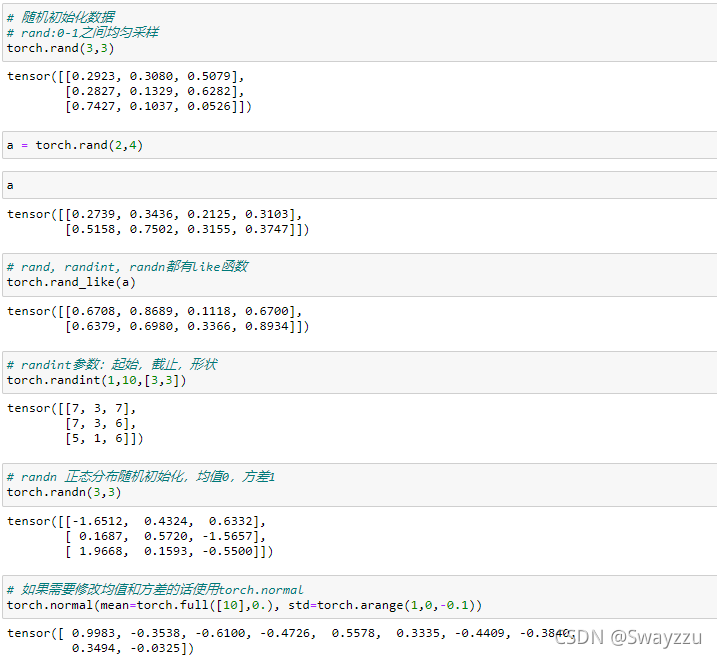

rand:0-1之间均匀采样 。

randn:均值0,方差1的正态分布随机采样 。

以上两种可以直接输入形状,即可产生对应形状的随机数.

randint:参数是---起始值、终止值、形状 。

同时每一个都会有一个_like方法,输入一个tensor,会生成对应形状的新tensor 。

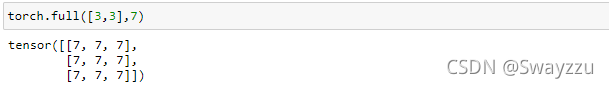

参数是---形状,数据。如果形状的位置给一个空的list,生成的就是标量.

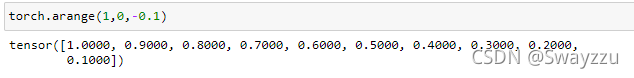

参数是---起始,终止,步长。不包含终止值.

参数是---起始,终止,数量。包含终止值 。

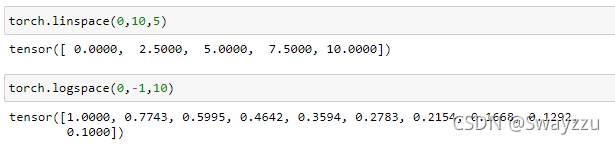

输入形状即可。ones和zeros也有_like方法 。

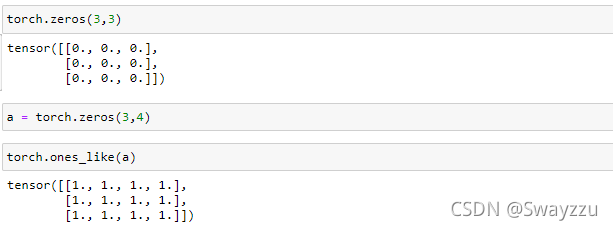

随机打散。输入一个数字,会自动生成这个数字长度的,从0开始的随机排列数字,可以作为索引。当需要对不同的数据,使用相同的索引,并且打乱顺序时,非常好用.

。

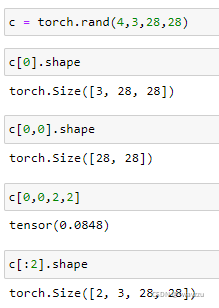

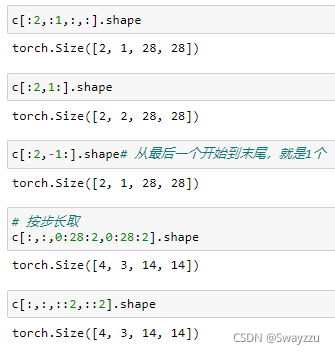

和python中的索引切片使用方法一致 。

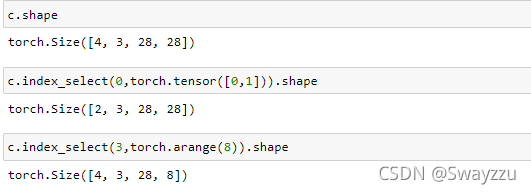

输入的参数---维度的位置、要选的内容对应的维度的索引。不太好理解,可以看下面的例子.

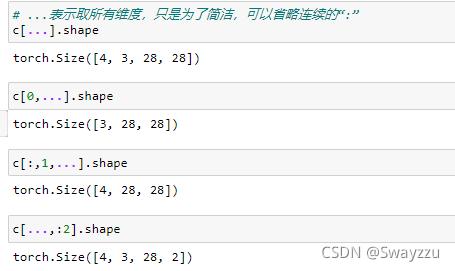

三个点相当于集成了的连续的冒号.

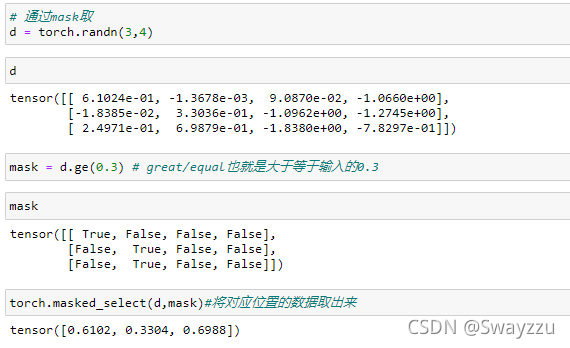

需要先根据数据生成一个mask,比如挑选出大于等于0.3的数,此时会得到一个和数据相同形状的,满足条件位置是1,不满足条件的位置是0的一个mask,通过masked_select可以选出数据.

。

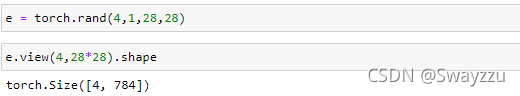

和numpy中的reshape方法一样。转换的时候需要考虑到实际的物理意义.

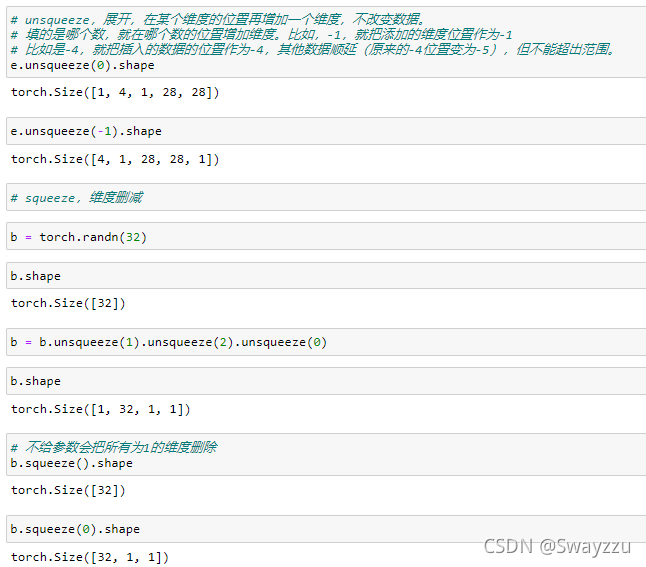

squeeze输入的参数---需要减少的维度所在位置 。

unsqueeze输入的参数---需要增加的维度所在的位置 。

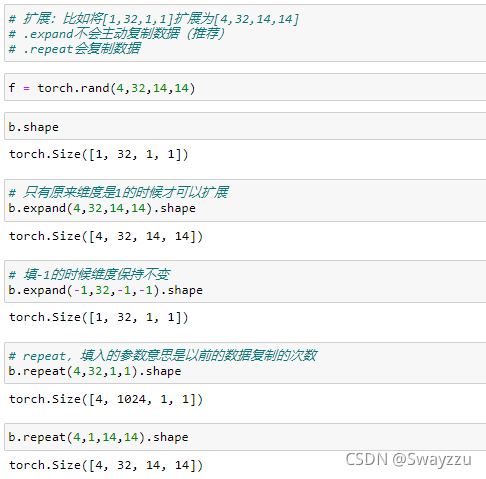

expand输入的参数---希望扩展后所形成的维度 。

repeat输入的参数---各自维度需要重复的次数 。

通常使用expand,因为不会主动复制数据.

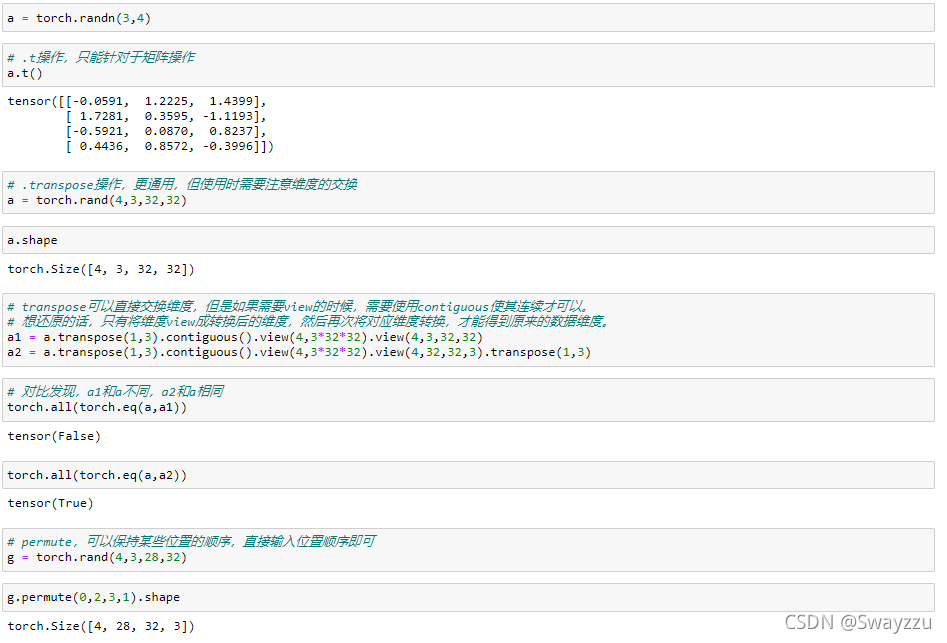

t:和numpy中的转置一样,只针对二维矩阵操作 。

transpose:输入需要交换的维度的位置即可。但想要还原的时候,需记得转换后的各个位置的物理意义,根据实际意义进行再次转换。见下面的例子.

permute:输入希望转换成的维度的位置索引即可。相当于多次使用transpose 。

以上就是人工智能学习Pytorch教程Tensor基本操作示例详解的详细内容,更多关于Pytorch的tensor基本操作的资料请关注我其它相关文章! 。

原文链接:https://blog.csdn.net/Swayzzu/article/details/121075984 。

最后此篇关于人工智能学习Pytorch教程Tensor基本操作示例详解的文章就讲到这里了,如果你想了解更多关于人工智能学习Pytorch教程Tensor基本操作示例详解的内容请搜索CFSDN的文章或继续浏览相关文章,希望大家以后支持我的博客! 。

我试图将迁移学习应用于 InceptionV3。这是我的代码: inception_model = InceptionV3(weights='imagenet',include_top=False)

我正在尝试展示 GAN 网络在某些指定时期的结果。打印当前结果的功能以前与 TF 一起使用。我需要换成 pytorch。 def show_result(G_net, z_, num_epoch, s

我对孪生神经网络还很陌生,最近发现了 this example和 Colab notebook . 运行代码时出现以下错误: IndexError: invalid index of a 0-dim

我正在尝试使用在此 PR 中添加的“高级”、numpy 样式的切片,但是我遇到了 same issue as the user here : ValueError: Shape must be ran

我想在 TensorFlow 中做类似这段 Numpy 代码的事情: a = np.zeros([5, 2]) idx = np.random.randint(0, 2, (5,)) row_idx

我有以下特征张量: Eigen::Tensor m(3,10,10); 我想访问第一个矩阵。在 numpy 中我会这样做 m(0,:,:) 我如何在 Eigen 中做到这一点 最佳答案 您可以使用 .

1、问题 模型训练完后进行测试,报错 RuntimeError: Tensor for 'out' is on CPU, Tensor for argument #1 'self' is on CPU

我正在对 TFRecords 进行配对,它为我提供了一个标签作为数值。但是我需要在读取原始记录时将此值转换为分类向量。我怎样才能做到这一点。这是读取原型(prototype)记录的代码片段: def

我正在对 TFRecords 进行配对,它为我提供了一个标签作为数值。但是我需要在读取原始记录时将此值转换为分类向量。我怎样才能做到这一点。这是读取原型(prototype)记录的代码片段: def

我应该如何从 Eigen::Tensor 创建一个 tensorflow::Tensor?我可以一个接一个地复制元素,但我希望有更好的方法。 最佳答案 没有公共(public) api 可以在不复制数

我正在尝试使用 Tensorflow(版本 0.9.0)以与 beginner's tutorial 非常相似的方式训练一个简单的二元逻辑回归分类器。并且在拟合模型时遇到以下错误: ValueErro

从 0.4.0 版本开始,可以使用 torch.tensor 和 torch.Tensor 有什么区别?提供这两个非常相似且令人困惑的替代方案的原因是什么? 最佳答案 在 PyTorch 中,torc

PyTorch0.4中,.data 仍保留,但建议使用 .detach(), 区别在于 .data 返回和 x 的相同数据 tensor, 但不会加入到x的计算历史里,且require s_grad

我有一个参差不齐的张量,在尝试创建模型并使用 model.fit() 时,出现错误:TypeError: Failed to convert object of type to Tensor. Co

我必须用生成器和判别器训练一个 GAN 网络。我的发电机网络如下。 def Generator(image_shape=(512,512,3): inputs = Input(image_shap

我正在使用 Flask 运行 Web 服务器,当我尝试使用 vgg16 时出现错误,vgg16 是 keras 的预训练 VGG16 模型的全局变量。我不知道为什么会出现这个错误,也不知道它是否与 T

我正在使用 keras 的预训练模型,并且在调用 ResNet50(weights='imagenet') 时出现错误。 我在 flask 服务器中有以下代码: def getVGG16Predict

执行以下代码时出现以下错误。 rnn.rnn() 返回张量列表。错误在 convert_to_tensor 行。 TypeError: List of Tensors when single Tens

我有一个fruit_train_net.py 文件,其中包含以下代码 import tensorflow as tf import numpy as np import time import os

我们可以使用 torch.Tensor([1., 2.], device='cuda') 在 GPU 上分配张量.使用这种方式而不是torch.cuda.Tensor([1., 2.])有什么不同吗?

我是一名优秀的程序员,十分优秀!