- ubuntu12.04环境下使用kvm ioctl接口实现最简单的虚拟机

- Ubuntu 通过无线网络安装Ubuntu Server启动系统后连接无线网络的方法

- 在Ubuntu上搭建网桥的方法

- ubuntu 虚拟机上网方式及相关配置详解

CFSDN坚持开源创造价值,我们致力于搭建一个资源共享平台,让每一个IT人在这里找到属于你的精彩世界.

这篇CFSDN的博客文章浅谈MyBatis原生批量插入的坑与解决方案由作者收集整理,如果你对这篇文章有兴趣,记得点赞哟.

前面的文章咱们讲了 MyBatis 批量插入的 3 种方法:循环单次插入、MyBatis Plus 批量插入、MyBatis 原生批量插入,详情请点击《MyBatis 批量插入数据的 3 种方法!》 。

但之前的文章也有不完美之处,原因在于:使用 「循环单次插入」的性能太低,使用「MyBatis Plus 批量插入」性能还行,但要额外的引入 MyBatis Plus 框架,使用「MyBatis 原生批量插入」性能最好,但在插入大量数据时会导致程序报错,那么,今天咱们就会提供一个更优的解决方案.

。

首先,我们来看一下 MyBatis 原生批量插入中的坑,当我们批量插入 10 万条数据时,实现代码如下:

import com.example.demo.model.User;import com.example.demo.service.impl.UserServiceImpl;import org.junit.jupiter.api.Test;import org.springframework.beans.factory.annotation.Autowired;import org.springframework.boot.test.context.SpringBootTest; import java.util.ArrayList;import java.util.List; @SpringBootTestclass UserControllerTest { // 最大循环次数 private static final int MAXCOUNT = 100000; @Autowired private UserServiceImpl userService; /** * 原生自己拼接 SQL,批量插入 */ @Test void saveBatchByNative() { long stime = System.currentTimeMillis(); // 统计开始时间 List<User> list = new ArrayList<>(); for (int i = 0; i < MAXCOUNT; i++) { User user = new User(); user.setName("test:" + i); user.setPassword("123456"); list.add(user); } // 批量插入 userService.saveBatchByNative(list); long etime = System.currentTimeMillis(); // 统计结束时间 System.out.println("执行时间:" + (etime - stime)); }}

核心文件 UserMapper.xml 中的实现代码如下:

<?xml version="1.0" encoding="UTF-8"?><!DOCTYPE mapper PUBLIC "-//mybatis.org//DTD Mapper 3.0//EN" "http://mybatis.org/dtd/mybatis-3-mapper.dtd"><mapper namespace="com.example.demo.mapper.UserMapper"> <insert id="saveBatchByNative"> INSERT INTO `USER`(`NAME`,`PASSWORD`) VALUES <foreach collection="list" separator="," item="item"> (#{item.name},#{item.password}) </foreach> </insert> </mapper>

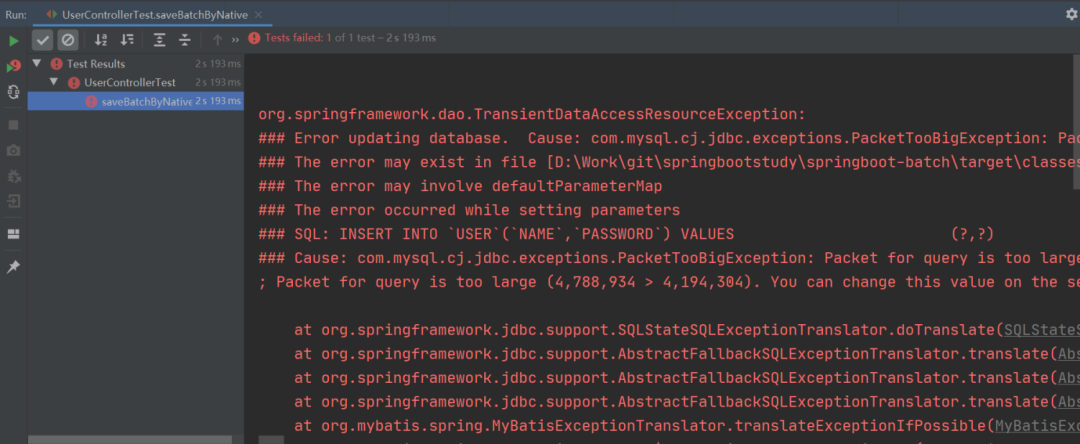

当我们开心地运行以上程序时,就出现了以下的一幕:

沃,程序竟然报错了! 。

这是因为使用 MyBatis 原生批量插入拼接的插入 SQL 大小是 4.56M,而默认情况下 MySQL 可以执行的最大 SQL 为 4M,那么在程序执行时就会报错了.

。

以上的问题就是因为批量插入时拼接的 SQL 文件太大了,所以导致 MySQL 的执行报错了。那么我们第一时间想到的解决方案就是将大文件分成 N 个小文件,这样就不会因为 SQL 太大而导致执行报错了。也就是说,我们可以将待插入的 List 集合分隔为多个小 List 来执行批量插入的操作,而这个操作过程就叫做 List 分片.

有了处理思路之后,接下来就是实操了,那如何对集合进行分片操作呢?

分片操作的实现方式有很多种,这个我们后文再讲,接下来我们使用最简单的方式,也就是 Google 提供的 Guava 框架来实现分片的功能.

。

要实现分片功能,第一步我们先要添加 Guava 框架的支持,在 pom.xml 中添加以下引用:

<!-- google guava 工具类 --><!-- https://mvnrepository.com/artifact/com.google.guava/guava --><dependency> <groupId>com.google.guava</groupId> <artifactId>guava</artifactId> <version>31.0.1-jre</version></dependency>

接下来我们写一个小小的 demo,将以下 7 个人名分为 3 组(每组最多 3 个),实现代码如下:

import com.google.common.collect.Lists; import java.util.Arrays;import java.util.List; /** * Guava 分片 */public class PartitionByGuavaExample { // 原集合 private static final List<String> OLD_LIST = Arrays.asList( "唐僧,悟空,八戒,沙僧,曹操,刘备,孙权".split(",")); public static void main(String[] args) { // 集合分片 List<List<String>> newList = Lists.partition(OLD_LIST, 3); // 打印分片集合 newList.forEach(i -> { System.out.println("集合长度:" + i.size()); }); }}

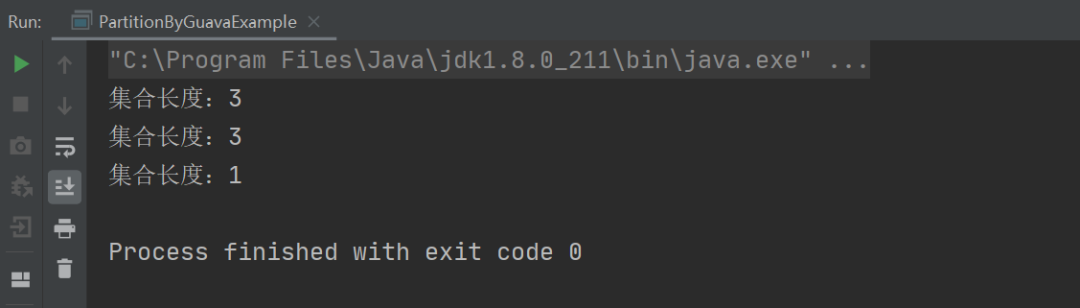

以上程序的执行结果如下:

从上述结果可以看出,我们只需要使用 Guava 提供的 Lists.partition 方法就可以很轻松的将一个集合进行分片了.

。

那接下来,就是改造我们的 MyBatis 批量插入代码了,具体实现如下:

@Testvoid saveBatchByNativePartition() { long stime = System.currentTimeMillis(); // 统计开始时间 List<User> list = new ArrayList<>(); // 构建插入数据 for (int i = 0; i < MAXCOUNT; i++) { User user = new User(); user.setName("test:" + i); user.setPassword("123456"); list.add(user); } // 分片批量插入 int count = (int) Math.ceil(MAXCOUNT / 1000.0); // 分为 n 份,每份 1000 条 List<List<User>> listPartition = Lists.partition(list, count); // 分片批量插入 for (List<User> item : listPartition) { userService.saveBatchByNative(item); } long etime = System.currentTimeMillis(); // 统计结束时间 System.out.println("执行时间:" + (etime - stime));}

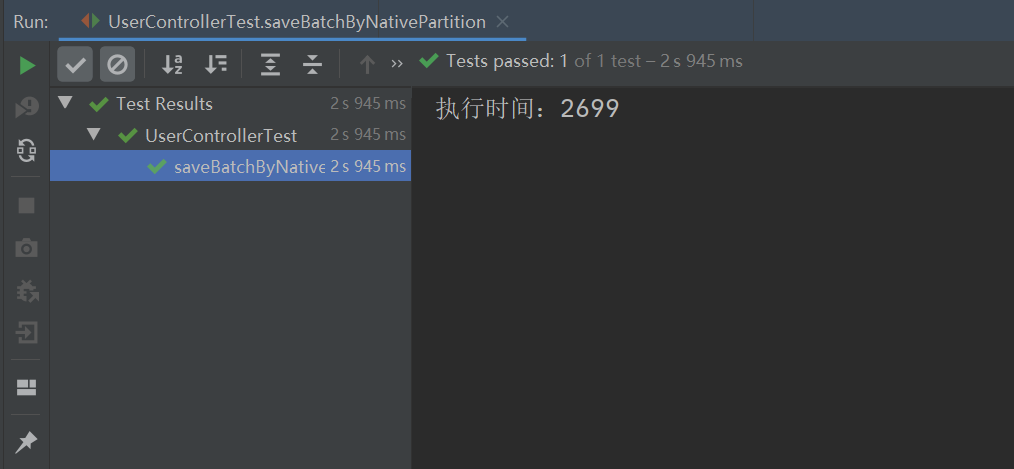

执行以上程序,最终的执行结果如下:

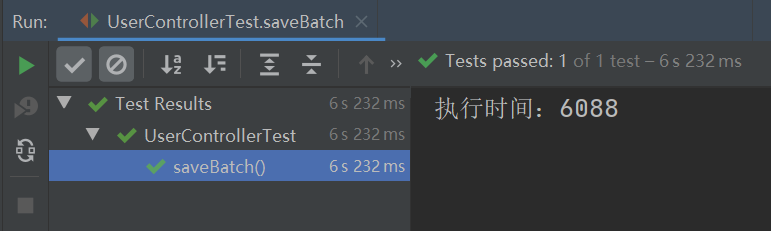

从上图可以看出,之前批量插入时的异常报错不见了,并且此实现方式的执行效率竟比 MyBatis Plus 的批量插入的执行效率要高,MyBatis Plus 批量插入 10W 条数据的执行时间如下:

。

本文我们演示了 MyBatis 原生批量插入时的问题:可能会因为插入的数据太多从而导致运行失败,我们可以通过分片的方式来解决此问题,分片批量插入的实现步骤如下:

到此这篇关于浅谈MyBatis原生批量插入的坑与解决方案的文章就介绍到这了,更多相关MyBatis原生批量插入内容请搜索我以前的文章或继续浏览下面的相关文章希望大家以后多多支持我! 。

原文链接:https://blog.csdn.net/sufu1065/article/details/120838034 。

最后此篇关于浅谈MyBatis原生批量插入的坑与解决方案的文章就讲到这里了,如果你想了解更多关于浅谈MyBatis原生批量插入的坑与解决方案的内容请搜索CFSDN的文章或继续浏览相关文章,希望大家以后支持我的博客! 。

前言 每日站会(Daily Standup)是团队统一节奏的、在固定时间发生的、帮助团队内部快速同步进展的敏捷实践活动: 站会的目的是让团队能更好地对齐 Sprint 目标;

jdbcTemplate 中的queryForList,你真的懂吗? 你想象中的queryForList是不是应该长成下面这种模样? String sql = "select *

python是一门清晰简洁的语言,如果你对一些细节不了解的话,就会掉入到那些深不见底的“坑”里,下面,我就来总结一些python里常见的坑。 列表创建和引用 嵌套列表的创建 使用*号来创建一个

如今,在DevOps当中建立安全体系显得比以往任何时候都更加重要。《2021年企业DevOps技能提升报告》指出,56%的受访者表示DevSecOps已经成为自动化工具中的一大必备要素。然而,D

前言 相信看到这个题目,可能大家都觉得是一个老生常谈的月经topic了。一直以来其实把握一个“值传递”基本上就能理解各种情况了,不过最近遇到了更深一点的“小坑”,与大家分享一下。 首先还是从最简

前言 Go 中的for range组合可以和方便的实现对一个数组或切片进行遍历,但是在某些情况下使用for range时很可能就会被"坑",下面用一段代码来模拟下:

大家好,我是明哥。 在开始之前,先考你一个非常 Go 味的经典问题:如何判断一个 interface{} 的值是否为 nil ? 这也是面试有可能会被问到的一个问题,这个问题很 “迷”,平时

ava并发包有很大一部分内容都是关于并发容器的,因此学习和搞懂这部分的内容很有必要。 Java 1.5 之前提供的同步容器虽然也能保证线程安全,但是性能很差,而 Java 1.5 版本之后提供的并发

大家好,我是煎鱼。 前几天在读者交流群里看到一位小伙伴,针对 interface 的使用有了比较大的疑惑。 无独有偶,我也在网上看到有小伙伴在 Go 面试的时候被问到了:

我是一名优秀的程序员,十分优秀!