- ubuntu12.04环境下使用kvm ioctl接口实现最简单的虚拟机

- Ubuntu 通过无线网络安装Ubuntu Server启动系统后连接无线网络的方法

- 在Ubuntu上搭建网桥的方法

- ubuntu 虚拟机上网方式及相关配置详解

CFSDN坚持开源创造价值,我们致力于搭建一个资源共享平台,让每一个IT人在这里找到属于你的精彩世界.

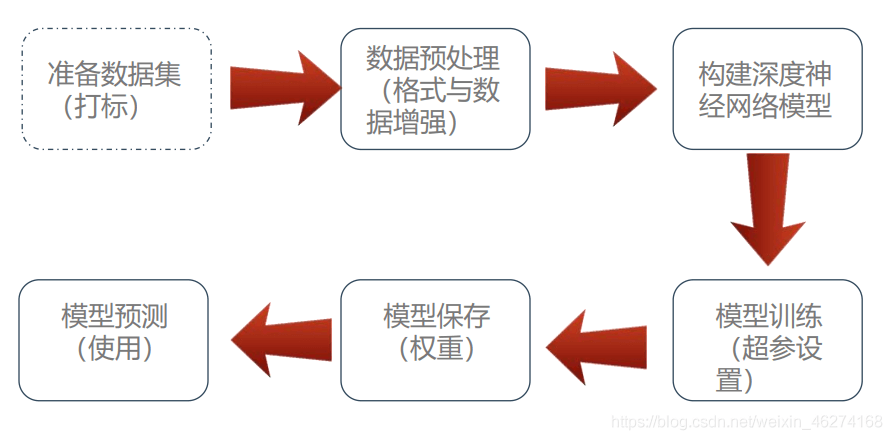

这篇CFSDN的博客文章由浅入深学习TensorFlow MNIST 数据集由作者收集整理,如果你对这篇文章有兴趣,记得点赞哟.

MNIST 包含 0~9 的手写数字, 共有 60000 个训练集和 10000 个测试集. 数据的格式为单通道 28*28 的灰度图. 。

。

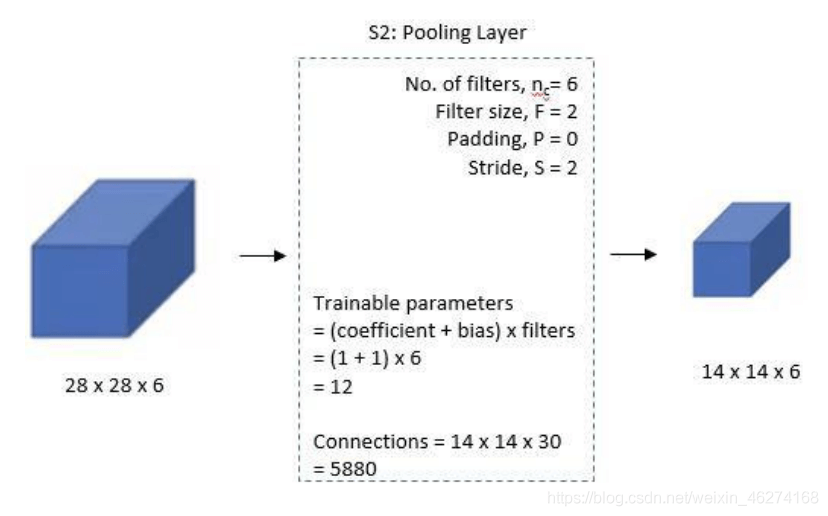

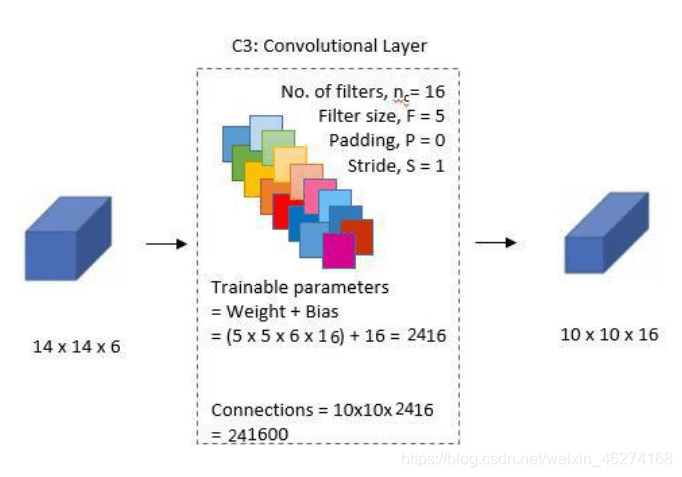

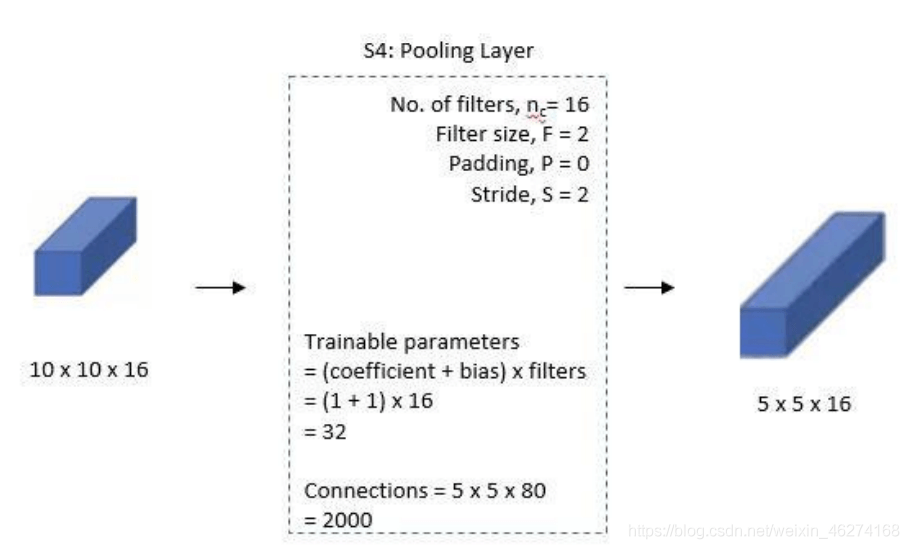

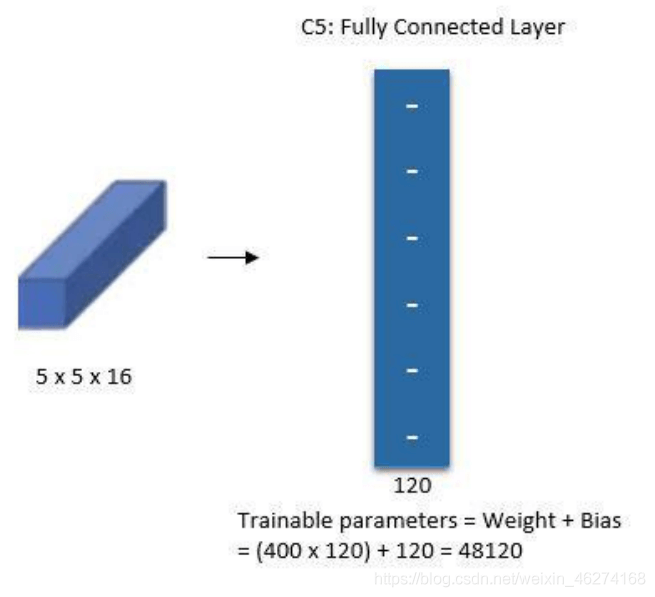

LeNet 网络最早由纽约大学的 Yann LeCun 等人于 1998 年提出, 也称 LeNet5. LeNet 是神经网络的鼻祖, 被誉为卷积神经网络的 “Hello World”. 。

。

。

from tensorflow.keras.datasets import mnistfrom matplotlib import pyplot as pltimport numpy as npimport tensorflow as tf

# ------------------1. 读取 & 查看数据------------------# 读取数据(X_train, y_train), (X_test, y_test) = mnist.load_data()# 数据集查看print(X_train.shape) # (60000, 28, 28)print(y_train.shape) # (60000,)print(X_test.shape) # (10000, 28, 28)print(y_test.shape) # (10000,)print(type(X_train)) # <class 'numpy.ndarray'># 图片显示plt.imshow(X_train[0], cmap="Greys") # 查看第一张图片plt.show()

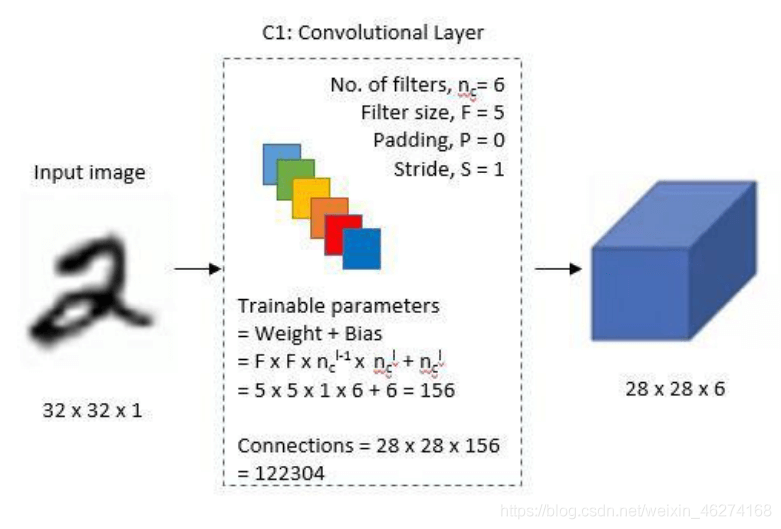

# ------------------2. 数据预处理------------------# 格式转换 (将图片从28*28扩充为32*32)X_train = np.pad(X_train, ((0, 0), (2, 2), (2, 2)), "constant", constant_values=0)X_test = np.pad(X_test, ((0, 0), (2, 2), (2, 2)), "constant", constant_values=0)print(X_train.shape) # (60000, 32, 32)print(X_test.shape) # (10000, 32, 32)# 数据集格式变换X_train = X_train.astype(np.float32)X_test = X_test.astype(np.float32)# 数据正则化X_train /= 255X_test /= 255# 数据维度转换X_train = np.expand_dims(X_train, axis=-1)X_test = np.expand_dims(X_test, axis=-1)print(X_train.shape) # (60000, 32, 32, 1)print(X_test.shape) # (10000, 32, 32, 1)

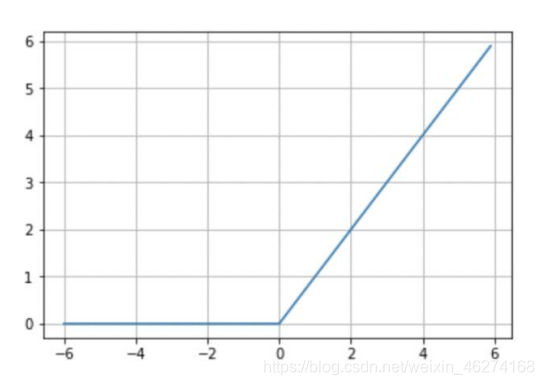

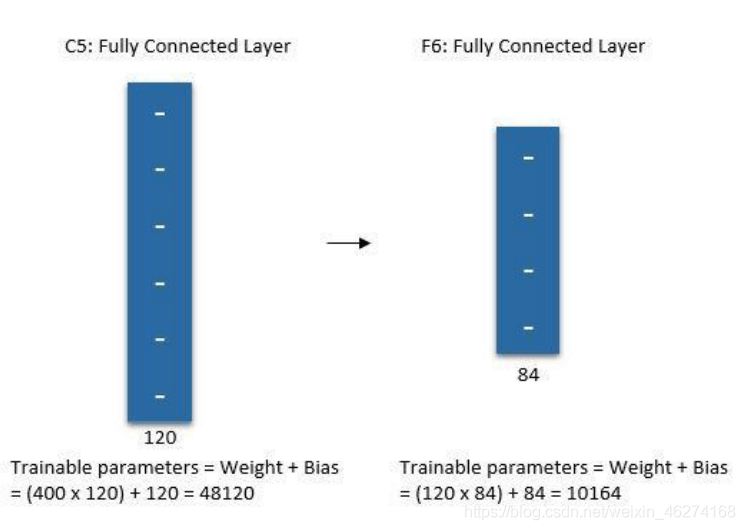

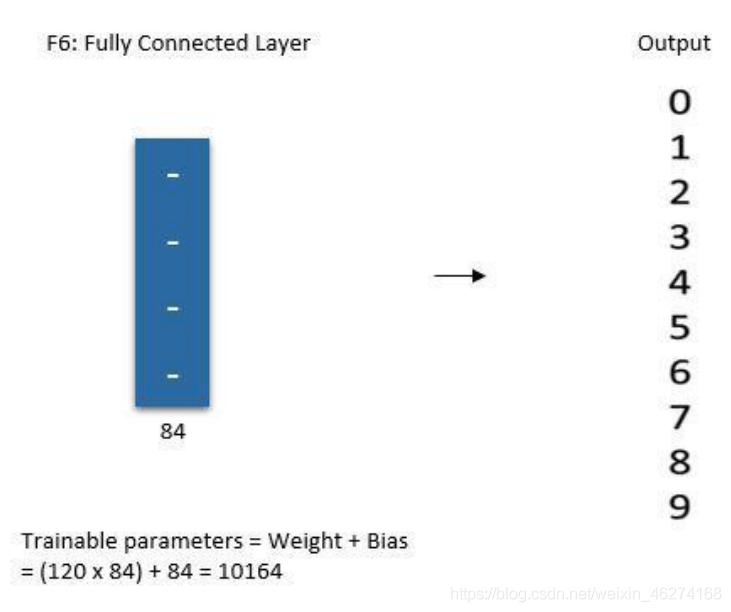

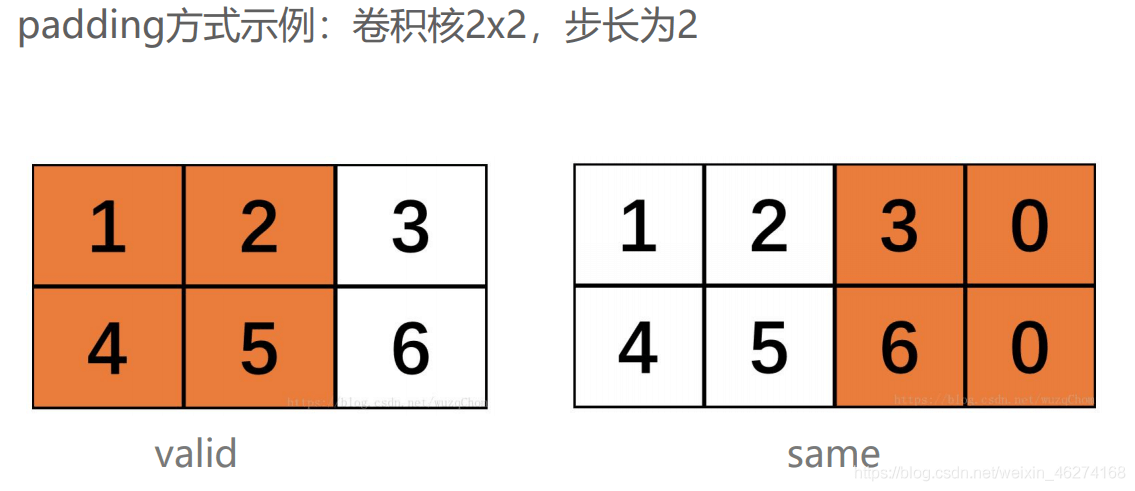

# 第一个卷积层conv_layer_1 = tf.keras.layers.Conv2D(filters=6, kernel_size=(5, 5), padding="valid", activation=tf.nn.relu)# 第一个池化层pool_layer_1 = tf.keras.layers.MaxPool2D(pool_size=(2, 2), padding="same")# 第二个卷积层conv_layer_2 = tf.keras.layers.Conv2D(filters=16, kernel_size=(5, 5), padding="valid", activation=tf.nn.relu)# 第二个池化层pool_layer_2 = tf.keras.layers.MaxPool2D(padding="same")# 扁平化flatten = tf.keras.layers.Flatten()# 第一个全连接层fc_layer_1 = tf.keras.layers.Dense(units=120, activation=tf.nn.relu)# 第二个全连接层fc_layer_2 = tf.keras.layers.Dense(units=84, activation=tf.nn.softmax)# 输出层output_layer = tf.keras.layers.Dense(units=10, activation=tf.nn.softmax)

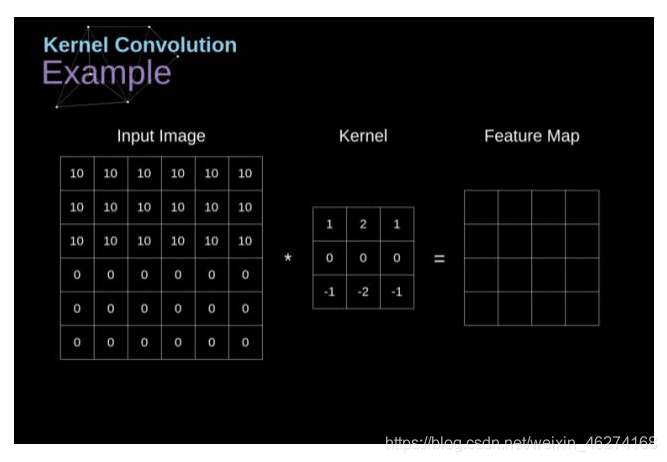

卷积 Conv2D 的用法

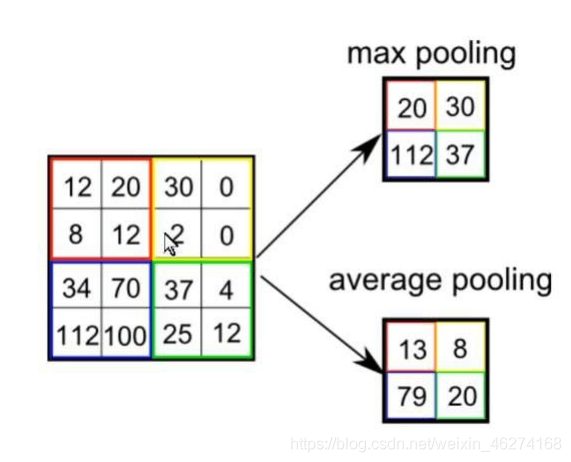

池化 AveragePooling2D 的用法

全连接 Dense 的用法

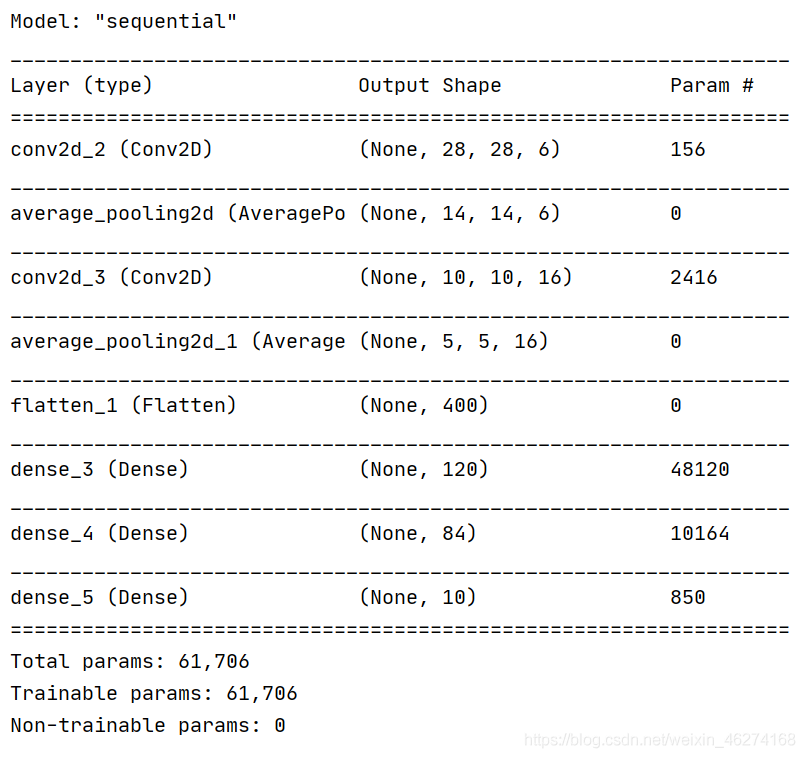

# 模型实例化model = tf.keras.models.Sequential([ tf.keras.layers.Conv2D(filters=6, kernel_size=(5, 5), padding='valid', activation=tf.nn.relu, input_shape=(32, 32, 1)), # relu tf.keras.layers.AveragePooling2D(pool_size=(2, 2), strides=(2, 2), padding='same'), tf.keras.layers.Conv2D(filters=16, kernel_size=(5, 5), padding='valid', activation=tf.nn.relu), tf.keras.layers.AveragePooling2D(pool_size=(2, 2), strides=(2, 2), padding='same'), tf.keras.layers.Flatten(), tf.keras.layers.Dense(units=120, activation=tf.nn.relu), tf.keras.layers.Dense(units=84, activation=tf.nn.relu), tf.keras.layers.Dense(units=10, activation=tf.nn.softmax)])# 模型展示model.summary()

输出结果

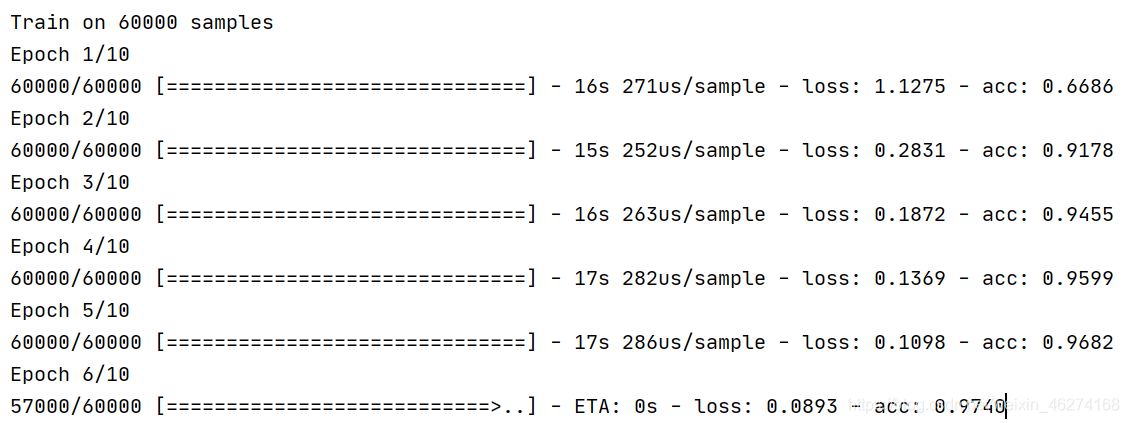

# ------------------4. 训练模型------------------# 设置超参数num_epochs = 10 # 训练轮数batch_size = 1000 # 批次大小learning_rate = 0.001 # 学习率

# 定义优化器adam_optimizer = tf.keras.optimizers.Adam(learning_rate)model.compile(optimizer=adam_optimizer,loss=tf.keras.losses.sparse_categorical_crossentropy,metrics=['accuracy'])

complie 的用法

with tf.Session() as sess: # 初始化所有变量 init = tf.global_variables_initializer() sess.run(init) model.fit(x=X_train,y=y_train,batch_size=batch_size,epochs=num_epochs) # 评估指标 print(model.evaluate(X_test, y_test)) # loss value & metrics values

输出结果

fit 的用法

# ------------------5. 保存模型------------------model.save('lenet_model.h5')

。

。

from tensorflow.keras.datasets import mnistfrom matplotlib import pyplot as pltimport numpy as npimport tensorflow as tf# ------------------1. 读取 & 查看数据------------------# 读取数据(X_train, y_train), (X_test, y_test) = mnist.load_data()# 数据集查看print(X_train.shape) # (60000, 28, 28)print(y_train.shape) # (60000,)print(X_test.shape) # (10000, 28, 28)print(y_test.shape) # (10000,)print(type(X_train)) # <class 'numpy.ndarray'># 图片显示plt.imshow(X_train[0], cmap="Greys") # 查看第一张图片plt.show()# ------------------2. 数据预处理------------------# 格式转换 (将图片从28*28扩充为32*32)X_train = np.pad(X_train, ((0, 0), (2, 2), (2, 2)), "constant", constant_values=0)X_test = np.pad(X_test, ((0, 0), (2, 2), (2, 2)), "constant", constant_values=0)print(X_train.shape) # (60000, 32, 32)print(X_test.shape) # (10000, 32, 32)# 数据集格式变换X_train = X_train.astype(np.float32)X_test = X_test.astype(np.float32)# 数据正则化X_train /= 255X_test /= 255# 数据维度转换X_train = np.expand_dims(X_train, axis=-1)X_test = np.expand_dims(X_test, axis=-1)print(X_train.shape) # (60000, 32, 32, 1)print(X_test.shape) # (10000, 32, 32, 1)# ------------------3. 模型建立------------------# 第一个卷积层conv_layer_1 = tf.keras.layers.Conv2D(filters=6, kernel_size=(5, 5), padding="valid", activation=tf.nn.relu)# 第一个池化层pool_layer_1 = tf.keras.layers.MaxPool2D(pool_size=(2, 2), padding="same")# 第二个卷积层conv_layer_2 = tf.keras.layers.Conv2D(filters=16, kernel_size=(5, 5), padding="valid", activation=tf.nn.relu)# 第二个池化层pool_layer_2 = tf.keras.layers.MaxPool2D(padding="same")# 扁平化flatten = tf.keras.layers.Flatten()# 第一个全连接层fc_layer_1 = tf.keras.layers.Dense(units=120, activation=tf.nn.relu)# 第二个全连接层fc_layer_2 = tf.keras.layers.Dense(units=84, activation=tf.nn.softmax)# 输出层output_layer = tf.keras.layers.Dense(units=10, activation=tf.nn.softmax)# 模型实例化model = tf.keras.models.Sequential([ tf.keras.layers.Conv2D(filters=6, kernel_size=(5, 5), padding='valid', activation=tf.nn.relu, input_shape=(32, 32, 1)), # relu tf.keras.layers.AveragePooling2D(pool_size=(2, 2), strides=(2, 2), padding='same'), tf.keras.layers.Conv2D(filters=16, kernel_size=(5, 5), padding='valid', activation=tf.nn.relu), tf.keras.layers.AveragePooling2D(pool_size=(2, 2), strides=(2, 2), padding='same'), tf.keras.layers.Flatten(), tf.keras.layers.Dense(units=120, activation=tf.nn.relu), tf.keras.layers.Dense(units=84, activation=tf.nn.relu), tf.keras.layers.Dense(units=10, activation=tf.nn.softmax)])# 模型展示model.summary()# ------------------4. 训练模型------------------# 设置超参数num_epochs = 10 # 训练轮数batch_size = 1000 # 批次大小learning_rate = 0.001 # 学习率# 定义优化器adam_optimizer = tf.keras.optimizers.Adam(learning_rate)model.compile(optimizer=adam_optimizer,loss=tf.keras.losses.sparse_categorical_crossentropy,metrics=['accuracy'])with tf.Session() as sess: # 初始化所有变量 init = tf.global_variables_initializer() sess.run(init) model.fit(x=X_train,y=y_train,batch_size=batch_size,epochs=num_epochs) # 评估指标 print(model.evaluate(X_test, y_test)) # loss value & metrics values# ------------------5. 保存模型------------------model.save('lenet_model.h5')

到此这篇关于由浅入深学习TensorFlow MNIST 数据集的文章就介绍到这了,更多相关TensorFlow MNIST 数据集内容请搜索我以前的文章或继续浏览下面的相关文章希望大家以后多多支持我! 。

原文链接:https://blog.csdn.net/weixin_46274168/article/details/114109017 。

最后此篇关于由浅入深学习TensorFlow MNIST 数据集的文章就讲到这里了,如果你想了解更多关于由浅入深学习TensorFlow MNIST 数据集的内容请搜索CFSDN的文章或继续浏览相关文章,希望大家以后支持我的博客! 。

关闭。这个问题是opinion-based .它目前不接受答案。 想要改进这个问题? 更新问题,以便 editing this post 可以用事实和引用来回答它. 关闭 9 年前。 Improve

介绍篇 什么是MiniApis? MiniApis的特点和优势 MiniApis的应用场景 环境搭建 系统要求 安装MiniApis 配置开发环境 基础概念 MiniApis架构概述

我正在从“JavaScript 圣经”一书中学习 javascript,但我遇到了一些困难。我试图理解这段代码: function checkIt(evt) { evt = (evt) ? e

package com.fastone.www.javademo.stringintern; /** * * String.intern()是一个Native方法, * 它的作用是:如果字

您会推荐哪些资源来学习 AppleScript。我使用具有 Objective-C 背景的传统 C/C++。 我也在寻找有关如何更好地开发和从脚本编辑器获取更快文档的技巧。示例提示是“查找要编写脚本的

关闭。这个问题不满足Stack Overflow guidelines .它目前不接受答案。 想改善这个问题吗?更新问题,使其成为 on-topic对于堆栈溢出。 4年前关闭。 Improve thi

关闭。这个问题不满足Stack Overflow guidelines .它目前不接受答案。 想改善这个问题吗?更新问题,使其成为 on-topic对于堆栈溢出。 7年前关闭。 Improve thi

关闭。这个问题不符合 Stack Overflow guidelines 。它目前不接受答案。 想改善这个问题吗?更新问题,以便堆栈溢出为 on-topic。 6年前关闭。 Improve this

我是塞内加尔的阿里。我今年60岁(也许这是我真正的问题-笑脸!!!)。 我正在学习Flutter和Dart。今天,我想使用给定数据模型的列表(它的名称是Mortalite,请参见下面的代码)。 我尝试

关闭。这个问题是off-topic .它目前不接受答案。 想改进这个问题? Update the question所以它是on-topic对于堆栈溢出。 9年前关闭。 Improve this que

学习 Cappuccino 的最佳来源是什么?我从事“传统”网络开发,但我对这个新框架非常感兴趣。请注意,我对 Objective-C 毫无了解。 最佳答案 如上所述,该网站是一个好地方,但还有一些其

我正在学习如何使用 hashMap,有人可以检查我编写的这段代码并告诉我它是否正确吗?这个想法是有一个在公司工作的员工列表,我想从 hashMap 添加和删除员工。 public class Staf

我正在尝试将 jQuery 与 CoffeScript 一起使用。我按照博客中的说明操作,指示使用 $ -> 或 jQuery -> 而不是 .ready() 。我玩了一下代码,但我似乎无法理解我出错

还在学习,还有很多问题,所以这里有一些。我正在进行 javascript -> PHP 转换,并希望确保这些做法是正确的。是$dailyparams->$calories = $calories;一条

我目前正在学习 SQL,以便从我们的 Magento 数据库制作一个简单的 RFM 报告,我目前可以通过导出两个查询并将它们粘贴到 Excel 模板中来完成此操作,我想摆脱 Excel 模板。 我认为

我知道我很可能会因为这个问题而受到抨击,但没有人问,我求助于你。这是否是一个正确的 javascript > php 转换 - 在我开始不良做法之前,我想知道这是否是解决此问题的正确方法。 JavaS

除了 Ruby-Doc 之外,哪些来源最适合获取一些示例和教程,尤其是关于 Ruby 中的 Tk/Tile?我发现自己更正常了 http://www.tutorialspoint.com/ruby/r

我只在第一次收到警告。这正常吗? >>> cv=LassoCV(cv=10).fit(x,y) C:\Python27\lib\site-packages\scikit_learn-0.14.1-py

按照目前的情况,这个问题不适合我们的问答形式。我们希望答案得到事实、引用或专业知识的支持,但这个问题可能会引发辩论、争论、投票或扩展讨论。如果您觉得这个问题可以改进并可能重新打开,visit the

As it currently stands, this question is not a good fit for our Q&A format. We expect answers to be

我是一名优秀的程序员,十分优秀!