- ubuntu12.04环境下使用kvm ioctl接口实现最简单的虚拟机

- Ubuntu 通过无线网络安装Ubuntu Server启动系统后连接无线网络的方法

- 在Ubuntu上搭建网桥的方法

- ubuntu 虚拟机上网方式及相关配置详解

CFSDN坚持开源创造价值,我们致力于搭建一个资源共享平台,让每一个IT人在这里找到属于你的精彩世界.

这篇CFSDN的博客文章利用机器学习预测房价由作者收集整理,如果你对这篇文章有兴趣,记得点赞哟.

背景:

DC竞赛比赛项目,运用回归模型进行房价预测.

数据介绍:

数据主要包括2014年5月至2015年5月美国King County的房屋销售价格以及房屋的基本信息.

其中训练数据主要包括10000条记录,14个字段,分别代表:

目标:

算法通过计算平均预测误差来衡量回归模型的优劣。平均预测误差越小,说明回归模型越好.

数据导入 。

先导入分析需要的python包:

#导入类库和加载数据集import pandas as pdimport numpy as npimport matplotlib.pyplot as pltimport seaborn as sns%matplotlib inline

导入下载好的kc_train的csv文件:

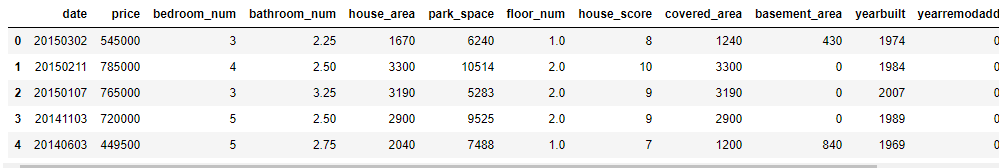

#读取数据train_names = ["date", "price", "bedroom_num", "bathroom_num", "house_area", "park_space", "floor_num", "house_score", "covered_area", "basement_area", "yearbuilt", "yearremodadd", "lat", "long"]data = pd.read_csv("kc_train.csv",names=train_names)data.head()

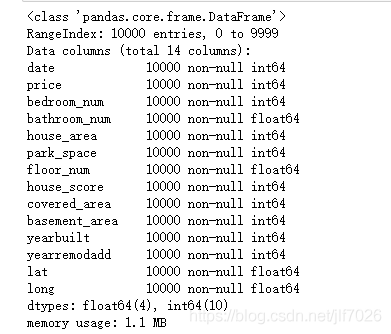

查看数据集概况 。

# 观察数据集概况data.info()

从图中可以看出没有任何缺失值,因此不需要对缺失值进行处理.

拆分数据:

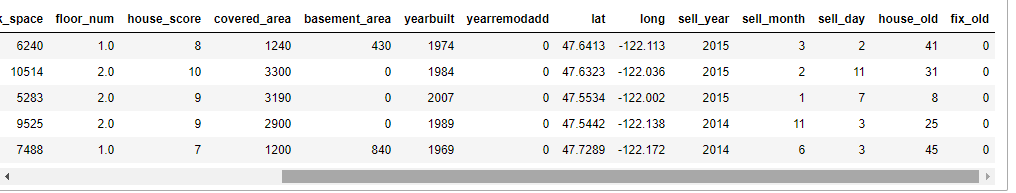

把原始数据中的年月日拆开,然后根据房屋的建造年份和修复年份计算一下售出时已经过了多少年,这样就有17个特征.

sell_year,sell_month,sell_day=[],[],[]house_old,fix_old=[],[]for [date,yearbuilt,yearremodadd] in data[["date","yearbuilt","yearremodadd"]].values: year,month,day=date//10000,date%10000//100,date%100 sell_year.append(year) sell_month.append(month) sell_day.append(day) house_old.append(year-yearbuilt) if yearremodadd==0: fix_old.append(0) else: fix_old.append(year-yearremodadd)del data["date"]data["sell_year"]=pd.DataFrame({"sell_year":sell_year})data["sell_month"]=pd.DataFrame({"sell_month":sell_month})data["sell_day"]=pd.DataFrame({"sell_day":sell_day})data["house_old"]=pd.DataFrame({"house_old":house_old})data["fix_old"]=pd.DataFrame({"fix_old":fix_old})data.head()

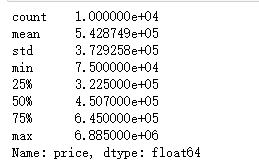

观察因变量(price)数据情况 。

#观察数据print(data["price"].describe())

#观察price的数据分布plt.figure(figsize = (10,5))# plt.xlabel("price")sns.distplot(data["price"])

从数据和图片上可以看出,price呈现典型的右偏分布,但总体上看还是符合一般规律.

相关性分析 。

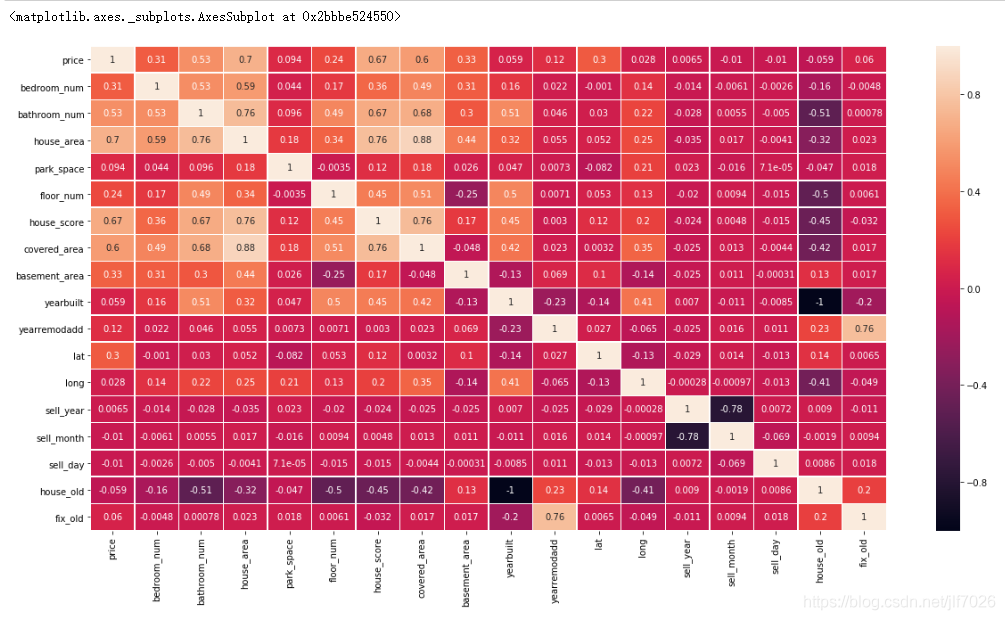

自变量与因变量的相关性分析,绘制相关性矩阵热力图,比较各个变量之间的相关性:

#自变量与因变量的相关性分析plt.figure(figsize = (20,10))internal_chars = ["price","bedroom_num","bathroom_num","house_area","park_space","floor_num","house_score","covered_area" ,"basement_area","yearbuilt","yearremodadd","lat","long","sell_year","sell_month","sell_day", "house_old","fix_old"]corrmat = data[internal_chars].corr() # 计算相关系数sns.heatmap(corrmat, square=False, linewidths=.5, annot=True) #热力图csdn.net/jlf7026/article/details/84630414

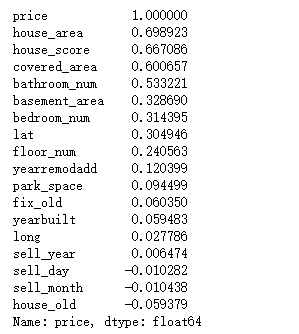

相关性越大,颜色越浅。看着可能不太清楚,因此看下排名 。

#打印出相关性的排名print(corrmat["price"].sort_values(ascending=False))

可以看出house_area,house_score,covered_area,bathroom_num这四个特征对price的影响最大,都超过了0.5。负数表明与price是负相关的.

特征选择 。

一般来说,选择一些与因变量(price)相关性比较大的做特征,但我尝试过选择前十的特征,然后进行建模预测,但得到的结果并不是很好,所以我还是把现有的特征全部用上.

归一化 。

对于各个特征的数据范围不一样,影响线性回归的效果,因此归一化数据.

#特征缩放data = data.astype("float")x = data.drop("price",axis=1)y = data["price"]from sklearn.preprocessing import MinMaxScalerscaler = MinMaxScaler()newX= scaler.fit_transform(x)newX = pd.DataFrame(newX, columns=x.columns)newX.head()

划分数据集 。

#先将数据集分成训练集和测试集from sklearn.model_selection import train_test_splitX_train,X_test,y_train,y_test = train_test_split(newX, y, test_size=0.2, random_state=21)

选择两个模型进行预测,观察那个模型更好.

#模型建立from sklearn import metricsdef RF(X_train, X_test, y_train, y_test): #随机森林 from sklearn.ensemble import RandomForestRegressor model= RandomForestRegressor(n_estimators=200,max_features=None) model.fit(X_train, y_train) predicted= model.predict(X_test) mse = metrics.mean_squared_error(y_test,predicted) return (mse/10000)def LR(X_train, X_test, y_train, y_test): #线性回归 from sklearn.linear_model import LinearRegression LR = LinearRegression() LR.fit(X_train, y_train) predicted = LR.predict(X_test) mse = metrics.mean_squared_error(y_test,predicted) return (mse/10000)

算法通过计算平均预测误差来衡量回归模型的优劣。平均预测误差越小,说明回归模型越好.

print("RF mse: ",RF(X_train, X_test, y_train, y_test))print("LR mse: ",LR(X_train, X_test, y_train, y_test))

可以看出,随机森林算法比线性回归算法要好很多.

总结 。

对机器学习有了初步了解。但对于数据的预处理,和参数,特征,模型的调优还很欠缺.

希望通过以后的学习,能不断提高。也希望看这篇文章的朋友和我一起感受机器学习的魅力,更多相关机器学习内容请搜索我以前的文章或继续浏览下面的相关文章,希望大家以后多多支持我! 。

原文链接:https://blog.csdn.net/jlf7026/article/details/84630414 。

最后此篇关于利用机器学习预测房价的文章就讲到这里了,如果你想了解更多关于利用机器学习预测房价的内容请搜索CFSDN的文章或继续浏览相关文章,希望大家以后支持我的博客! 。

我正在使用 R 预测包拟合模型,如下所示: fit <- auto.arima(df) plot(forecast(fit,h=200)) 打印原始数据框和预测。当 df 相当大时,这

我正在尝试预测自有住房的中位数,这是一个行之有效的例子,给出了很好的结果。 https://heuristically.wordpress.com/2011/11/17/using-neural-ne

type="class"函数中的type="response"和predict有什么区别? 例如: predict(modelName, newdata=testData, type = "class

我有一个名为 Downloaded 的文件夹,其中包含经过训练的 CNN 模型必须对其进行预测的图像。 下面是导入图片的代码: import os images = [] for filename i

关于预测的快速问题。 我尝试预测的值是 0 或 1(它设置为数字,而不是因子),因此当我运行随机森林时: fit , data=trainData, ntree=50) 并预测: pred, data

使用 Python,我尝试使用历史销售数据来预测产品的 future 销售数量。我还试图预测各组产品的这些计数。 例如,我的专栏如下所示: Date Sales_count Department It

我是 R 新手,所以请帮助我了解问题所在。我试图预测一些数据,但预测函数返回的对象(这是奇怪的类(因子))包含低数据。测试集大小为 5886 obs。 160 个变量,当预测对象长度为 110 时..

关闭。这个问题需要更多focused .它目前不接受答案。 想改进这个问题吗? 更新问题,使其只关注一个问题 editing this post . 关闭 6 年前。 Improve this qu

下面是我的神经网络代码,有 3 个输入和 1 个隐藏层和 1 个输出: #Data ds = SupervisedDataSet(3,1) myfile = open('my_file.csv','r

我正在开发一个 Web 应用程序,它具有全文搜索功能,可以正常运行。我想对此进行改进并向其添加预测/更正功能,这意味着如果用户输入错误或结果为 0,则会查询该输入的更正版本,而不是查询结果。基本上类似

我对时间序列还很陌生。 这是我正在处理的数据集: Date Price Location 0 2012-01-01 1771.0

我有许多可变长度的序列。对于这些,我想训练一个隐马尔可夫模型,稍后我想用它来预测(部分)序列的可能延续。到目前为止,我已经找到了两种使用 HMM 预测 future 的方法: 1) 幻觉延续并获得该延

我正在使用 TensorFlow 服务提供初始模型。我在 Azure Kubernetes 上这样做,所以不是通过更标准和有据可查的谷歌云。 无论如何,这一切都在起作用,但是我感到困惑的是预测作为浮点

我正在尝试使用 Amazon Forecast 进行一些测试。我现在尝试了两个不同的数据集,它们看起来像这样: 13,2013-03-31 19:25:00,93.10999 14,2013-03-3

使用 numpy ndarray大多数时候我们不需要担心内存布局的问题,因为结果并不依赖于它。 除非他们这样做。例如,考虑这种设置 3x2 矩阵对角线的稍微过度设计的方法 >>> a = np.zer

我想在同一个地 block 上用不同颜色绘制多个预测,但是,比例尺不对。我对任何其他方法持开放态度。 可重现的例子: require(forecast) # MAKING DATA data

我正在 R 中使用 GLMM,其中混合了连续变量和 calcategories 变量,并具有一些交互作用。我使用 MuMIn 中的 dredge 和 model.avg 函数来获取每个变量的效果估计。

我能够在 GUI 中成功导出分类器错误,但无法在命令行中执行此操作。有什么办法可以在命令行上完成此操作吗? 我使用的是 Weka 3.6.x。在这里,您可以右键单击模型,选择“可视化分类器错误”并从那

我想在同一个地 block 上用不同颜色绘制多个预测,但是,比例尺不对。我对任何其他方法持开放态度。 可重现的例子: require(forecast) # MAKING DATA data

我从 UCI 机器学习数据集库下载了一个巨大的文件。 (~300mb)。 有没有办法在将数据集加载到 R 内存之前预测加载数据集所需的内存? Google 搜索了很多,但我到处都能找到如何使用 R-p

我是一名优秀的程序员,十分优秀!