- ubuntu12.04环境下使用kvm ioctl接口实现最简单的虚拟机

- Ubuntu 通过无线网络安装Ubuntu Server启动系统后连接无线网络的方法

- 在Ubuntu上搭建网桥的方法

- ubuntu 虚拟机上网方式及相关配置详解

CFSDN坚持开源创造价值,我们致力于搭建一个资源共享平台,让每一个IT人在这里找到属于你的精彩世界.

这篇CFSDN的博客文章openstack中的rpc远程调用的方法由作者收集整理,如果你对这篇文章有兴趣,记得点赞哟.

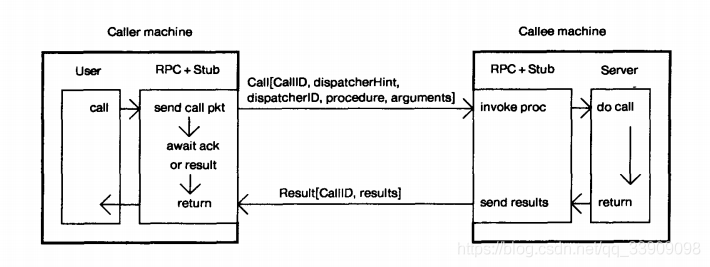

众所周知,openstack的通信方式有两种,一种是基于http协议的restful api方式,另一种则是rpc调用。两种通信方式的应用场景有所不同,在openstack中,前者主要用于各组件之间的通信(如nova与glance的通信),而后者则用于同一组件中各个不同模块之间的通信(如nova组件中nova-compute与nova-scheduler的通信).

nova中rpc调用非常多,用pycharm点点点跟函数的时候遇到rpc就会点不下去了,不解决直接就看不下去了那种多法 。

看不明白这个图对于看nova代码,其实不是很重要,直接忽略以后再看也可以,当务之急是解决一下看openstack代码遇到rpc就跟丢了的问题 。

这三个其实不是一个层面的东西,本质上不应该放在一起比,但是因为都用来通信,比较容易混淆就还是解释一下 。

nova/nova/nova/conductor/tasks/live_migrate.py 。

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

|

class

livemigrationtask(base.taskbase):

def __init__(self, context, instance, destination,

block_migration, disk_over_commit, migration, compute_rpcapi,

servicegroup_api, scheduler_client):

super

(livemigrationtask, self).__init__(context, instance)

...

def _execute(self):

self._check_instance_is_active()

self._check_host_is_up(self.source)

if

not self.destination:

self.destination = self._find_destination()

self.migration.dest_compute = self.destination

self.migration.save()

else

:

self._check_requested_destination()

# todo(johngarbutt) need to move complexity out of compute manager

# todo(johngarbutt) disk_over_commit?

#调用 computeapi 类中的 live_migration() rpc接口

return

self.compute_rpcapi.live_migration(self.context,

host=self.source,

instance=self.instance,

dest=self.destination,

block_migration=self.block_migration,

migration=self.migration,

migrate_data=self.migrate_data)

|

conductor以compute_rpcapi.live_migration的方式远程调用compute的live_migration,过程就是, conductor以rpc的方式发出一个请求到queue再被nova-compute接收 。

nova/nova/nova/compute/rpcapi.py 。

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

|

class

computeapi(object):

# 这是一个rpc远程调用的方法

def live_migration(self, ctxt, instance, dest, block_migration, host,

migration, migrate_data=none):

args = {

'migration'

: migration}

version =

'4.2'

if

not self.client.can_send_version(version):

version =

'4.0'

# 获取目标 compute 主机(dest host)的rpc client,即被调用的服务进程的hostip

cctxt = self.client.prepare(server=host, version=version)

# 通过目标主机对象的 rpc cliient 来调用远程过程方法 cast() ,以此来实现远程调用

cctxt.cast(ctxt,

'live_migration'

, instance=instance,

dest=dest, block_migration=block_migration,

migrate_data=migrate_data, **args)

# cast()异步远程调用,不会阻塞别的进程,适合于需要长时间进行的执行过程

# cast()的第二个参数是rpc client调用的函数名,

case

()后面的参数会继续作为参数传入该调用函数

# cast()函数内的live_migration()函数是 manager.live_migration() 视具体实现迁移功能的函数,在manager.py内实现。

|

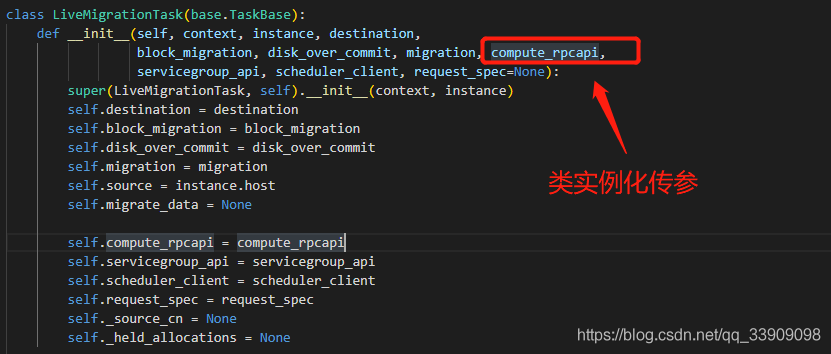

调用的时候是从nova/nova/conductor/tasks/live_migrate.py到nova/nova/compute/rpcapi.py,但是实际上是compute服务首先得在rpcapi.py提供出接口函数,然后使用者通过 - 1. import导入的方式去使用rpc调用 - 2. 类实例化传参的方式去引入 。

热迁移这里用的就是类实例化传参 。

tip: call()表示同步调用 和 cast()表示异步调用 。

根据在rpc.py或者rpcapi.py中的cast()的第二个参数,去该服务下的manager.py中找和这个参数同名的函数(这个就是rpc最终想要调用的函数),我们这里是compute_rpcapi,所以要去找compute下的mannager.py 。

为什么要去找mannager,是因为nova.compute.manager 会一直监听 queue ,当queue中存在相关的 rpc 请求时,就去完成这个请求 。

nova/nova/nova/compute/manager.py 。

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

|

@wrap_exception

()

@wrap_instance_event

(prefix=

'compute'

)

@wrap_instance_fault

def live_migration(self, context, dest, instance, block_migration,

migration, migrate_data):

""

"执行实时迁移。

:param context: security context

:param dest: destination host

:param instance: a nova.objects.instance.instance object

:param block_migration:

if

true

, prepare

for

block migration

:param migration: an nova.objects.migration object

:param migrate_data: implementation specific params

""

"

self._set_migration_status(migration,

'queued'

)

def dispatch_live_migration(*args, **kwargs):

with self._live_migration_semaphore:

# 调用_do_live_migration执行迁移

self._do_live_migration(*args, **kwargs)

# note(danms): we spawn here to

return

the rpc worker thread back to

# the pool. since what follows could take a really

long

time, we don't

# want to tie up rpc workers.

utils.spawn_n(dispatch_live_migration,

context, dest, instance,

block_migration, migration,

migrate_data)

|

当然实际干活的还不是manager.py的def live_migration,而是live_migration函数去调用_do_live_migration,但是之后的就是热迁移的流程,在之前的文档里写了就不展开了,反正rpc的体现就只到这里 。

冷迁移中还有很多例子,不一一列举了,有兴趣可以去看这篇博客 。

看完例子会发现,既然原生的代码既然已经写了rpc调用,那么对应的服务肯定已经提供了rpc接口,所以实际上看到compute_rpcapi,可以不去compute下的rpc文件中找了,直接去compute下的manager看具体实现(不止compute,其他服务也一样),当然,如果需要雪确定是同步还是异步调用那还是不要偷这一步的懒.

完整的rpc应该具有 。

rpc.py或者rpcapi.py文件)import或者类实例化传参)rpc方式发送一个请求到消息队列)rpc请求会通过manager处理请求)如果只是看代码,那么去对应的manager下面找实现就可以了,但是如果自己要加就还是的明白从哪里提供的、怎样导入,何种途径接收,这样想在代码里添加自己的rpc调用才心里有数 。

参考文献:

https://zhuanlan.zhihu.com/p/36427583 https://blog.csdn.net/jmilk/article/details/52655645 https://www.cnblogs.com/wongbingming/p/11086773.html https://blog.csdn.net/qq_33909098/article/details/118578133 。

到此这篇关于openstack中的rpc远程调用的文章就介绍到这了,更多相关openstack rpc调用内容请搜索我以前的文章或继续浏览下面的相关文章希望大家以后多多支持我! 。

原文链接:https://blog.csdn.net/qq_33909098/article/details/118576253 。

最后此篇关于openstack中的rpc远程调用的方法的文章就讲到这里了,如果你想了解更多关于openstack中的rpc远程调用的方法的内容请搜索CFSDN的文章或继续浏览相关文章,希望大家以后支持我的博客! 。

为了让我的代码几乎完全用 Jquery 编写,我想用 Jquery 重写 AJAX 调用。 这是从网页到 Tomcat servlet 的调用。 我目前情况的类似代码: var http = new

我想使用 JNI 从 Java 调用 C 函数。在 C 函数中,我想创建一个 JVM 并调用一些 Java 对象。当我尝试创建 JVM 时,JNI_CreateJavaVM 返回 -1。 所以,我想知

环顾四周,我发现从 HTML 调用 Javascript 函数的最佳方法是将函数本身放在 HTML 中,而不是外部 Javascript 文件。所以我一直在网上四处寻找,找到了一些简短的教程,我可以根

我有这个组件: import {Component} from 'angular2/core'; import {UserServices} from '../services/UserService

我正在尝试用 C 实现一个简单的 OpenSSL 客户端/服务器模型,并且对 BIO_* 调用的使用感到好奇,与原始 SSL_* 调用相比,它允许一些不错的功能。 我对此比较陌生,所以我可能会完全错误

我正在处理有关异步调用的难题: 一个 JQuery 函数在用户点击时执行,然后调用一个 php 文件来检查用户输入是否与数据库中已有的信息重叠。如果是这样,则应提示用户确认是否要继续或取消,如果他单击

我有以下类(class)。 public Task { public static Task getInstance(String taskName) { return new

嘿,我正在构建一个小游戏,我正在通过制作一个数字 vector 来创建关卡,该数字 vector 通过枚举与 1-4 种颜色相关联。问题是循环(在 Simon::loadChallenge 中)我将颜

我有一个java spring boot api(数据接收器),客户端调用它来保存一些数据。一旦我完成了数据的持久化,我想进行另一个 api 调用(应该处理持久化的数据 - 数据聚合器),它应该自行异

首先,这涉及桌面应用程序而不是 ASP .Net 应用程序。 我已经为我的项目添加了一个 Web 引用,并构建了各种数据对象,例如 PayerInfo、Address 和 CreditCard。但问题

我如何告诉 FAKE 编译 .fs文件使用 fsc ? 解释如何传递参数的奖励积分,如 -a和 -target:dll . 编辑:我应该澄清一下,我正在尝试在没有 MSBuild/xbuild/.sl

我使用下划线模板配置了一个简单的主干模型和 View 。两个单独的 API 使用完全相同的配置。 API 1 按预期工作。 要重现该问题,请注释掉 API 1 的 URL,并取消注释 API 2 的

我不确定什么是更好的做法或更现实的做法。我希望从头开始创建目录系统,但不确定最佳方法是什么。 我想我在需要显示信息时使用对象,例如 info.php?id=100。有这样的代码用于显示 Game.cl

from datetime import timedelta class A: def __abs__(self): return -self class B1(A):

我在操作此生命游戏示例代码中的数组时遇到问题。 情况: “生命游戏”是约翰·康威发明的一种细胞自动化技术。它由一个细胞网格组成,这些细胞可以根据数学规则生存/死亡/繁殖。该网格中的活细胞和死细胞通过

如果我像这样调用 read() 来读取文件: unsigned char buf[512]; memset(buf, 0, sizeof(unsigned char) * 512); int fd;

我用 C 编写了一个简单的服务器,并希望调用它的功能与调用其他 C 守护程序的功能相同(例如使用 ./ftpd start 调用它并使用 ./ftpd stop 关闭该实例)。显然我遇到的问题是我不知

在 dos 中,当我粘贴此命令时它会起作用: "C:\Program Files (x86)\Google\Chrome\Application\chrome.exe" https://google.

在 dos 中,当我粘贴此命令时它会起作用: "C:\Program Files (x86)\Google\Chrome\Application\chrome.exe" https://google.

我希望能够从 cmd 在我的 Windows 10 计算机上调用 python3。 我已重新安装 Python3.7 以确保选择“添加到路径”选项,但仍无法调用 python3 并使 CMD 启动 P

我是一名优秀的程序员,十分优秀!