- ubuntu12.04环境下使用kvm ioctl接口实现最简单的虚拟机

- Ubuntu 通过无线网络安装Ubuntu Server启动系统后连接无线网络的方法

- 在Ubuntu上搭建网桥的方法

- ubuntu 虚拟机上网方式及相关配置详解

CFSDN坚持开源创造价值,我们致力于搭建一个资源共享平台,让每一个IT人在这里找到属于你的精彩世界.

这篇CFSDN的博客文章python操作kafka实践的示例代码由作者收集整理,如果你对这篇文章有兴趣,记得点赞哟.

1、先看最简单的场景,生产者生产消息,消费者接收消息,下面是生产者的简单代码.

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

|

#!/usr/bin/env python

# -*- coding: utf-8 -*-

import

json

from

kafka

import

kafkaproducer

producer

=

kafkaproducer(bootstrap_servers

=

'xxxx:x'

)

msg_dict

=

{

"sleep_time"

:

10

,

"db_config"

: {

"database"

:

"test_1"

,

"host"

:

"xxxx"

,

"user"

:

"root"

,

"password"

:

"root"

},

"table"

:

"msg"

,

"msg"

:

"hello world"

}

msg

=

json.dumps(msg_dict)

producer.send(

'test_rhj'

, msg, partition

=

0

)

producer.close()

|

下面是消费者的简单代码:

|

1

2

3

4

5

6

|

from

kafka

import

kafkaconsumer

consumer

=

kafkaconsumer(

'test_rhj'

, bootstrap_servers

=

[

'xxxx:x'

])

for

msg

in

consumer:

recv

=

"%s:%d:%d: key=%s value=%s"

%

(msg.topic, msg.partition, msg.offset, msg.key, msg.value)

print

recv

|

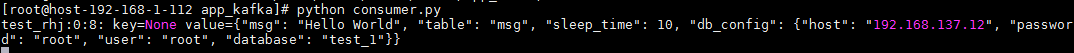

下面是结果:

2、如果想要完成负载均衡,就需要知道kafka的分区机制,同一个主题,可以为其分区,在生产者不指定分区的情况,kafka会将多个消息分发到不同的分区,消费者订阅时候如果不指定服务组,会收到所有分区的消息,如果指定了服务组,则同一服务组的消费者会消费不同的分区,如果2个分区两个消费者的消费者组消费,则,每个消费者消费一个分区,如果有三个消费者的服务组,则会出现一个消费者消费不到数据;如果想要消费同一分区,则需要用不同的服务组。以此为原理,我们对消费者做如下修改:

|

1

2

3

4

5

6

|

from

kafka

import

kafkaconsumer

consumer

=

kafkaconsumer(

'test_rhj'

, bootstrap_servers

=

[

'xxxx:x'

])

for

msg

in

consumer:

recv

=

"%s:%d:%d: key=%s value=%s"

%

(msg.topic, msg.partition, msg.offset, msg.key, msg.value)

print

recv

|

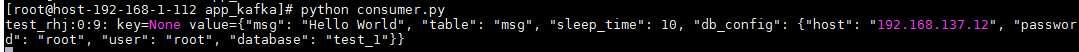

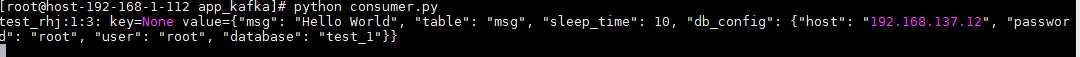

然后我们开两个消费者进行消费,生产者分别往0分区和1分区发消息结果如下,可以看到,一个消费者只能消费0分区,另一个只能消费1分区:

3、kafka提供了偏移量的概念,允许消费者根据偏移量消费之前遗漏的内容,这基于kafka名义上的全量存储,可以保留大量的历史数据,历史保存时间是可配置的,一般是7天,如果偏移量定位到了已删除的位置那也会有问题,但是这种情况可能很小;每个保存的数据文件都是以偏移量命名的,当前要查的偏移量减去文件名就是数据在该文件的相对位置。要指定偏移量消费数据,需要指定该消费者要消费的分区,否则代码会找不到分区而无法消费,代码如下:

|

1

2

3

4

5

6

7

8

9

10

11

12

|

from

kafka

import

kafkaconsumer

from

kafka.structs

import

topicpartition

consumer

=

kafkaconsumer(group_id

=

'123456'

, bootstrap_servers

=

[

'10.43.35.25:4531'

])

consumer.assign([topicpartition(topic

=

'test_rhj'

, partition

=

0

), topicpartition(topic

=

'test_rhj'

, partition

=

1

)])

print

consumer.partitions_for_topic(

"test_rhj"

)

# 获取test主题的分区信息

print

consumer.assignment()

print

consumer.beginning_offsets(consumer.assignment())

consumer.seek(topicpartition(topic

=

'test_rhj'

, partition

=

0

),

0

)

for

msg

in

consumer:

recv

=

"%s:%d:%d: key=%s value=%s"

%

(msg.topic, msg.partition, msg.offset, msg.key, msg.value)

print

recv

|

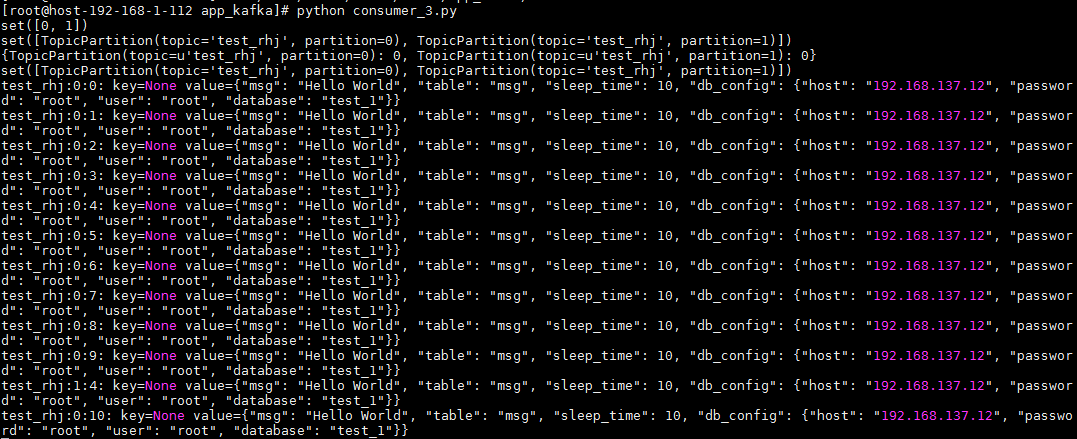

因为指定的便宜量为0,所以从一开始插入的数据都可以查到,而且因为指定了分区,指定的分区结果都可以消费,结果如下:

4、有时候,我们并不需要实时获取数据,因为这样可能会造成性能瓶颈,我们只需要定时去获取队列里的数据然后批量处理就可以,这种情况,我们可以选择主动拉取数据 。

|

1

2

3

4

5

6

7

8

9

10

11

12

|

from

kafka

import

kafkaconsumer

import

time

consumer

=

kafkaconsumer(group_id

=

'123456'

, bootstrap_servers

=

[

'10.43.35.25:4531'

])

consumer.subscribe(topics

=

(

'test_rhj'

,))

index

=

0

while

true:

msg

=

consumer.poll(timeout_ms

=

5

)

# 从kafka获取消息

print

msg

time.sleep(

2

)

index

+

=

1

print

'--------poll index is %s----------'

%

index

|

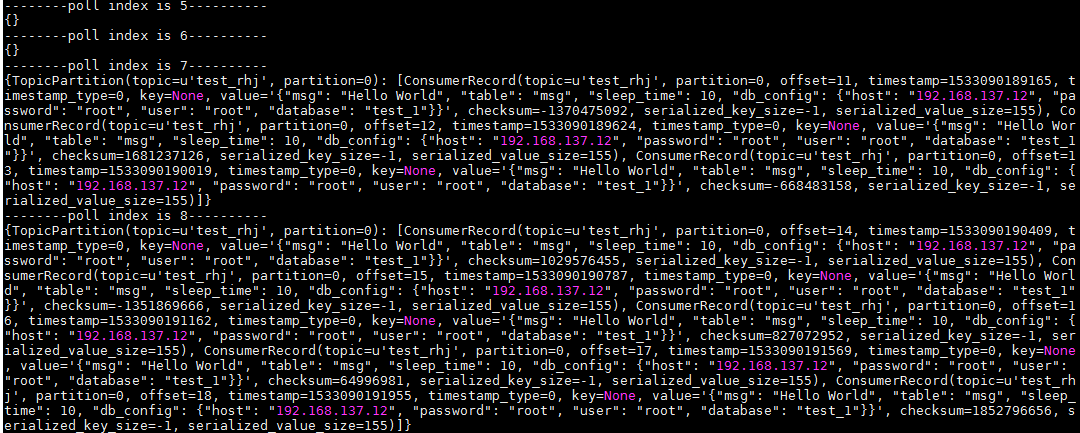

结果如下,可以看到,每次拉取到的都是前面生产的数据,可能是多条的列表,也可能没有数据,如果没有数据,则拉取到的为空:

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持我.

原文链接:https://www.cnblogs.com/small-office/p/9399907.html 。

最后此篇关于python操作kafka实践的示例代码的文章就讲到这里了,如果你想了解更多关于python操作kafka实践的示例代码的内容请搜索CFSDN的文章或继续浏览相关文章,希望大家以后支持我的博客! 。

我尝试理解[c代码 -> 汇编]代码 void node::Check( data & _data1, vector& _data2) { -> push ebp -> mov ebp,esp ->

我需要在当前表单(代码)的上下文中运行文本文件中的代码。其中一项要求是让代码创建新控件并将其添加到当前窗体。 例如,在Form1.cs中: using System.Windows.Forms; ..

我有此 C++ 代码并将其转换为 C# (.net Framework 4) 代码。有没有人给我一些关于 malloc、free 和 sprintf 方法的提示? int monate = ee; d

我的网络服务器代码有问题 #include #include #include #include #include #include #include int

给定以下 html 代码,将列表中的第三个元素(即“美丽”一词)以斜体显示的 CSS 代码是什么?当然,我可以给这个元素一个 id 或一个 class,但 html 代码必须保持不变。谢谢

关闭。这个问题不符合Stack Overflow guidelines .它目前不接受答案。 我们不允许提问寻求书籍、工具、软件库等的推荐。您可以编辑问题,以便用事实和引用来回答。 关闭 7 年前。

我试图制作一个宏来避免重复代码和注释。 我试过这个: #define GrowOnPage(any Page, any Component) Component.Width := Page.Surfa

我正在尝试将我的旧 C++ 代码“翻译”成头条新闻所暗示的 C# 代码。问题是我是 C# 中的新手,并不是所有的东西都像 C++ 中那样。在 C++ 中这些解决方案运行良好,但在 C# 中只是不能。我

在 Windows 10 上工作,R 语言的格式化程序似乎没有在 Visual Studio Code 中完成它的工作。我试过R support for Visual Studio Code和 R-T

我正在处理一些报告(计数),我必须获取不同参数的计数。非常简单但乏味。 一个参数的示例查询: qCountsEmployee = ( "select count(*) from %s wher

最近几天我尝试从 d00m 调试网络错误。我开始用尽想法/线索,我希望其他 SO 用户拥有可能有用的宝贵经验。我希望能够提供所有相关信息,但我个人无法控制服务器环境。 整个事情始于用户注意到我们应用程

我有一个 app.js 文件,其中包含如下 dojo amd 模式代码: require(["dojo/dom", ..], function(dom){ dom.byId('someId').i

我对“-gencode”语句中的“code=sm_X”选项有点困惑。 一个例子:NVCC 编译器选项有什么作用 -gencode arch=compute_13,code=sm_13 嵌入库中? 只有

我为我的表格使用 X-editable 框架。 但是我有一些问题。 $(document).ready(function() { $('.access').editable({

我一直在通过本教程学习 flask/python http://blog.miguelgrinberg.com/post/the-flask-mega-tutorial-part-i-hello-wo

我想将 Vim 和 EMACS 用于 CNC、G 代码和 M 代码。 Vim 或 EMACS 是否有任何语法或模式来处理这种类型的代码? 最佳答案 一些快速搜索使我找到了 this vim 和 thi

关闭。这个问题不符合Stack Overflow guidelines .它目前不接受答案。 想改进这个问题?更新问题,使其成为 on-topic对于堆栈溢出。 7年前关闭。 Improve this

这个问题在这里已经有了答案: Enabling markdown highlighting in Vim (5 个回答) 6年前关闭。 当我在 Vim 中编辑包含 Markdown 代码的 READM

我正在 Swift3 iOS 中开发视频应用程序。基本上我必须将视频 Assets 和音频与淡入淡出效果合并为一个并将其保存到 iPhone 画廊。为此,我使用以下方法: private func d

pipeline { agent any stages { stage('Build') { steps { e

我是一名优秀的程序员,十分优秀!