- ubuntu12.04环境下使用kvm ioctl接口实现最简单的虚拟机

- Ubuntu 通过无线网络安装Ubuntu Server启动系统后连接无线网络的方法

- 在Ubuntu上搭建网桥的方法

- ubuntu 虚拟机上网方式及相关配置详解

CFSDN坚持开源创造价值,我们致力于搭建一个资源共享平台,让每一个IT人在这里找到属于你的精彩世界.

这篇CFSDN的博客文章Dlib+OpenCV深度学习人脸识别的方法示例由作者收集整理,如果你对这篇文章有兴趣,记得点赞哟.

前言 。

人脸识别在lwf(labeled faces in the wild)数据集上人脸识别率现在已经99.7%以上,这个识别率确实非常高了,但是真实的环境中的准确率有多少呢?我没有这方面的数据,但是可以确信的是真实环境中的识别率并没有那么乐观。现在虽然有一些商业应用如员工人脸识别管理系统、海关身份验证系统、甚至是银行人脸识别功能,但是我们可以仔细想想员工人脸识别管理,海关身份证系统的应用场景对身份的验证功能其实并没有商家吹嘘的那么重要,打个比方说员工上班的时候刷脸如果失败了会怎样,是不是重新识别一下,如果还是误识别,或是识别不出,是不是就干脆刷卡或是其他方式登记上班,然后骂一句他娘的,本人那么帅居然没识别出来!那银行柜员机上人脸识别系统呢,你看它敢不敢让你连密码也不输直接刷脸转账,是不是关掉了人脸识别、指纹识别机器还可以正常运作。所以说真实环境中在各种光照因素、年龄因素、网红因素(化妆)、甚至是作弊因素等各种因素条件下的识别率有多少只有产品厂家自己知道,我相信每个厂家针对这些情况都有做优化,比如外围硬件的辅助,针对特定场景的各种约束等等,通过各个厂家自己在各个方面对系统的优化,是可以提升自身产品的综合体验的.

前面扯远了,本文的目的是实现一个人脸识别的最简单实际应用,即用摄像头捕捉动态人脸,然后和已经存储在数据库中的128d人脸特征进行比较识别出相应的人脸信息(名字等)。工程是基于vs2015+简单的mfc对话框实现的,代码存放在:http://git.oschina.net/wjiang/face_recognition 。

在这个系统中我预先存储了下面几位明星的正面头像的128d人脸特征,当然你可以存储和导入更多的人脸.

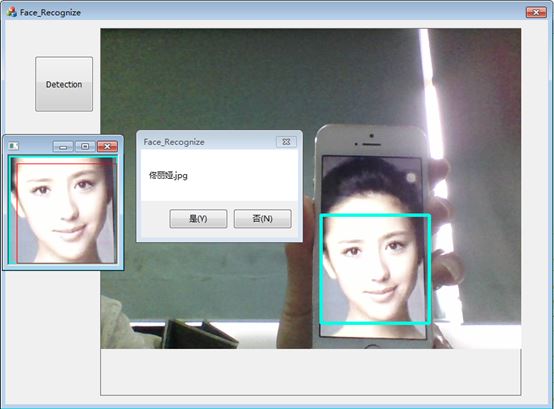

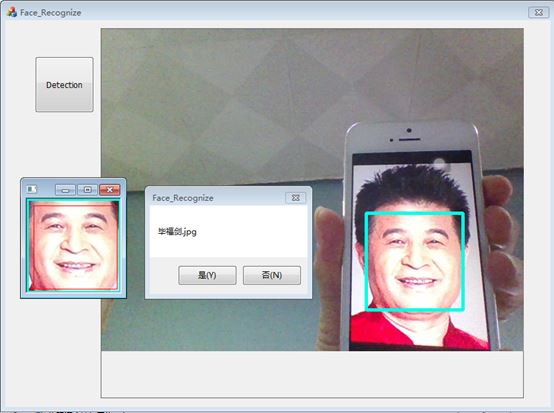

然后经过人脸检测、人脸图像处理,和人脸识别等步骤识别出相应的人脸信息,识别效果如下(怕大家被丑到所以用了明星的图片,没有用真实的人脸 – 没有做活体检测):

当然这只是一个简单的应用,真正用到生产的系统,还需运用活体检测等技术,防止运用照片或是手机视频等方式欺骗过人脸识别系统,安全级别要求更高的应用领域例如支付、转账等系统活体检测可能仍不够安全,这时还可以通过人脸识别+验证密码等方式加强安全性能.

人脸数据库导入 。

人脸数据导入,也就是说我在系统启动之初,需要导入我的人脸数据库,也就是前面的那些明星的正面照。装载的开始阶段,因为要检测静态人脸图片的人脸部位,首先需要用dlib的人脸检测器,用get_frontal_face_detector()获得。然后需要将68点人脸标记模型导入shape_predictor sp,目的就是要对其人脸到一个标准的姿势,接着就是装载dnn模型。然后取每张人脸照片的特征,并将特征和姓名等相关的信息放入face_desc结构中,最后将每张人脸信息结构放入face_desc_vec容器中,这里我只装载了9个明星的人脸信息.

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

|

int

face_recognition::load_db_faces(void)

{

intrc

=

-

1

;

longhfile

=

0

;

struct_finddata_tfileinfo;

frontal_face_detectordetector

=

get_frontal_face_detector();

/

/

we will also use a face landmarking model to align faces to a standard pose: (see face_landmark_detection_excpp

for

an introduction)

deserialize(

"shape_predictor_68_face_landmarksdat"

) >>sp;

/

/

and

finally

we load the dnn responsible

for

face recognition

deserialize(

"dlib_face_recognition_resnet_model_vdat"

) >>net;

if

((hfile

=

_findfirst(

"\\faces\\*jpg"

, &fileinfo)) !

=

-

1

)

{

do

{

if

((fileinfoattrib &_a_arch))

{

if

(strcmp(fileinfoname,"

") != 0 && strcmp(fileinfoname,"

") !

=

0

)

{

if

(!strcmp(strstr(fileinfoname,"

") + 1 , "

jpg"))

{

cout <<

"this file is an image file!"

<<fileinfoname <<endl;

matrix<rgb_pixel>img;

charpath[

260

];

sprintf_s(path,

"\\faces\\%s"

,fileinfoname);

load_image(img,path);

image_windowwin(img);

for

(autoface :detector(img))

{

autoshape

=

sp(img,face);

matrix<rgb_pixel>face_chip;

extract_image_chip(img,get_face_chip_details(shape,

150

,

25

),face_chip);

/

/

record the

all

this face's information

face_descsigle_face;

sigle_faceface_chip

=

face_chip;

sigle_facename

=

fileinfoname;

std::vector<matrix<rgb_pixel>>face_chip_vec;

std::vector<matrix<

float

,

0

,

1

>>face_all;

face_chip_vecpush_back(move(face_chip));

/

/

asks the dnn to convert each face image

in

faces into a

128d

vector

face_all

=

net(face_chip_vec);

/

/

get the feature of this person

std::vector<matrix<

float

,

0

,

1

>>::iteratoriter_begin

=

face_allbegin(),

iter_end

=

face_allend();

if

(face_allsize() >

1

)

break

;

sigle_faceface_feature

=

*

iter_begin;

/

/

all

the person description into vector

face_desc_vecpush_back(sigle_face);

winadd_overlay(face);

}

}

else

{

cout <<

"this file is not image file!"

<<fileinfoname <<endl;

}

}

}

else

{

/

/

filespush_back(passign(path)append(

"\\"

)append(fileinfoname));

}

}

while

(_findnext(hfile, &fileinfo)

=

=

0

);

_findclose(hfile);

}

returnrc;

}

|

人脸检测 。

人脸检测在人脸识别的应用系统中我认为是至关重要的一环,因为人脸检测的好坏直接影响最终的识别率,如果在人脸检测阶段能做到尽量好的话,系统的识别率会有一个比较大的提升。下面的是人脸检测的具体代码实现(很简陋莫怪),尝试了用dlib人脸检测,opencv人脸检测,还有于仕琪的libfacedetection,比较发现于仕琪的libfacedetection是做人脸检测最好的一个,速度快,并且检测图像效果也很好.

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

|

intcapture_face(matframe,mat&out)

{

matgray;

matface;

intrc

=

-

1

;

if

(frame.empty() || !frame.data)

return

-

1

;

cvtcolor(frame,gray,cv_bgr2gray);

int

*

presults

=

null;

unsignedchar

*

pbuffer

=

(unsignedchar

*

)malloc(detect_buffer_size);

if

(!pbuffer)

{

fprintf(stderr,

"can not alloc buffer.\n"

);

return

-

1

;

}

/

/

presults

=

facedetect_frontal_tmp((unsigned char

*

)(gray.ptr(

0

)), gray.cols, gray.rows, gray.step,

/

/

1.2f

,

5

,

24

);

presults

=

facedetect_multiview_reinforce(pbuffer, (unsignedchar

*

)(gray.ptr(

0

)),gray.cols,gray.rows, (

int

)gray.step,

1.2f

,

2

,

48

,

0

,

1

);

/

/

printf(

"%d faces detected.\n"

, (presults ?

*

presults :

0

));

/

/

重复运行

/

/

print

the detection results

if

(presults !

=

null)

{

for

(inti

=

0

;i < (presults ?

*

presults :

0

);i

+

+

)

{

short

*

p

=

((short

*

)(presults

+

1

))

+

6

*

i;

intx

=

p[

0

];

inty

=

p[

1

];

intw

=

p[

2

];

inth

=

p[

3

];

intneighbors

=

p[

4

];

rect_<

float

>face_rect

=

rect_<

float

>(x,y,w, h);

face

=

frame(face_rect);

printf(

"face_rect=[%d, %d, %d, %d], neighbors=%d\n"

,x,y, w,h,neighbors);

pointleft(x,y);

pointright(x

+

w,y

+

h);

cv::rectangle(frame,left,right, scalar(

230

,

255

,

0

),

4

);

}

/

/

imshow(

"frame"

, frame);

if

(face.empty() || !face.data)

{

face_detect_count

=

0

;

return

-

1

;

}

if

(face_detect_count

+

+

>

30

)

{

imshow(

"face"

,face);

out

=

face.clone();

return

0

;

}

}

else

{

/

/

face

is

moving,

and

reset the detect count

face_detect_count

=

0

;

}

returnrc;

}

|

人脸识别 。

通过人脸检测函数capture_face()经过处理之后临时保存在工程目录下的cap.jpg,用get_face_chip_details()函数将检测到的目标图片标准化为150*150像素大小,并对人脸进行旋转居中,用extract_image_chip()取得图像的一个拷贝,然后将其存储到自己的图片face_chip中,把的到face_chip放入vect_faces容器中,传送给深度神经网络net,得到捕捉到人脸图片的128d向量特征。最后在事先导入的人脸数据库中遍历与此特征最相近的人脸即可识别出相应的人脸信息.

这种模式的应用,也就是我们所说的1:n应用,1对n是比较考验系统运算能力的,举个例子,现在支付宝账户应该已经是上亿级别的用户,如果你在就餐的时候选择使用支付宝人脸支付,也许在半个小时内服务器也没有找你的脸,这下就悲催,当然在真实应用场景可能是还需要你输入你的名字,这下可能就快多了,毕竟全国可能和你重名的也就了不的几千上万个吧,一搜索,人脸识别再一验证即可.

前面的这些还没有考虑安全的因素,比如说双胞胎啊,化妆啊(网红的年代啊),还有年龄的因素,环境的因素还包括光照、角度等导致的误识别或是识别不出,识别不出的情况还好,如果是误识别对于支付等对于安全性要求极其严苛的应用来说简直就是灾难。所以人脸识别还有很大的局限性 – 额,好像扯远了.

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

|

matrix<rgb_pixel> face_cap;

/

/

save the capture

in

the project directory

load_image(face_cap,

".\\cap.jpg"

);

/

/

display the raw image on the screen

image_window win1(face_cap);

frontal_face_detector detector

=

get_frontal_face_detector();

std::vector<matrix<rgb_pixel>> vect_faces;

for

(auto face : detector(face_cap))

{

auto shape

=

face_recognize.sp(face_cap, face);

matrix<rgb_pixel> face_chip;

extract_image_chip(face_cap, get_face_chip_details(shape,

150

,

0.25

), face_chip);

vect_faces.push_back(move(face_chip));

win1.add_overlay(face);

}

if

(vect_faces.size() !

=

1

)

{

cout <<

"capture face error! face number "

<< vect_faces.size() << endl;

cap.release();

goto capture;

}

/

/

use dnn

and

get the capture face's feature with

128d

vector

std::vector<matrix<

float

,

0

,

1

>> face_cap_desc

=

face_recognize.net(vect_faces);

/

/

browse the face feature

from

the database,

and

find the match one

std::pair<double,std::string> candidate_face;

std::vector<double> len_vec;

std::vector<std::pair<double, std::string>> candi_face_vec;

candi_face_vec.reserve(

256

);

for

(size_t i

=

0

; i < face_recognize.face_desc_vec.size();

+

+

i)

{

auto

len

=

length(face_cap_desc[

0

]

-

face_recognize.face_desc_vec[i].face_feature);

if

(

len

<

0.45

)

{

len_vec.push_back(

len

);

candidate_face.first

=

len

;

candidate_face.second

=

face_recognize.face_desc_vec[i].name.c_str();

candi_face_vec.push_back(candidate_face);

#ifdef _face_recognize_debug

char

buffer

[

256

]

=

{

0

};

sprintf_s(

buffer

,

"candidate face %s euclid length %f"

,

face_recognize.face_desc_vec[i].name.c_str(),

len

);

messagebox(cstring(

buffer

), null, mb_yesno);

#endif

}

else

{

cout <<

"this face from database is not match the capture face, continue!"

<< endl;

}

}

/

/

find the most similar face

if

(len_vec.size() !

=

0

)

{

shellsort(len_vec);

int

i(

0

);

for

(i

=

0

; i !

=

len_vec.size(); i

+

+

)

{

if

(len_vec[

0

]

=

=

candi_face_vec[i].first)

break

;

}

char

buffer

[

256

]

=

{

0

};

sprintf_s(

buffer

,

"the face is %s -- euclid length %f"

,

candi_face_vec[i].second.c_str(), candi_face_vec[i].first);

if

(messagebox(cstring(

buffer

), null, mb_yesno)

=

=

idno)

{

face_record();

}

}

else

{

if

(messagebox(cstring(

"not the similar face been found"

), null, mb_yesno)

=

=

idyes)

{

face_record();

}

}

face_detect_count

=

0

;

frame.release();

face.release();

|

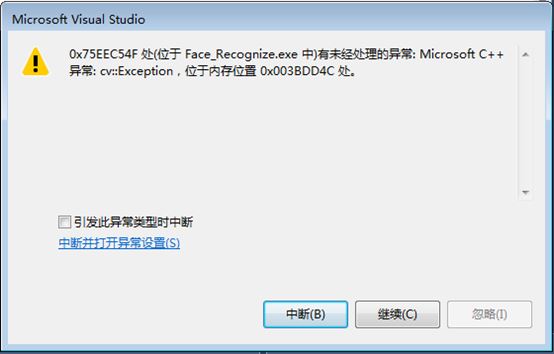

异常处理 。

当人脸或是物体快速的在摄像头前活动时,会导致系统异常抛出,异常提示如下:

对于这个问题,我们可以先用c++捕获异常的工具,try和catch工具来捕获异常:

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

|

mat frame;

mat face;

videocapture cap(

0

);

if

(!cap.isopened()) {

afxmessagebox(_t(

"please check your usb camera's interface num."

));

}

try

{

while

(

1

)

{

check_close(cap);

cap >> frame;

if

(!frame.empty())

{

if

(capture_face(frame, face)

=

=

0

)

{

/

/

convert to iplimage

format

and

then save with .jpg

format

iplimage face_img;

face_img

=

iplimage(face);

/

/

save the capture face to the project directory

cvsaveimage(

"./cap.jpg"

, &face_img);

break

;

}

imshow(

"view"

, frame);

}

int

c

=

waitkey(

10

);

if

((char)c

=

=

'c'

) {

break

; }

}

}

catch (exception& e)

{

cout <<

"\nexception thrown!"

<< endl;

cout << e.what() << endl;

#ifdef _capture_debug

messagebox(cstring(e.what()), null, mb_yesno);

#endif

goto capture;

}

|

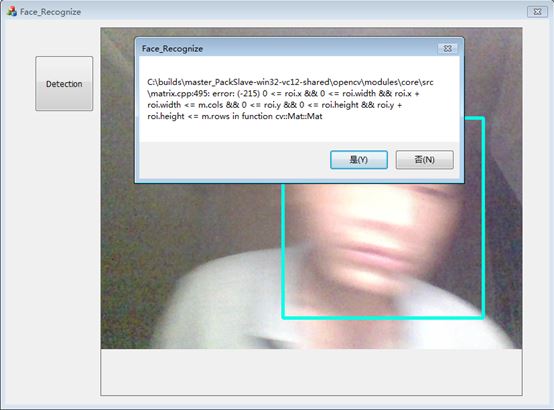

在catch中将捕获到的异常信息打印出来:

可以看到,可能是由于摄像头捕获响应速率跟不上的原因,在cap >>frame;的时候得到的frame出现了格式错误,如上图的对话框所示error(-215) 0 < roi.x,也就是说opencv感兴趣区域的x坐标出现了一个负数,而这显然必须是要非负数的地方出现了一个负数的输入,导致opencv异常抛出.

没关系我们我们不理会这个异常的frame输入就可以,在异常抛出的catch屏蔽掉对话框的显示,我们即可流畅的采集图像。不理会这个错误的帧输入也就是说直接丢弃这一帧.

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持我.

原文链接:http://www.cnblogs.com/spoorer/p/7067756.html 。

最后此篇关于Dlib+OpenCV深度学习人脸识别的方法示例的文章就讲到这里了,如果你想了解更多关于Dlib+OpenCV深度学习人脸识别的方法示例的内容请搜索CFSDN的文章或继续浏览相关文章,希望大家以后支持我的博客! 。

我使用的是linux的windows子系统,安装了ubuntu,bash运行流畅。 我正在尝试使用make,似乎bash 无法识别gcc。尝试将其添加到 PATH,但没有任何改变。奇怪的是 - cmd

ImageMagick 已正确安装。 WAMP 的“PHP 扩展”菜单也显示带有勾选的 php_imagick。除了 Apache 和系统环境变量外,phpinfo() 没有显示任何 imagick

我是这么想的,因为上限是 2^n,并且考虑到它们都是有限机,n 状态 NFA 和具有 2^n 或更少状态的 DFA 的交集将是有效。 我错了吗? 最佳答案 你是对的。 2^n 是一个上限,因此生成的

我有一个大型数据集,其中包含每日值,指示一年中的特定一天是否特别热(用 1 或 0 表示)。我的目标是识别 3 个或更多特别炎热的日子的序列,并创建一个包含每个日子的长度以及开始和结束日期的新数据集。

我有一个向量列表,每个向量看起来像这样 c("Japan", "USA", "country", "Japan", "source", "country", "UK", "source", "coun

是否有任何工具或方法可以识别静态定义数组中的缓冲区溢出(即 char[1234] 而不是 malloc(1234))? 昨天我花了大部分时间来追踪崩溃和奇怪的行为,最终证明是由以下行引起的: // e

我一直在尝试通过导入制表符分隔的文件来手动创建 Snakemake 通配符,如下所示: dataset sample species frr PRJNA493818_GSE120639_SRP1628

我一直在尝试通过导入制表符分隔的文件来手动创建 Snakemake 通配符,如下所示: dataset sample species frr PRJNA493818_GSE120639_SRP1628

我想录下某人的声音,然后根据我获得的关于他/她声音的信息,如果那个人再次说话,我就能认出来!问题是我没有关于哪些统计数据(如频率)导致人声差异的信息,如果有人可以帮助我如何识别某人的声音? 在研究过程

我希望我的程序能够识别用户何时按下“enter”并继续循环播放。但是我不知道如何使程序识别“输入”。尝试了两种方法: string enter; string ent = "\n"; dice d1;

我创建了这个带有一个参数(文件名)的 Bash 小脚本,该脚本应该根据文件的扩展名做出响应: #!/bin/bash fileFormat=${1} if [[ ${fileFormat} =~ [F

我正在寻找一种在 for 循环内迭代时识别 subview 对象的方法,我基本上通过执行 cell.contentView.subviews 从 UITableView 的 contentView 获

我正在尝试在 Swift 中使用 CallKit 来识别调用者。 我正在寻找一种通过发出 URL 请求来识别调用者的方法。 例如:+1-234-45-241 给我打电话,我希望它向 mydomain.

我将(相当古老的)插件称为“thickbox”,如下所述: 创建厚盒时,它包含基于查询的内容列表。 使用 JavaScript 或 jQuery,我希望能够访问 type 的值(在上面的示例中 t

我想编写一些可以接受某种输入并将其识别为方波、三角波或某种波形的代码。我还需要一些产生所述波的方法。 我确实有使用 C/C++ 的经验,但是,我不确定我将如何模拟所有这些。最终,我想将其转换为微 Co

我创建了一个 for 循环,用于在每个部分显示 8 个项目,但我试图在循环中识别某些项目。例如,我想识别前两项,然后是第五项和第六项,但我的识别技术似乎是正确的。 for (int i = 0; i

如何识别 UIStoryboard? 该类具有创建和实例化的方法,但我没有看到带有类似name 的@property。例如 获取 Storyboard对象 + storyboardWithName:b

如何确定所运行的SQLServer2005的版本 要确定所运行的SQLServer2005的版本,请使用SQLServerManagementStudio连接到SQLServer2005,然后运行

这个问题在这里已经有了答案: How to check whether an object is a date? (26 个答案) 关闭2 年前。 我正在使用一个 npm 模块,它在错误时抛出一个空

我正在制作一个使用 ActivityRecognition API 在后台跟踪用户 Activity 的应用,如果用户在指定时间段(例如 1 小时)内停留在同一个地方,系统就会推送通知告诉用户去散步.

我是一名优秀的程序员,十分优秀!