- ubuntu12.04环境下使用kvm ioctl接口实现最简单的虚拟机

- Ubuntu 通过无线网络安装Ubuntu Server启动系统后连接无线网络的方法

- 在Ubuntu上搭建网桥的方法

- ubuntu 虚拟机上网方式及相关配置详解

CFSDN坚持开源创造价值,我们致力于搭建一个资源共享平台,让每一个IT人在这里找到属于你的精彩世界.

这篇CFSDN的博客文章详解PyTorch基本操作由作者收集整理,如果你对这篇文章有兴趣,记得点赞哟.

什么是 PyTorch?

PyTorch是一个基于Python的科学计算包,提供最大灵活性和速度的深度学习研究平台.

张量 。

张量类似于NumPy 的n 维数组,此外张量也可以在 GPU 上使用以加速计算.

让我们构造一个简单的张量并检查输出。首先让我们看看我们如何构建一个 5×3 的未初始化矩阵:

输出如下:

现在让我们构造一个随机初始化的矩阵:

输出:

直接从数据构造张量:

输出:

创建一个统一的长张量.

「浮动张量。」 。

「在范围内创建张量」 。

「重塑张量」 。

使用 .view重塑张量.

-1根据张量的大小自动识别维度.

「改变张量轴」 。

改变张量轴:两种方法view和permute 。

view改变张量的顺序,而permute只改变轴.

张量运算 。

在下面的示例中,我们将查看加法操作:

输出:

调整大小:如果你想调整张量的形状,你可以使用“torch.view”:

输出:

PyTorch 和 NumPy的转换 。

NumPy 是Python 编程语言的库,增加了对大型、多维数组和矩阵的支持,以及对这些数组进行操作的大量高级数学函数集合.

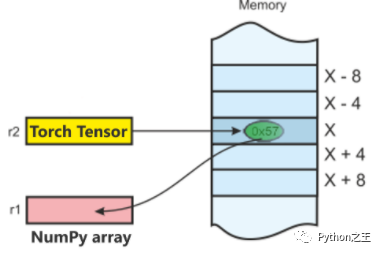

将Torch中Tensor 转换为 NumPy 数组,反之亦然是轻而易举的.

Torch Tensor 和 NumPy 数组将共享它们的底层内存位置 ,改变一个将改变另一个.

「将 Torch 张量转换为 NumPy 数组:」 。

输出:tensor([1., 1., 1., 1., 1.]) 。

输出:[1., 1., 1., 1., 1.] 。

让我们执行求和运算并检查值的变化:

输出:

「将 NumPy 数组转换为 Torch 张量:」 。

输出:

所以,正如你所看到的,就是这么简单.

接下来在这个 PyTorch 教程博客上,让我们看看PyTorch 的 AutoGrad 模块.

AutoGrad 。

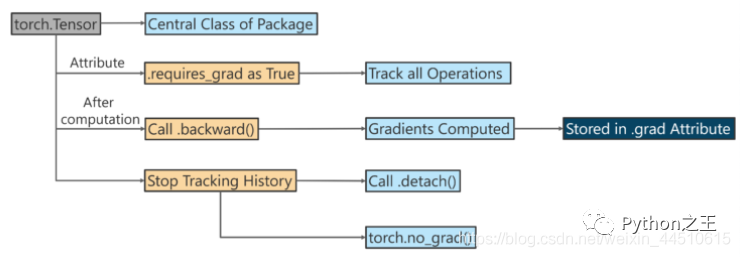

该autograd包提供自动求导为上张量的所有操作.

它是一个按运行定义的框架,这意味着您的反向传播是由您的代码运行方式定义的,并且每次迭代都可以不同.

「下面使用 Autograd 进行反向传播。」 。

如果requires_grad=True,则 Tensor 对象会跟踪它是如何创建的.

因为requires_grad=True,z知道它是通过增加两个张量的产生z = x + y.

s是由它的数字总和创建的。当我们调用.backward(),反向传播从s开始运行。然后可以计算梯度.

下面例子是计算log(x)的导数为1 / x 。

原文链接:https://mp.weixin.qq.com/s/OhtCtLxAgu1gEA2iz9bLYw 。

最后此篇关于详解PyTorch基本操作的文章就讲到这里了,如果你想了解更多关于详解PyTorch基本操作的内容请搜索CFSDN的文章或继续浏览相关文章,希望大家以后支持我的博客! 。

已关闭。此问题不符合Stack Overflow guidelines 。目前不接受答案。 这个问题似乎与 help center 中定义的范围内的编程无关。 . 已关闭 3 年前。 此帖子于去年编辑

据我所知,在使用 GPU 训练和验证模型时,GPU 内存主要用于加载数据,向前和向后。据我所知,我认为 GPU 内存使用应该相同 1) 训练前,2) 训练后,3) 验证前,4) 验证后。但在我的例子中

我正在尝试在 PyTorch 中将两个复数矩阵相乘,看起来 the torch.matmul functions is not added yet to PyTorch library for com

我正在尝试定义二分类问题的损失函数。但是,目标标签不是硬标签0,1,而是0~1之间的一个 float 。 Pytorch 中的 torch.nn.CrossEntropy 不支持软标签,所以我想自己写

我正在尝试让 PyTorch 与 DataLoader 一起工作,据说这是处理小批量的最简单方法,在某些情况下这是获得最佳性能所必需的。 DataLoader 需要一个数据集作为输入。 大多数关于 D

Pytorch Dataloader 的迭代顺序是否保证相同(在温和条件下)? 例如: dataloader = DataLoader(my_dataset, batch_size=4,

PyTorch 的负对数似然损失,nn.NLLLoss定义为: 因此,如果以单批处理的标准重量计算损失,则损失的公式始终为: -1 * (prediction of model for correct

在PyTorch中,new_ones()与ones()有什么区别。例如, x2.new_ones(3,2, dtype=torch.double) 与 torch.ones(3,2, dtype=to

假设我有一个矩阵 src带形状(5, 3)和一个 bool 矩阵 adj带形状(5, 5)如下, src = tensor([[ 0, 1, 2], [ 3, 4,

我想知道如果不在第 4 行中使用“for”循环,下面的代码是否有更有效的替代方案? import torch n, d = 37700, 7842 k = 4 sample = torch.cat([

我有三个简单的问题。 如果我的自定义损失函数不可微会发生什么? pytorch 会通过错误还是做其他事情? 如果我在我的自定义函数中声明了一个损失变量来表示模型的最终损失,我应该放 requires_

我想知道 PyTorch Parameter 和 Tensor 的区别? 现有answer适用于使用变量的旧 PyTorch? 最佳答案 这就是 Parameter 的全部想法。类(附加)在单个图像中

给定以下张量(这是网络的结果 [注意 grad_fn]): tensor([121., 241., 125., 1., 108., 238., 125., 121., 13., 117., 12

什么是__constants__在 pytorch class Linear(Module):定义于 https://pytorch.org/docs/stable/_modules/torch/nn

我在哪里可以找到pytorch函数conv2d的源代码? 它应该在 torch.nn.functional 中,但我只找到了 _add_docstr 行, 如果我搜索conv2d。我在这里看了: ht

如 documentation 中所述在 PyTorch 中,Conv2d 层使用默认膨胀为 1。这是否意味着如果我想创建一个简单的 conv2d 层,我必须编写 nn.conv2d(in_chann

我阅读了 Pytorch 的源代码,发现它没有实现 convolution_backward 很奇怪。函数,唯一的 convolution_backward_overrideable 函数是直接引发错

我对编码真的很陌生,现在我正在尝试将我的标签变成一种热门编码。我已经完成将 np.array 传输到张量,如下所示 tensor([4., 4., 4., 4., 4., 4., 4., 4., 4.

我正在尝试实现 text classification model使用CNN。据我所知,对于文本数据,我们应该使用一维卷积。我在 pytorch 中看到了一个使用 Conv2d 的示例,但我想知道如何

我有一个多标签分类问题,我正试图用 Pytorch 中的 CNN 解决这个问题。我有 80,000 个训练示例和 7900 个类;每个示例可以同时属于多个类,每个示例的平均类数为 130。 问题是我的

我是一名优秀的程序员,十分优秀!