- ubuntu12.04环境下使用kvm ioctl接口实现最简单的虚拟机

- Ubuntu 通过无线网络安装Ubuntu Server启动系统后连接无线网络的方法

- 在Ubuntu上搭建网桥的方法

- ubuntu 虚拟机上网方式及相关配置详解

CFSDN坚持开源创造价值,我们致力于搭建一个资源共享平台,让每一个IT人在这里找到属于你的精彩世界.

这篇CFSDN的博客文章pytorch自定义不可导激活函数的操作由作者收集整理,如果你对这篇文章有兴趣,记得点赞哟.

今天自定义不可导函数的时候遇到了一个大坑.

首先我需要自定义一个函数:sign_f 。

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

|

import

torch

from

torch.autograd

import

Function

import

torch.nn as nn

class

sign_f(Function):

@staticmethod

def

forward(ctx, inputs):

output

=

inputs.new(inputs.size())

output[inputs >

=

0.

]

=

1

output[inputs <

0.

]

=

-

1

ctx.save_for_backward(inputs)

return

output

@staticmethod

def

backward(ctx, grad_output):

input_,

=

ctx.saved_tensors

grad_output[input_>

1.

]

=

0

grad_output[input_<

-

1.

]

=

0

return

grad_output

|

然后我需要把它封装为一个module 类型,就像 nn.Conv2d 模块 封装 f.conv2d 一样,于是 。

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

|

import

torch

from

torch.autograd

import

Function

import

torch.nn as nn

class

sign_(nn.Module):

# 我需要的module

def

__init__(

self

,

*

kargs,

*

*

kwargs):

super

(sign_,

self

).__init__(

*

kargs,

*

*

kwargs)

def

forward(

self

, inputs):

# 使用自定义函数

outs

=

sign_f(inputs)

return

outs

class

sign_f(Function):

@staticmethod

def

forward(ctx, inputs):

output

=

inputs.new(inputs.size())

output[inputs >

=

0.

]

=

1

output[inputs <

0.

]

=

-

1

ctx.save_for_backward(inputs)

return

output

@staticmethod

def

backward(ctx, grad_output):

input_,

=

ctx.saved_tensors

grad_output[input_>

1.

]

=

0

grad_output[input_<

-

1.

]

=

0

return

grad_output

|

结果报错 。

TypeError: backward() missing 2 required positional arguments: 'ctx' and 'grad_output' 。

我试了半天,发现自定义函数后面要加 apply ,详细见下面 。

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

|

import

torch

from

torch.autograd

import

Function

import

torch.nn as nn

class

sign_(nn.Module):

def

__init__(

self

,

*

kargs,

*

*

kwargs):

super

(sign_,

self

).__init__(

*

kargs,

*

*

kwargs)

self

.r

=

sign_f.

apply

### <-----注意此处

def

forward(

self

, inputs):

outs

=

self

.r(inputs)

return

outs

class

sign_f(Function):

@staticmethod

def

forward(ctx, inputs):

output

=

inputs.new(inputs.size())

output[inputs >

=

0.

]

=

1

output[inputs <

0.

]

=

-

1

ctx.save_for_backward(inputs)

return

output

@staticmethod

def

backward(ctx, grad_output):

input_,

=

ctx.saved_tensors

grad_output[input_>

1.

]

=

0

grad_output[input_<

-

1.

]

=

0

return

grad_output

|

问题解决了! 。

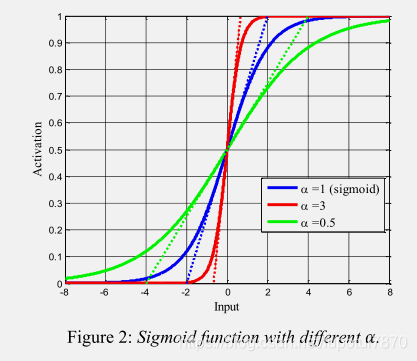

有的时候我们需要给损失函数设一个超参数但是又不想设固定阈值想和网络一起自动学习,例如给Sigmoid一个参数alpha进行调节 。

函数如下:

|

1

2

3

4

5

6

7

8

9

10

11

12

13

|

import

torch.nn as nn

import

torch

class

LearnableSigmoid(nn.Module):

def

__init__(

self

, ):

super

(LearnableSigmoid,

self

).__init__()

self

.weight

=

torch.nn.Parameter(torch.FloatTensor(

1

), requires_grad

=

True

)

self

.reset_parameters()

def

reset_parameters(

self

):

self

.weight.data.fill_(

1.0

)

def

forward(

self

,

input

):

return

1

/

(

1

+

torch.exp(

-

self

.weight

*

input

))

|

验证和Sigmoid的一致性 。

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

|

class

LearnableSigmoid(nn.Module):

def

__init__(

self

, ):

super

(LearnableSigmoid,

self

).__init__()

self

.weight

=

torch.nn.Parameter(torch.FloatTensor(

1

), requires_grad

=

True

)

self

.reset_parameters()

def

reset_parameters(

self

):

self

.weight.data.fill_(

1.0

)

def

forward(

self

,

input

):

return

1

/

(

1

+

torch.exp(

-

self

.weight

*

input

))

Sigmoid

=

nn.Sigmoid()

LearnSigmoid

=

LearnableSigmoid()

input

=

torch.tensor([[

0.5289

,

0.1338

,

0.3513

],

[

0.4379

,

0.1828

,

0.4629

],

[

0.4302

,

0.1358

,

0.4180

]])

print

(Sigmoid(

input

))

print

(LearnSigmoid(

input

))

|

输出结果 。

tensor([[0.6292, 0.5334, 0.5869], [0.6078, 0.5456, 0.6137], [0.6059, 0.5339, 0.6030]]) tensor([[0.6292, 0.5334, 0.5869], [0.6078, 0.5456, 0.6137], [0.6059, 0.5339, 0.6030]], grad_fn=<MulBackward0>) 。

验证权重是不是会更新 。

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

|

import

torch.nn as nn

import

torch

import

torch.optim as optim

class

LearnableSigmoid(nn.Module):

def

__init__(

self

, ):

super

(LearnableSigmoid,

self

).__init__()

self

.weight

=

torch.nn.Parameter(torch.FloatTensor(

1

), requires_grad

=

True

)

self

.reset_parameters()

def

reset_parameters(

self

):

self

.weight.data.fill_(

1.0

)

def

forward(

self

,

input

):

return

1

/

(

1

+

torch.exp(

-

self

.weight

*

input

))

class

Net(nn.Module):

def

__init__(

self

):

super

(Net,

self

).__init__()

self

.LSigmoid

=

LearnableSigmoid()

def

forward(

self

, x):

x

=

self

.LSigmoid(x)

return

x

net

=

Net()

print

(

list

(net.parameters()))

optimizer

=

optim.SGD(net.parameters(), lr

=

0.01

)

learning_rate

=

0.001

input_data

=

torch.randn(

10

,

2

)

target

=

torch.FloatTensor(

10

,

2

).random_(

8

)

criterion

=

torch.nn.MSELoss(

reduce

=

True

, size_average

=

True

)

for

i

in

range

(

2

):

optimizer.zero_grad()

output

=

net(input_data)

loss

=

criterion(output, target)

loss.backward()

optimizer.step()

print

(

list

(net.parameters()))

|

输出结果 。

tensor([1.], requires_grad=True)] [Parameter containing: tensor([0.9979], requires_grad=True)] [Parameter containing: tensor([0.9958], requires_grad=True)] 。

会更新~ 。

以上为个人经验,希望能给大家一个参考,也希望大家多多支持我.

原文链接:https://blog.csdn.net/qq_43110298/article/details/115032262 。

最后此篇关于pytorch自定义不可导激活函数的操作的文章就讲到这里了,如果你想了解更多关于pytorch自定义不可导激活函数的操作的内容请搜索CFSDN的文章或继续浏览相关文章,希望大家以后支持我的博客! 。

我正在尝试将抓取的 xml 输出写入 json。由于项目不可序列化,抓取失败。 从这个问题来看,它建议您需要构建一个管道,未提供的答案超出了问题 SO scrapy serializer 的范围。 所

有没有一种方法可以通过重载函数来区分参数是在编译时可评估还是仅在运行时可评估? 假设我有以下功能: std::string lookup(int x) { return table::va

我正在使用 MVVM 模式编写一个应用程序。我通过将 View 的 DataContext 属性设置为 ViewModel 的实例来向 View 提供数据。一般来说,我只是从那里使用 Binding

对于一个项目,我正在使用带有简单 python module 的传感器收集多个红外命令。 . 我收到如下字节字符串: commando1= b'7g4770CQfwCTVT9bQDAzVEBMagGR

我有一个计算方法,可以在用户使用 Cartridge 作为我的商店框架结账时计算税费。 税 = 税 * 小数(str(settings.SHOP_DEFAULT_TAX_RATE)) 计算工作正常。然

我正在用 pygame 制作一个绘图程序,我想在其中为用户提供一个选项来保存程序的确切状态,然后在稍后重新加载它。在这一点上,我保存了我的全局字典的副本,然后遍历, pickle 每个对象。 pyga

在 C++11 之前,我可以使用它来使类不可复制: private: MyClass(const MyClass&); MyClass& operator=(const MyClass&); 使用 C

大家好 :) 我在我的 VC++ 项目中使用 1.5.4-all (2014-10-22)(适用于 x86 平台的 Microsoft Visual C++ 编译器 18.00.21005.1)。 我

我有一个 python 文件:analysis.py: def svm_analyze_AHE(file_name): # obtain abp file testdata = pd.

这个问题已经有答案了: How to serialize SqlAlchemy result to JSON? (37 个回答) 已关闭 4 年前。 我正在编写小查询来从 mysql 获取数据数据库,

我是 Python 初学者,我在 JSON 方面遇到了一些问题。在我正在使用的教程中有两个函数: def read_json(filename): data = [] if os.pa

我目前正在开发一个针对 iPad 的基于 HTML5 Canvas/JavaScript 的小型绘图应用程序。它在 Safari 中运行。到目前为止,除了一件事之外,一切都进展顺利。 如果我旋转设备,

以下代码无法使用 Visual Studio 2013 编译: #include struct X { X() = default; X(const X&) = delete;

嗨,我制作了一个文本分类分类器,我在其中使用了它,它返回一个数组,我想返回 jsonresponse,但最后一行代码给我错误 'array(['cycling'], dtype =object) 不可

我使用 Flask 和 Flask-Login 进行用户身份验证。 Flask-Sqlalchemy 将这些模型存储在 sqlite 数据库中: ROLE_USER = 0 ROLE_ADMIN =

如果您尝试发送不可 JSON 序列化的对象(列表、字典、整数等以外的任何对象),您会收到以下错误消息: "errorMessage": "Object of type set is not JSON

我在尝试 move std::vector 时遇到崩溃其中 T显然是不可 move 的(没有定义 move 构造函数/赋值运算符,它包含内部指针) 但为什么 vector 的 move 函数要调用 T

我尝试在用户成功登录后将 token 返回给他们,但不断收到以下错误: 类型错误:“字节”类型的对象不可 JSON 序列化 我该如何解决这个问题?这是我到目前为止的代码: if user:

我是一名优秀的程序员,十分优秀!