- ubuntu12.04环境下使用kvm ioctl接口实现最简单的虚拟机

- Ubuntu 通过无线网络安装Ubuntu Server启动系统后连接无线网络的方法

- 在Ubuntu上搭建网桥的方法

- ubuntu 虚拟机上网方式及相关配置详解

CFSDN坚持开源创造价值,我们致力于搭建一个资源共享平台,让每一个IT人在这里找到属于你的精彩世界.

这篇CFSDN的博客文章Window10上Tensorflow的安装(CPU和GPU版本)由作者收集整理,如果你对这篇文章有兴趣,记得点赞哟.

之前摸索tensorflow的时候安装踩坑的时间非常久,主要是没搞懂几个东西的关系,就在瞎调试,以及当时很多东西不懂,很多报错也一知半解的。这次重装系统后正好需要再配置一次,把再一次的经历记录一下。我的电脑是华为的matebook13,intel i5-8625U,MX250显卡,win10系统。(不得不吐槽很垃圾,只能满足测试测试调调代码的需求) 。

深度学习利用Tensorflow平台,其中的Keras Sequential API对新用户非常的友好,可以将各基础组件组合在一起来构建模型.

(官网: https://tensorflow.google.cn/?hl=zh-cn) 。

GPU就是用来渲染计算的,GPU版本计算性能是CPU的百倍之快。如果电脑没有独立显卡只能用CPU版本计算.

tensorflow_cpu版本只需要安装anaconda后在anaconda prompt里面pip install tensorflow_cpu==(版本号) 即可。安装anaconda的方法见GPU版本里面.

注意查下python和tensorflow_cpu适配的版本号.

tensorflow_gpu版本安装大致分为三步:1、安装anaconda 2、安装cuda和cdunn 3、安装tensorflow_gpu。其中第一步和第二步的顺序可以调换,就是安装完了前面三个东西再安装tensorflow即可.

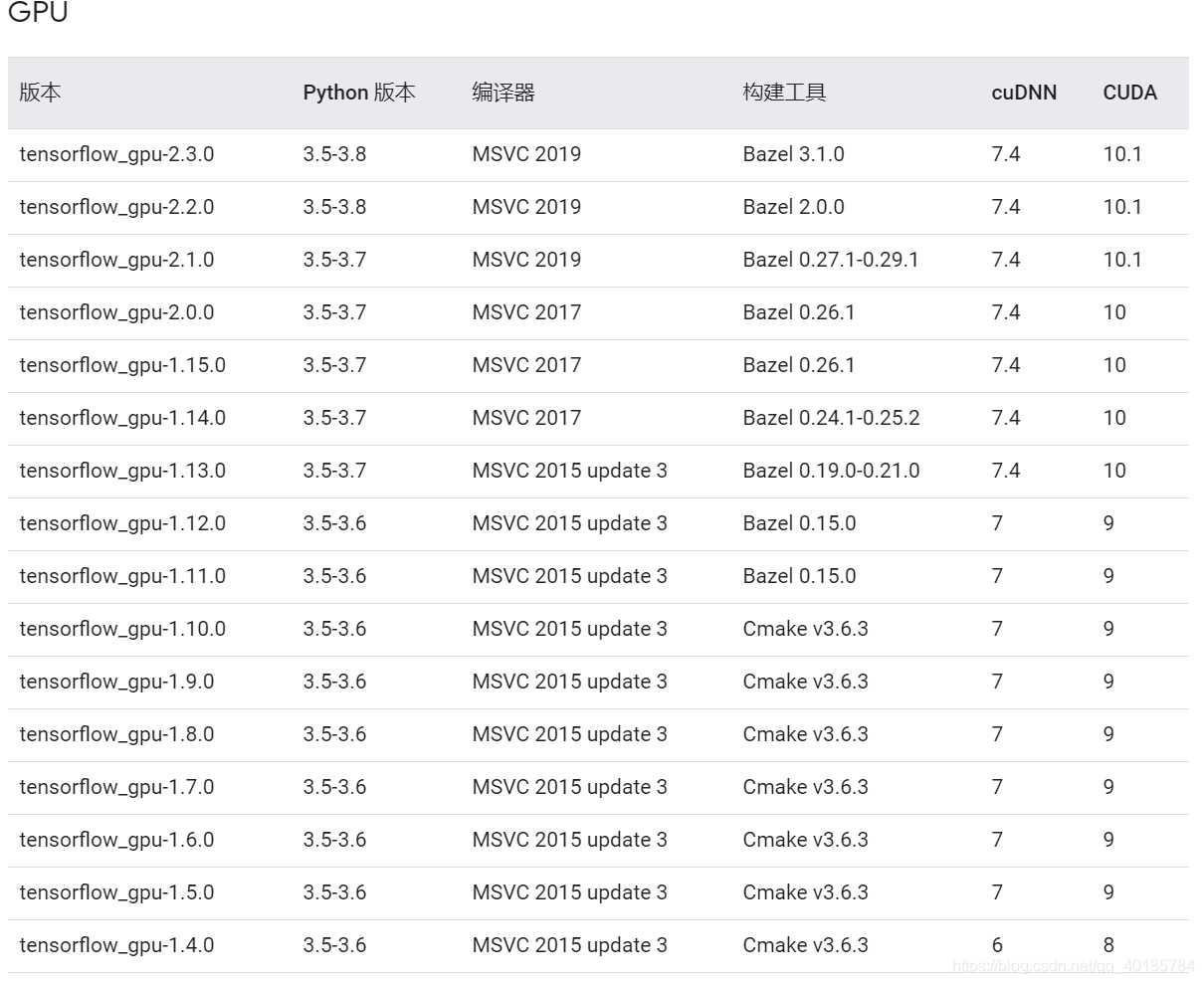

tensorflow最近出了2.0版本,和1.0大版本有一些区别。具体我还没有去了解,代码不一定兼容,需要注意一下。这三个步骤的版本需要格外的注意,一旦三个自己的版本互相不兼容或者和电脑的显卡不兼容,就用不了。所以安装前看看要安装的tensorflow版本。先查好显卡的算力,然后适配的相应版本再安装,否则踩坑要很久.

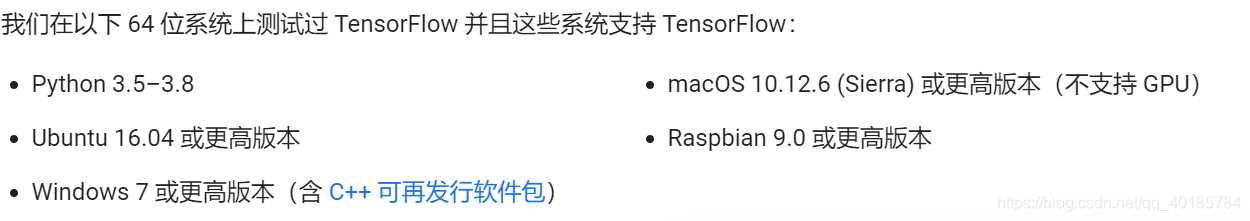

首先确定电脑所能支持的tensorflow版本,根据tensorflow官网所给配置,我们要去检查电脑gpu的cuda支持版本,再去对应下载python版本和tensorflow版本.

右键 桌面>NVIDIA控制面板>帮助>系统信息>组件 。

上图说明我的显卡所支持的cuda版本为11.1(向下兼容) 。

Tensorflow配置window官网:https://tensorflow.google.cn/install/source_windows 。

以我电脑为例,之前我用的是3.7.3的版本。这次重装系统后安装的是3.8.3.

cmd查看python版本:

我之前tensorflow用的是1.13的版本,这次因为已经安装了python3.8,因此打算安装2.0版本。如果仍需要低版本需要重新安装python较低的版本或者搭一个虚拟环境(但不是很建议).

第一步,安装anaconda 。

anaconda会对应安装python环境,不一定要最新的, 最新的python版本不一定有兼容的cuda加速,有cuda加速也不一定支持电脑的显卡.

官网安装:https://www.anaconda.com/products/individual,之前版本如果官网没有可能需要找资源.

第二步,安装cuda工具包 。

(官网:https://developer.nvidia.com/zh-cn/cuda-toolkit) 。

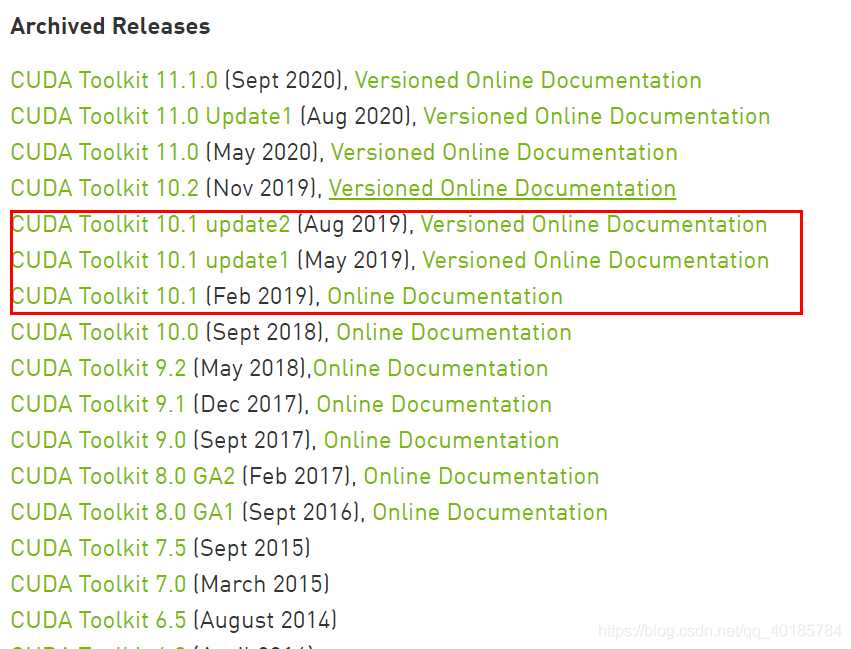

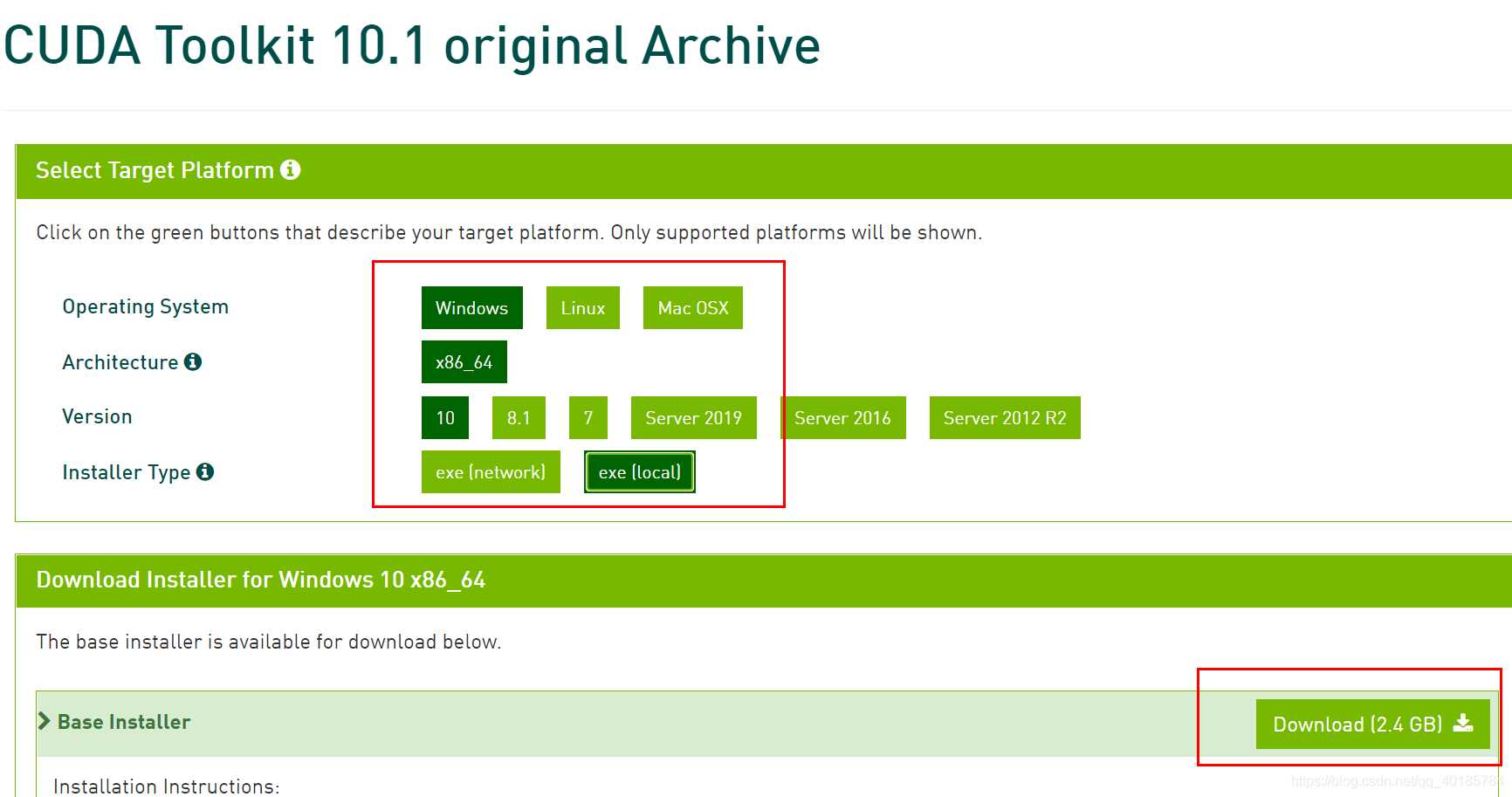

CUDA是 NVIDIA 专为图形处理单元 (GPU) 上的通用计算开发的并行计算平台和编程模型。借助 CUDA,开发者能够利用 GPU 的强大性能显著加速计算应用。在经 GPU 加速的应用中,工作负载的串行部分在 CPU 上运行,且 CPU 已针对单线程性能进行优化,而应用的计算密集型部分则以并行方式在数千个 GPU 核心上运行。使用 CUDA 时,开发者使用主流语言(如 C、C++、Fortran、Python 和 MATLAB)进行编程,并通过扩展程序以几个基本关键字的形式来表示并行性。由于tensorflow最高版本对应的是cuda10.1版本,那下载cuda10.1即可。安装包链接:https://developer.nvidia.com/cuda-toolkit-archive 。

CUDA的下载需要挂载VPN,否则下下来只有1kb (好像后面又不一定需要VPN,可以直接下载试试) 。

自定义安装,安装的东西全选了,尽量不要改安装位置 。

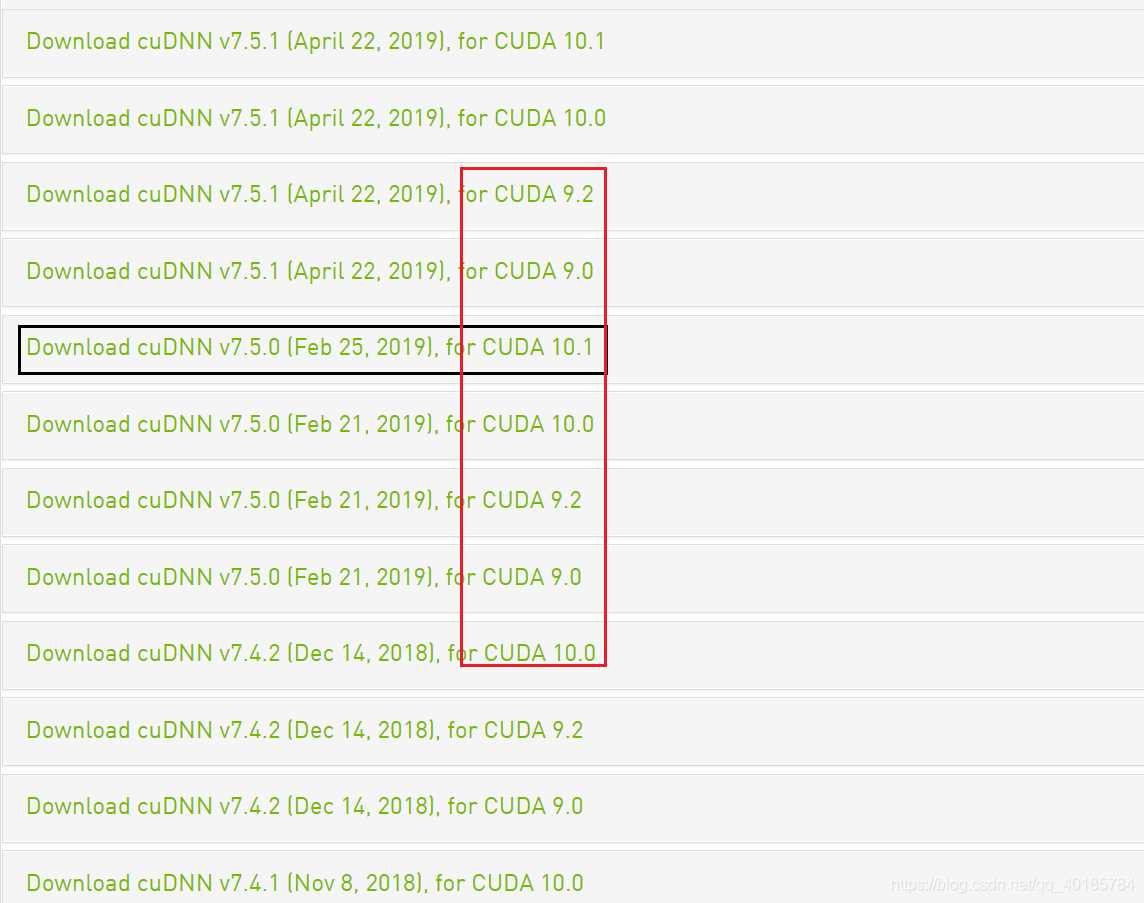

安装完之后安装cuDNN, cuDNN是用于深度神经网络的GPU加速库.注意安装的版本,选择自身cuda版本对应的cudnn下载.

官网:https://developer.nvidia.com/rdp/cudnn-archive ,cuDNN的下载需要注册官网的账号 。

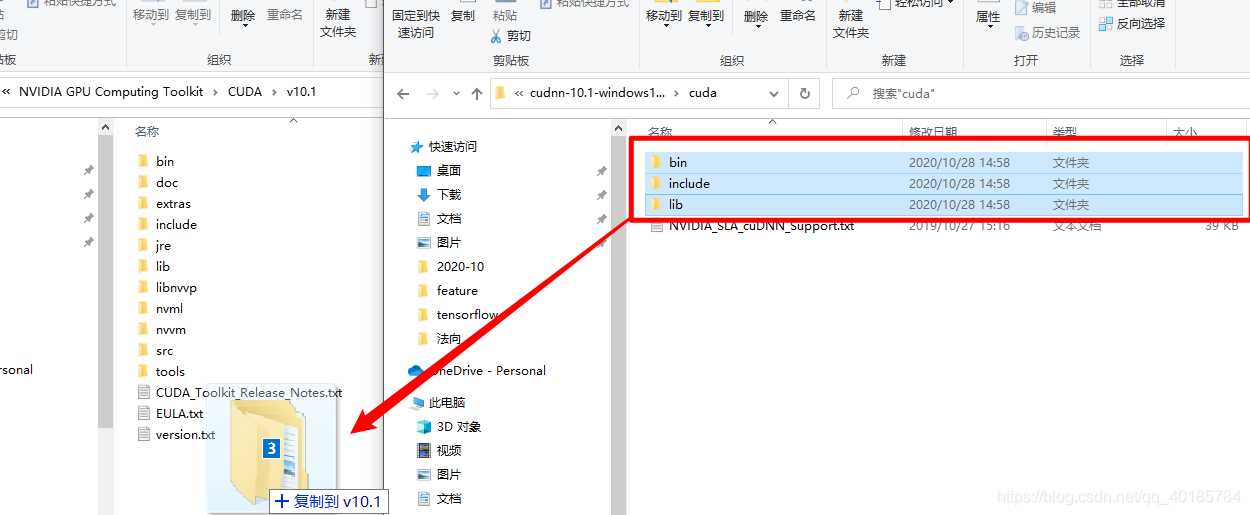

下载好的cudnn文件解压后,将文件夹内的文件放到cuda对应文件夹下,注意:是文件夹内的文件,而不要直接复制替换文件夹 。

第三步,安装tensorflow—gpu 。

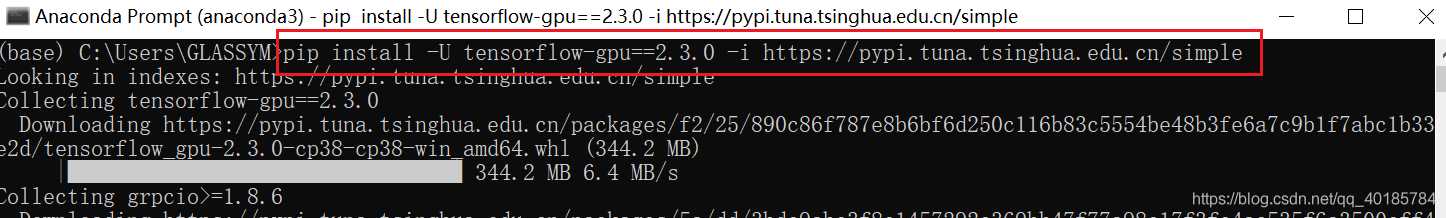

在anaconda prompt里面安装:pip install tensorflow-gpu , 后面可以指定版本号,下载慢挂载一个镜像源 -i https://pypi.tuna.tsinghua.edu.cn/simple 。

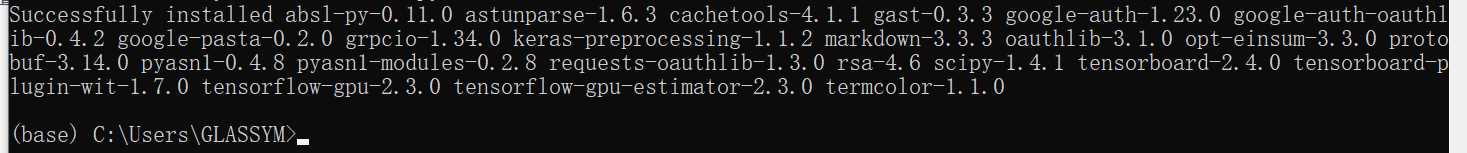

安装完成:

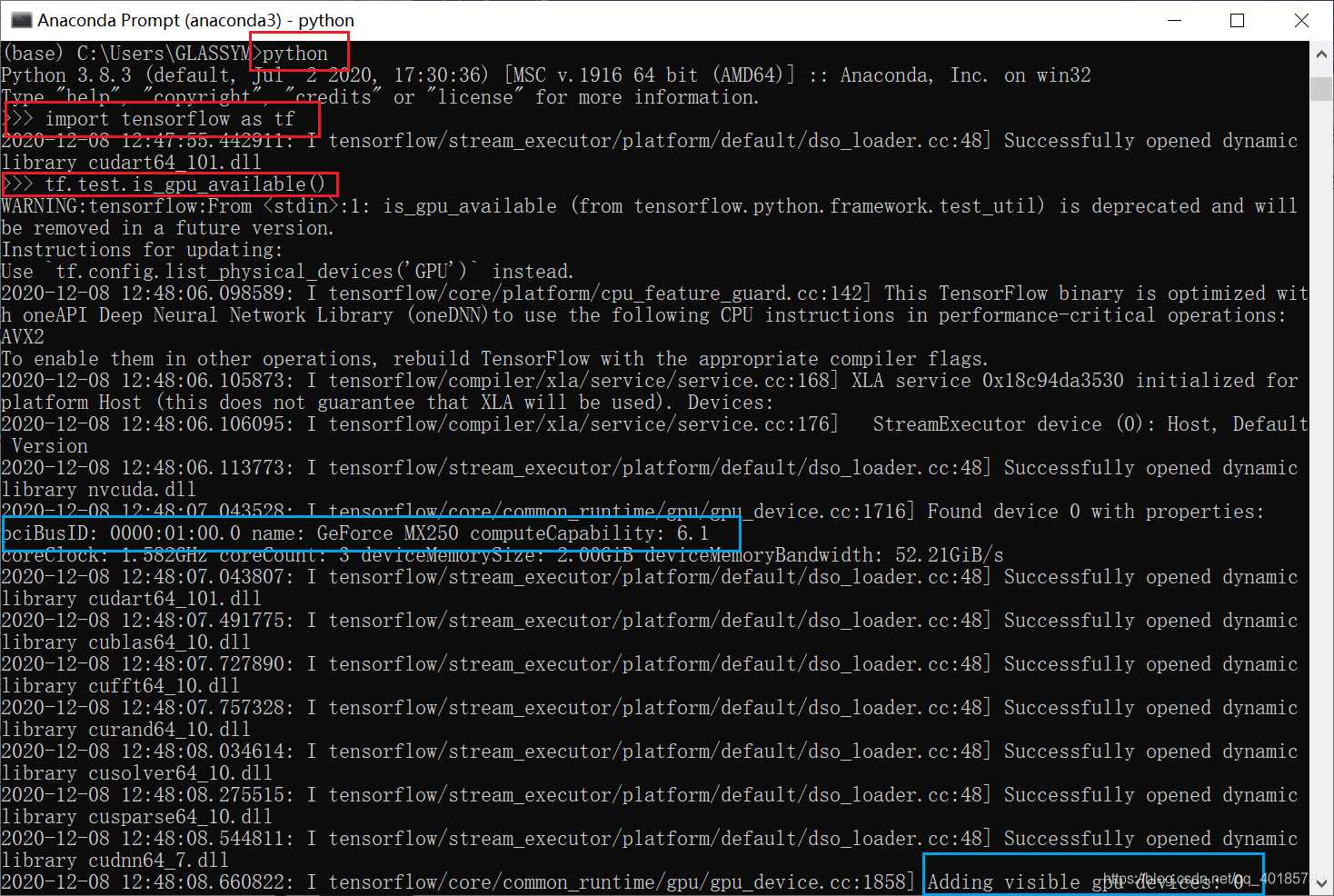

测试是否安装成功:

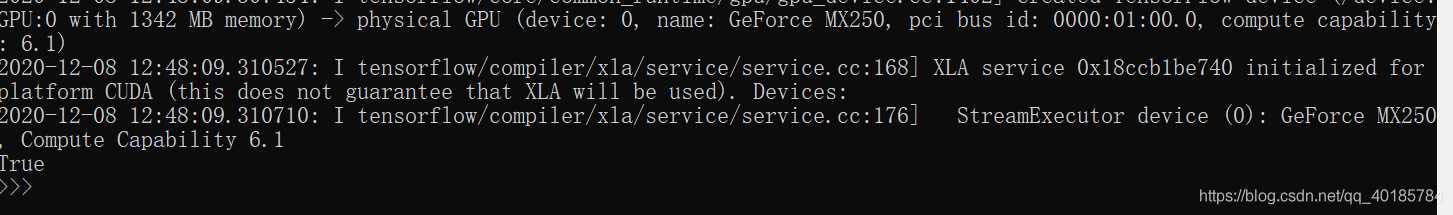

True即表示安装成功了.

查看版本号:

至此安装成功,可以跑一个小程序测试一下.

显示“GPU True”, 也即代表GPU版本安装成功.

经过几天调了一下代码之后发现tensorflow2相对与1还是有挺多改动的,1里面能够运行的代码可能2里面需要一定的修改.

关于Tensorflow2和1上面keras的一些区别可以搜一下相关的资料.

到此这篇关于Window10上Tensorflow的安装(CPU和GPU版本)的文章就介绍到这了,更多相关Window10安装Tensorflow 内容请搜索我以前的文章或继续浏览下面的相关文章希望大家以后多多支持我! 。

原文链接:https://blog.csdn.net/qq_40185784/article/details/111165906 。

最后此篇关于Window10上Tensorflow的安装(CPU和GPU版本)的文章就讲到这里了,如果你想了解更多关于Window10上Tensorflow的安装(CPU和GPU版本)的内容请搜索CFSDN的文章或继续浏览相关文章,希望大家以后支持我的博客! 。

谁能解释或指出在多 GPU/多显示器设置中渲染如何工作的解释(或至少一些线索)? 例如,我安装了 5 个 NVIDIA Quadro 4000 视频卡并连接了 9 个显示器。显示不进行任何分组。刚刚在

以下代码报错: import spacy spacy.require_gpu() Traceback (most recent call last): File "/home/user/Pycha

正如问题已经暗示的那样,我是深度学习的新手。我知道模型的学习过程在没有 GPU 的情况下会很慢。如果我愿意等待,如果我只使用CPU可以吗? 最佳答案 在计算深度学习(以及一般的神经网络)中执行的许多操

我知道 Renderscript 的设计是为了掩盖我正在运行的处理器的事实,但是有没有办法编写代码,以便在支持 GPU 计算的设备(目前是 Nexus 10)上运行显卡?有什么方法可以判断脚本的功能正

关闭。这个问题是opinion-based 。目前不接受答案。 想要改进这个问题吗?更新问题,以便 editing this post 可以用事实和引文来回答它。 . 已关闭 8 年前。 Improv

我想以编程方式找出可用的 GPU 及其当前内存使用情况,并根据内存可用性使用其中一个 GPU。我想在 PyTorch 中执行此操作。 我在这个 post 中看到了以下解决方案: import torc

我喜欢 GPU Gems 的结构化技术摘要。但是自上次发布以来已经过去了很长时间,应该开发新算法来处理新型硬件。 我可以阅读有关最近 GPU 技术成就的哪些信息? 潜伏在编程板上是唯一的方法吗? 最佳

我一直在做一些关于测量数据传输延迟的实验 CPU->GPU 和 GPU->CPU。我发现对于特定消息大小,CPU->GPU 数据传输速率几乎是 GPU->CPU 传输速率的两倍。谁能解释我为什么会这样

当我使用选项 --gres=gpu:1 向具有两个 GPU 的节点提交 SLURM 作业时,如何获取为该作业分配的 GPU ID?是否有用于此目的的环境变量?我使用的 GPU 都是 nvidia GP

我用 gpu、cuda 7.0 和 cudnn 6.5 安装了 tensorflow。当我导入 tensorflow 时,它运行良好。 我正在尝试在 Tensorflow 上运行一个简单的矩阵乘法,但

我们正在寻找有关 slurm salloc gpu 分配的一些建议。目前,给定: % salloc -n 4 -c 2 -gres=gpu:1 % srun env | grep CUDA CUD

我是否必须自定义为非 GPU Tensorflow 库编写的代码以适应tensorflow-gpu 库? 我有一个 GPU,想运行仅为非 GPU tensorflow 库编写的 Python 代码。我

我是否必须自定义为非 GPU Tensorflow 库编写的代码以适应tensorflow-gpu 库? 我有一个 GPU,想运行仅为非 GPU tensorflow 库编写的 Python 代码。我

我正在使用 pytorch 框架训练网络。我的电脑里有 K40 GPU。上周,我在同一台计算机上添加了 1080。 在我的第一个实验中,我在两个 GPU 上观察到相同的结果。然后,我在两个 GPU 上

有没有办法在 Slurm 上超额订阅 GPU,即运行共享一个 GPU 的多个作业/作业步骤?我们只找到了超额订阅 CPU 和内存的方法,但没有找到 GPU。 我们希望在同一 GPU 上并行运行多个作业

我可以访问 4 个 GPU(不是 root 用户)。其中一个 GPU(2 号)表现怪异,它们的一些内存被阻塞但功耗和温度非常低(好像没有任何东西在上面运行)。请参阅下图中 nvidia-smi 的详细

我正在尝试通过 Tensorflow 运行示例 seq2seq,但它不会使用 GPU。以下是我在带有 Tesla K20x 的 Linux 系统上安装 Tensorflow 所采取的步骤 git cl

一位电气工程师最近提醒我不要使用 GPU 进行科学计算(例如,在精度非常重要的地方),因为没有像 CPU 那样的硬件保护措施。这是真的吗?如果是的话,典型硬件中的问题有多普遍/严重? 最佳答案 实际上

关闭。这个问题不满足Stack Overflow guidelines .它目前不接受答案。 想改善这个问题吗?更新问题,使其成为 on-topic对于堆栈溢出。 7年前关闭。 Improve thi

最近我研究了强化学习,有一个问题困扰着我,我找不到答案:如何使用 GPU 有效地完成训练?据我所知,需要与环境持续交互,这对我来说似乎是一个巨大的瓶颈,因为这项任务通常是非数学的/不可并行化的。然而,

我是一名优秀的程序员,十分优秀!