- ubuntu12.04环境下使用kvm ioctl接口实现最简单的虚拟机

- Ubuntu 通过无线网络安装Ubuntu Server启动系统后连接无线网络的方法

- 在Ubuntu上搭建网桥的方法

- ubuntu 虚拟机上网方式及相关配置详解

CFSDN坚持开源创造价值,我们致力于搭建一个资源共享平台,让每一个IT人在这里找到属于你的精彩世界.

这篇CFSDN的博客文章彻底搞清 Flink 中的 Window 机制由作者收集整理,如果你对这篇文章有兴趣,记得点赞哟.

在流处理应用中,数据是连续不断的,有时我们需要做一些聚合类的处理,例如:在过去的1分钟内有多少用户点击了我们的网页.

在这种情况下,我们必须定义一个窗口(window),用来收集最近1分钟内的数据,并对这个窗口内的数据进行计算 。

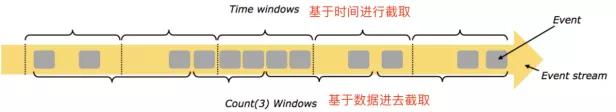

2.1 按照time和count分类 。

time-window:时间窗口:根据时间划分窗口,如:每xx分钟统计最近xx分钟的数据 。

count-window:数量窗口:根据数量划分窗口,如:每xx个数据统计最近xx个数据 。

2.2 按照slide和size分类 。

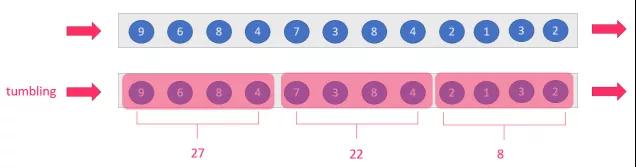

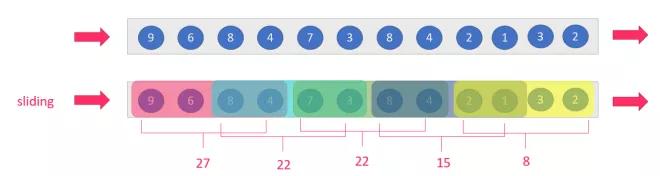

窗口有两个重要的属性: 窗口大小size和滑动间隔slide,根据它们的大小关系可分为

tumbling-window:滚动窗口:size=slide,如:每隔10s统计最近10s的数据 。

sliding-window:滑动窗口:size>slide,如:每隔5s统计最近10s数据 。

注意:当size 。

小结 。

按照上面窗口的分类方式进行组合,可以得出如下的窗口

注意:Flink还支持一个特殊的窗口:Session会话窗口,需要设置一个会话超时时间,如30s,则表示30s内没有数据到来,则触发上个窗口的计算 。

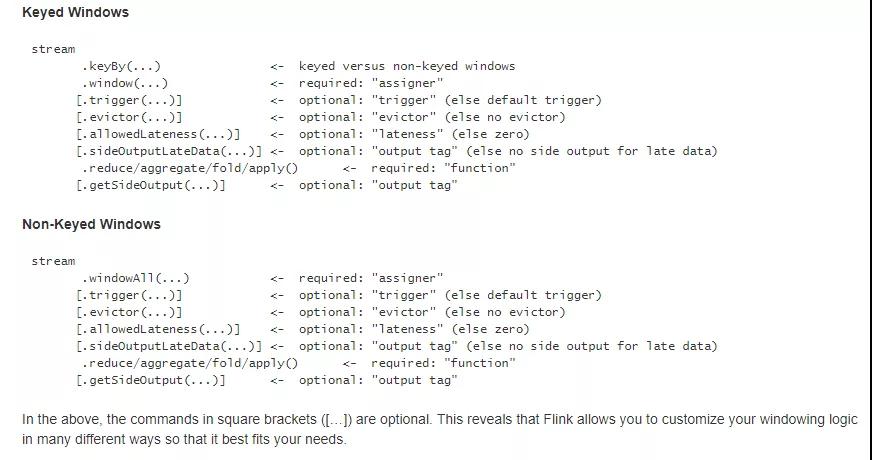

3.1 window和windowAll 。

使用keyby的流,应该使用window方法 。

未使用keyby的流,应该调用windowAll方法 。

区别:

Window算子:是可以设置并行度的 。

WindowAll 算子:并行度始终为1 。

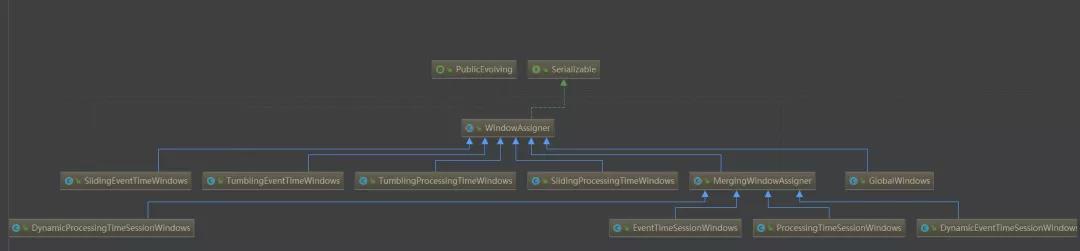

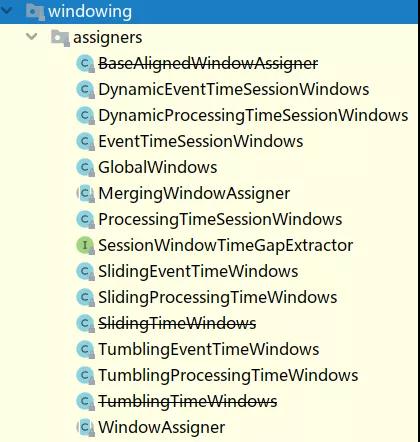

3.2 WindowAssigner 。

Windows Assigner的作用是指定窗口的类型,定义如何将数据流分配到一个或者多个窗口,API中通过window (WindowsAssigner assigner)指定。在Flink中支持两种类型的窗口,一种是基于时间的窗口(TimeWindow),另一种是基于数量的窗口(countWindow)。窗口所表现出的类型特性取决于window assigner的定义.

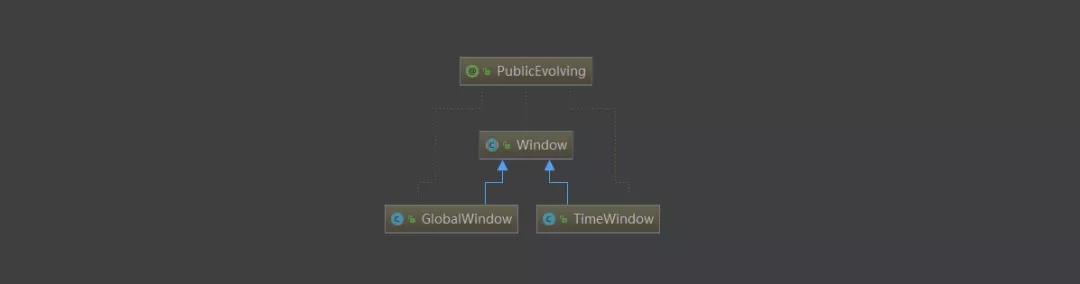

Flink底层Window模型仅有TimeWindow以及GlobalWindow.

Flink提供了很多各种场景用的WindowAssigner:

如果需要自定制数据分发策略,则可以实现一个 class,继承自 WindowAssigner.

3.3 evictor 。

evictor 主要用于做一些数据的自定义操作,可以在执行用户代码之前,也可以在执行 。

用户代码之后,更详细的描述可以参考org.apache.flink.streaming.api.windowing.evictors.Evictor 的 evicBefore 和 evicAfter两个方法.

Flink 提供了如下三种通用的 evictor:

CountEvictor 保留指定数量的元素 。

TimeEvictor 设定一个阈值 interval,删除所有不再 max_ts - interval 范围内的元 。

素,其中 max_ts 是窗口内时间戳的最大值.

DeltaEvictor 通过执行用户给定的 DeltaFunction 以及预设的 theshold,判断是否删 除一个元素.

3.4 trigger 。

trigger 用来判断一个窗口是否需要被触发,每个 WindowAssigner 都自带一个默认的trigger, 。

如果默认的 trigger 不能满足你的需求,则可以自定义一个类,继承自Trigger 即可,我们详细描述下 Trigger 的接口以及含义:

onEventTime() 当 event-time timer 被触发的时候会调用 。

onElement() 每次往 window 增加一个元素的时候都会触发 。

onMerge() 对两个 `rigger 的 state 进行 merge 操作 。

clear() window 销毁的时候被调用 。

上面的接口中前三个会返回一个 TriggerResult, TriggerResult 有如下几种可能的选 择:

4.1 基于时间的滚动和滑动窗口 。

测试数据 。

需求1:每5秒钟统计一次,最近5秒钟内,各个路口通过红绿灯汽车的数量--基于时间的滚动窗口 。

需求2:每5秒钟统计一次,最近10秒钟内,各个路口通过红绿灯汽车的数量--基于时间的滑动窗口 。

4.2 基于数量的滚动和滑动窗口 。

测试数据 。

需求1:统计在最近5条消息中,各自路口通过的汽车数量,相同的key每出现5次进行统计--基于数量的滚动窗口 。

需求2:统计在最近5条消息中,各自路口通过的汽车数量,相同的key每出现3次进行统计--基于数量的滑动窗口 。

case class CartInfo(var sensorId: String, var count: Int) 。

4.3 会话窗口 。

测试数据 。

设置会话超时时间为10s,10s内没有数据到来,则触发上个窗口的计算 。

原文链接:https://mp.weixin.qq.com/s/GPIcjPQUT1xAKAG6fBmvtg 。

最后此篇关于彻底搞清 Flink 中的 Window 机制的文章就讲到这里了,如果你想了解更多关于彻底搞清 Flink 中的 Window 机制的内容请搜索CFSDN的文章或继续浏览相关文章,希望大家以后支持我的博客! 。

我想做的是让 JTextPane 在 JPanel 中占用尽可能多的空间。对于我使用的 UpdateInfoPanel: public class UpdateInfoPanel extends JP

我在 JPanel 中有一个 JTextArea,我想将其与 JScrollPane 一起使用。我正在使用 GridBagLayout。当我运行它时,框架似乎为 JScrollPane 腾出了空间,但

我想在 xcode 中实现以下功能。 我有一个 View Controller 。在这个 UIViewController 中,我有一个 UITabBar。它们下面是一个 UIView。将 UITab

有谁知道Firebird 2.5有没有类似于SQL中“STUFF”函数的功能? 我有一个包含父用户记录的表,另一个表包含与父相关的子用户记录。我希望能够提取用户拥有的“ROLES”的逗号分隔字符串,而

我想使用 JSON 作为 mirth channel 的输入和输出,例如详细信息保存在数据库中或创建 HL7 消息。 简而言之,输入为 JSON 解析它并输出为任何格式。 最佳答案 var objec

通常我会使用 R 并执行 merge.by,但这个文件似乎太大了,部门中的任何一台计算机都无法处理它! (任何从事遗传学工作的人的附加信息)本质上,插补似乎删除了 snp ID 的 rs 数字,我只剩

我有一个以前可能被问过的问题,但我很难找到正确的描述。我希望有人能帮助我。 在下面的代码中,我设置了varprice,我想添加javascript变量accu_id以通过rails在我的数据库中查找记

我有一个简单的 SVG 文件,在 Firefox 中可以正常查看 - 它的一些包装文本使用 foreignObject 包含一些 HTML - 文本包装在 div 中:

所以我正在为学校编写一个 Ruby 程序,如果某个值是 1 或 3,则将 bool 值更改为 true,如果是 0 或 2,则更改为 false。由于我有 Java 背景,所以我认为这段代码应该有效:

我做了什么: 我在这些账户之间创建了 VPC 对等连接 互联网网关也连接到每个 VPC 还配置了路由表(以允许来自双方的流量) 情况1: 当这两个 VPC 在同一个账户中时,我成功测试了从另一个 La

我有一个名为 contacts 的表: user_id contact_id 10294 10295 10294 10293 10293 10294 102

我正在使用 Magento 中的新模板。为避免重复代码,我想为每个产品预览使用相同的子模板。 特别是我做了这样一个展示: $products = Mage::getModel('catalog/pro

“for”是否总是检查协议(protocol)中定义的每个函数中第一个参数的类型? 编辑(改写): 当协议(protocol)方法只有一个参数时,根据该单个参数的类型(直接或任意)找到实现。当协议(p

我想从我的 PHP 代码中调用 JavaScript 函数。我通过使用以下方法实现了这一点: echo ' drawChart($id); '; 这工作正常,但我想从我的 PHP 代码中获取数据,我使

这个问题已经有答案了: Event binding on dynamically created elements? (23 个回答) 已关闭 5 年前。 我有一个动态表单,我想在其中附加一些其他 h

我正在尝试找到一种解决方案,以在 componentDidMount 中的映射项上使用 setState。 我正在使用 GraphQL连同 Gatsby返回许多 data 项目,但要求在特定的 pat

我在 ScrollView 中有一个 View 。只要用户按住该 View ,我想每 80 毫秒调用一次方法。这是我已经实现的: final Runnable vibrate = new Runnab

我用 jni 开发了一个 android 应用程序。我在 GetStringUTFChars 的 dvmDecodeIndirectRef 中得到了一个 dvmabort。我只中止了一次。 为什么会这

当我到达我的 Activity 时,我调用 FragmentPagerAdapter 来处理我的不同选项卡。在我的一个选项卡中,我想显示一个 RecyclerView,但他从未出现过,有了断点,我看到

当我按下 Activity 中的按钮时,会弹出一个 DialogFragment。在对话框 fragment 中,有一个看起来像普通 ListView 的 RecyclerView。 我想要的行为是当

我是一名优秀的程序员,十分优秀!