- ubuntu12.04环境下使用kvm ioctl接口实现最简单的虚拟机

- Ubuntu 通过无线网络安装Ubuntu Server启动系统后连接无线网络的方法

- 在Ubuntu上搭建网桥的方法

- ubuntu 虚拟机上网方式及相关配置详解

CFSDN坚持开源创造价值,我们致力于搭建一个资源共享平台,让每一个IT人在这里找到属于你的精彩世界.

这篇CFSDN的博客文章Kafka 如何解决消息不丢失?由作者收集整理,如果你对这篇文章有兴趣,记得点赞哟.

大家好,我是Tom哥~ 。

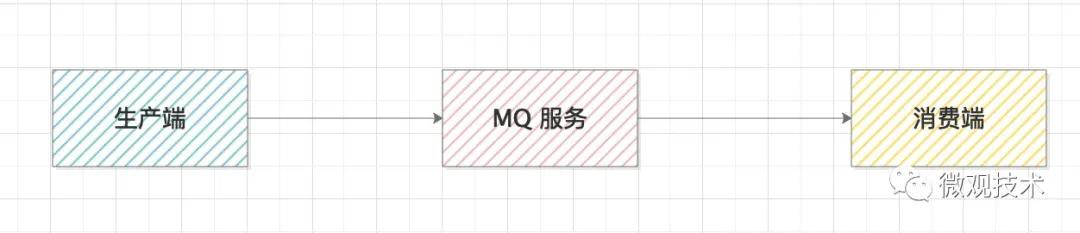

Kafka 消息框架,大家一定不陌生,很多人工作中都有接触。它的核心思路,通过一个高性能的MQ服务来连接生产和消费两个系统,达到系统间的解耦,有很强的扩展性.

你可能会有疑问,如果中间某一个环节断掉了,那怎么办?

这种情况,我们称之为消息丢失,会造成系统间的数据不一致.

那如何解决这个问题?需要从生产端、MQ服务端、消费端,三个维度来处理.

1、生产端 。

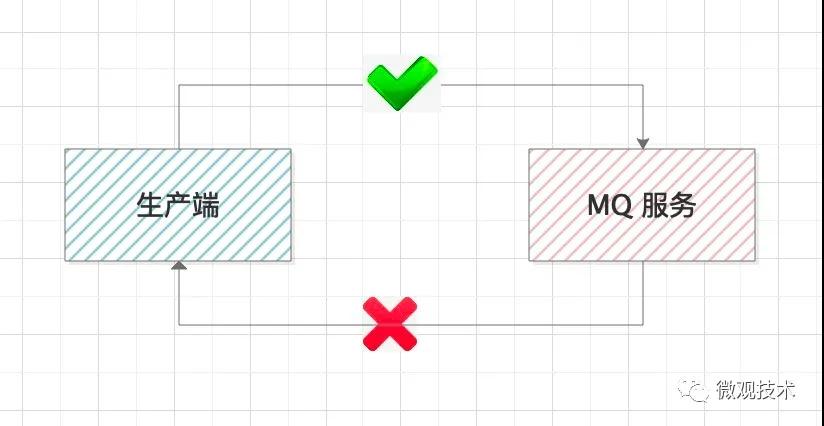

生产端的职责就是,确保生产的消息能到达MQ服务端,这里我们需要有一个响应来判断本次的操作是否成功.

比如,上面的代码就是通过一个Callback函数,来判断消息是否发送成功,如果失败,我们需要补偿处理.

另外,为了提升发送时的灵活性,kafka提供了多种参数,供不同业务自己选择 。

1.1 参数 acks 。

该参数表示有多少个分区副本收到消息,才认为本次发送是成功的.

acks=0,只要发送消息就认为成功,生产端不等待服务器节点的响应 。

acks=1,表示生产者收到 leader 分区的响应就认为发送成功 。

acks=-1,只有当 ISR 中的副本全部收到消息时,生产端才会认为是成功的。这种配置是最安全的,但由于同步的节点较多,吞吐量会降低.

1.2 参数 retries 。

表示生产端的重试次数,如果重试次数用完后,还是失败,会将消息临时存储在本地磁盘,待服务恢复后再重新发送。建议值 retries=3 。

1.3 参数 retry.backoff.m 。

消息发送超时或失败后,间隔的重试时间。一般推荐的设置时间是 300 毫秒.

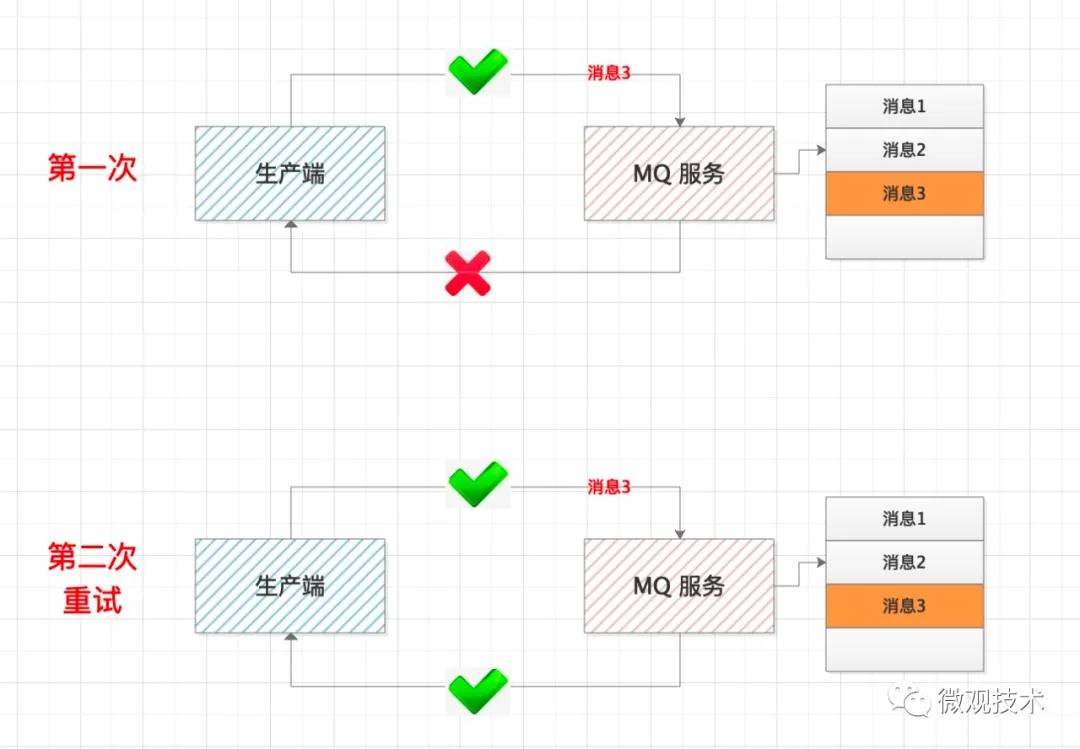

这里要特别注意一种特殊情况,如果MQ服务没有正常响应,不一定代表消息发送失败,也有可能是响应时正好赶上网络抖动,响应超时.

当生产端做完这些,一定能保证消息发送成功了,但可能发送多次,这样就会导致消息重复,这个我们后面再讲解决方案.

2、MQ服务端 。

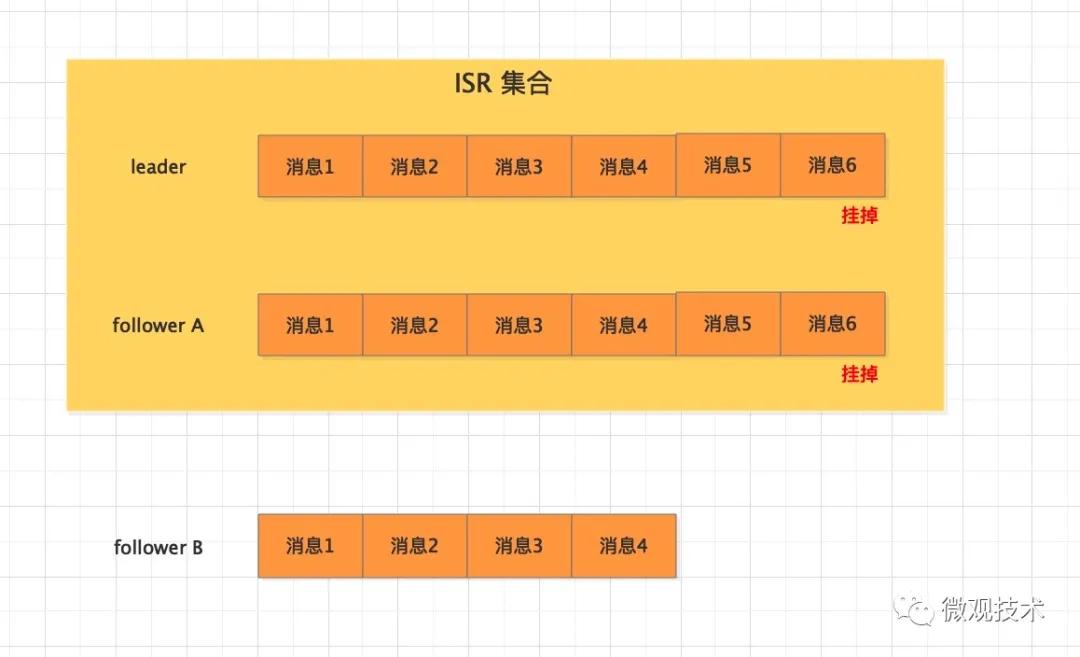

MQ服务端作为消息的存储介质,也有可能会丢失消息。比如:一个分区突然挂掉,那么怎么保证这个分区的数据不丢失,我们会引入副本概念,通过备份来解决这个问题.

具体可设置哪些参数?

2.1 参数 replication.factor 。

表示分区副本的个数,replication.factor >1 当leader 副本挂了,follower副本会被选举为leader继续提供服务.

2.2 参数 min.insync.replicas 。

表示 ISR 最少的副本数量,通常设置 min.insync.replicas >1,这样才有可用的follower副本执行替换,保证消息不丢失 。

2.3 参数 unclean.leader.election.enable 。

是否可以把非 ISR 集合中的副本选举为 leader 副本.

如果设置为true,而follower副本的同步消息进度落后较多,此时被选举为leader,会导致消息丢失,慎用.

3、消费端 。

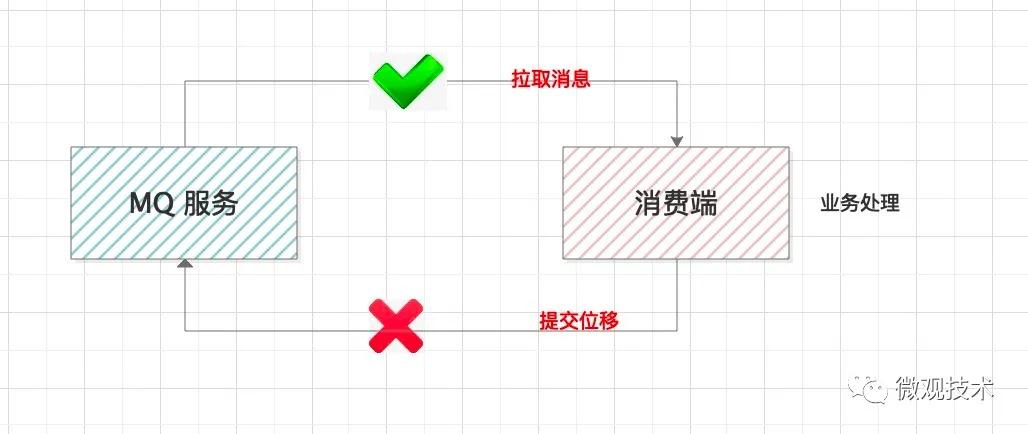

消费端要做的是把消息完整的消费处理掉。但是这里面有个提交位移的步骤.

有的同学,考虑到业务处理消耗时间较长,会单独启动线程拉取消息存储到本地内存队列,然后再搞个线程池并行处理业务逻辑。这样设计有个风险,本地消息如果没有处理完,服务器宕机了,会造成消息丢失.

正确的做法:拉取消息 --- 业务处理 ---- 提交消费位移 。

关于提交位移,kafka提供了集中参数配置 。

参数 enable.auto.commit 。

表示消费位移是否自动提交.

如果拉取了消息,业务逻辑还没处理完,提交了消费位移但是消费端却挂了,消费端恢复或其他消费端接管该分片再也拉取不到这条消息,会造成消息丢失。所以,我们通常设置 enable.auto.commit=false,手动提交消费位移.

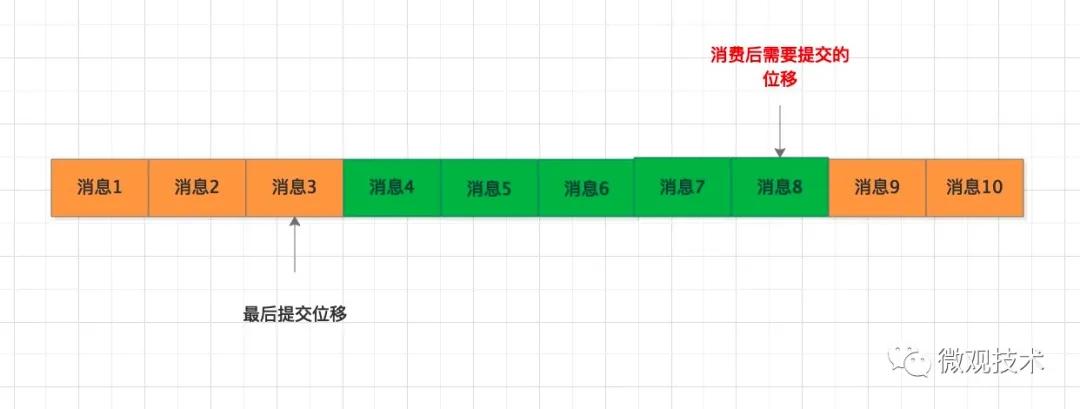

这个方案,会产生另外一个问题,我们来看下这个图:

拉取了消息4~消息8,业务处理后,在提交消费位移时,不凑巧系统宕机了,最后的提交位移并没有保存到MQ 服务端,下次拉取消息时,依然是从消息4开始拉取,但是这部分消息已经处理过了,这样便会导致重复消费.

如何解决重复消费,避免引发数据不一致 。

首先,要解决MQ 服务端的重复消息。kafka 在 0.11.0 版本后,每条消息都有唯一的message id, MQ服务采用空间换时间方式,自动对重复消息过滤处理,保证接口的幂等性.

但这个不能根本上解决消息重复问题,即使MQ服务中存储的消息没有重复,但消费端是采用拉取方式,如果重复拉取,也会导致重复消费,如何解决这种场景问题?

方案一:只拉取一次(消费者拉取消息后,先提交 offset 后再处理消息),但是如果系统宕机,业务处理没有正常结束,后面再也拉取不到这些消息,会导致数据不一致,该方案很少采用.

方案二:允许拉取重复消息,但是消费端自己做幂等性控制。保证只成功消费一次.

关于幂等技术方案很多,我们可以采用数据表或Redis缓存存储处理标识,每次拉取到消息,处理前先校验处理状态,再决定是处理还是丢弃消息.

原文链接:https://mp.weixin.qq.com/s/ppJ6asrbT-r3_9T3SHOGTw 。

最后此篇关于Kafka 如何解决消息不丢失?的文章就讲到这里了,如果你想了解更多关于Kafka 如何解决消息不丢失?的内容请搜索CFSDN的文章或继续浏览相关文章,希望大家以后支持我的博客! 。

@Cacheable在同一类中方法调用无效 上述图片中,同一个类中genLiveBullets()方法调用同类中的queryLiveByRoom()方法,这样即便标识了Cacheable标签,

目录 @Transaction注解导致动态切换更改数据库失效 使用场景 遇到问题 解决 @Transaction

@RequestBody不能class类型匹配 在首次第一次尝试使用@RequestBody注解 开始加载字符串使用post提交(貌似只能post),加Json数据格式传输的时候,

目录 @Autowired注入static接口问题 @Autowired自动注入普通service很方便 但是如果注入static修饰的serv

目录 @RequestBody部分属性丢失 问题描述 JavaBean实现 Controller实现

目录 解决@PathVariable参数接收不完整的问题 今天遇到的问题是: 解决办法: @PathVariable接受的参

这几天在项目里面发现我使用@Transactional注解事务之后,抛了异常居然不回滚。后来终于找到了原因。 如果你也出现了这种情况,可以从下面开始排查。 1、特性 先来了解一下@Trans

概述: ? 1

场景: 在处理定时任务时,由于这几个方法都是静态方法,在aop的切面中使用@Around注解,进行监控方法调用是否有异常。 发现aop没有生效。 代码如下:

最近做项目的时候 用户提出要上传大图片 一张图片有可能十几兆 本来用的第三方的上传控件 有限制图片上传大小的设置 以前设置的是2M&nb

我已经实现了这个SCIM reference code在我们的应用程序中。 我实现的代码确实通过了此postman link中存在的所有用户测试集合。 。我的 SCIM Api 也被 Azure 接受

我一直对“然后”不被等待的行为感到困扰,我明白其原因。然而,我仍然需要绕过它。这是我的用例。 doWork(family) { return doWork1(family)

我正在尝试查找 channel 中的消息是否仍然存在,但是,我不确定如何解决 promise ,查看其他答案和文档,我可以看到它可能是通过函数实现的,但我是不完全确定如何去做。我希望能在这方面获得一些

我有以下情况: 同一工作区中的 2 个 Eclipse 项目:Apa 和 Bepa(为简洁起见,使用化名)。 Apa 项目引用(包括)Bepa 项目。 我在 Bepa 有一个类 X,具有公共(publ

这个问题已经有答案了: Why am I getting a NoClassDefFoundError in Java? (31 个回答) 已关闭 6 年前。 我正在努力学习 spring。所以我输入

我正在写一个小游戏,屏幕上有许多圆圈在移动。 我在两个线程中管理圈子,如下所示: public void run() { int stepCount = 0; int dx;

我在使用 Sympy 求解方程时遇到问题。当我运行代码时,例如: 打印(校正(10)) 我希望它打印一个数字 f。相反,它给我错误:执行中止。 def correction(r): from

好吧,我制作的每个页面都有这个问题。我不确定我做错了什么,但我所有的页面都不适用于所有分辨率。可能是因为我使用的是宽屏?大声笑我不确定,但在小于宽屏分辨率的情况下,它永远不会看起来正确。它的某些部分你

我正在尝试像这样进行一个非常简单的文化 srting 检查 if(culture.ToUpper() == "ES-ES" || "IT-IT") { //do something } else

Closed. This question is off-topic. It is not currently accepting answers. Learn more。 想改进这个问题吗?Upda

我是一名优秀的程序员,十分优秀!