- ubuntu12.04环境下使用kvm ioctl接口实现最简单的虚拟机

- Ubuntu 通过无线网络安装Ubuntu Server启动系统后连接无线网络的方法

- 在Ubuntu上搭建网桥的方法

- ubuntu 虚拟机上网方式及相关配置详解

CFSDN坚持开源创造价值,我们致力于搭建一个资源共享平台,让每一个IT人在这里找到属于你的精彩世界.

这篇CFSDN的博客文章pytorch 中autograd.grad()函数的用法说明由作者收集整理,如果你对这篇文章有兴趣,记得点赞哟.

我们在用神经网络求解PDE时, 经常要用到输出值对输入变量(不是Weights和Biases)求导; 在训练WGAN-GP 时, 也会用到网络对输入变量的求导.

以上两种需求, 均可以用pytorch 中的autograd.grad() 函数实现.

autograd.grad(outputs, inputs, grad_outputs=None, retain_graph=None, create_graph=False, only_inputs=True, allow_unused=False) 。

outputs: 求导的因变量(需要求导的函数) 。

inputs: 求导的自变量 。

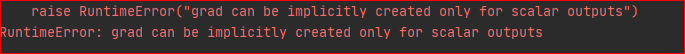

grad_outputs: 如果 outputs为标量,则grad_outputs=None,也就是说,可以不用写; 如果outputs 是向量,则此参数必须写,不写将会报如下错误:

那么此参数究竟代表着什么呢?

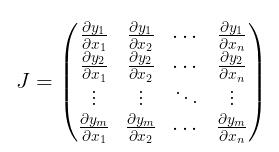

先假设 为一维向量, 即可设自变量因变量分别为 , 其对应的 Jacobi 矩阵为 。

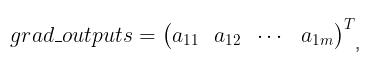

grad_outputs 是一个shape 与 outputs 一致的向量, 即 。

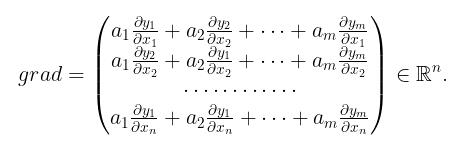

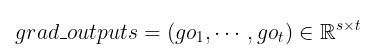

在给定grad_outputs 之后,真正返回的梯度为 。

为方便下文叙述我们引入记号 。

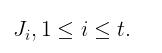

其次假设 ,第i个列向量对应的Jacobi矩阵为 。

此时的grad_outputs 为(维度与outputs一致) 。

由第一种情况, 我们有 。

也就是说对输出变量的列向量求导,再经过权重累加.

若 沿用第一种情况记号 。

, 其中每一个 均由第一种方法得出, 。

即对输入变量列向量求导,之后按照原先顺序排列即可.

retain_graph: True 则保留计算图, False则释放计算图 。

create_graph: 若要计算高阶导数,则必须选为True 。

allow_unused: 允许输入变量不进入计算 。

下面我们看一下具体的例子:

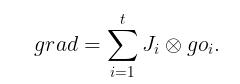

import torchfrom torch import autograd x = torch.rand(3, 4)x.requires_grad_()

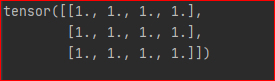

观察 x 为 。

不妨设 y 是 x 所有元素的和, 因为 y是标量,故计算导数不需要设置grad_outputs 。

y = torch.sum(x)grads = autograd.grad(outputs=y, inputs=x)[0]print(grads)

结果为 。

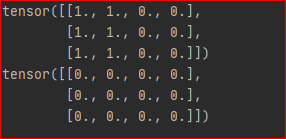

若y是向量 。

y = x[:,0] +x[:,1]# 设置输出权重为1grad = autograd.grad(outputs=y, inputs=x, grad_outputs=torch.ones_like(y))[0]print(grad)# 设置输出权重为0grad = autograd.grad(outputs=y, inputs=x, grad_outputs=torch.zeros_like(y))[0]print(grad)

结果为 。

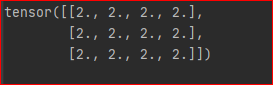

最后, 我们通过设置 create_graph=True 来计算二阶导数 。

y = x ** 2grad = autograd.grad(outputs=y, inputs=x, grad_outputs=torch.ones_like(y), create_graph=True)[0]grad2 = autograd.grad(outputs=grad, inputs=x, grad_outputs=torch.ones_like(grad))[0]print(grad2)

结果为 。

综上,我们便搞清楚了它的求导机制.

补充:pytorch学习笔记:自动微分机制(backward、torch.autograd.grad) 。

神经网络通常依赖反向传播求梯度来更我络参数,求梯度过程通常是一件非常复杂而容易出错的事情.

而深度学习框架可以帮助我们自动地完成这种求梯度运算.

Pytorch一般通过反向传播 backward方法 实现这种求梯度计算。该方法求得的梯度将存在对应自变量张量的grad属性下.

除此之外,也能够调用torch.autograd.grad函数来实现求梯度计算.

这就是Pytorch的自动微分机制.

backward方法通常在一个标量张量上调用,该方法求得的梯度将存在对应自变量张量的grad属性下。如果调用的张量非标量,则要传入一个和它同形状的gradient参数张量。相当于用该gradient参数张量与调用张量作向量点乘,得到的标量结果再反向传播.

import numpy as np import torch # f(x) = a*x**2 + b*x + c的导数x = torch.tensor(0.0,requires_grad = True) # x需要被求导a = torch.tensor(1.0)b = torch.tensor(-2.0)c = torch.tensor(1.0)y = a*torch.pow(x,2) + b*x + c y.backward()dy_dx = x.gradprint(dy_dx)

输出:

tensor(-2.) 。

import numpy as np import torch # f(x) = a*x**2 + b*x + cx = torch.tensor([[0.0,0.0],[1.0,2.0]],requires_grad = True) # x需要被求导a = torch.tensor(1.0)b = torch.tensor(-2.0)c = torch.tensor(1.0)y = a*torch.pow(x,2) + b*x + c gradient = torch.tensor([[1.0,1.0],[1.0,1.0]])print("x:",x)print("y:",y)y.backward(gradient = gradient)x_grad = x.gradprint("x_grad:",x_grad)

输出:

x

tensor([[0., 0.].

[1., 2.]], requires_grad=True) 。

y

tensor([[1., 1.].

[0., 1.]], grad_fn=<AddBackward0>) 。

x_grad

tensor([[-2., -2.].

[ 0., 2.]]) 。

import numpy as np import torch # f(x) = a*x**2 + b*x + cx = torch.tensor([[0.0,0.0],[1.0,2.0]],requires_grad = True) # x需要被求导a = torch.tensor(1.0)b = torch.tensor(-2.0)c = torch.tensor(1.0)y = a*torch.pow(x,2) + b*x + c gradient = torch.tensor([[1.0,1.0],[1.0,1.0]])z = torch.sum(y*gradient)print("x:",x)print("y:",y)z.backward()x_grad = x.gradprint("x_grad:",x_grad)

输出:

x: tensor([[0., 0.].

[1., 2.]], requires_grad=True) 。

y: tensor([[1., 1.].

[0., 1.]], grad_fn=<AddBackward0>) 。

x_grad

tensor([[-2., -2.].

[ 0., 2.]]) 。

import numpy as np import torch # f(x) = a*x**2 + b*x + c的导数x = torch.tensor(0.0,requires_grad = True) # x需要被求导a = torch.tensor(1.0)b = torch.tensor(-2.0)c = torch.tensor(1.0)y = a*torch.pow(x,2) + b*x + c# create_graph 设置为 True 将允许创建更高阶的导数 dy_dx = torch.autograd.grad(y,x,create_graph=True)[0]print(dy_dx.data)# 求二阶导数dy2_dx2 = torch.autograd.grad(dy_dx,x)[0] print(dy2_dx2.data)

输出:

tensor(-2.) 。

tensor(2.) 。

import numpy as np import torch x1 = torch.tensor(1.0,requires_grad = True) # x需要被求导x2 = torch.tensor(2.0,requires_grad = True)y1 = x1*x2y2 = x1+x2# 允许同时对多个自变量求导数(dy1_dx1,dy1_dx2) = torch.autograd.grad(outputs=y1, inputs = [x1,x2],retain_graph = True)print(dy1_dx1,dy1_dx2)# 如果有多个因变量,相当于把多个因变量的梯度结果求和(dy12_dx1,dy12_dx2) = torch.autograd.grad(outputs=[y1,y2], inputs = [x1,x2])print(dy12_dx1,dy12_dx2)

输出:

tensor(2.) tensor(1.) 。

tensor(3.) tensor(2.) 。

import numpy as np import torch # f(x) = a*x**2 + b*x + c的最小值x = torch.tensor(0.0,requires_grad = True) # x需要被求导a = torch.tensor(1.0)b = torch.tensor(-2.0)c = torch.tensor(1.0)optimizer = torch.optim.SGD(params=[x],lr = 0.01)def f(x): result = a*torch.pow(x,2) + b*x + c return(result)for i in range(500): optimizer.zero_grad() y = f(x) y.backward() optimizer.step() print("y=",f(x).data,";","x=",x.data)

输出:

y= tensor(0.) ; x= tensor(1.0000) 。

以上为个人经验,希望能给大家一个参考,也希望大家多多支持我。如有错误或未考虑完全的地方,望不吝赐教.

原文链接:https://blog.csdn.net/waitingwinter/article/details/105774720 。

最后此篇关于pytorch 中autograd.grad()函数的用法说明的文章就讲到这里了,如果你想了解更多关于pytorch 中autograd.grad()函数的用法说明的内容请搜索CFSDN的文章或继续浏览相关文章,希望大家以后支持我的博客! 。

我正在查看预先重写的 jQuery 代码。我无法理解以下代码。 $('body > *:not(#print-modal):not(script)').clone(); 最佳答案 此选择器匹配以下任何

所以我开始学习MySQL,我对表有点困惑,所以我想澄清一下。数据库中可以有多个表吗?例如: Database1 -Table1 -Username -Password -Table2 -Name

我在 PostgreSQL 中编写了一个函数,其代码如下: for (i = 0; i str[0][i]); values[i] = datumCopy(dat_value,

oid: 行的对象标识符(对象 ID)。这个字段只有在创建表的时候使用了 WITH OIDS ,或者是设置了default_with_oids 配置参数时出现。 这个字段的类型是 oid (和字段同

我在搜索最大连接设备数时发现了 a post大致说: 当使用 P2P_STAR 时,最大设备数量为 10,因为此 topoly 使用 Wi-Fi 热点。也就是说,如果您没有路由器。 这让我问了两个问题

我不明白为什么会这样: Printf.sprintf "%08s" "s" = Printf.sprintf "%8s" "s" - : bool = true 换句话说,我希望: Printf.sp

我正在遵循 Grails in Action 中的示例。我有一个问题,如何理解 addTo*()功能有效。 我有一个简单的域:具有以下关系的用户、帖子、标签: 用户1对M发帖 用户一对一标签 发布 M

请问为什么行 "b[0]= new Child2();"在运行时而不是在编译时失败。请不要检查语法,我只是在这里做了 class Base {} class Child1 : Base {} clas

所以我想进一步加深我对套接字的理解,但是我想首先从最低级别开始(在C语言中,而不是在汇编中大声笑) 但是,我处理的大多数站点都使用SOCK_STREAM或SOCK_DGRAM。但是我已经阅读了Beej

好吧,我对 javascript 语法了解甚少,而且我对 null 的行为感到非常困惑。关于空值有很多讨论,但我似乎无法找出问题所在!请帮我。这是脚本。 var jsonData = '';

关闭。此题需要details or clarity 。目前不接受答案。 想要改进这个问题吗?通过 editing this post 添加详细信息并澄清问题. 已关闭5 年前。 Improve thi

问题: SeriesSum 类旨在计算以下系列的总和: 类名:SeriesSum 数据成员/实例变量: x:存储整数 n:存储术语数量 sum:用于存储系列总和的双变量 成员函数: SeriesSum

关闭。这个问题需要多问focused 。目前不接受答案。 想要改进此问题吗?更新问题,使其仅关注一个问题 editing this post . 已关闭 9 年前。 Improve this ques

今天我在 logcat 中注意到以下内容: D/OpenGLRenderer:0xa2c70600 (CardView) 上的 endAllStagingAnimators,句柄为 0xa2c9d35

如何创建值有序对的列表,例如list1 [(x, y), (x1, y1) ...].?? 学习如何创建此列表后,我需要知道如何将 x 值提供给列表中的用户输入并搜索 x 的下一个值并显示有序对 (x

我在存储过程中有以下逻辑。 这里完成了什么? 如果color为null,替换为'' IF ISNULL(@color, '') <> '' BEGIN END 最佳答案 它等同于: IF (@colo

我知道.Net中的接口(interface)定义了接口(interface)和继承它的类之间的契约。刚刚完成了一个大量使用数据访问层接口(interface)的项目,这让我开始思考。 . .有什么大不

如何防止基类方法被子类覆盖 最佳答案 您不需要做任何特别的事情:默认情况下方法是不可覆盖的。相反,如果您希望该方法可重写,则必须将 virtual 关键字添加到其声明中。 但是请注意,即使方法不可重写

我已阅读以下有关工厂模式的文章 here 请仅引用Class Registration - avoiding reflection这一部分。 这个版本在没有反射的情况下实现了工厂和具体产品之间的减少耦

我正在学习 Java 类(class),但无法完全理解下一课的内容。 目的:本课的目的是通过创建一个模拟 for-each 循环如何工作的替代方案来解释 for-each 循环的工作方式。 在上一课中

我是一名优秀的程序员,十分优秀!