- ubuntu12.04环境下使用kvm ioctl接口实现最简单的虚拟机

- Ubuntu 通过无线网络安装Ubuntu Server启动系统后连接无线网络的方法

- 在Ubuntu上搭建网桥的方法

- ubuntu 虚拟机上网方式及相关配置详解

CFSDN坚持开源创造价值,我们致力于搭建一个资源共享平台,让每一个IT人在这里找到属于你的精彩世界.

这篇CFSDN的博客文章pytorch 多个反向传播操作由作者收集整理,如果你对这篇文章有兴趣,记得点赞哟.

之前我的一篇文章pytorch 计算图以及backward,讲了一些pytorch中基本的反向传播,理清了梯度是如何计算以及下降的,建议先看懂那个,然后再看这个.

从一个错误说起:

RuntimeError: Trying to backward through the graph a second time, but the buffers have already been freed 。

在深度学习中,有些场景需要进行两次反向,比如Gan网络,需要对D进行一次,还要对G进行一次,很多人都会遇到上面这个错误,这个错误的意思就是尝试对一个计算图进行第二次反向,但是计算图已经释放了.

其实看简单点和我们之前的backward一样,当图进行了一次梯度更新,就会把一些梯度的缓存给清空,为了避免下次叠加,但在Gan这种情形下,我们必须要二次更新,那怎么办呢.

这是网上大多数给出的解决方案,在第一次反向时候加入一个l2.backward(),这样就能避免释放掉了.

上面的方案虽然解决了问题,但是并不优美,因为我们用Gan的时候,D和G两者的更新并无联系,二者的联系仅仅是D里面用到了G的输出,而这个输出一般我们都是直接拿来用的,而问题就出现在这里.

下面给一个模拟:

data = torch.randn(4,10)model1 = torch.nn.Linear(10,2)model2 = torch.nn.Linear(2,2)optimizer1 = torch.optim.Adam(model1.parameters(), lr=0.001,betas=(0.5, 0.999))optimizer2 = torch.optim.Adam(model2.parameters(), lr=0.001,betas=(0.5, 0.999))loss = torch.nn.CrossEntropyLoss()data = torch.randn(4,10)label = torch.Tensor([0,1,1,0]).long()for i in range(20): a = model1(data) b = model2(a) l1 = loss(a,label) l2 = loss(b,label) optimizer2.zero_grad() l2.backward() optimizer2.step() optimizer1.zero_grad() l1.backward() optimizer1.step()

上面定义了两个模型,而model2的输入是model1的输出,而更新的时候,二者都是各自更新自己的参数,并无联系,但是上面的代码会报一个RuntimeError: Trying to backward through the graph a second time, but the buffers have already been freed 这样的错,解决方案可以是l2.backward(retain_graph=True).

除此之外我们还可以是b = model2(a.detach()),这个就优美一点,a.detach()和a的区别你可以打印出来看一下,其实a.detach()是没有梯度的,所以相当于一个单纯的数字,和model1就脱离了联系,这样model2和model1就是完全分离开来的两个图,但是如果用的是a则model2和model1则仍然公用一个图,所以导致了错误.

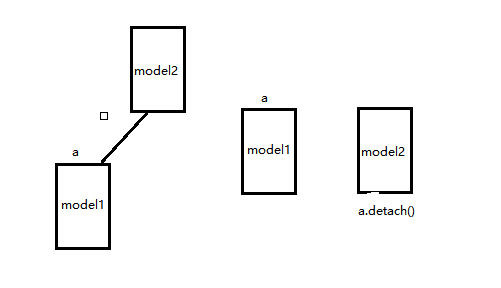

可以看下面示意图(这个是我猜测,帮助理解):

左边相当于直接用a而右边则用a.detach(),类似的在Gan网络里面D的输入可以改为G的输出y_fake.detach().

但有一点需要注意的是,两个网络一定没有需要共同更新的 ,假如上面的optimizer2 = torch.optim.Adam(itertools.chain(model1.parameters(),model2.parameters()), lr=0.001,betas=(0.5, 0.999)),则还是用retain_graph=True保险,因为.detach则model2反向不会传播到model1,导致不对model1里面参数更新.

补充:聊聊Focal Loss及其反向传播 。

我们都知道,当前的目标检测(Objece Detection)算法主要分为两大类:two-stage detector和one-stage detector。two-stage detector主要包括rcnn、fast-rcnn、faster-rcnn和rfcn等,one-stage detector主要包括yolo和ssd等,前者精度高但检测速度较慢,后者精度低些但速度很快.

对于two-stage detector而言,通常先由RPN生成proposals,再由RCNN对proposals进行Classifcation和Bounding Box Regression。这样做的一个好处是有利于样本和模型之间的feature alignment,从而使Classification和Bounding Box Regression更容易些;此外,RPN和RCNN中存在正负样本不均衡的问题,RPN直接限制正负样本的比例为1:1,对于固定的rpn_batch_size,正样本不足的情况下才用负样本来填充,RCNN则是直接限制了正负样本的比例为1:3或者采用OHEM.

对于one-stage detector而言,样本和模型之间的feature alignment只能通过reception field来实现,且直接通过回归方式进行预测,存在这严重的正负样本数据不均衡(1:1000)的问题,负样本的比例过高,占据了loss的绝大部分,且大多数是容易分类的,这使得模型的训练朝着不希望的方向前进。作者认为这种数据的严重不均衡是造成one-stage detector精度低的主要原因,因此提出Focal Loss来解决这一问题.

通过人工控制正负样本比例或者OHEM能够一定程度解决数据不均衡问题,但这两种方法都比较粗暴,采用这种“一刀切”的方式有可能把一些hard examples忽略掉。因此,作者提出了一种新的损失函数Focal Loss,不忽略任何样本,同时又能让模型训练时更加专注在hard examples上。简单说明下Focal loss的原理.

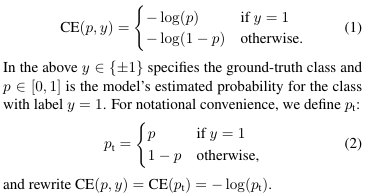

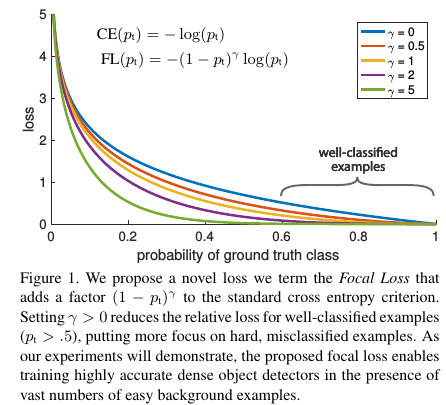

Focal Loss是在标准的交叉熵损失的基础上改进而来。以二分类为例,标准的交叉熵损失函数为 。

针对类别不均衡,针对对不同类别对loss的贡献进行控制即可,也就是加一个控制权重αt,那么改进后的balanced cross entropy loss为 。

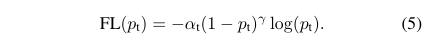

但是balanced cross entropy loss没办法让训练时专注在hard examples上。实际上,样本的正确分类概率pt越大,那么往往说明这个样本越易分。所以,最终的Focal Loss为 。

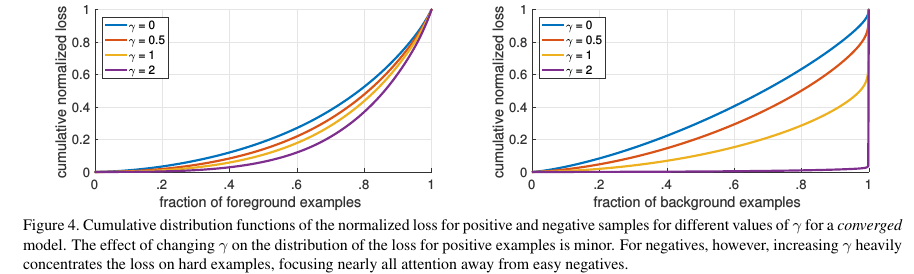

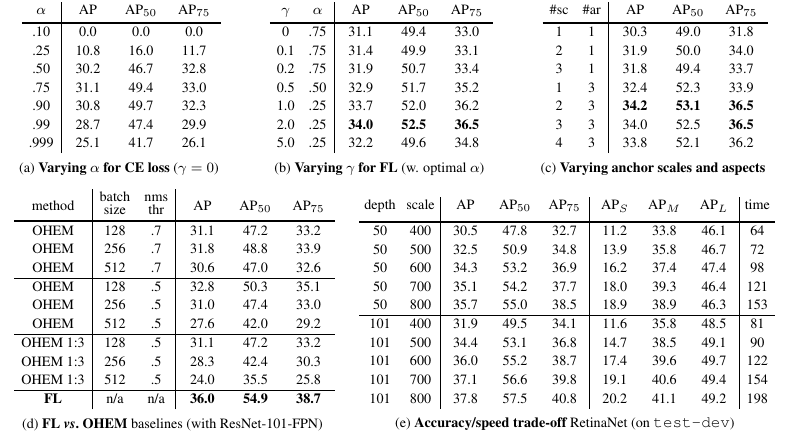

Focal Loss存在这两个超参数(hyperparameter),不同的αt和γ,对于的loss如Figure 1所示。从Figure 4, 我们可以看到γ的变化对正(forground)样本的累积误差的影响并不大,但是对于负(background)样本的累积误差的影响还是很大的(γ=2时,将近99%的background样本的损失都非常小).

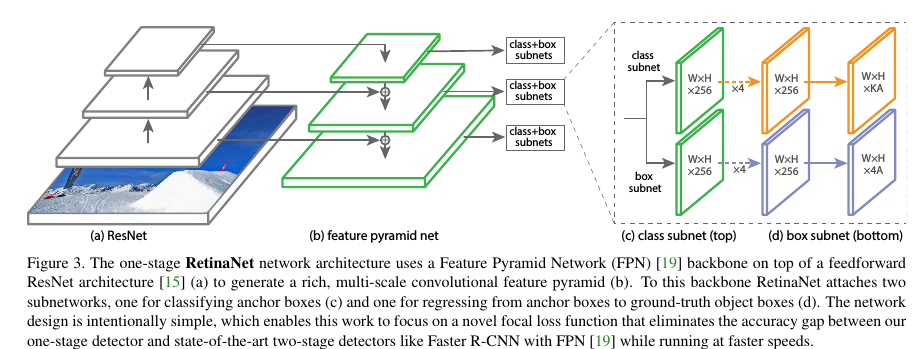

接下来看下实验结果,为了验证Focal Loss,作者提出了一种新的one-stage detector架构RetinaNet,采用的是resnet_fpn,同时scales增加到15个,如Figure 3所示 。

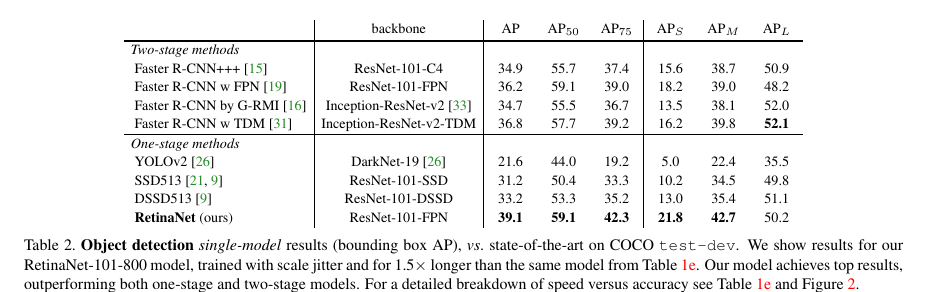

Table 1给出了RetinaNet和Focal Loss的一些实验结果,从中我们看出增加α-类别均衡,AP提高了0.9,再增加了γ控制,AP达到了37.8.Focal Local相比于OHEM,AP提高了3.2。从Table 2可以看出,增加训练时间并采用scale jitter,AP最终那达到39.1.

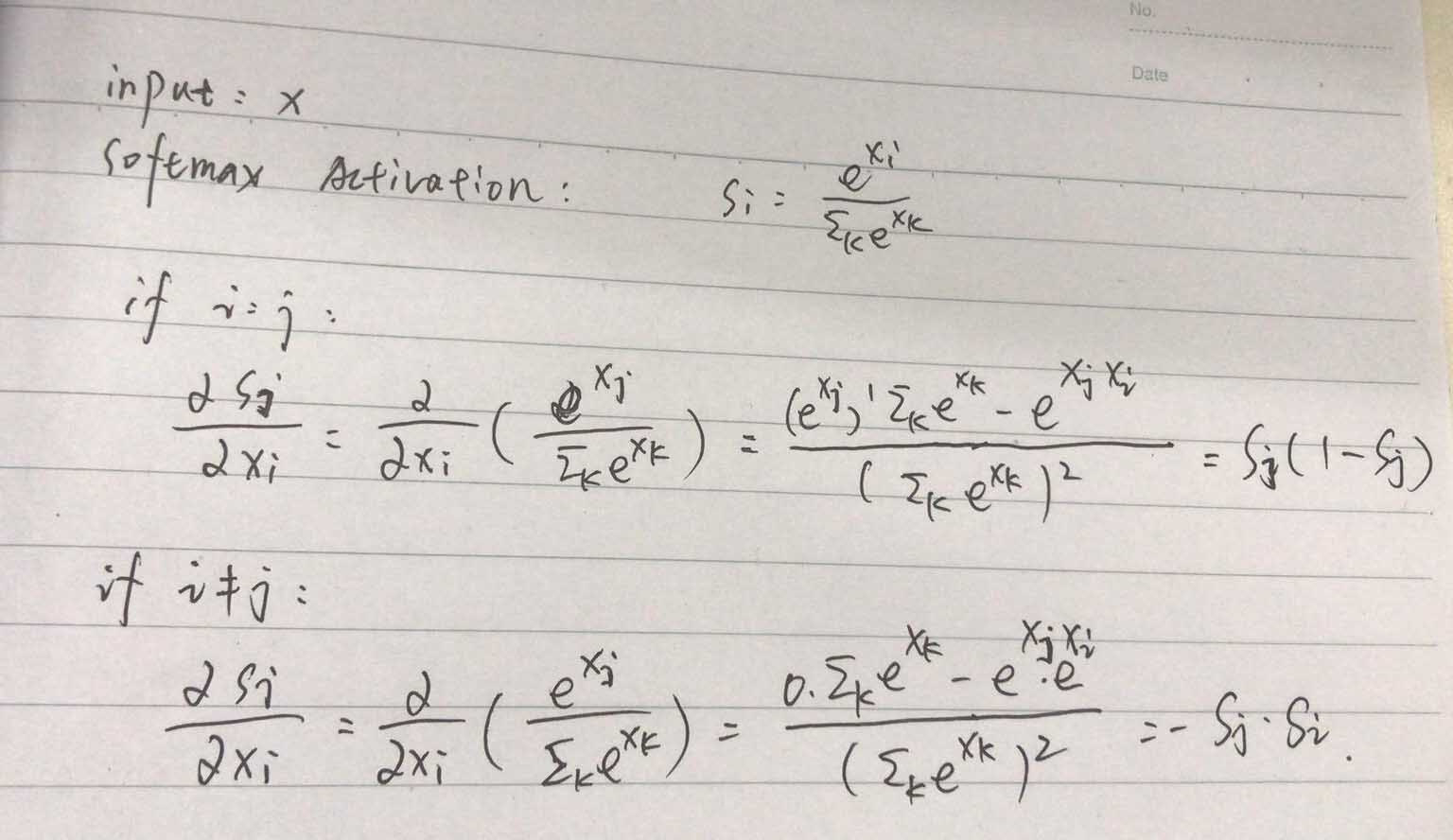

Focal Loss的原理分析和实验结果至此结束了,那么,我们接下来看下Focal Loss的反向传播。首先给出Softmax Activation的反向梯度传播公式,为 。

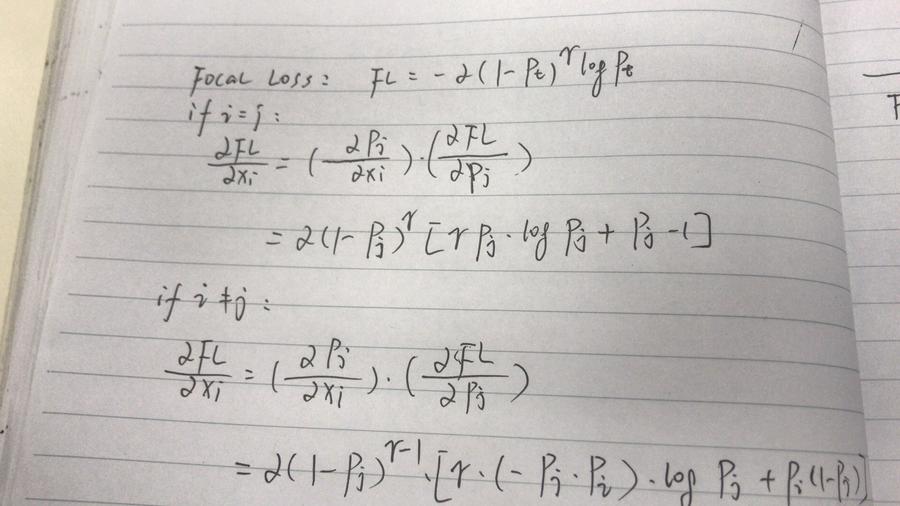

有了Softmax Activation的反向梯度传播公式,根据链式法则,Focal Loss的反向梯度传播公式为 。

Focal Loss主要用于解决数据不均衡问题,可以看做是OHEM算法的延伸。作者是将Focal Loss用于one-stage detector,但实际上这种解决数据不均衡的方法对于two-stage detector来讲同样有效.

以上为个人经验,希望能给大家一个参考,也希望大家多多支持我。如有错误或未考虑完全的地方,望不吝赐教.

原文链接:https://blog.csdn.net/qq_28888837/article/details/103651695 。

最后此篇关于pytorch 多个反向传播操作的文章就讲到这里了,如果你想了解更多关于pytorch 多个反向传播操作的内容请搜索CFSDN的文章或继续浏览相关文章,希望大家以后支持我的博客! 。

如果有人能解释这个注释的作用以及我们何时使用它: @Transactional(propagation=Propagation.REQUIRED) 谢谢 最佳答案 如果您需要在 Spring Docs

我有一个页面,它有一个 keydown 事件监听器,用于监听 Escape 键,以便返回。我还有一个简单的模态类,它也监听 Escape 键以关闭它。主页监听器检查模式是否打开,如果打开,则不执行任何

我想在模型中设置默认变量名称 T (=xx) - 将该模型拖到新模型中并在其中定义变量 xx。我收到错误消息:使用未声明的变量 xx。 这是子模型 model test parameter Rea

在 android 2.x 浏览器中查看此示例..它是在我的应用程序中复制场景的示例.. http://johnchacko.net/samples/tap.html 它是关于监听“tap”并从监听器

如您所见,我正在尝试将 GatewayConnectionFailedException 传播到我的 UI。我希望此代码捕获除异常之外的所有内容,我希望表示层捕获该异常以通知用户数据库是问题所在,以便

我目前正在尝试让可执行文件与它需要的所有依赖项正确链接。 这是依赖项的示例结构: exe -> libA -> libB exe和 libA有自己的存储库。 exe拉入libA像这样的东西: add_

有什么方法可以调用带有单个参数的 Scala 函数,给定一个数组 (类似于 JavaScript Spreads在 ECMAScript 6) 中? ys = [10.0, 2.72, -3.14]

我有一个小型静态库,它需要 boost 头文件,并且需要包含目录中的“include”目录。 ... add_library(alib STATIC ...) target_include_direc

我有一些 promise 可以返回对象。 现在我想将它们合并/扩展为一个新对象,因此我使用 Lodash's extend . var whenEverythingIsDone = Promise.a

这是我认为人们通常希望在 Scala 中做的事情,但如果我能在任何地方找到一个例子,我就该死了。 这段代码由于类型删除而无法编译,但它演示了我正在努力完成的事情: def parse[T](json:

这是我认为人们通常希望在 Scala 中做的事情,但如果我能在任何地方找到一个例子,我就该死了。 这段代码由于类型删除而无法编译,但它演示了我正在努力完成的事情: def parse[T](json:

我们有大量 MOSS 2007 站点需要添加大量的 javascript。我编辑、 checkin 、发布并批准了对 default.master 的更改,更改反射(reflect)在根网站上,但没有

请看一下下面的 fiddle :http://jsfiddle.net/K9NjY/ 我在这段代码上花了 3-4 个小时,并将其缩小到最短的版本,但现在我陷入了困境。 问题:1. 点击“divOne”

我读到如果在流程中抛出异常,框架要做的第一件事就是检查消息头中的错误 channel 属性。总是这样吗? 在我的特殊情况下,我将自定义错误 channel 分配给消息 header ,但该消息似乎已向

创建一个小的 C++ 大型精度类,一切似乎都运行良好,但是添加,如果我将 0xffffffff 和 0x04 加在一起,我会得到 0xffff0003,而我应该得到 0x0100000003。这是有问

我正在尝试重新创建 Dan Abramov 类(class)中的 Redux 示例。传播{...store.getState()}在应用程序级别不起作用,Redux 正在更改状态并且 React 不会

考虑一个需要很长时间的事务。在此期间,我想对 TableSmall 执行一些小更新。 ,它应该立即执行,并且主事务的回滚不应该回滚那些小的更新。 我当前的问题是这些小更新将锁定 TableSmall\

我需要对现有函数进行修改,具有一些 const 输入参数: int f(const owntype *r1, const owntype *r2) 为了做到这一点,我想调用一个使用相同类型但没有 co

我有一个带有 ViewModel 的 WPF UserControl: 这个 UserControl 有一个 De

我试图在收到这样的短信时不传播 public class SMSReceiver extends BroadcastReceiver { @Override public void onRec

我是一名优秀的程序员,十分优秀!