- ubuntu12.04环境下使用kvm ioctl接口实现最简单的虚拟机

- Ubuntu 通过无线网络安装Ubuntu Server启动系统后连接无线网络的方法

- 在Ubuntu上搭建网桥的方法

- ubuntu 虚拟机上网方式及相关配置详解

CFSDN坚持开源创造价值,我们致力于搭建一个资源共享平台,让每一个IT人在这里找到属于你的精彩世界.

这篇CFSDN的博客文章Python3实现爬虫爬取赶集网列表功能【基于request和BeautifulSoup模块】由作者收集整理,如果你对这篇文章有兴趣,记得点赞哟.

本文实例讲述了python3实现爬虫爬取赶集网列表功能。分享给大家供大家参考,具体如下:

python3爬虫之爬取赶集网列表。这几天一直在学习使用python3爬取数据,今天记录一下,代码很简单很容易上手.

首先需要安装python3。如果还没有安装,可参考本站前面关于python3安装与配置相关文章.

首先需要安装request和beautifulsoup两个模块 。

request是python的http网络请求模块,使用requests可以轻而易举的完成浏览器可有的任何操作 。

|

1

|

pip install requests

|

beautifulsoup是用python写的一个html/xml的解析器,它可以很好的处理不规范标记并生成剖析树 。

|

1

|

pip install beautifulsoup4

|

代码:

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

|

from

urllib

import

request

from

bs4

import

beautifulsoup

#构造头文件,模拟浏览器访问

url

=

"http://xa.ganji.com/meirdjm/o2/"

headers

=

{

'user-agent'

:

'mozilla/5.0 (windows nt 6.1; win64; x64) applewebkit/537.36 (khtml, like gecko) chrome/70.0.3538.77 safari/537.36'

}

page

=

request.request(url,headers

=

headers)

# 发送请求,获取内容

page_info

=

request.urlopen(page).read().decode(

'utf-8'

)

# 将获取到的内容转换成beautifulsoup格式,并将html.parser作为解析器

soup

=

beautifulsoup(page_info,

'html.parser'

)

# 查找所有a标签中class='list-info-title'

titles

=

soup.find_all(

'a'

,

class_

=

"list-info-title"

)

# 打印抓取到的title

for

title

in

titles:

print

(title.string)

|

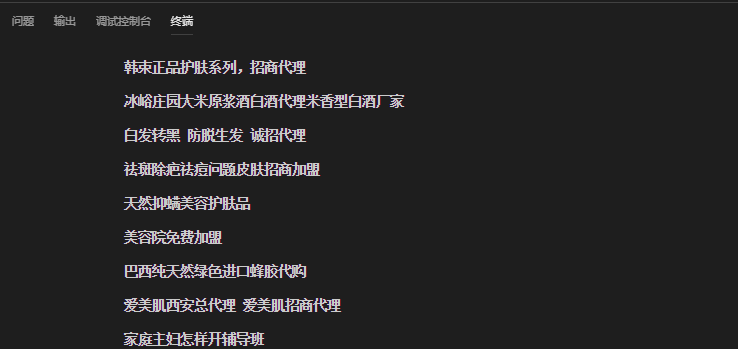

结果:

希望本文所述对大家python程序设计有所帮助.

原文链接:https://blog.csdn.net/ziwoods/article/details/84250755 。

最后此篇关于Python3实现爬虫爬取赶集网列表功能【基于request和BeautifulSoup模块】的文章就讲到这里了,如果你想了解更多关于Python3实现爬虫爬取赶集网列表功能【基于request和BeautifulSoup模块】的内容请搜索CFSDN的文章或继续浏览相关文章,希望大家以后支持我的博客! 。

如标题所示,ans_list是一个答案列表,ans_index是一个数字(答案在词汇表中的索引,但与atm无关) 这里生成的 tree.anslist 是什么? (例如,仅针对第一个),忽略迭代。 f

我目前将用户的输入存储在逗号分隔的列表中,如下所示: Userid | Options 1 | 1,2,5 用户在一个数组形式中勾选一组选项,然后用逗号连接起来 1,2,5 然后 MySQ

我目前将用户的输入存储在逗号分隔的列表中,如下所示: Userid | Options 1 | 1,2,5 用户在一个数组形式中勾选一组选项,然后用逗号连接起来 1,2,5 然后 MySQ

我想知道如何完全展平列表和包含它们的东西。除其他外,我想出了一个解决方案,它可以将具有多个元素的东西滑倒并将它们放回原处,或者在滑倒后将具有一个元素的东西拿走。 这与 How do I “flatte

我想知道如何完全展平列表和包含它们的东西。除其他外,我想出了一个解决方案,它可以将具有多个元素的东西滑倒并将它们放回原处,或者在滑倒后将带有一个元素的东西拿走。 这与 How do I “flatte

这个问题已经有答案了: Convert nested list to 2d array (3 个回答) 已关闭 7 年前。 java中有没有快捷方式可以转换 List> 到 String[][] ?

我在排序时遇到问题 List> 。我创建了一个自定义比较器,在其中编写了对数据进行排序的代码。 public class CustomComparator implements Comparator

这个问题已经有答案了: 已关闭10 年前。 Possible Duplicate: Java Generics: Cannot cast List to List? 我只是想知道为什么下面的java代

试图想出一个 LINQy 方法来做到这一点,但我什么也没想到。 我有一个对象列表<>,其中包含一个属性,该属性是逗号分隔的字母代码列表: lst[0].codes = "AA,BB,DD" lst[1

假设我有这些任务: points = [] point = (1, 2) 我怎么会这样做: points += point 它工作得很好,并且给了我点 = [1, 2]。但是,如果我这样做: poin

如何在 scala 中将 List[Task[List[Header]]] 类型转换为 Task[List[Header]]。 我有一个方法返回 Task[List[Header]] 并多次调用 do

如何在 Java 中查找二维列表的元素? 我有一个参数为 List> 的函数我想知道如何找到这个列表的行和列。 最佳答案 如果你喜欢 List> obj 然后你就可以像这样访问 obj.get(cur

分配 List到 List工作正常。 分配 List>到 List>不编译。 代码 public class Main { public static void main(String[] a

我正在用 Java 编写一个方法,该方法必须接收并迭代 Serializable 的 List。 有什么区别: public void myMethod(List list) { } 和 public

我看到很多人想用 mvvm 更新网格/列表/树的一部分,但他们不想刷新整个列表。 对于所有遇到此问题的人,我做了以下示例。 希望这对你有用。 最佳答案 这是一个简单的例子。整个代码中最重要的是: Bi

我正在为现有的 C++ 库编写包装器,该库使用列表,其中 T 是自定义结构。我被建议使用 vector 而不是列表,但我试图避免修改库。 为了更好地理解这个场景,我做了一个简单的应用程序,使用一个列表

List list List list 这两种声明有什么区别吗? 谢谢, 最佳答案 是的。 List可以包含所有派生自 Base 的不同事物的混合物. List包含同质项(从某种意义上说,它们必须全部

有人可以尽可能详细地解释以下类型之间的区别吗? List List List 让我更具体一点。我什么时候想使用 // 1 public void CanYouGiveMeAnAnswer(List l

我有一个元组列表,每个元组都是一对列表。所以我的数据看起来像: mylist = [(['foo', 'bar'], ['bar', 'bar']),(['bar', 'bar'],['bar', '

也许是一个时髦的标题,但我遇到了以下问题: 给定一个类型为 (a * b) list 的列表,我想创建一个类型为 (a * b list) list 的新列表。一个例子: 给定列表 let testL

我是一名优秀的程序员,十分优秀!