- ubuntu12.04环境下使用kvm ioctl接口实现最简单的虚拟机

- Ubuntu 通过无线网络安装Ubuntu Server启动系统后连接无线网络的方法

- 在Ubuntu上搭建网桥的方法

- ubuntu 虚拟机上网方式及相关配置详解

CFSDN坚持开源创造价值,我们致力于搭建一个资源共享平台,让每一个IT人在这里找到属于你的精彩世界.

这篇CFSDN的博客文章玩转python爬虫之cookie使用方法由作者收集整理,如果你对这篇文章有兴趣,记得点赞哟.

之前一篇文章我们学习了爬虫的异常处理问题,那么接下来我们一起来看一下Cookie的使用.

为什么要使用Cookie呢?

Cookie,指某些网站为了辨别用户身份、进行session跟踪而储存在用户本地终端上的数据(通常经过加密) 。

比如说有些网站需要登录后才能访问某个页面,在登录之前,你想抓取某个页面内容是不允许的。那么我们可以利用Urllib2库保存我们登录的Cookie,然后再抓取其他页面就达到目的了.

在此之前呢,我们必须先介绍一个opener的概念.

1.Opener 。

当你获取一个URL你使用一个opener(一个urllib2.OpenerDirector的实例)。在前面,我们都是使用的默认的opener,也就是urlopen。它是一个特殊的opener,可以理解成opener的一个特殊实例,传入的参数仅仅是url,data,timeout.

如果我们需要用到Cookie,只用这个opener是不能达到目的的,所以我们需要创建更一般的opener来实现对Cookie的设置.

2.Cookielib 。

cookielib模块的主要作用是提供可存储cookie的对象,以便于与urllib2模块配合使用来访问Internet资源。Cookielib模块非常强大,我们可以利用本模块的CookieJar类的对象来捕获cookie并在后续连接请求时重新发送,比如可以实现模拟登录功能。该模块主要的对象有CookieJar、FileCookieJar、MozillaCookieJar、LWPCookieJar.

它们的关系:CookieJar —-派生—->FileCookieJar —-派生—–>MozillaCookieJar和LWPCookieJar 。

1)获取Cookie保存到变量 首先,我们先利用CookieJar对象实现获取cookie的功能,存储到变量中,先来感受一下 。

|

1

2

3

4

5

6

7

8

9

10

11

12

13

|

import

urllib2

import

cookielib

#声明一个CookieJar对象实例来保存cookie

cookie

=

cookielib.CookieJar()

#利用urllib2库的HTTPCookieProcessor对象来创建cookie处理器

handler

=

urllib2.HTTPCookieProcessor(cookie)

#通过handler来构建opener

opener

=

urllib2.build_opener(handler)

#此处的open方法同urllib2的urlopen方法,也可以传入request

response

=

opener.

open

(

'http://www.baidu.com'

)

for

item

in

cookie:

print

'Name = '

+

item.name

print

'Value = '

+

item.value

|

我们使用以上方法将cookie保存到变量中,然后打印出了cookie中的值,运行结果如下 。

|

1

2

3

4

5

6

7

8

9

10

|

Name

=

BAIDUID

Value

=

B07B663B645729F11F659C02AAE65B4C:FG

=

1

Name

=

BAIDUPSID

Value

=

B07B663B645729F11F659C02AAE65B4C

Name

=

H_PS_PSSID

Value

=

12527_11076_1438_10633

Name

=

BDSVRTM

Value

=

0

Name

=

BD_HOME

Value

=

0

|

2)保存Cookie到文件 在上面的方法中,我们将cookie保存到了cookie这个变量中,如果我们想将cookie保存到文件中该怎么做呢?这时,我们就要用到 。

FileCookieJar这个对象了,在这里我们使用它的子类MozillaCookieJar来实现Cookie的保存 。

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

|

import

cookielib

import

urllib2

#设置保存cookie的文件,同级目录下的cookie.txt

filename

=

'cookie.txt'

#声明一个MozillaCookieJar对象实例来保存cookie,之后写入文件

cookie

=

cookielib.MozillaCookieJar(filename)

#利用urllib2库的HTTPCookieProcessor对象来创建cookie处理器

handler

=

urllib2.HTTPCookieProcessor(cookie)

#通过handler来构建opener

opener

=

urllib2.build_opener(handler)

#创建一个请求,原理同urllib2的urlopen

response

=

opener.

open

(

"http://www.baidu.com"

)

#保存cookie到文件

cookie.save(ignore_discard

=

True

, ignore_expires

=

True

)

|

关于最后save方法的两个参数在此说明一下:

官方解释如下:

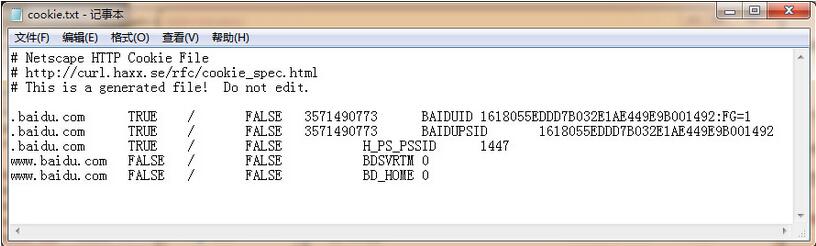

ignore_discard: save even cookies set to be discarded. ignore_expires: save even cookies that have expiredThe file is overwritten if it already exists 由此可见,ignore_discard的意思是即使cookies将被丢弃也将它保存下来,ignore_expires的意思是如果在该文件中cookies已经存在,则覆盖原文件写入,在这里,我们将这两个全部设置为True。运行之后,cookies将被保存到cookie.txt文件中,我们查看一下内容,附图如下 。

3)从文件中获取Cookie并访问 那么我们已经做到把Cookie保存到文件中了,如果以后想使用,可以利用下面的方法来读取cookie并访问网站,感受一下 。

|

1

2

3

4

5

6

7

8

9

10

11

12

13

|

import

cookielib

import

urllib2

#创建MozillaCookieJar实例对象

cookie

=

cookielib.MozillaCookieJar()

#从文件中读取cookie内容到变量

cookie.load(

'cookie.txt'

, ignore_discard

=

True

, ignore_expires

=

True

)

#创建请求的request

req

=

urllib2.Request(

"http://www.baidu.com"

)

#利用urllib2的build_opener方法创建一个opener

opener

=

urllib2.build_opener(urllib2.HTTPCookieProcessor(cookie))

response

=

opener.

open

(req)

print

response.read()

|

设想,如果我们的 cookie.txt 文件中保存的是某个人登录百度的cookie,那么我们提取出这个cookie文件内容,就可以用以上方法模拟这个人的账号登录百度.

4)利用cookie模拟网站登录 下面我们以我们学校的教育系统为例,利用cookie实现模拟登录,并将cookie信息保存到文本文件中,来感受一下cookie大法吧! 。

注意:密码我改了啊,别偷偷登录本宫的选课系统 o(╯□╰)o 。

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

|

import

urllib

import

urllib2

import

cookielib

filename

=

'cookie.txt'

#声明一个MozillaCookieJar对象实例来保存cookie,之后写入文件

cookie

=

cookielib.MozillaCookieJar(filename)

opener

=

urllib2.build_opener(urllib2.HTTPCookieProcessor(cookie))

postdata

=

urllib.urlencode({

'stuid'

:

'201200131012'

,

'pwd'

:

'23342321'

})

#登录教务系统的URL

loginUrl

=

'http://jwxt.sdu.edu.cn:7890/pls/wwwbks/bks_login2.login'

#模拟登录,并把cookie保存到变量

result

=

opener.

open

(loginUrl,postdata)

#保存cookie到cookie.txt中

cookie.save(ignore_discard

=

True

, ignore_expires

=

True

)

#利用cookie请求访问另一个网址,此网址是成绩查询网址

gradeUrl

=

'http://jwxt.sdu.edu.cn:7890/pls/wwwbks/bkscjcx.curscopre'

#请求访问成绩查询网址

result

=

opener.

open

(gradeUrl)

print

result.read()

|

以上程序的原理如下 。

创建一个带有cookie的opener,在访问登录的URL时,将登录后的cookie保存下来,然后利用这个cookie来访问其他网址.

如登录之后才能查看的成绩查询呀,本学期课表呀等等网址,模拟登录就这么实现啦,是不是很酷炫?

好,小伙伴们要加油哦!我们现在可以顺利获取网站信息了,接下来就是把网站里面有效内容提取出来,下一篇文章我们去会会正则表达式! 。

最后此篇关于玩转python爬虫之cookie使用方法的文章就讲到这里了,如果你想了解更多关于玩转python爬虫之cookie使用方法的内容请搜索CFSDN的文章或继续浏览相关文章,希望大家以后支持我的博客! 。

在我的主要组件中,我有: mounted() { window.$cookie.set('cookie_name', userName, expiringTime); }, 这会产生以下错误:

我正在学习 cookie,并且我想知道在编写依赖 cookie 来存储状态的 Web 应用程序时浏览器的支持情况。 对于每个域/网站,可以向浏览器发送多少个 Cookie,大小是多少? 如果发送并存储

我已经为我的站点设置了一个 cdn,并将其用于 css、js 和图像。 网站只提供那些文件 我的问题是 firefox 中的页面速度插件对于我的图片请求,我看到了一个 cookie Cookie fc

在阅读了 Internet 上的文档和帖子后,我仍然无法解决 jMeter 中的 Cookie Manager 问题。 我在响应头中得到了 sid ID,但它没有存储在我的 cookie 管理器中。

我正在 Node.JS 中处理一些类似浏览器的 cookie 处理,想知道从 NodeJS and HTTP Client - Are cookies supported? 开始对这段代码进行扩展到什

我正在此堆栈上构建自托管 Web 服务器:欧文南希网络 API 2 我正在使用 Katana 的 Microsoft.Owin.Security.Cookies 进行类似表单的身份验证。我得到了 Se

我有一个从另一个网站加载资源的网站。我已经能够确定: 第三方网站在用户的浏览器上放置 cookie。 如果我在浏览器设置中禁用第三方 cookie,第三方网站将无法再在浏览器上放置 cookie。 该

关闭。这个问题是off-topic .它目前不接受答案。 想改善这个问题吗? Update the question所以它是 on-topic对于堆栈溢出。 9年前关闭。 Improve this q

我正在使用 python mechanize 制作登录脚本。我已经读到 Mechanize 的 Browser() 对象将自动处理 cookie 以供进一步请求。 我怎样才能使这个 cookie 持久

我正在尝试在 www.example.com 和 admin.other.example.com 之间共享 cookie 我已经能够使其与 other.example.com 一起使用,但是无法访问子

我设置了一个域为 .example.com 的 cookie .它适用于我网站上的每个一级子域,应该如此。 但是,它不适用于 n 级子域,即 sub.subdomain.example.com和 to

我想让用户尽可能长时间地登录。 我应该使用什么? 普通 cookies 持久性 cookie 快闪 cookies ip地址 session 或这些的某种组合? 最佳答案 我认为 Flash cook

如果给定的 Web 服务器只能读取其域内设置的 cookie,那么 Internet 广告商如何从其网络外的网站跟踪用户的 Web 流量? 是否存在某种“supercookie”全局广告系统,允许广告

我知道一个 cookie 可以容纳多少数据是有限制的,但是我们可以设置多少个 cookie 有限制吗? 最佳答案 来自 http://www.ietf.org/rfc/rfc2109.txt Prac

如果我拒绝创建 cookie,则在我的浏览器中创建名称为 __utma、__utmb 等的 cookie。我认为这个 cookie 是用于谷歌分析的。任何人都知道谷歌如何创建这个 cookie,即使浏

我有一个生产环境和一个登台环境。我想知道我是否可以在环境之间沙箱 cookie。我的设置看起来像 生产 domain.com - 前端 SPA api.domain.com - 后端节点 分期 sta

我想知道浏览器(即 Firefox )和网站的交互。 当我将用户名和密码提交到登录表单时,会发生什么? 我认为该网站向我发送了一些 cookie,并通过检查这些 cookie 来授权我。 cookie

我在两个不同的域中有两个网络应用程序 WebApp1 和 WebApp2。 我在 HttpResponse 的 WebApp1 中设置 cookie。 如何从 WebApp2 中的 HttpReque

我正在使用Dartium“Version 34.0.1847.0 aura(264987)”,并从Dart创建一个websocket。但是,如果不是httpOnly,我的安全 session cook

我从 Headfirst Javascript 书中获取了用于 cookie 的代码。但由于某种原因,它不适用于我的浏览器。我主要使用chrome和ff,并且我在chrome中启用了本地cookie。

我是一名优秀的程序员,十分优秀!