- ubuntu12.04环境下使用kvm ioctl接口实现最简单的虚拟机

- Ubuntu 通过无线网络安装Ubuntu Server启动系统后连接无线网络的方法

- 在Ubuntu上搭建网桥的方法

- ubuntu 虚拟机上网方式及相关配置详解

CFSDN坚持开源创造价值,我们致力于搭建一个资源共享平台,让每一个IT人在这里找到属于你的精彩世界.

这篇CFSDN的博客文章python3.4.3下逐行读入txt文本并去重的方法由作者收集整理,如果你对这篇文章有兴趣,记得点赞哟.

读写文件时应注意的问题包括:

1.字符编码 。

2.操作完成即时关闭文件描述符 。

3.代码兼容性 。

几种方法:

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

|

#!/bin/python3

original_list1

=

[

" "

]

original_list2

=

[

" "

]

original_list3

=

[

" "

]

original_list4

=

[

" "

]

newlist1

=

[

" "

]

newlist2

=

[

" "

]

newlist3

=

[

" "

]

newlist4

=

[

" "

]

newtxt1

=

""

newtxt2

=

""

newtxt3

=

""

newtxt4

=

""

#first way to readline

f

=

open

(

"duplicate_txt.txt"

,

"r+"

)

# 返回一个文件对象

line

=

f.readline()

# 调用文件的 readline()方法

while

line:

original_list1.append(line)

line

=

f.readline()

f.close()

#use "set()" remove duplicate str in the list

# in this way,list will sort randomly

newlist1

=

list

(

set

(original_list1))

#newlist1 = {}.fromkeys(original_list1).keys() #faster

#rebuild a new txt

newtxt1

=

"".join(newlist1)

f1

=

open

(

"noduplicate1.txt"

,

"w"

)

f1.write(newtxt1)

f1.close()

###################################################################

#second way to readline

for

line

in

open

(

"duplicate_txt.txt"

,

"r+"

):

original_list2.append(line)

newlist2

=

list

(

set

(original_list2))

newlist2.sort(key

=

original_list2.index)

#sort

#newlist2 = sorted(set(original_list2),key=l1.index) #other way

newtxt2

=

"".join(newlist2)

f2

=

open

(

"noduplicate2.txt"

,

"w"

)

f2.write(newtxt2)

f2.close()

###################################################################

#third way to readline

f3

=

open

(

"duplicate_txt.txt"

,

"r"

)

original_list3

=

f3.readlines()

#读取全部内容 ,并以列表方式返回

for

i

in

original_list3:

#遍历去重

if

not

i

in

newlist3:

newlist3.append(i)

newtxt3

=

"".join(newlist3)

f4

=

open

(

"noduplicate3.txt"

,

"w"

)

f4.write(newtxt3)

f4.close()

###################################################################

#fourth way

f5

=

open

(

'duplicate_txt.txt'

,

"r+"

)

try

:

original_list4

=

f5.readlines()

[newlist4.append(i)

for

i

in

original_list4

if

not

i

in

newlist4]

newtxt4

=

"".join(newlist4)

f6

=

open

(

"noduplicate4.txt"

,

"w"

)

f6.write(newtxt4)

f6.close()

finally

:

f5.close()

|

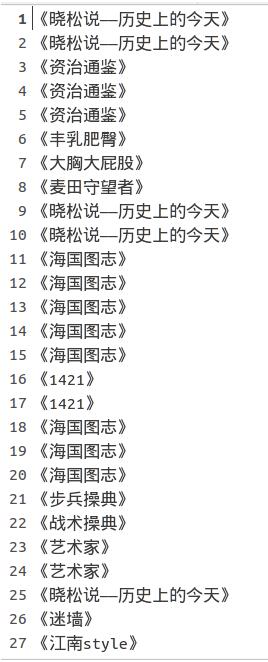

结果:

去重前:

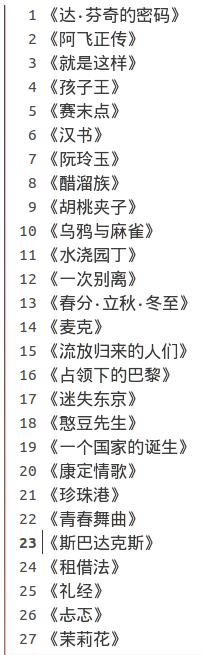

去重后(无序):

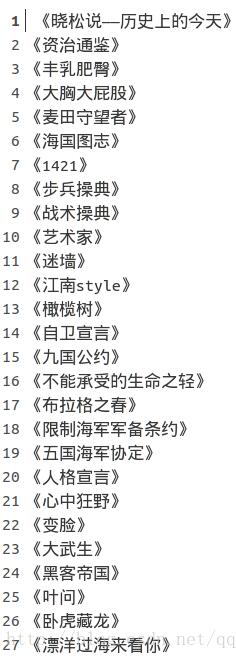

去重后(有序):

总结 。

这段下程序涉及文件读写操作以及链表list的操作,文章开头提到的几个问题,由于并没有使用中文,所以不关心编码,但这里还是要提一提

|

1

2

|

f

=

open

(

"test.txt"

,

"w"

)

f.write(u

"你好"

)

|

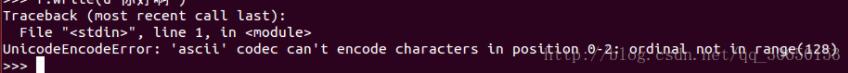

上面这段代码如果在python2中运行会报错 。

报错是因为程序没办法直接保存unicode字符串,要经过编码转换成str类型的二进制字节序列才可以保存.

write()方法会自动编码转换,默认使用ascii编码格式,而ascii不能处理中文,所以出现unicodeencodeerror.

正确方式是在调用write()方法前,手动格式转换,用utf-8或者gbk转换成str.

|

1

2

3

4

|

f

=

open

(

"test.txt"

,

"w"

)

text

=

u

"你好"

text

=

text.encode(encoding

=

'utf-8'

)

f.write(text)

|

关于close()问题

不关闭会有什么影响呢?操作完成后,不关闭文件,会对系统资源造成浪费,因为系统可打开的文件描述符数量是有限的。linux是65535.

一般来说close之后就ok了,但是也会存在特殊情况,比如说,在调用open()函数时就已经发生错误,权限不足,调用close()肯定报错。还有一种是在write()时,如果磁盘空间不足,报错,close()就没有机会执行了。正确的做法就是使用 try except 对异常进行捕获:

|

1

2

3

4

5

6

7

8

9

|

f

=

open

(

"test.txt"

,

"w"

)

try

:

text

=

u

"你好"

text

=

text.encode(encoding

=

'utf-8'

)

f.write(text)

except

: ioerror as e:

print

(

"oops,%s"

%

e.args[

0

])

finally

:

f.close()

|

更优雅的写法是用 with…as.

|

1

2

3

|

with

open

(

"test.txt"

,

"w"

) as f:

text

=

u

"你好"

f.write(text.encode(encoding

=

'utf-8'

))

|

文件对象实现上下午管理器协议,程序进入with语句时,会把文件对象赋值给变量f,在程序退出with时会自动的调用close()方法.

关于兼容性问题

python2和python3的open()函数是不一样的,后者可以在函数中指定字符编码格式.

如何解决python2和python3的兼容open()问题呢?

使用io模块下的open()函数,python2中的io.open等价与python3的open函数 。

|

1

2

3

|

from

io

import

open

with

open

(

"test.txt"

,

"w"

,encoding

=

'utf-8'

) as f:

f.write(u

"你好"

)

|

以上这篇python3.4.3下逐行读入txt文本并去重的方法就是小编分享给大家的全部内容了,希望能给大家一个参考,也希望大家多多支持我.

原文链接:https://blog.csdn.net/qq_30650153/article/details/77894942 。

最后此篇关于python3.4.3下逐行读入txt文本并去重的方法的文章就讲到这里了,如果你想了解更多关于python3.4.3下逐行读入txt文本并去重的方法的内容请搜索CFSDN的文章或继续浏览相关文章,希望大家以后支持我的博客! 。

我正在处理一组标记为 160 个组的 173k 点。我想通过合并最接近的(到 9 或 10 个组)来减少组/集群的数量。我搜索过 sklearn 或类似的库,但没有成功。 我猜它只是通过 knn 聚类

我有一个扁平数字列表,这些数字逻辑上以 3 为一组,其中每个三元组是 (number, __ignored, flag[0 or 1]),例如: [7,56,1, 8,0,0, 2,0,0, 6,1,

我正在使用 pipenv 来管理我的包。我想编写一个 python 脚本来调用另一个使用不同虚拟环境(VE)的 python 脚本。 如何运行使用 VE1 的 python 脚本 1 并调用另一个 p

假设我有一个文件 script.py 位于 path = "foo/bar/script.py"。我正在寻找一种在 Python 中通过函数 execute_script() 从我的主要 Python

这听起来像是谜语或笑话,但实际上我还没有找到这个问题的答案。 问题到底是什么? 我想运行 2 个脚本。在第一个脚本中,我调用另一个脚本,但我希望它们继续并行,而不是在两个单独的线程中。主要是我不希望第

我有一个带有 python 2.5.5 的软件。我想发送一个命令,该命令将在 python 2.7.5 中启动一个脚本,然后继续执行该脚本。 我试过用 #!python2.7.5 和http://re

我在 python 命令行(使用 python 2.7)中,并尝试运行 Python 脚本。我的操作系统是 Windows 7。我已将我的目录设置为包含我所有脚本的文件夹,使用: os.chdir("

剧透:部分解决(见最后)。 以下是使用 Python 嵌入的代码示例: #include int main(int argc, char** argv) { Py_SetPythonHome

假设我有以下列表,对应于及时的股票价格: prices = [1, 3, 7, 10, 9, 8, 5, 3, 6, 8, 12, 9, 6, 10, 13, 8, 4, 11] 我想确定以下总体上最

所以我试图在选择某个单选按钮时更改此框架的背景。 我的框架位于一个类中,并且单选按钮的功能位于该类之外。 (这样我就可以在所有其他框架上调用它们。) 问题是每当我选择单选按钮时都会出现以下错误: co

我正在尝试将字符串与 python 中的正则表达式进行比较,如下所示, #!/usr/bin/env python3 import re str1 = "Expecting property name

考虑以下原型(prototype) Boost.Python 模块,该模块从单独的 C++ 头文件中引入类“D”。 /* file: a/b.cpp */ BOOST_PYTHON_MODULE(c)

如何编写一个程序来“识别函数调用的行号?” python 检查模块提供了定位行号的选项,但是, def di(): return inspect.currentframe().f_back.f_l

我已经使用 macports 安装了 Python 2.7,并且由于我的 $PATH 变量,这就是我输入 $ python 时得到的变量。然而,virtualenv 默认使用 Python 2.6,除

我只想问如何加快 python 上的 re.search 速度。 我有一个很长的字符串行,长度为 176861(即带有一些符号的字母数字字符),我使用此函数测试了该行以进行研究: def getExe

list1= [u'%app%%General%%Council%', u'%people%', u'%people%%Regional%%Council%%Mandate%', u'%ppp%%Ge

这个问题在这里已经有了答案: Is it Pythonic to use list comprehensions for just side effects? (7 个答案) 关闭 4 个月前。 告

我想用 Python 将两个列表组合成一个列表,方法如下: a = [1,1,1,2,2,2,3,3,3,3] b= ["Sun", "is", "bright", "June","and" ,"Ju

我正在运行带有最新 Boost 发行版 (1.55.0) 的 Mac OS X 10.8.4 (Darwin 12.4.0)。我正在按照说明 here构建包含在我的发行版中的教程 Boost-Pyth

学习 Python,我正在尝试制作一个没有任何第 3 方库的网络抓取工具,这样过程对我来说并没有简化,而且我知道我在做什么。我浏览了一些在线资源,但所有这些都让我对某些事情感到困惑。 html 看起来

我是一名优秀的程序员,十分优秀!