- ubuntu12.04环境下使用kvm ioctl接口实现最简单的虚拟机

- Ubuntu 通过无线网络安装Ubuntu Server启动系统后连接无线网络的方法

- 在Ubuntu上搭建网桥的方法

- ubuntu 虚拟机上网方式及相关配置详解

CFSDN坚持开源创造价值,我们致力于搭建一个资源共享平台,让每一个IT人在这里找到属于你的精彩世界.

这篇CFSDN的博客文章python实现梯度下降算法由作者收集整理,如果你对这篇文章有兴趣,记得点赞哟.

梯度下降(gradient descent)算法是机器学习中使用非常广泛的优化算法。当前流行的机器学习库或者深度学习库都会包括梯度下降算法的不同变种实现.

本文主要以线性回归算法损失函数求极小值来说明如何使用梯度下降算法并给出python实现。若有不正确的地方,希望读者能指出。 。

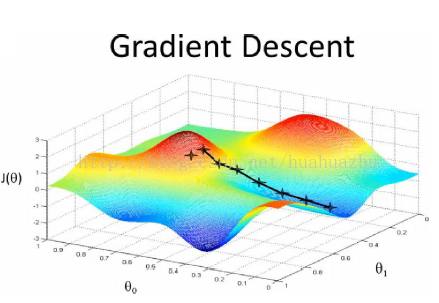

梯度下降 。

梯度下降原理:将函数比作一座山,我们站在某个山坡上,往四周看,从哪个方向向下走一小步,能够下降的最快.

在线性回归算法中,损失函数为 。

在求极小值时,在数据量很小的时候,可以使用矩阵求逆的方式求最优的θ值。但当数据量和特征值非常大,例如几万甚至上亿时,使用矩阵求逆根本就不现实。而梯度下降法就是很好的一个选择了.

使用梯度下降算法的步骤:

1)对θ赋初始值,这个值可以是随机的,也可以让θ是一个全零的向量.

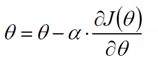

2)改变θ的值,使得目标损失函数j(θ)按梯度下降的方向进行减少.

其中为学习率或步长,需要人为指定,若过大会导致震荡即不收敛,若过小收敛速度会很慢.

3)当下降的高度小于某个定义的值,则停止下降.

另外,对上面线性回归算法损失函数求梯度,结果如下:

在实际应用的过程中,梯度下降算法有三类,它们不同之处在于每次学习(更新模型参数)使用的样本个数,每次更新使用不同的样本会导致每次学习的准确性和学习时间不同。下面将分别介绍原理及python实现.

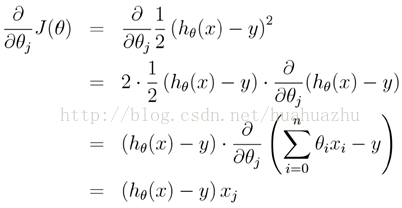

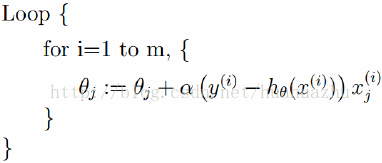

批量梯度下降(batch gradient descent) 。

每次使用全量的训练集样本来更新模型参数,即给定一个步长,然后对所有的样本的梯度的和进行迭代: 。

梯度下降算法最终得到的是局部极小值。而线性回归的损失函数为凸函数,有且只有一个局部最小,则这个局部最小一定是全局最小。所以线性回归中使用批量梯度下降算法,一定可以找到一个全局最优解.

优点:全局最优解;易于并行实现;总体迭代次数不多 缺点:当样本数目很多时,训练过程会很慢,每次迭代需要耗费大量的时间.

随机梯度下降(stochastic gradient descent) 。

随机梯度下降算法每次从训练集中随机选择一个样本来进行迭代,即:

随机梯度下降算法每次只随机选择一个样本来更新模型参数,因此每次的学习是非常快速的,并且可以进行在线更新。 。

随机梯度下降最大的缺点在于每次更新可能并不会按照正确的方向进行,因此可以带来优化波动(扰动)。不过从另一个方面来看,随机梯度下降所带来的波动有个好处就是,对于类似盆地区域(即很多局部极小值点)那么这个波动的特点可能会使得优化的方向从当前的局部极小值点跳到另一个更好的局部极小值点,这样便可能对于非凸函数,最终收敛于一个较好的局部极值点,甚至全局极值点。 。

优点:训练速度快,每次迭代计算量不大 缺点:准确度下降,并不是全局最优;不易于并行实现;总体迭代次数比较多.

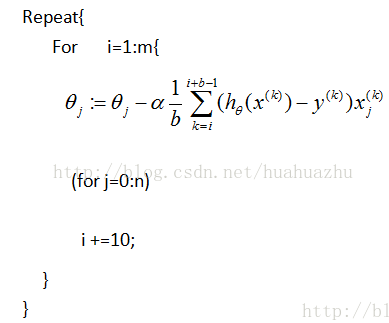

mini-batch梯度下降算法 。

mini-batch梯度下降综合了batch梯度下降与stochastic梯度下降,在每次更新速度与更新次数中间取得一个平衡,其每次更新从训练集中随机选择b,b<m个样本进行学习,即:

python代码实现 。

批量梯度下降算法 。

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

|

#!/usr/bin/python

#coding=utf-8

import

numpy as np

from

scipy

import

stats

import

matplotlib.pyplot as plt

# 构造训练数据

x

=

np.arange(

0.

,

10.

,

0.2

)

m

=

len

(x)

# 训练数据点数目

print

m

x0

=

np.full(m,

1.0

)

input_data

=

np.vstack([x0, x]).t

# 将偏置b作为权向量的第一个分量

target_data

=

2

*

x

+

5

+

np.random.randn(m)

# 两种终止条件

loop_max

=

10000

# 最大迭代次数(防止死循环)

epsilon

=

1e

-

3

# 初始化权值

np.random.seed(

0

)

theta

=

np.random.randn(

2

)

alpha

=

0.001

# 步长(注意取值过大会导致振荡即不收敛,过小收敛速度变慢)

diff

=

0.

error

=

np.zeros(

2

)

count

=

0

# 循环次数

finish

=

0

# 终止标志

while

count < loop_max:

count

+

=

1

# 标准梯度下降是在权值更新前对所有样例汇总误差,而随机梯度下降的权值是通过考查某个训练样例来更新的

# 在标准梯度下降中,权值更新的每一步对多个样例求和,需要更多的计算

sum_m

=

np.zeros(

2

)

for

i

in

range

(m):

dif

=

(np.dot(theta, input_data[i])

-

target_data[i])

*

input_data[i]

sum_m

=

sum_m

+

dif

# 当alpha取值过大时,sum_m会在迭代过程中会溢出

theta

=

theta

-

alpha

*

sum_m

# 注意步长alpha的取值,过大会导致振荡

# theta = theta - 0.005 * sum_m # alpha取0.005时产生振荡,需要将alpha调小

# 判断是否已收敛

if

np.linalg.norm(theta

-

error) < epsilon:

finish

=

1

break

else

:

error

=

theta

print

'loop count = %d'

%

count,

'\tw:'

,theta

print

'loop count = %d'

%

count,

'\tw:'

,theta

# check with scipy linear regression

slope, intercept, r_value, p_value, slope_std_error

=

stats.linregress(x, target_data)

print

'intercept = %s slope = %s'

%

(intercept, slope)

plt.plot(x, target_data,

'g*'

)

plt.plot(x, theta[

1

]

*

x

+

theta[

0

],

'r'

)

plt.show()

|

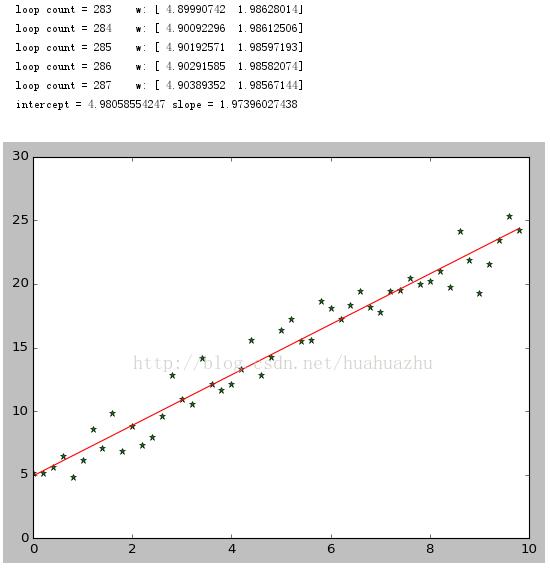

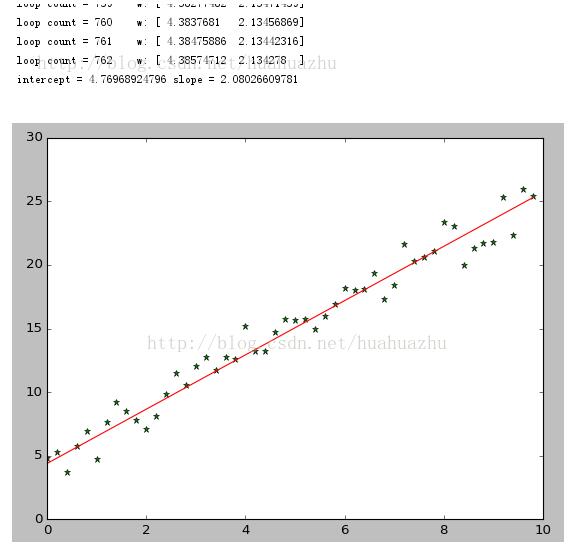

运行结果截图:

随机梯度下降算法 。

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

|

#!/usr/bin/python

#coding=utf-8

import

numpy as np

from

scipy

import

stats

import

matplotlib.pyplot as plt

# 构造训练数据

x

=

np.arange(

0.

,

10.

,

0.2

)

m

=

len

(x)

# 训练数据点数目

x0

=

np.full(m,

1.0

)

input_data

=

np.vstack([x0, x]).t

# 将偏置b作为权向量的第一个分量

target_data

=

2

*

x

+

5

+

np.random.randn(m)

# 两种终止条件

loop_max

=

10000

# 最大迭代次数(防止死循环)

epsilon

=

1e

-

3

# 初始化权值

np.random.seed(

0

)

theta

=

np.random.randn(

2

)

# w = np.zeros(2)

alpha

=

0.001

# 步长(注意取值过大会导致振荡,过小收敛速度变慢)

diff

=

0.

error

=

np.zeros(

2

)

count

=

0

# 循环次数

finish

=

0

# 终止标志

######-随机梯度下降算法

while

count < loop_max:

count

+

=

1

# 遍历训练数据集,不断更新权值

for

i

in

range

(m):

diff

=

np.dot(theta, input_data[i])

-

target_data[i]

# 训练集代入,计算误差值

# 采用随机梯度下降算法,更新一次权值只使用一组训练数据

theta

=

theta

-

alpha

*

diff

*

input_data[i]

# ------------------------------终止条件判断-----------------------------------------

# 若没终止,则继续读取样本进行处理,如果所有样本都读取完毕了,则循环重新从头开始读取样本进行处理。

# ----------------------------------终止条件判断-----------------------------------------

# 注意:有多种迭代终止条件,和判断语句的位置。终止判断可以放在权值向量更新一次后,也可以放在更新m次后。

if

np.linalg.norm(theta

-

error) < epsilon:

# 终止条件:前后两次计算出的权向量的绝对误差充分小

finish

=

1

break

else

:

error

=

theta

print

'loop count = %d'

%

count,

'\tw:'

,theta

# check with scipy linear regression

slope, intercept, r_value, p_value, slope_std_error

=

stats.linregress(x, target_data)

print

'intercept = %s slope = %s'

%

(intercept, slope)

plt.plot(x, target_data,

'g*'

)

plt.plot(x, theta[

1

]

*

x

+

theta[

0

],

'r'

)

plt.show()

|

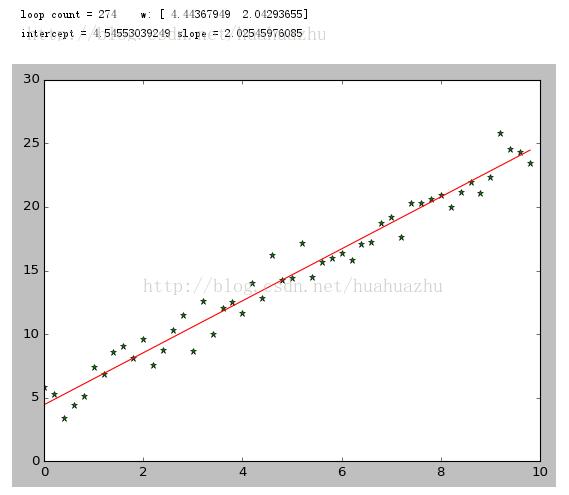

运行结果截图:

mini-batch梯度下降 。

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

|

#!/usr/bin/python

#coding=utf-8

import

numpy as np

from

scipy importstats

import

matplotlib.pyplot as plt

# 构造训练数据

x

=

np.arange(

0.

,

10.

,

0.2

)

m

=

len

(x)

# 训练数据点数目

print

m

x0

=

np.full(m,

1.0

)

input_data

=

np.vstack([x0, x]).t

# 将偏置b作为权向量的第一个分量

target_data

=

2

*

x

+

5

+

np.random.randn(m)

# 两种终止条件

loop_max

=

10000

#最大迭代次数(防止死循环)

epsilon

=

1e

-

3

# 初始化权值

np.random.seed(

0

)

theta

=

np.random.randn(

2

)

alpha

=

0.001

#步长(注意取值过大会导致振荡即不收敛,过小收敛速度变慢)

diff

=

0.

error

=

np.zeros(

2

)

count

=

0

#循环次数

finish

=

0

#终止标志

minibatch_size

=

5

#每次更新的样本数

while

count < loop_max:

count

+

=

1

# minibatch梯度下降是在权值更新前对所有样例汇总误差,而随机梯度下降的权值是通过考查某个训练样例来更新的

# 在minibatch梯度下降中,权值更新的每一步对多个样例求和,需要更多的计算

for

i inrange(

1

,m,minibatch_size):

sum_m

=

np.zeros(

2

)

for

k inrange(i

-

1

,i

+

minibatch_size

-

1

,

1

):

dif

=

(np.dot(theta, input_data[k])

-

target_data[k])

*

input_data[k]

sum_m

=

sum_m

+

dif

#当alpha取值过大时,sum_m会在迭代过程中会溢出

theta

=

theta

-

alpha

*

(

1.0

/

minibatch_size)

*

sum_m

#注意步长alpha的取值,过大会导致振荡

# 判断是否已收敛

if

np.linalg.norm(theta

-

error) < epsilon:

finish

=

1

break

else

:

error

=

theta

print

'loopcount = %d'

%

count,

'\tw:'

,theta

print

'loop count = %d'

%

count,

'\tw:'

,theta

# check with scipy linear regression

slope, intercept, r_value, p_value,slope_std_error

=

stats.linregress(x, target_data)

print

'intercept = %s slope = %s'

%

(intercept, slope)

plt.plot(x, target_data,

'g*'

)

plt.plot(x, theta[

1

]

*

x

+

theta[

0

],

'r'

)

plt.show()

|

运行结果:

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持我.

原文链接:https://blog.csdn.net/huahuazhu/article/details/73385362 。

最后此篇关于python实现梯度下降算法的文章就讲到这里了,如果你想了解更多关于python实现梯度下降算法的内容请搜索CFSDN的文章或继续浏览相关文章,希望大家以后支持我的博客! 。

我正在处理一组标记为 160 个组的 173k 点。我想通过合并最接近的(到 9 或 10 个组)来减少组/集群的数量。我搜索过 sklearn 或类似的库,但没有成功。 我猜它只是通过 knn 聚类

我有一个扁平数字列表,这些数字逻辑上以 3 为一组,其中每个三元组是 (number, __ignored, flag[0 or 1]),例如: [7,56,1, 8,0,0, 2,0,0, 6,1,

我正在使用 pipenv 来管理我的包。我想编写一个 python 脚本来调用另一个使用不同虚拟环境(VE)的 python 脚本。 如何运行使用 VE1 的 python 脚本 1 并调用另一个 p

假设我有一个文件 script.py 位于 path = "foo/bar/script.py"。我正在寻找一种在 Python 中通过函数 execute_script() 从我的主要 Python

这听起来像是谜语或笑话,但实际上我还没有找到这个问题的答案。 问题到底是什么? 我想运行 2 个脚本。在第一个脚本中,我调用另一个脚本,但我希望它们继续并行,而不是在两个单独的线程中。主要是我不希望第

我有一个带有 python 2.5.5 的软件。我想发送一个命令,该命令将在 python 2.7.5 中启动一个脚本,然后继续执行该脚本。 我试过用 #!python2.7.5 和http://re

我在 python 命令行(使用 python 2.7)中,并尝试运行 Python 脚本。我的操作系统是 Windows 7。我已将我的目录设置为包含我所有脚本的文件夹,使用: os.chdir("

剧透:部分解决(见最后)。 以下是使用 Python 嵌入的代码示例: #include int main(int argc, char** argv) { Py_SetPythonHome

假设我有以下列表,对应于及时的股票价格: prices = [1, 3, 7, 10, 9, 8, 5, 3, 6, 8, 12, 9, 6, 10, 13, 8, 4, 11] 我想确定以下总体上最

所以我试图在选择某个单选按钮时更改此框架的背景。 我的框架位于一个类中,并且单选按钮的功能位于该类之外。 (这样我就可以在所有其他框架上调用它们。) 问题是每当我选择单选按钮时都会出现以下错误: co

我正在尝试将字符串与 python 中的正则表达式进行比较,如下所示, #!/usr/bin/env python3 import re str1 = "Expecting property name

考虑以下原型(prototype) Boost.Python 模块,该模块从单独的 C++ 头文件中引入类“D”。 /* file: a/b.cpp */ BOOST_PYTHON_MODULE(c)

如何编写一个程序来“识别函数调用的行号?” python 检查模块提供了定位行号的选项,但是, def di(): return inspect.currentframe().f_back.f_l

我已经使用 macports 安装了 Python 2.7,并且由于我的 $PATH 变量,这就是我输入 $ python 时得到的变量。然而,virtualenv 默认使用 Python 2.6,除

我只想问如何加快 python 上的 re.search 速度。 我有一个很长的字符串行,长度为 176861(即带有一些符号的字母数字字符),我使用此函数测试了该行以进行研究: def getExe

list1= [u'%app%%General%%Council%', u'%people%', u'%people%%Regional%%Council%%Mandate%', u'%ppp%%Ge

这个问题在这里已经有了答案: Is it Pythonic to use list comprehensions for just side effects? (7 个答案) 关闭 4 个月前。 告

我想用 Python 将两个列表组合成一个列表,方法如下: a = [1,1,1,2,2,2,3,3,3,3] b= ["Sun", "is", "bright", "June","and" ,"Ju

我正在运行带有最新 Boost 发行版 (1.55.0) 的 Mac OS X 10.8.4 (Darwin 12.4.0)。我正在按照说明 here构建包含在我的发行版中的教程 Boost-Pyth

学习 Python,我正在尝试制作一个没有任何第 3 方库的网络抓取工具,这样过程对我来说并没有简化,而且我知道我在做什么。我浏览了一些在线资源,但所有这些都让我对某些事情感到困惑。 html 看起来

我是一名优秀的程序员,十分优秀!