- ubuntu12.04环境下使用kvm ioctl接口实现最简单的虚拟机

- Ubuntu 通过无线网络安装Ubuntu Server启动系统后连接无线网络的方法

- 在Ubuntu上搭建网桥的方法

- ubuntu 虚拟机上网方式及相关配置详解

CFSDN坚持开源创造价值,我们致力于搭建一个资源共享平台,让每一个IT人在这里找到属于你的精彩世界.

这篇CFSDN的博客文章高吞吐、线程安全的LRU缓存详解由作者收集整理,如果你对这篇文章有兴趣,记得点赞哟.

本文研究的主要是高吞吐、线程安全的lru缓存的相关内容,具体介绍如下.

几年以前,我实现了一个lru缓存用来为关键字来查找它的id。数据结构非常有意思,因为要求的吞吐很大足以消除大量使用locks和synchronized关键字带来的性能问题,应用是用java实现的.

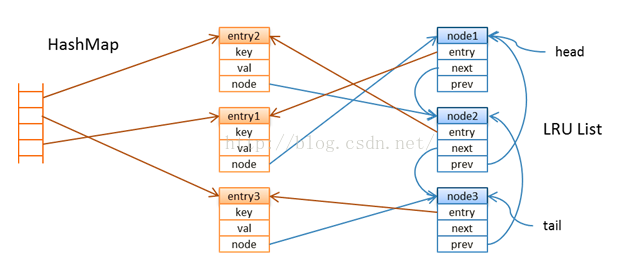

我想到一连串的原子引用分配会在concurrenthashmap中保持lru保持lru顺序,开始的时候我把value包装到entry中去,entry在双链表的lru链中有一个节点,链的尾部保持的是最近使用的entry,头节点中存放的是当缓存达到一定的大小的时候可能会清空的entry。每一个节点都指向用来查找的entry.

当你通过key查找值的时候,缓存首先要查找map看看是否有这个value存在,如果不存在的话,它将依赖于加载器将value从数据源中以read-through的方式读出来并且以“如果缺失则添加”的方式添加的map中去。确保高吞吐的挑战是有效的维护lru链。这个并发的哈希map是分段的而且在线程的水平在一定水平(当你构建map的时候你可以指定并发的水平)情况下的时候不会经历太多的线程竞争。但是lru链不能以同样的方式被划分吗,为了解决这个问题,我引入了辅助的队列用来清除操作.

在cache中有六个基本的方法。对于缓存命中,查找包含两个基本操作:get和offer,对于换粗丢失包含四个基本的方法get、load、put和offer。在put方法上,我们也许需要追踪清空操作,在缓存命中的情况下get,我们在lru链上被动的做一些清空叫做净化操作.

get : lookup entry in the map by key load : load value from a data source put : create entry and map it to key offer: append a node at the tail of the lru list that refers to a recently accessed entry evict: remove nodes at the head of the list and associated entries from the map (after the cache reaches a certain size) purge: delete unused nodes in the lru list -- we refer to these nodes as holes, and the cleanup queue keeps track of these 。

清空操作和净化操作都是大批量的处理数据,我们来看一下每个操作的细节 。

get操作是按如下方式工作的:

|

1

2

3

4

5

6

7

8

9

10

11

12

|

get(k) -> v

lookup entry by key k

if

cache hit, we have an entry e

offer entry e

try

purge some holes

else

load value v

for

key k

create entry e <- (k,v)

try

put entry e

end

return

value e.v

|

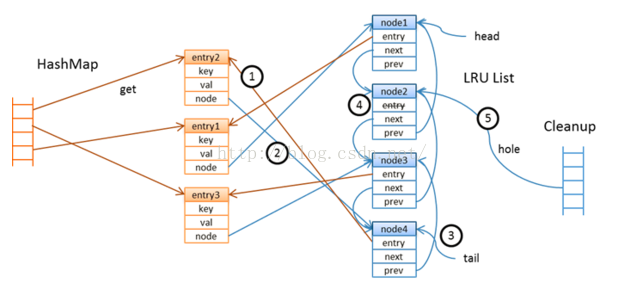

如果key存在,我们在lru链的尾部提供一个新的节点来表明,这是一个最近使用的值。get和offer的执行并不是原子操作(这里没有lock),所以我们不能说这个offered 节点指向最近使用的实体,但是肯定是当我们并发执行时获得的最近使用的实体。我们没有强制get和offer对在线程间执行的顺序,因为这可能会限制吞吐量。在offer一个节点之后,我们尝试着做一些清除和返回value的操作。下边我们详细看一下这offer和purge操作.

如果缓存丢失发生了,我们将调用加载器为这个key加载value,创建一个新的实体并把它放入到map中去,put操作如下:

|

1

2

3

4

5

6

7

8

9

10

11

12

|

put(e) -> e

existing entry ex <- map.putifabsent(e.k, e)

if

absent

offer entry e;

if

size reaches evict-threshold

evict some entries

end

return

entry e

else

, we have an existing entry ex

return

entry ex

end

|

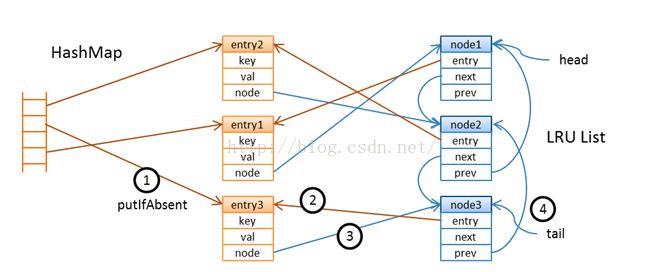

正如你所见的一样,有两个或这两个以上的线程把一个实体放入map的时候可能存在竞争,但是只允许一个成功并且会调用offer。在lru链的尾部提供一个节点之后,我们需要检查是否缓存已经达到了它的阙值的大小,阙值是我们用来出发批量清空操作的标识。在这个特定的应用的场景下,阙值的设置要比容量的大小要小。清空操作小批量的发生而不是每一个实体加进来的时候都会发生,多线程或许会参与到清空操作中去,直到缓存的容量达到它的容量。上锁很容易但是线程却能是安全的。清空需要移除lru链的头节点,这需要依赖细心的原子操作来避免在map中多线程的移除操作.

这个offer操作非常有意思,它总是尝试着创建一个节点但是并不试图在lru中立即移除和删除那些不再使用的节点.

|

1

2

3

4

5

6

7

8

9

10

11

12

13

|

offer(e)

if

tail node doesn't refer to entry e

assign current node c <- e.n

create a

new

node n(e),

new

node refers to entry e

if

atomic compare-and-set node e.n, expect c, assign n

add node n to tail of lru list

if

node c not

null

set entry c.e to

null

, c now has a hole

add node c to cleanup queue

end

end

end

|

首先它会检查,链中尾部的节点没有指向已经访问的实体,这并没有什么不同除非所有的线程频繁的访问同样的键值对,它将会链部的尾的实体创建一个新的节点当这个实体不同的时候,在提供新的节点之前,它尝试为实体进一个比较和设置的操作,这将阻止多线程做同样的事情.

成功的分配节点的线程在lru链的尾部提供了一个新的节点,这个操作和concurrentlinkedqueue中的find一样,依赖的算法在下边的文章中有描述 simple, fast, and practical non-blocking and blocking concurrent queue algorithms。线程然后会检查实体之前是否和其他的节点有相关连,如果是这样的话,老的节点不会立即删除,但是会被标记为一个hole(它的实体的引用会被设置为空) 。

总结 。

以上就是本文关于高吞吐、线程安全的lru缓存详解的全部内容,希望对大家有所帮助。感兴趣的朋友可以继续参阅本站其他相关专题,如有不足之处,欢迎留言指出。感谢朋友们对本站的支持! 。

原文链接:http://blog.csdn.net/maoyeqiu/article/details/50502410 。

最后此篇关于高吞吐、线程安全的LRU缓存详解的文章就讲到这里了,如果你想了解更多关于高吞吐、线程安全的LRU缓存详解的内容请搜索CFSDN的文章或继续浏览相关文章,希望大家以后支持我的博客! 。

我正在寻找一种方法来创建根据价格选择我的产品的过滤器(选择下拉菜单)。 我知道这样的查询是完全可能的: SELECT * FROM products ORDER BY price ASC SELECT

函数参数中或显示尺寸时(高度,宽度)的顺序是否有约定? 最佳答案 我不知道大量的语言,但我使用过的语言(宽度,高度)。它更适合沿着 (x, y) 坐标线。 关于language-agnostic -

在我的表单中,我让用户输入房间的长度高度和宽度以获得 m2、m3 和瓦特的计算值。但是用户也应该能够直接输入 height 和 m2 来获取值。我尝试了很多语法,但 if else 不能正常工作。我知

我在 Elasticsearch 中创建了一个索引,看起来像 {"amazingdocs":{"aliases":{},"mappings":{"properties":{"Adj Close":{"

我有以下功能,我需要清除数据库中的所有图片列并移动到文件系统。当我一次性完成这一切时,内存太多并且会崩溃。我切换到递归函数并执行 20 次写入和批量操作。 我需要为大约 6 个表执行此操作。我的 Re

我正在编写一个函数来计算 PI 的值,并将其作为 double 值返回。到目前为止,一切都很好。但是一旦函数到达小数点后14位,它就不能再保存了。我假设这是因为 double 有限。我应该怎么做才能继

2020年是中国CDN行业从98年诞生到今天快速发展的第二十四年,相关数据显示,全国感知网速持续上扬,达到了3.29兆/秒,标志着在宽带中国的政策指导下,中国的网速水平正在大步赶上世界发达国家的水平

在 aerospike 集合中,我们有四个 bin userId、adId、timestamp、eventype,主键是 userId:timestamp。在 userId 上创建二级索引以获取特定用

$('#container').highcharts('Map', { title : { text : 'Highmaps basic demo'

有没有办法显示自定义宽度/高度的YouTube视频? 最佳答案 在YouTube网站上的this link中: You can resize the player by editing the obj

我使用 Highcharts ,我想在 Highcharts 状态下悬停时制作动态不同的颜色。 正如你可以看到不同的颜色,这就是我做的 var usMapChart , data = [] ; va

在所有节点上运行 tpstats 后。我看到很多节点都有大量的 ALL TIME BLOCKED NTR。我们有一个 4 节点集群,NTR ALL TIME BLOCKED 的值为: 节点 1:239

我发现 APC 上存在大量碎片 (>80%),但实际上性能似乎相当不错。我有 read another post这建议在 wordpress/w3tc 中禁用对象缓存,但我想知道减少碎片是否比首先缓存

对于我的脚本类(class),我们必须制作更高/更低的游戏。到目前为止,这是我的代码: import random seedVal = int(input("What seed should be u

我发现 APC 上存在大量碎片 (>80%),但实际上性能似乎相当不错。我有 read another post这建议在 wordpress/w3tc 中禁用对象缓存,但我想知道减少碎片是否比首先缓存

对于我的脚本类(class),我们必须制作更高/更低的游戏。到目前为止,这是我的代码: import random seedVal = int(input("What seed should be u

我已经 seen >2 字节的 unicode 代码点,如 U+10000 可以成对编写,如 \uD800\uDC00。它们似乎以半字节 d 开头,但我只注意到了这一点。 这个 split Actio

有人可以帮我理解为什么我的饼图百分比计算不正确吗?看截图: 根据我的计算,如 RHS 上所示,支出百分比应为 24.73%。传递给 Highcharts 的值如下:- 花费:204827099.36-

我阅读了有关该问题的所有答案,但我还没有找到任何解决方案。 我有一个应用程序,由我的 api 服务器提供。 Wildfly 8.1 和 Mysql 5.6。当查看时间到来时(Wildfly 服务器连接

我正在用选定的项目创建圆形导航。当用户单击任何项目时,它将移动到定义的特定点。一切都很好,除了当你继续点击项目时,当动画表现不同并且项目在 360 度圆中移动并且它被重置直到你重复场景时,我希望它

我是一名优秀的程序员,十分优秀!