- html - 出于某种原因,IE8 对我的 Sass 文件中继承的 html5 CSS 不友好?

- JMeter 在响应断言中使用 span 标签的问题

- html - 在 :hover and :active? 上具有不同效果的 CSS 动画

- html - 相对于居中的 html 内容固定的 CSS 重复背景?

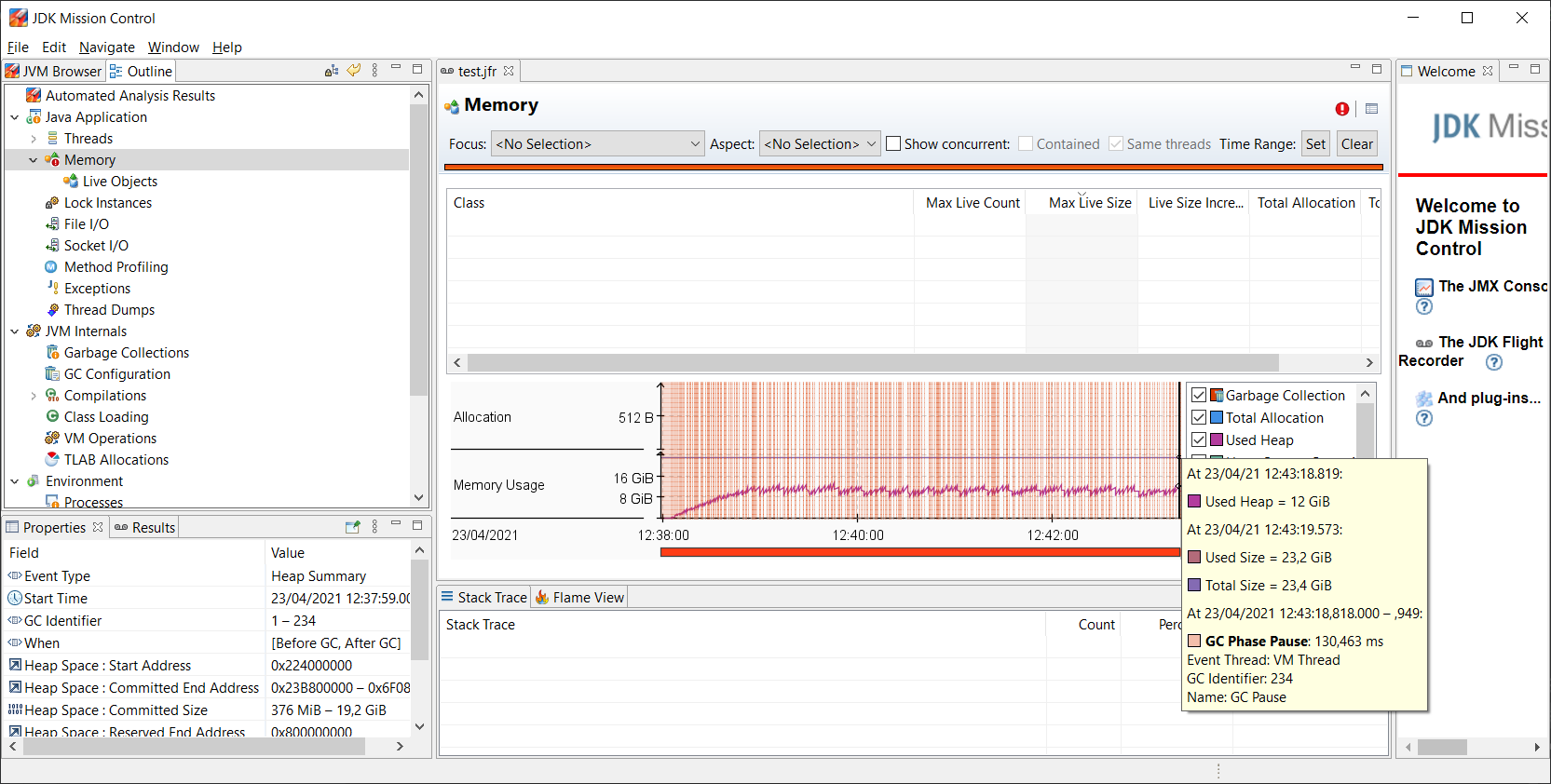

我们正在运行一个具有消耗大量内存的缓存的进程。但是该缓存中的对象数量在执行期间保持稳定,而内存使用量却在无限增长。

我们运行了 Java Flight Recorder 以尝试猜测发生了什么。

在那份报告中,我们可以看到 UsedHeap 大约是 UsedSize 的一半,对此我找不到任何解释。

JVM 退出并转储 OutOfMemory 报告,您可以在此处找到: https://frojasg1.com/stackOverflow/20210423.outOfMemory/hs_err_pid26210.log

这是整个 Java Flight Recorder 报告: https://frojasg1.com/stackOverflow/20210423.outOfMemory/test.7z

有人知道为什么会出现这种 outOfMemory 吗?

也许我必须改变问题......并问:为什么有将近 10 GB 的已用内存未在堆中使用?

最佳答案

日志文件是这样说的:

# Native memory allocation (mmap) failed to map 520093696 bytes

for committing reserved memory.

所以发生的事情是 JVM 通过 mmap 系统调用从操作系统请求了大约 500MB 的内存块,但操作系统拒绝了。

当我查看更多日志文件时,很明显 G1GC 本身正在请求更多内存,看起来它在尝试扩展堆1 时正在这样做。

我能想到mmap 失败的几个可能原因:

操作系统可能没有交换空间来支持内存分配。

您的 JVM 可能已达到每个进程的内存限制。 (在 UNIX/Linux 上,这是作为 ulimit 实现的。)

如果您的 JVM 在 Docker(或类似)容器中运行,您可能已经超出了容器的内存限制。

这不是“正常”的 OOME。这实际上是 JVM 的内存需求与操作系统可用内存之间的不匹配。

它可以在操作系统级别解决;即通过删除或增加限制,或添加更多交换空间(或可能更多 RAM)。

也可以通过减少 JVM 的最大堆大小来解决这个问题。这将阻止 GC 尝试将堆扩展到不可持续的大小2。这样做也可能导致 GC 运行得更频繁,但这比应用程序因可避免的 OOME 过早死亡要好。

1- 在 G1GC 诊断方面具有更多经验的人可能能够从故障转储中辨别出更多信息,但对我来说这看起来像是正常的堆扩展行为。没有明显迹象表明正在创建一个“巨大”的对象。

2 - 计算出可持续大小实际上需要分析整个系统的内存使用情况,并查看可用的 RAM 和交换资源以及限制。那是系统管理问题,而不是编程问题。

关于java - Java进程中出现OutOfMemoryException,但Used Heap大约是Used Size的一半,我们在Stack Overflow上找到一个类似的问题: https://stackoverflow.com/questions/67231088/

我需要围绕半径大约为 X 米的点 (lon,lat) 创建一个圆。 该点是通过等效于 geomFromEwkt('SRID=1;POINT(lon lat)') 生成的。 我知道 postgis 的缓

代码实现了读取文件(包含大量url)的功能,每个url都通过“evhttp_uri_parse”获取主机和路径。但是有一个错误,evhttp_uri_parse解析失败,返回NULL。可能原因是堆栈溢

所以我有两个进程,一个客户端进程,一个服务器进程。用户可以向客户端发出命令,当用户输入命令时客户端会将命令长度发送给服务器,之后再发送实际的命令。 服务器首先发回响应的长度,然后发送回响应。 我可以执

我从enwiki-latest-pagelinks.sql.gz下载了dumps.wikimedia.org/enwiki/latest/转储。 我开始将表导入到mysql数据库中: mysql -D

我有一个带有 Jw 音频播放器的 php 页面,并且有大约 5500 个链接,在每个链接的 onclick 事件上都附加了一个 javascript 函数。 php 正在生成文件的确切相对路径和名称,

我有一个大约 2GB 的巨大文本文件,我试图用 C# 解析它。该文件具有行和列的自定义分隔符。我想解析文件并提取数据并通过插入列标题并将 RowDelimiter 替换为换行符并将 ColumnDel

我已经建立了几个网站,出于某种原因,当我“喜欢”一篇博客文章或喜欢这个网站时,它们都不会再贴到我的墙上了。 (使用 iframe)示例: http://madhatterulti.com/ http:

关闭。这个问题需要更多focused .它目前不接受答案。 想改进这个问题吗? 更新问题,使其只关注一个问题 editing this post . 关闭 8 年前。 Improve this qu

我有一个与 LongPoll 一起工作的服务,当我收到我的数据时一切正常,但是当我没有收到数据时,我收到的是空结果(长轮询最大时间 == 25 秒)我的服务有时会关闭手动(我没有在服务列表中看到它)。

对于用于 Android 和应用内购买的最佳支付 API 是否达成共识? 在谷歌上搜索“Android 支付 api”,有大量来自 paypal、sms 和信用卡公司等的点击。但其中大部分文章已有多年

我的查询执行时间很长,大约 120 秒。 任何人都可以帮我重写这个查询。 请参阅下面的解释计划和表格结构。 我们经常在慢日志中收到此查询。 查询: select count(*) as col_

我正在尝试找到一种方法来对墓 map 像进行近似分割(在文化科学中的 CBIR 背景下 - 但这不是主题)。到目前为止,我正在使用这个策略: 模糊图像两次(实验结果) 应用 Canny 边缘检测器 寻

当您在 Google 中搜索时(我几乎可以肯定 Altavista 做了同样的事情),它会显示“关于 xxxx 的结果 1-10”... 这一直让我感到惊讶......“关于”是什么意思? 他们怎么能

今天我们的一台 Linux 服务器在打开出站请求时遇到问题。我已经查看了这个答案,Increasing the maximum number of tcp/ip connections in linu

我在 MVC4 站点中使用 NuGet 的最新 SignalR。使用sample hub code (或任何代码),我遇到一些奇怪的连接问题。一切加载正常,SignalR 进行协商调用并记录“Even

有人可以帮帮我吗?我的 GUI 有问题。这会过快地接收过多数据,以至于事件处理程序会完全阻塞 GUI 以供用户输入。 后台程序用于向 GUI 发送解决方案(作为文本),但 GUI 处理数据的速度不够快

假设我有一段代码,例如 for (j = 0; j 180) { c.fillStyle = 'red' } c.fi

我正在创建 2 名玩家的游戏,每个玩家都有自己的区域。我希望每个玩家都可以用一根手指触摸自己的区域。所以首先我将“达阵”功能限制为“2 个指针”。 public boolean touchDown(i

进程运行卡在 32000 (± 5%) 左右 ~# cat/proc/sys/kernel/threads-max127862 ~# ulimit -s堆栈大小(千字节,-s)2048 可用内存:3,

我有一个问题。我的应用程序在某些 Android 设备(Android 版本 5 到 6)的后台运行(如前台服务)。应用程序连接到服务器(TCP 连接)并且它们至少每 45 秒交换一次数据。 如果屏幕

我是一名优秀的程序员,十分优秀!