- html - 出于某种原因,IE8 对我的 Sass 文件中继承的 html5 CSS 不友好?

- JMeter 在响应断言中使用 span 标签的问题

- html - 在 :hover and :active? 上具有不同效果的 CSS 动画

- html - 相对于居中的 html 内容固定的 CSS 重复背景?

任何非零 recurrent_dropout产生 NaN 损失和权重;后者是 0 或 NaN。发生堆叠,浅,stateful , return_sequences = 任何,不包含 Bidirectional() , activation='relu' , loss='binary_crossentropy' . NaN 出现在几个批处理中。

任何修复?感谢帮助。

recurrent_dropout=0.2,0.1,0.01,1e-6 kernel_constraint=maxnorm(0.5,axis=0) recurrent_constraint=maxnorm(0.5,axis=0) clipnorm=50 (凭经验确定),那达慕优化器activation='tanh' - 无 NaN,权重稳定,测试多达 10 批处理lr=2e-6,2e-5 - 无 NaN,权重稳定,测试多达 10 批处理lr=5e-5 - 没有 NaN,权重稳定,对于 3 个批处理 - 第 4 批处理为 NaNbatch_shape=(32,48,16) - 2 批损失较大,第 3 批为 NaN注意:batch_shape=(32,672,16) , 17 次调用 train_on_batch每批处理

附加信息:

模型分歧是自发的,在不同的训练更新时发生,即使使用固定种子 - Numpy、Random 和 TensorFlow 随机种子。此外,当第一次发散时,LSTM 层权重都是正常的 - 稍后才变为 NaN。

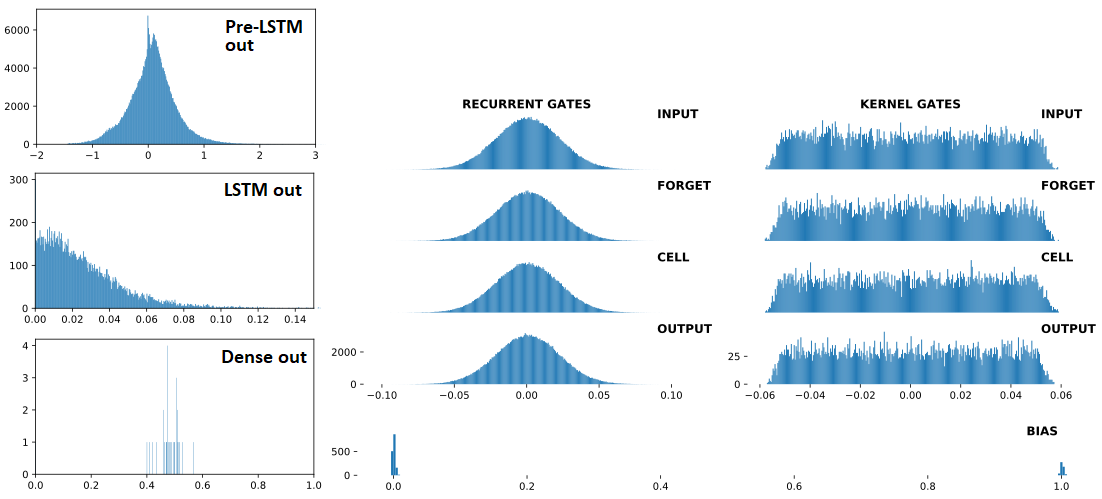

以下按顺序排列:(1) 输入 LSTM ; (2) LSTM产出; (3) Dense(1,'sigmoid')输出——这三个是连续的,有Dropout(0.5)每个之间。前面的 (1) 是 Conv1D层。右:LSTM 权重。 "BEFORE"= 之前有 1 次列车更新; "AFTER = 1 次列车更新之后

分歧之前:

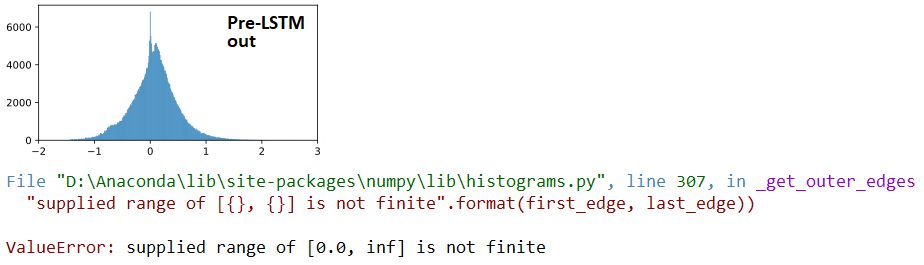

AT 分歧:

## LSTM outputs, flattened, stats

(mean,std) = (inf,nan)

(min,max) = (0.00e+00,inf)

(abs_min,abs_max) = (0.00e+00,inf)

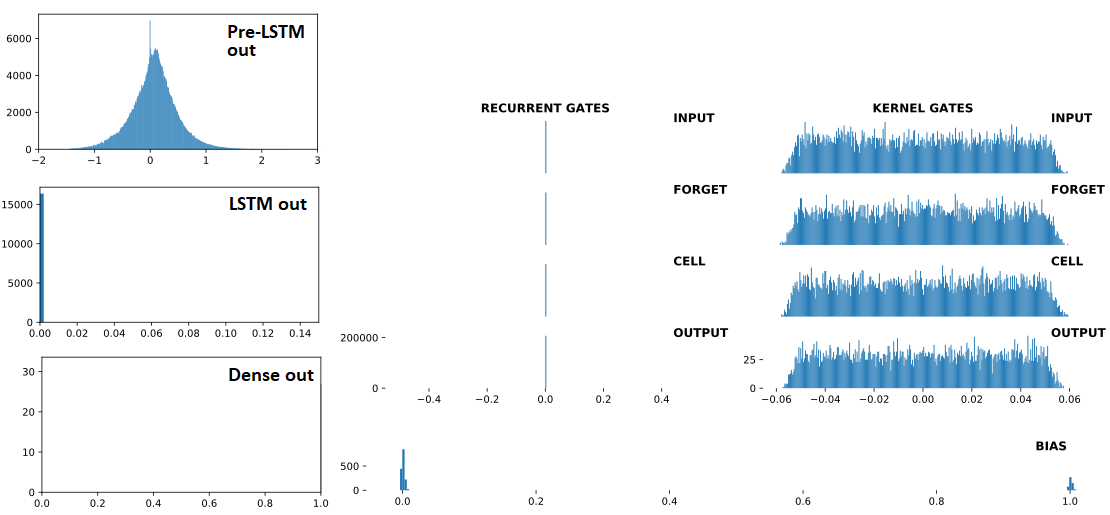

分歧之后:

## Recurrent Gates Weights:

array([[nan, nan, nan, ..., nan, nan, nan],

[ 0., 0., -0., ..., -0., 0., 0.],

[ 0., -0., -0., ..., -0., 0., 0.],

...,

[nan, nan, nan, ..., nan, nan, nan],

[ 0., 0., -0., ..., -0., 0., -0.],

[ 0., 0., -0., ..., -0., 0., 0.]], dtype=float32)

## Dense Sigmoid Outputs:

array([[1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.,

1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1., 1.]], dtype=float32)

from keras.layers import Input,Dense,LSTM,Dropout

from keras.models import Model

from keras.optimizers import Nadam

from keras.constraints import MaxNorm as maxnorm

import numpy as np

ipt = Input(batch_shape=(32,672,16))

x = LSTM(512, activation='relu', return_sequences=False,

recurrent_dropout=0.3,

kernel_constraint =maxnorm(0.5, axis=0),

recurrent_constraint=maxnorm(0.5, axis=0))(ipt)

out = Dense(1, activation='sigmoid')(x)

model = Model(ipt,out)

optimizer = Nadam(lr=4e-4, clipnorm=1)

model.compile(optimizer=optimizer,loss='binary_crossentropy')

for train_update,_ in enumerate(range(100)):

x = np.random.randn(32,672,16)

y = np.array([1]*5 + [0]*27)

np.random.shuffle(y)

loss = model.train_on_batch(x,y)

print(train_update+1,loss,np.sum(y))

观察:以下加速分歧:

units (LSTM)lr << 当 <=1e-4 时没有分歧, 测试了多达 400 列火车'1'标签 << 与 y 没有分歧下面,即使有lr=1e-3 ;测试了多达 400 列火车 y = np.random.randint(0,2,32) # makes more '1' labels

更新:未在 TF2 中修复;也可使用 from tensorflow.keras 重现进口。

最佳答案

深入研究 LSTM 公式并深入挖掘源代码,一切都变得清晰起来。

结论:recurrent_dropout 与它无关;一件事情在没有人预料到的地方循环。

真正的罪魁祸首:activation 参数,现在是 'relu',应用于循环转换 -与几乎所有将其显示为无害的 'tanh' 的教程相反。

即,激活不仅用于隐藏到输出的转换 - source code ;它直接在计算两种循环状态、细胞和隐藏层上运行:

c = f * c_tm1 + i * self.activation(x_c + K.dot(h_tm1_c, self.recurrent_kernel_c))

h = o * self.activation(c)

解决方案:

BatchNormalization 应用于 LSTM 的输入,尤其是如果前一层的输出是无界的(ReLU、ELU 等)

activation=None,然后是 BN,然后是 Activation层)activation='selu';更稳定,但仍然可以发散lr更多答案,对一些剩余问题:

recurrent_dropout 被怀疑? 不严谨的测试设置;直到现在我才专注于在没有它的情况下强制发散。然而,它确实有时会加速发散——这可以通过它将非 relu 贡献归零来解释,否则会抵消乘法强化。2020 年 1 月 22 日更新:recurrent_dropout 实际上可能是一个促成因素,因为它利用倒置 dropout,在培训,在许多时间步上缓解不同的行为。关于此的 Git 问题 here

关于tensorflow - LSTM 'recurrent_dropout' 和 'relu' 产生 NaN,我们在Stack Overflow上找到一个类似的问题: https://stackoverflow.com/questions/57516678/

在其 API documentation ,它说“计算整流线性”。 是 Re(ctified) L(inear)... 那么 U 是什么? 最佳答案 Re(ctified) L(inear) (U)n

关闭。这个问题不符合Stack Overflow guidelines .它目前不接受答案。 想改进这个问题?将问题更新为 on-topic对于堆栈溢出。 3年前关闭。 Improve this qu

我看到这里记录了这个“tf.nn.relu”:https://www.tensorflow.org/api_docs/python/tf/nn/relu 但后来我在“model_fn”的这个页面上也看

我只是想知道 的用途和专业之间是否有任何显着差异 Dense(activation='relu') 和 keras.layers.ReLu 后一个如何以及在哪里可以使用?我最好的猜测是在功能 API

我最近在做一个基于 TensorFlow 的 Udacity 深度学习类(class)。 .我有一个简单的 MNIST大约 92% 准确的程序: from tensorflow.examples.tu

我在使用 relu 激活函数时无法实现反向传播。我的模型有两个隐藏层,两个隐藏层都有 10 个节点,输出层有一个节点(因此有 3 个权重,3 个偏差)。除了这个损坏的 backward_prop 函数

由于neuralnet包没有ReLU功能,所以我尝试写ReLU功能的代码。但是有一个错误我不明白。请在下面查看我的代码和错误信息。 relu=0,x,0)} nn =0)} relu <- funct

由于neuralnet包没有ReLU功能,所以我尝试写ReLU功能的代码。但是有一个错误我不明白。请在下面查看我的代码和错误信息。 relu=0,x,0)} nn =0)} relu <- funct

我已经用 relu 作为激活函数在 tensorflow 中编写了一个卷积网络,但是它不是学习(对于评估和训练数据集,损失都是恒定的)。对于不同的激活函数,一切都按其应有的方式工作。 这是创建 nn

我正在使用 python 2.7 并试图更好地了解 tensorflow 。 我正在使用以下代码尝试在 mnist 数据上训练自动编码器,当我使用 sigmoid 激活时,它可以正常(90%),但是当

所以我开始使用 Pytorch,并在 FashionMNIST 数据集上构建一个非常基本的 CNN。我在使用神经网络时注意到一些奇怪的行为,我不知道为什么会发生这种情况,在前向函数中,当我在每个线性层

我正在根据负值和正值的数据训练神经网络。 有没有什么方法可以将数据输入 ReLU 网络,而不将其全部转换为正数,并且有一个单独的输入来表示数据是负数还是正数? 我看到的问题是,输入层的负输入意味着除非

ReLU 函数,在这种情况下,我使用了 leaky ReLU 给我错误的输出。但是使用 sigmoid 函数它给了我一个可接受的输出 这是我的代码: import numpy as np def re

在 keras 文档中,函数 keras.activations.relu(x, alpha=0.0, max_value=None, Threshold=0.0) 定义为: f(x) = max_v

我正在尝试使用神经网络 (Keras) 逼近正弦函数。 是的,我阅读了相关的帖子:) Link 1 Link 2 Link 3 使用四个带 sigmoid 的隐藏神经元和一个带线性激活的输出层效果很好

作为一个更大项目的一部分,我一直在构建一个编程语言检测器,即代码片段的分类器。我的基线模型非常简单:将输入标记化并将片段编码为词袋,或者,在这种情况下,bag-of-tokens,并在这些特征之上制作

我正在实现一个神经网络,并希望使用 ReLU 作为神经元的激活函数。此外,我正在使用 SDG 和反向传播训练网络。我正在用范例 XOR 问题测试神经网络,到目前为止,如果我使用逻辑函数或双曲正切作为激

测试代码: ? 1

最近我观察到,在定义神经网络时,我们多次为每一层定义单独的 ReLU 对象。为什么我们不能在需要的地方使用相同的 ReLU 对象。 例如而不是像这样写- def __init__(self):

我们使用 ReLu 而不是 Sigmoid 激活函数,因为它没有像激活函数一样存在于 Sigmoid 中的梯度消失和爆炸问题, Leaky-ReLU 是 rely 的改进之一。大家都在谈论 Leaky

我是一名优秀的程序员,十分优秀!