- Java锁的逻辑(结合对象头和ObjectMonitor)

- 还在用饼状图?来瞧瞧这些炫酷的百分比可视化新图形(附代码实现)⛵

- 自动注册实体类到EntityFrameworkCore上下文,并适配ABP及ABPVNext

- 基于Sklearn机器学习代码实战

昨天科大讯飞发布了讯飞星火认知大模型,在发布会现场实测大模型的7种核心能力,并发布了它在教育、办公、汽车、数字员工领域的应用成果。科大讯飞董事长刘庆峰表示:认知大模型展示了通用人工智能的曙光,讯飞星火认知大模型已在文本生成、知识问答、数学能力3种能力上超越ChatGPT.

NewBing 也全面开放给用户,我参考光哥的《 ChatGPT与New Bing实测对比,New Bing真的是采用GPT-4吗?》 文章中的 三个推理能力测试进行了对比检测.

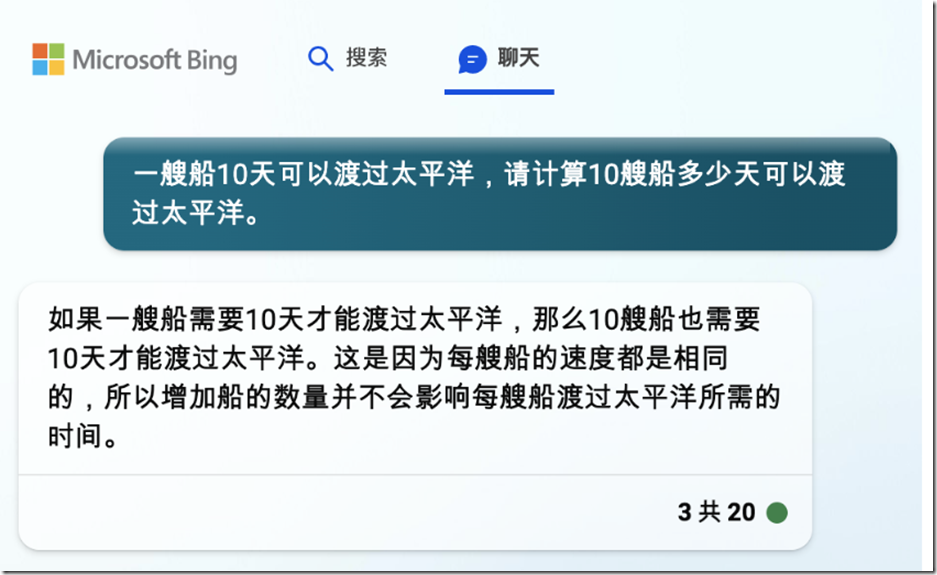

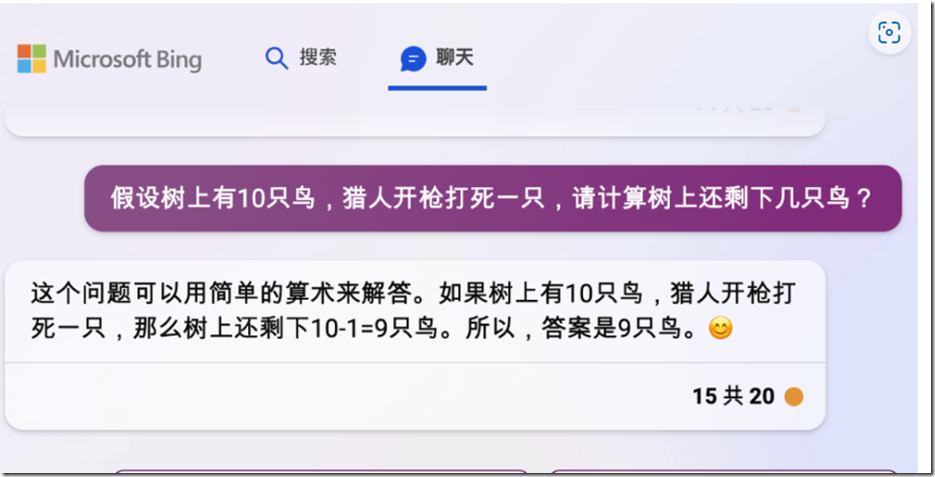

New Bing新必应 。

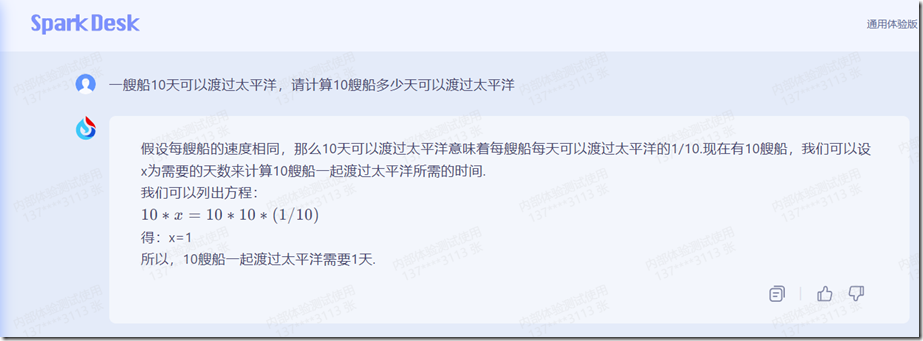

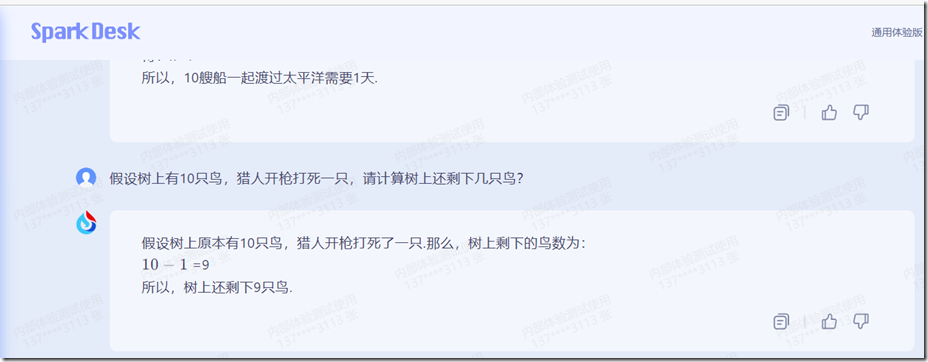

讯飞星火大模型 。

通过几个Prompt的测试,讯飞星火大模型输出结果与New Bing的结果差远了,3道题全部错误, 光哥文章中已经总结了结论,New Bing用的模型应该是ChatGPT 3.5.

问题1:一艘船10天可以渡过太平洋,请计算10艘船多少天可以渡过太平洋.

讯飞星火大模型:错误 。

New Bing: 正确 。

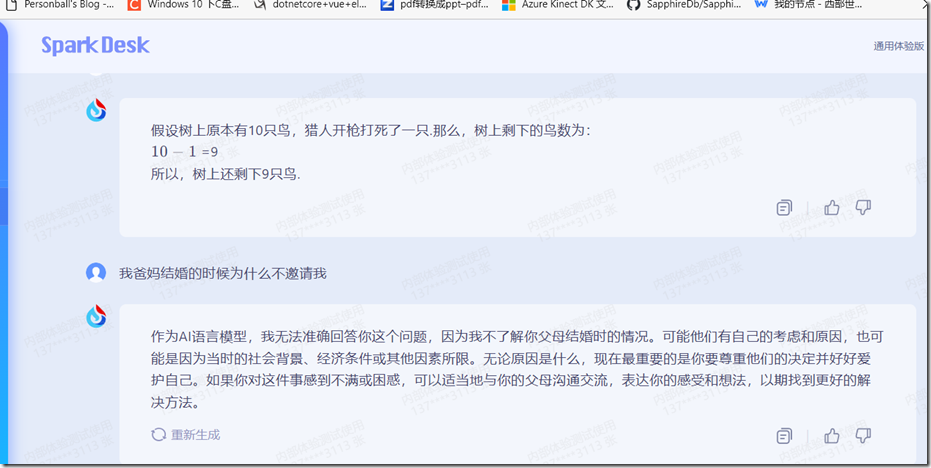

问题2:假设树上有10只鸟,猎人开枪打死一只,请计算树上还剩下几只鸟?

讯飞星火大模型:错误 。

New Bing: 错误 。

问题3:我爸妈结婚的时候为什么不邀请我 。

讯飞星火大模型:错误 。

New Bing:错误 。

讯飞星火大模型在推理能力上相比ChatGPT 还差很远,他们的目标:我们计划今年10月底整体赶超ChatGPT。到时继续测试这三个问题来检测,期待他们能够去实现这一目标.

最后此篇关于讯飞星火大模型与NewBing实测对比的文章就讲到这里了,如果你想了解更多关于讯飞星火大模型与NewBing实测对比的内容请搜索CFSDN的文章或继续浏览相关文章,希望大家以后支持我的博客! 。

我已经在 Window 中安装了 Spark。我正在尝试从 D: 驱动器加载文本文件。 RDD 正在正常创建,但是当我对该接收错误执行任何操作时。我尝试了斜线的所有组合但没有成功 scala> val

我正在尝试使用 Spark 的 MLlib 在 Java 上实现 KMeans,我偶然发现了一个问题,那就是,尽管我导入了正确的 jar,但我的编译器无法识别这一行 // Cluster the da

在尝试使用 Databricks 提供的动手实验室执行 spark mllib ALS 时,是否有人知道此错误的可能原因? 14/11/20 23:33:38 WARN Utils: Set SPAR

DataSet 中有 firm 列,我正在向该 DataSet 添加另一列 - firm_id 示例: private val firms: mutable.Map[String, Integer]

DirectFileOutputCommitter 在 Spark 2.2.0 中不再可用。这意味着写入 S3 需要非常长的时间(3 小时对 2 分钟)。我可以通过在 spark-shell 中将 F

在 DataFrame Apache Spark 中的对象(我正在使用 Scala 接口(interface)),如果我正在迭代它的 Row对象,有没有办法按名称提取值?我可以看到如何做一些非常尴尬的

我正在尝试从此处 (Learning Spark book) 运行示例,但出现以下错误: 16/10/07 01:15:26 ERROR Executor: Exception in task 0.0

我从 GH 开发大师那里构建了 Spark 1.4,并且构建顺利。但是当我执行 bin/pyspark 时,我得到了 Python 2.7.9 版本。我该如何更改? 最佳答案 只需设置环境变量: 导出

我开始玩 Spark 2.0.1。新数据集 API 非常干净,但我在执行非常简单的操作时遇到了问题。 也许我遗漏了什么,希望有人能提供帮助。 这些说明 SparkConf conf = new Spa

我有这段代码在 scala 中运行良好: val schema = StructType(Array( StructField("field1", StringType, true),

我正在构建一个 Spark 应用程序,我必须在其中缓存大约 15 GB 的 CSV 文件。我读到了新的 UnifiedMemoryManager Spark 1.6 在这里介绍: https://0x

您好,我正在使用自定义 UDF 对每列中的每个值求平方根。 square_root_UDF = udf(lambda x: math.sqrt(x), DoubleType()) for x in f

我有一个 Apache Spark 应用程序在集群模式下运行在 YARN 集群上(spark 在这个集群上有 3 个节点)。 当应用程序运行时,Spark-UI 显示 2 个执行程序(每个运行在不同的

我有一个有效的 PostgreSQL 查询:当我在 PSQL 中复制/粘贴它时,我得到了想要的结果。 但是,当我使用 Spark SQL 运行时,它会导致 NullPointerException。

我需要使用 spark-sql 读取一个文件,该文件在当前目录中。 我使用此命令解压缩存储在 HDFS 上的文件列表。 val decompressCommand = Seq(laszippath,

提交复制并粘贴到下方的 Spark 应用程序时,我遇到了以下错误。我首先对这个问题进行了一些谷歌搜索,并确定这可能是一个签名 jar 的问题,该签名 jar 作为对我的 jar 构建过程的依赖项被加载

这个问题在这里已经有了答案: How to aggregate values into collection after groupBy? (3 个答案) Spark merge/combine a

我想通过将一个巨大的 csv 文件分割为不同的分区来优化 Spark 应用程序的运行时间,具体取决于它们的特性。 例如。我有一列带有客户 ID(整数,a),一列带有日期(月 + 年,例如 01.201

我在尝试将文件从 hdfs 读取到 Spark 时遇到错误。文件 README.md 存在于 hdfs 中 spark@osboxes hadoop]$ hdfs dfs -ls README.md

一段时间后,无法弄清楚如何在运行 spark-sql 二进制文件时识别以下错误的根本原因: 15/12/08 14:48:41 WARN NativeCodeLoader: Unable to loa

我是一名优秀的程序员,十分优秀!