- Java锁的逻辑(结合对象头和ObjectMonitor)

- 还在用饼状图?来瞧瞧这些炫酷的百分比可视化新图形(附代码实现)⛵

- 自动注册实体类到EntityFrameworkCore上下文,并适配ABP及ABPVNext

- 基于Sklearn机器学习代码实战

容器系列文章 。

容器系列视频 。

前面分析了flannel vxlan模式进行容器跨主机通信的原理,但是vxlan模式需要对数据包进行额外的封包解包处理,带来的开销较大.

所以flannel提供了另外一种纯3层转发的通信模式,叫做host-gw,顾明思议,这种模式是将主机作为网关在用了.

先来看下网关在ip通信中的作用,例如,一个tcp包有源ip和目的ip,如果目的ip匹配不到路由信息,那么就会将包转发到网关,在一个发往目的ip的过程中,可能会经过多个网关.

网关的本质是作为ip通信的中转站,网络包在传输过程中,目的ip是不会变的,一直在变化的是mac地址,每到达一台主机,那么目的mac地址就会发生变化,变成下一个网关的mac地址,数据包需要到达的下一台主机被称作”下一跳“(next hop).

了解了网关的作用,再来看看flannel host-gw模式在k8s节点上做了哪些改动.

这里我同样是启动了一个3节点的集群,cni插件就是用flannel,模式是host-gw模式.

net-conf.json: |

{

"Network": "10.10.0.0/16",

"Backend": {

"Type": "host-gw"

}

}

集群节点信息 。

parallels@master:~/k8s$ kubectl get nodes -o wide

NAME STATUS ROLES AGE VERSION INTERNAL-IP EXTERNAL-IP OS-IMAGE KERNEL-VERSION CONTAINER-RUNTIME

master Ready control-plane,master 13d v1.23.3 192.168.2.17 <none> Ubuntu 22.04 LTS 5.15.0-58-generic docker://20.10.12

worker1 Ready <none> 13d v1.23.3 192.168.2.16 <none> Ubuntu 22.04 LTS 5.15.0-60-generic docker://20.10.12

worker2 Ready <none> 13d v1.23.3 192.168.2.15 <none> Ubuntu 22.04 LTS 5.15.0-60-generic docker://20.10.12

然后用busybox镜像启动了4个pod 。

parallels@master:~/k8s$ kubectl get pods -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

busybox-8647b8666c-jpnb6 1/1 Running 0 21m 10.10.1.6 worker1 <none> <none>

busybox-8647b8666c-pg7ps 1/1 Running 0 21m 10.10.2.4 worker2 <none> <none>

busybox-8647b8666c-sgf8v 1/1 Running 0 21m 10.10.1.5 worker1 <none> <none>

busybox-8647b8666c-zlxmm 1/1 Running 0 21m 10.10.2.3 worker2 <none> <none>

我们的目的就是看看worker1节点上的ip为10.10.1.6 的pod 是如何ping通 worker2节点上的ip为 10.10.2.4 的pod的.

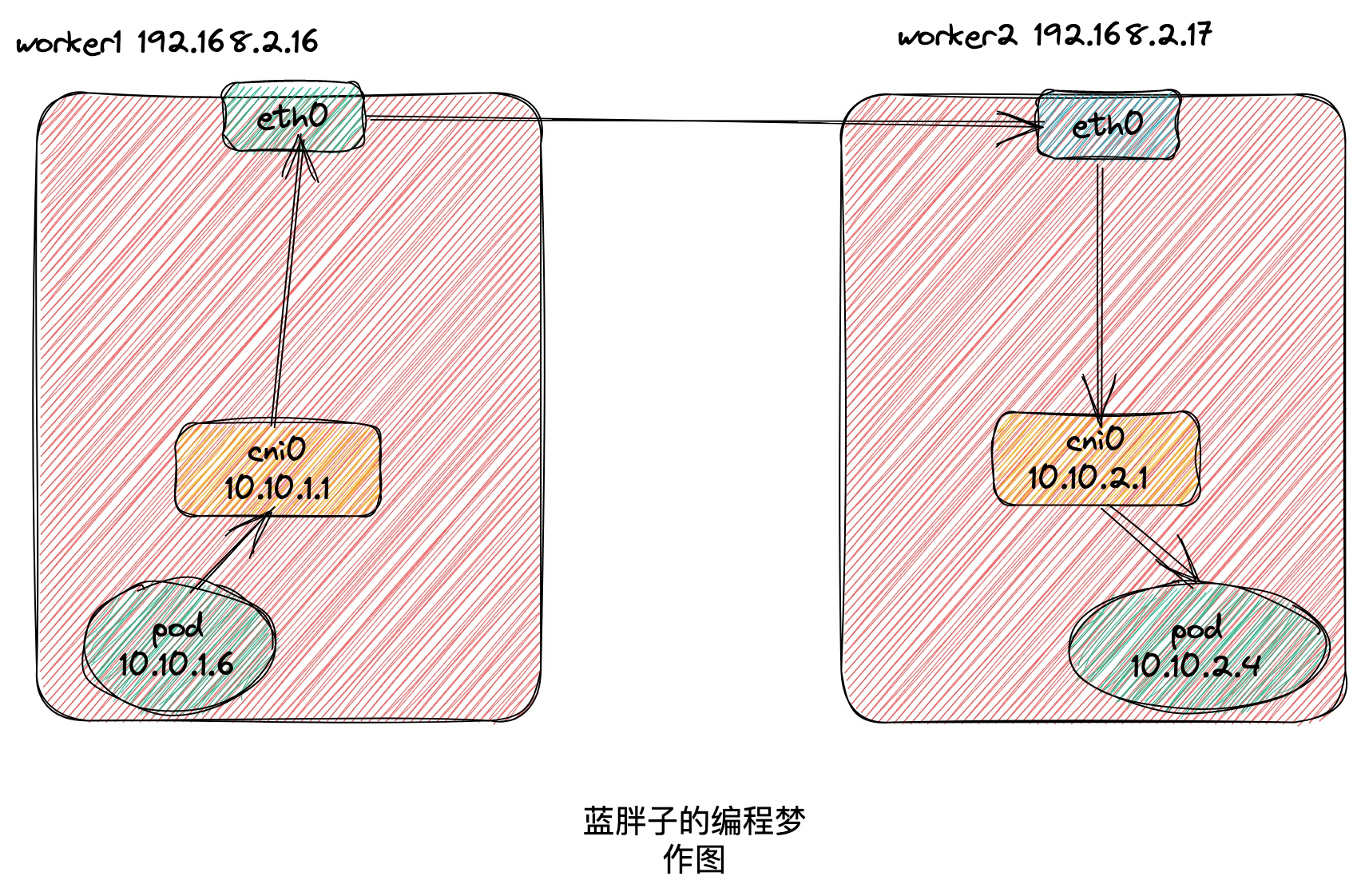

为了接下来的分析更加形象化,这里我先贴上一张集群内部的网络拓扑图。后续的分析都可以随时回顾下这张图.

先从10.10.1.6的pod看起,进入10.10.1.6的pod查看路由信息.

worker1节点上的ip为10.10.1.6的pod路由信息 。

parallels@master:~/k8s$ kubectl exec -it busybox-8647b8666c-jpnb6 /bin/sh

kubectl exec [POD] [COMMAND] is DEPRECATED and will be removed in a future version. Use kubectl exec [POD] -- [COMMAND] instead.

/ #

/ # ip route

default via 10.10.1.1 dev eth0

10.10.0.0/16 via 10.10.1.1 dev eth0

10.10.1.0/24 dev eth0 scope link src 10.10.1.6

默认网关是10.10.1.1 ,这个ip地址其实就是worker1节点上cni0网桥的ip地址 。

可以查到worker1节点上cni0的ip地址 。

parallels@worker1:~$ ifconfig

cni0: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500

inet 10.10.1.1 netmask 255.255.255.0 broadcast 10.10.1.255

所以在ip为10.10.1.6的pod内部去ping上worker2节点的pod ip 10.10.2.4 会匹配上第二条路由信息,然后由eth0网卡出去,网关地址是10.10.1.1,所以网络包就从pod内部传送到了worker1的cni0网桥上.

cni0网桥会将mac地址为其自身mac地址的数据包转发到主机的3层网络中,而具体要怎么路由,则是需要看worker1主机上的路由规则.

parallels@worker1:~$ ip route

default via 192.168.2.1 dev enp0s5 proto dhcp src 192.168.2.16 metric 100

10.10.0.0/24 via 192.168.2.17 dev enp0s5

10.10.1.0/24 dev cni0 proto kernel scope link src 10.10.1.1

10.10.2.0/24 via 192.168.2.15 dev enp0s5

172.17.0.0/16 dev docker0 proto kernel scope link src 172.17.0.1 linkdown

192.168.2.0/24 dev enp0s5 proto kernel scope link src 192.168.2.16 metric 100

192.168.2.1 dev enp0s5 proto dhcp scope link src 192.168.2.16 metric 100

这些节点上路由的配置是由flannel 在每个节点上启动的flanneld进程去进行的配置的,配置信息来源是k8s集群内部的etcd集群 。

我们发送的数据包目的ip是10.10.2.4 ,它会匹配上worker1主机的第二条路由信息,第二条路由信息是在说访问10.10.0.0/24 网段的数据包都将由enp0s5网卡发出,并且网关地址也就是下一跳的ip地址是192.168.2.17,而192.168.2.17 就是worker2的ip地址.

为了看的更加清晰,我们再来回顾下开局的图.

这样数据包就到达到worker2节点了,到了worker2节点后,数据包的如何流动是看worker2节点上的路由规则,所以我们再来看下节点2上面的路由规则。记住数据包的目的ip是10.10.2.4.

parallels@worker2:~$ ip route

default via 192.168.2.1 dev enp0s5 proto dhcp src 192.168.2.15 metric 100

10.10.0.0/24 via 192.168.2.17 dev enp0s5

10.10.1.0/24 via 192.168.2.16 dev enp0s5

10.10.2.0/24 dev cni0 proto kernel scope link src 10.10.2.1

172.17.0.0/16 dev docker0 proto kernel scope link src 172.17.0.1 linkdown

192.168.2.0/24 dev enp0s5 proto kernel scope link src 192.168.2.15 metric 100

192.168.2.1 dev enp0s5 proto dhcp scope link src 192.168.2.15 metric 100

匹配上了第4条路由规则,发往 10.10.2.0/24 的网段的数据包是要被cni0网桥处理的,所以数据包来到了worker2节点上的cni0网桥上,cni0是如何找到要发送的目的ip的veth端口的呢?

pod内部的eth0 网卡其实就是个veth设备,veth设备一端连接在pod的网路命名空间中,一端连接在网桥上,从veth的一端发出去的网络包一定能够被另一端接收.

网桥收到主机发来的数据包后,首先看自身有没有数据包的目的ip的端口记录,如果有,那么就从该端口发送数据包,因为连接的veth设备,所以从端口发送出去后,一定能到达pod的内部,veth设备就像是网线一样.

如果没有记录,那么网桥会向通过arp协议广播帧,得到回应后便能知道端口与ip的映射关系。从而将数据包发往正确的端口.

这样一个数据包就完全的从一台主机通过路由规则到达到了另外一台主机,而主机ip实际上是被当成网关,作为原ip地址的下一跳地址了.

相比于vxlan模式,因为少了封包解包的操作,会提升数据传输的性能。但由于这是一个纯3层转发的方案,要想主机作为的网关的前提,必须是集群中的两台主机是一个二层连通的环境中.

最后此篇关于k8s容器互联-flannelhost-gw原理篇的文章就讲到这里了,如果你想了解更多关于k8s容器互联-flannelhost-gw原理篇的内容请搜索CFSDN的文章或继续浏览相关文章,希望大家以后支持我的博客! 。

这是我想做的 1 - 点击提交 2 - 隐藏 DIV 容器 1 3 - 显示 DIV 容器 2 4 - 将“PricingDisclaimer.php”中找到的所有 DIV 加载到 Div 容器 2

我有一个 ios 应用程序,它使用 iCloudcontainer 来保存用户的一些数据,例如用户的“到期日期”。我要用不同的方式创建应用程序的副本开发者账号。我要将用户从第一个应用程序迁移到第二个应

这是场景。 我有三个容器。 Container1、container2 和 container3(基于 Ubuntu 的镜像),其中 container2 充当容器 1 和容器 2 之间的路由器。 我

关闭。这个问题需要多问focused 。目前不接受答案。 想要改进此问题吗?更新问题,使其仅关注一个问题 editing this post . 已关闭 9 年前。 Improve this ques

我正在改造管道以使用声明式管道方法,以便我能够 to use Docker images在每个阶段。 目前我有以下工作代码,它执行连接到在 Docker 容器中运行的数据库的集成测试。 node {

我正在开发一个需要尽可能简单地为最终用户安装的应用程序。虽然最终用户可能是经验丰富的 Linux 用户(或销售工程师),但他们对 Tomcat、Jetty 等并不真正了解,我认为他们也不应该了解。 所

我从gvisor-containerd-shim(Shim V1)移到了containerd-shim-runsc-v1(Shim V2)。在使用gvisor-containerd-shim的情况下,

假设我们只在某些开发阶段很少需要这样做(冒烟测试几个 api 调用),让项目 Bar 中的 dockerized web 服务访问 Project Foo 中的 dockerized web 服务的最

各位,我的操作系统是 Windows 10,运行的是 Docker 版本 17.06.0-ce-win19。我在 Windows 容器中运行 SQL Server Express,并且希望将 SQL

谁能告诉我,为什么我们不能在 Azure 存储中的容器内创建容器?还有什么方法可以处理,我们需要在 azure 存储中创建目录层次结构? 最佳答案 您无法在容器中创建容器,因为 Windows Azu

#include template struct Row { Row() { puts("Row default"); } Row(const Row& other) { puts

按照目前的情况,这个问题不适合我们的问答形式。我们希望答案得到事实、引用或专业知识的支持,但这个问题可能会引发辩论、争论、投票或扩展讨论。如果您觉得这个问题可以改进并可能重新打开,visit the

RDF容器用于描述一组事物 例如,把一本书的所有作者列在一起 RDF容器有三种类型: <Bag> <Seq> <Alt> <rdf:

编辑:从到目前为止添加的答案和评论看来,我没有正确解释我想要什么。下面是一个例子: // type not supporting any type of comparison [] [] type b

我正在测试 spatie 的异步项目。我创建了一个这样的任务。 use Spatie\Async\Task; class ServiceTask extends Task { protecte

我想使用 Azure Blob 存储来上传和下载文档。有一些公司可以上传和下载他们的文档。我想保证这些文件的安全。这意味着公司只能看到他们的文件。不是别人的。 我可以在 blob 容器中创建多个文件夹

我正在尝试与 Azure 中的容器实例进行远程交互。我已执行以下步骤: 已在本地注册表中加载本地镜像 docker load -i ima.tar 登录远程 ACR docker登录--用户名--密码

我正在研究http://progrium.viewdocs.io/dokku/process-management/,并试图弄清楚如何从单个项目中运行多个服务。 我有一个Dockerfile的仓库:

我有一个想要容器化的单体应用程序。文件夹结构是这样的: --app | |-file.py <-has a variable foo that is passed in --configs

我正在学习 Docker,并且一直在为 Ubuntu 容器制作 Dockerfile。 我的问题是我不断获取不同容器之间的持久信息。我已经退出,移除了容器,然后移除了它的图像。在对 Dockerfil

我是一名优秀的程序员,十分优秀!