- Java锁的逻辑(结合对象头和ObjectMonitor)

- 还在用饼状图?来瞧瞧这些炫酷的百分比可视化新图形(附代码实现)⛵

- 自动注册实体类到EntityFrameworkCore上下文,并适配ABP及ABPVNext

- 基于Sklearn机器学习代码实战

也许每一个男子全都有过这样的两个女人,至少两个。娶了红玫瑰,久而久之,红的变了墙上的一抹蚊子血,白的还是床前明月光;娶了白玫瑰,白的便是衣服上沾的一粒饭黏子,红的却是心口上一颗朱砂痣。--张爱玲《红玫瑰与白玫瑰》 。

Selenium一直都是Python开源自动化浏览器工具的王者,但这两年微软开源的PlayWright异军突起,后来者居上,隐隐然有撼动Selenium江湖地位之势,本次我们来对比PlayWright与Selenium之间的差异,看看曾经的玫瑰花Selenium是否会变成蚊子血.

PlayWright是由业界大佬微软(Microsoft)开源的端到端 Web 测试和自动化库,可谓是大厂背书,功能满格,虽然作为无头浏览器,该框架的主要作用是测试 Web 应用,但事实上,无头浏览器更多的是用于 Web 抓取目的,也就是爬虫.

首先终端运行安装命令:

pip3 install playwright

程序返回:

Successfully built greenlet

Installing collected packages: pyee, greenlet, playwright

Attempting uninstall: greenlet

Found existing installation: greenlet 2.0.2

Uninstalling greenlet-2.0.2:

Successfully uninstalled greenlet-2.0.2

Successfully installed greenlet-2.0.1 playwright-1.30.0 pyee-9.0.4

目前最新稳定版为1.30.0 。

随后可以选择直接安装浏览器驱动:

playwright install

程序返回:

Downloading Chromium 110.0.5481.38 (playwright build v1045) from https://playwright.azureedge.net/builds/chromium/1045/chromium-mac-arm64.zip

123.8 Mb [====================] 100% 0.0s

Chromium 110.0.5481.38 (playwright build v1045) downloaded to /Users/liuyue/Library/Caches/ms-playwright/chromium-1045

Downloading FFMPEG playwright build v1008 from https://playwright.azureedge.net/builds/ffmpeg/1008/ffmpeg-mac-arm64.zip

1 Mb [====================] 100% 0.0s

FFMPEG playwright build v1008 downloaded to /Users/liuyue/Library/Caches/ms-playwright/ffmpeg-1008

Downloading Firefox 108.0.2 (playwright build v1372) from https://playwright.azureedge.net/builds/firefox/1372/firefox-mac-11-arm64.zip

69.8 Mb [====================] 100% 0.0s

Firefox 108.0.2 (playwright build v1372) downloaded to /Users/liuyue/Library/Caches/ms-playwright/firefox-1372

Downloading Webkit 16.4 (playwright build v1767) from https://playwright.azureedge.net/builds/webkit/1767/webkit-mac-12-arm64.zip

56.9 Mb [====================] 100% 0.0s

Webkit 16.4 (playwright build v1767) downloaded to /Users/liuyue/Library/Caches/ms-playwright/webkit-1767

默认会下载Chromium内核、Firefox以及Webkit驱动.

其中使用最广泛的就是基于Chromium内核的浏览器,最负盛名的就是Google的Chrome和微软自家的Edge.

确保当前电脑安装了Edge浏览器,让我们小试牛刀一把:

from playwright.sync_api import sync_playwright

import time

with sync_playwright() as p:

browser = p.chromium.launch(channel="msedge", headless=True)

page = browser.new_page()

page.goto('http:/v3u.cn')

page.screenshot(path=f'./example-v3u.png')

time.sleep(5)

browser.close()

这里导入sync_playwright模块,顾名思义,同步执行,通过上下文管理器开启浏览器进程.

随后通过channel指定edge浏览器,截图后关闭浏览器进程:

我们也可以指定headless参数为True,让浏览器再后台运行:

from playwright.sync_api import sync_playwright

with sync_playwright() as p:

browser = p.chromium.launch(channel="msedge", headless=True)

page = browser.new_page()

page.goto('http:/v3u.cn')

page.screenshot(path=f'./example-v3u.png')

browser.close()

除了同步模式,PlayWright也支持异步非阻塞模式:

import asyncio

from playwright.async_api import async_playwright

async def main():

async with async_playwright() as p:

browser = await p.chromium.launch(channel="msedge", headless=False)

page = await browser.new_page()

await page.goto("http://v3u.cn")

print(await page.title())

await browser.close()

asyncio.run(main())

可以通过原生协程库asyncio进行调用,PlayWright内置函数只需要添加await关键字即可,非常方便,与之相比,Selenium原生库并不支持异步模式,必须安装三方扩展才可以.

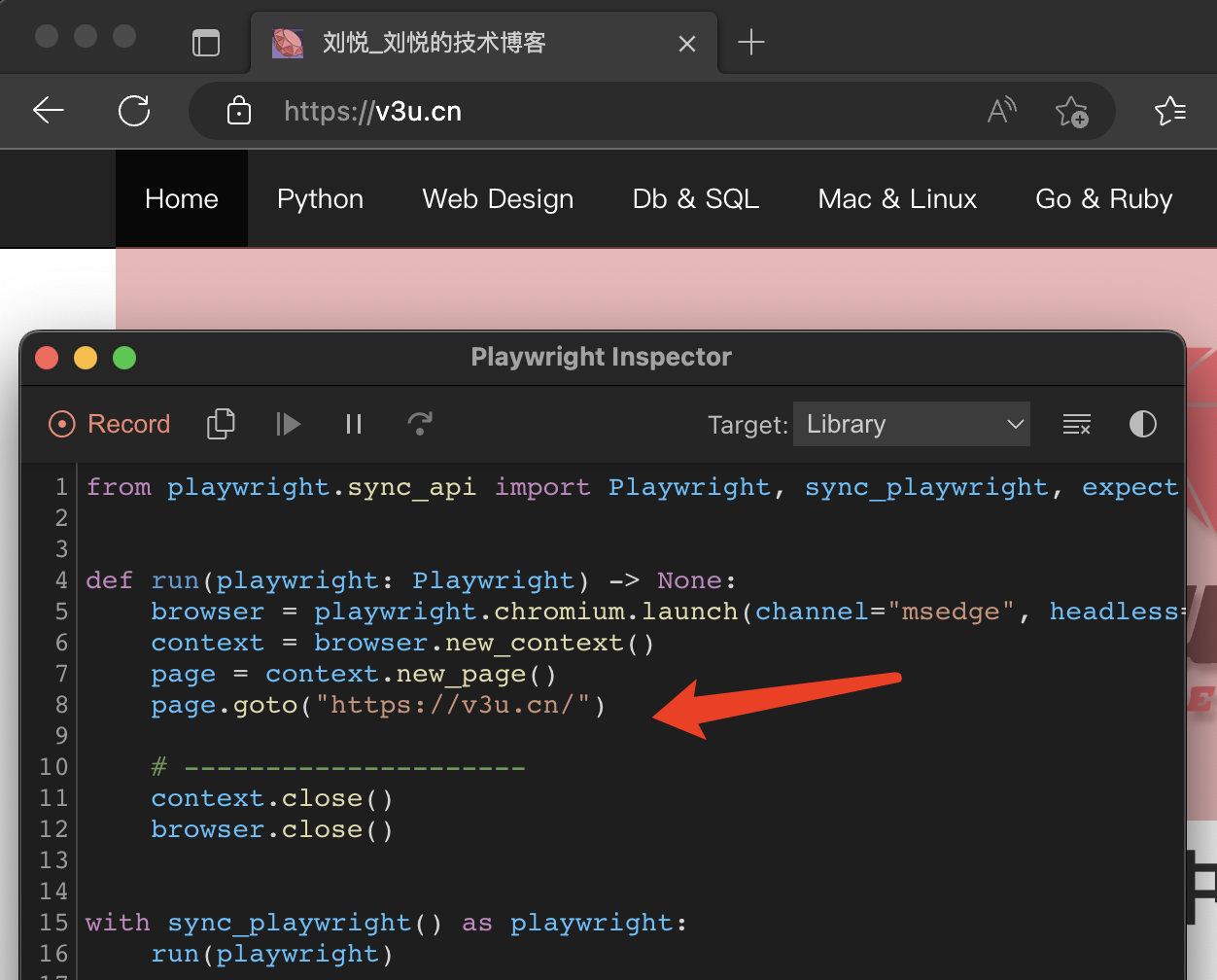

最炫酷的是,PlayWright可以对用户的浏览器操作进行录制,并且可以转换为相应的代码,在终端执行以下命令:

python -m playwright codegen --target python -o 'edge.py' -b chromium --channel=msedge

这里通过codegen命令进行录制,指定浏览器为edge,将所有操作写入edge.py的文件中:

与此同时,PlayWright也支持移动端的浏览器模拟,比如苹果手机:

from playwright.sync_api import sync_playwright

with sync_playwright() as p:

iphone_13 = p.devices['iPhone 13 Pro']

browser = p.webkit.launch(headless=False)

page = browser.new_page()

page.goto('https://v3u.cn')

page.screenshot(path='./v3u-iphone.png')

browser.close()

这里模拟Iphone13pro的浏览器访问情况.

当然了,除了UI功能测试,我们当然还需要PlayWright帮我们干点脏活累活,那就是爬虫:

from playwright.sync_api import sync_playwright

def extract_data(entry):

name = entry.locator("h3").inner_text().strip("\n").strip()

capital = entry.locator("span.country-capital").inner_text()

population = entry.locator("span.country-population").inner_text()

area = entry.locator("span.country-area").inner_text()

return {"name": name, "capital": capital, "population": population, "area (km sq)": area}

with sync_playwright() as p:

# launch the browser instance and define a new context

browser = p.chromium.launch()

context = browser.new_context()

# open a new tab and go to the website

page = context.new_page()

page.goto("https://www.scrapethissite.com/pages/simple/")

page.wait_for_load_state("load")

# get the countries

countries = page.locator("div.country")

n_countries = countries.count()

# loop through the elements and scrape the data

data = []

for i in range(n_countries):

entry = countries.nth(i)

sample = extract_data(entry)

data.append(sample)

browser.close()

这里data变量就是抓取的数据内容:

[

{'name': 'Andorra', 'capital': 'Andorra la Vella', 'population': '84000', 'area (km sq)': '468.0'},

{'name': 'United Arab Emirates', 'capital': 'Abu Dhabi', 'population': '4975593', 'area (km sq)': '82880.0'},

{'name': 'Afghanistan', 'capital': 'Kabul', 'population': '29121286', 'area (km sq)': '647500.0'},

{'name': 'Antigua and Barbuda', 'capital': "St. John's", 'population': '86754', 'area (km sq)': '443.0'},

{'name': 'Anguilla', 'capital': 'The Valley', 'population': '13254', 'area (km sq)': '102.0'},

...

]

基本上,该有的功能基本都有,更多功能请参见官方文档: https://playwright.dev/python/docs/library 。

Selenium曾经是用于网络抓取和网络自动化的最流行的开源无头浏览器工具之一。在使用 Selenium 进行抓取时,我们可以自动化浏览器、与 UI 元素交互并在 Web 应用程序上模仿用户操作。Selenium 的一些核心组件包括 WebDriver、Selenium IDE 和 Selenium Grid.

关于Selenium的一些基本操作请移玉步至: python3.7爬虫:使用Selenium带Cookie登录并且模拟进行表单上传文件 ,这里不作过多赘述.

如同前文提到的,与Playwright相比,Selenium需要第三方库来实现异步并发执行,同时,如果需要录制动作视频,也需要使用外部的解决方案.

就像Playwright那样,让我们使用 Selenium 构建一个简单的爬虫脚本.

首先导入必要的模块并配置 Selenium 实例,并且通过设置确保无头模式处于活动状态option.headless = True:

from selenium import webdriver

from selenium.webdriver.chrome.service import Service

from selenium.webdriver.common.by import By

# web driver manager: https://github.com/SergeyPirogov/webdriver_manager

# will help us automatically download the web driver binaries

# then we can use `Service` to manage the web driver's state.

from webdriver_manager.chrome import ChromeDriverManager

def extract_data(row):

name = row.find_element(By.TAG_NAME, "h3").text.strip("\n").strip()

capital = row.find_element(By.CSS_SELECTOR, "span.country-capital").text

population = row.find_element(By.CSS_SELECTOR, "span.country-population").text

area = row.find_element(By.CSS_SELECTOR, "span.country-area").text

return {"name": name, "capital": capital, "population": population, "area (km sq)": area}

options = webdriver.ChromeOptions()

options.headless = True

# this returns the path web driver downloaded

chrome_path = ChromeDriverManager().install()

# define the chrome service and pass it to the driver instance

chrome_service = Service(chrome_path)

driver = webdriver.Chrome(service=chrome_service, options=options)

url = "https://www.scrapethissite.com/pages/simple"

driver.get(url)

# get the data divs

countries = driver.find_elements(By.CSS_SELECTOR, "div.country")

# extract the data

data = list(map(extract_data, countries))

driver.quit()

数据返回:

[

{'name': 'Andorra', 'capital': 'Andorra la Vella', 'population': '84000', 'area (km sq)': '468.0'},

{'name': 'United Arab Emirates', 'capital': 'Abu Dhabi', 'population': '4975593', 'area (km sq)': '82880.0'},

{'name': 'Afghanistan', 'capital': 'Kabul', 'population': '29121286', 'area (km sq)': '647500.0'},

{'name': 'Antigua and Barbuda', 'capital': "St. John's", 'population': '86754', 'area (km sq)': '443.0'},

{'name': 'Anguilla', 'capital': 'The Valley', 'population': '13254', 'area (km sq)': '102.0'},

...

]

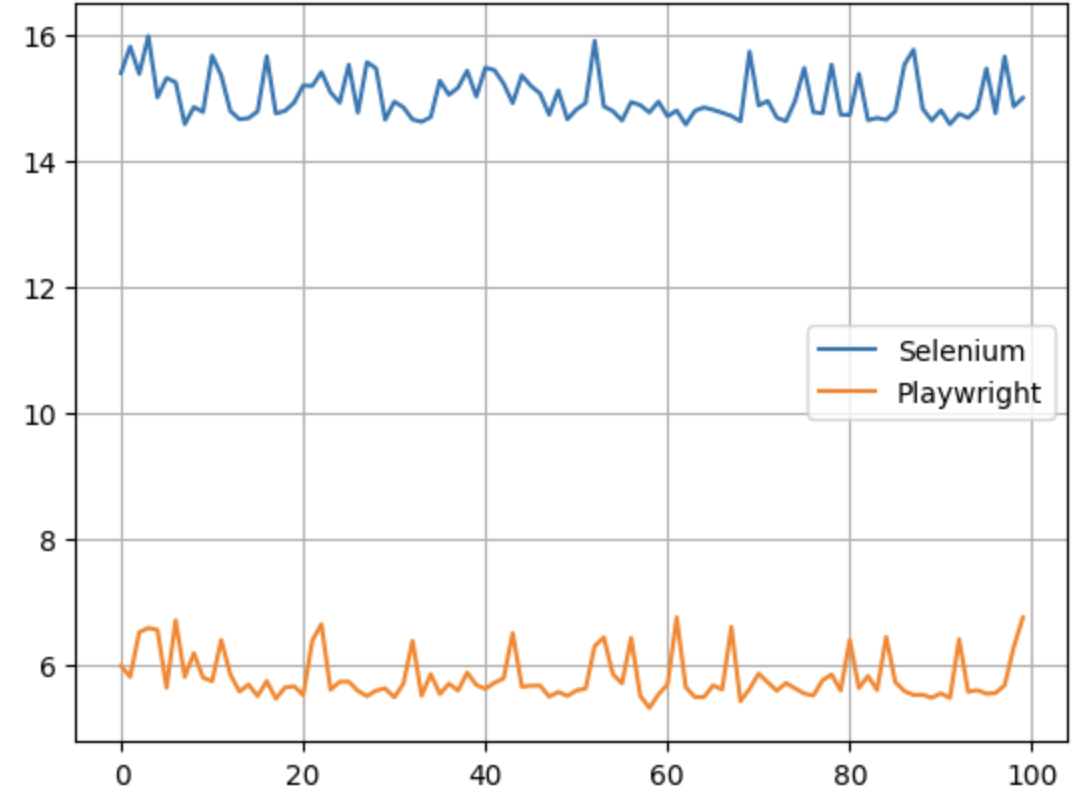

在数据抓取量一样的前提下,我们当然需要知道到底谁的性能更好,是PlayWright,还是Selenium?

这里我们使用Python3.10内置的time模块来统计爬虫脚本的执行速度.

PlayWright

import time

from playwright.sync_api import sync_playwright

def extract_data(entry):

name = entry.locator("h3").inner_text().strip("\n").strip()

capital = entry.locator("span.country-capital").inner_text()

population = entry.locator("span.country-population").inner_text()

area = entry.locator("span.country-area").inner_text()

return {"name": name, "capital": capital, "population": population, "area (km sq)": area}

start = time.time()

with sync_playwright() as p:

# launch the browser instance and define a new context

browser = p.chromium.launch()

context = browser.new_context()

# open a new tab and go to the website

page = context.new_page()

page.goto("https://www.scrapethissite.com/pages/")

# click to the first page and wait while page loads

page.locator("a[href='/pages/simple/']").click()

page.wait_for_load_state("load")

# get the countries

countries = page.locator("div.country")

n_countries = countries.count()

data = []

for i in range(n_countries):

entry = countries.nth(i)

sample = extract_data(entry)

data.append(sample)

browser.close()

end = time.time()

print(f"The whole script took: {end-start:.4f}")

Selenium

import time

from selenium import webdriver

from selenium.webdriver.chrome.service import Service

from selenium.webdriver.common.by import By

# web driver manager: https://github.com/SergeyPirogov/webdriver_manager

# will help us automatically download the web driver binaries

# then we can use `Service` to manage the web driver's state.

from webdriver_manager.chrome import ChromeDriverManager

def extract_data(row):

name = row.find_element(By.TAG_NAME, "h3").text.strip("\n").strip()

capital = row.find_element(By.CSS_SELECTOR, "span.country-capital").text

population = row.find_element(By.CSS_SELECTOR, "span.country-population").text

area = row.find_element(By.CSS_SELECTOR, "span.country-area").text

return {"name": name, "capital": capital, "population": population, "area (km sq)": area}

# start the timer

start = time.time()

options = webdriver.ChromeOptions()

options.headless = True

# this returns the path web driver downloaded

chrome_path = ChromeDriverManager().install()

# define the chrome service and pass it to the driver instance

chrome_service = Service(chrome_path)

driver = webdriver.Chrome(service=chrome_service, options=options)

url = "https://www.scrapethissite.com/pages/"

driver.get(url)

# get the first page and click to the link

first_page = driver.find_element(By.CSS_SELECTOR, "h3.page-title a")

first_page.click()

# get the data div and extract the data using beautifulsoup

countries_container = driver.find_element(By.CSS_SELECTOR, "section#countries div.container")

countries = driver.find_elements(By.CSS_SELECTOR, "div.country")

# scrape the data using extract_data function

data = list(map(extract_data, countries))

end = time.time()

print(f"The whole script took: {end-start:.4f}")

driver.quit()

测试结果

Y轴是执行时间,一望而知,Selenium比PlayWright差了大概五倍左右.

不得不承认,Playwright 和 Selenium 都是出色的自动化无头浏览器工具,都可以完成爬虫任务。我们还不能断定那个更好一点,所以选择那个取决于你的网络抓取需求、你想要抓取的数据类型、浏览器支持和其他考虑因素:

Playwright 不支持真实设备,而 Selenium 可用于真实设备和远程服务器.

Playwright 具有内置的异步并发支持,而 Selenium 需要第三方工具.

Playwright 的性能比 Selenium 高.

Selenium 不支持详细报告和视频录制等功能,而 Playwright 具有内置支持.

Selenium 比 Playwright 支持更多的浏览器.

Selenium 支持更多的编程语言.

如果您看完了本篇文章,那么到底谁是最好的无头浏览器工具,答案早已在心间,所谓强中强而立强,只有弱者才害怕竞争,相信PlayWright的出现会让Selenium变为更好的自己,再接再厉,再创辉煌.

最后此篇关于玫瑰花变蚊子血,自动化无痕浏览器对比测试,新贵PlayWrightVs老牌Selenium,基于Python3.10的文章就讲到这里了,如果你想了解更多关于玫瑰花变蚊子血,自动化无痕浏览器对比测试,新贵PlayWrightVs老牌Selenium,基于Python3.10的内容请搜索CFSDN的文章或继续浏览相关文章,希望大家以后支持我的博客! 。

我的“登录”是在 IE 浏览器中进行的,登录后,如果我单击链接,它们就会在 Chrome 浏览器中打开。如何在同一个测试用例中将我当前的浏览器从 IE 切换到 Chrome。如果我创建一个 chrom

您好,我不明白在 Firefox 的内容属性中使用的特殊字符的不同显示行为。我已经剥离了一切并创造了一支笔: http://codepen.io/rpkoller/pen/Fbgav 在其“基本形式”

我正在研究 Spring Data REST,特别是 HAL 浏览器。我一直在关注 http://docs.spring.io/spring-data/rest/docs/current/refere

我正在使用工具提示,在 ie 上出现定位错误。我放了jquery浏览器代码 我的工具提示 $('.tooltip').tooltip({ position: "bottom center"

我应该如何处理蓝鸟协程中的错误? 我使用co in节点已有一段时间,它具有出色的捕获功能。 co(function*() { return new Promise(function(resol

package webviewbrowser; import java.util.List; import javafx.application.Application; import javafx.

我有一些 JavaScript 在同一域上的两个独立服务器之间共享请求。 .com 是 JavaScript 中域的要求吗? 在这种情况下,两台服务器都位于 .abc.tyy 域上,tyy 通常是 .

package webviewbrowser; import java.util.List; import javafx.application.Application; import javafx.

我正在尝试构建仍支持 NPAPI 的先前版本的 Chromium 浏览器。我已经获得了代码,并且可以使用 stand build 命令在我的 mac 上构建最新版本的 Chromium gclient

我环顾四周,找不到 browscap 的 Python 等效项(我在 PHP 中使用它来检测给定的用户代理字符串是什么浏览器。 我希望我不必自己写......:P 最佳答案 看看这个,它应该做你想要的

是否有任何 chrome 或 firefox 扩展允许 javascript 在客户端 PC 中创建写入文件? 最佳答案 你想做什么? HTML5 有一个 File API .这是最好的解决方案,因为

当我点击链接或刷新或关闭标签页时,我有这段代码会发出警报。 但我需要在关闭 窗口(选项卡)上仅 发出警报。怎么做? 我的网站上有很多外部和内部链接。

我目前正在尝试使用 Browserify + Angular,但我遇到了一个奇怪的问题。我在我的 Controller 的子目录中创建了一个名为 controllers/start-controlle

我正在为客户(项目已被接受,但现在是解释不同功能的问题)写一份详细的估算,以开发一个响应式布局的网站。 这不是我第一次进行此类开发,但这是一个关键客户,必须铺平道路。 布局将从 300px 宽度调整到

我在时事通讯上设计了一些黑底白字。由于时事通讯在打印时看起来不错且可读。我需要使布局和文本与浏览器中的内容相似。 通常情况下,黑色文本和无背景颜色是浏览器/网络邮件客户端的默认打印样式吗? 最佳答案

我有一个使用 GWT/mGWT 构建的移动友好网络应用程序。该应用程序有白色输入文本框和深灰色输入文本。但是,在 Android 浏览器上,文本显示为白色,因此是不可见的。我尝试的所有 CSS 都无法

我创建了一个带有选择输入的页面来更改正在使用的 jQuery UI 主题。当主题更改时,它会存储在 cookie 中。页面加载时,如果 cookie 存在,则恢复主题,否则加载默认主题。 当我使用 F

在我的 CSS 中,我使用了以下代码片段: word-break: break-word; -webkit-hyphens: auto; hyphens: auto; 渲染引擎如何知道在所有不同语言中

我的网络浏览器 Safari 有问题,我在 Chrome、FireFox 中测试了我的网站。 Safari 版本也是正确的,但是,当需要在 1920x1080 或更高分辨率下对其进行测试时,它无法正常

就目前情况而言,这个问题不太适合我们的问答形式。我们希望答案得到事实、引用资料或专业知识的支持,但这个问题可能会引发辩论、争论、民意调查或扩展讨论。如果您觉得这个问题可以改进并可能重新开放,visit

我是一名优秀的程序员,十分优秀!