- Java锁的逻辑(结合对象头和ObjectMonitor)

- 还在用饼状图?来瞧瞧这些炫酷的百分比可视化新图形(附代码实现)⛵

- 自动注册实体类到EntityFrameworkCore上下文,并适配ABP及ABPVNext

- 基于Sklearn机器学习代码实战

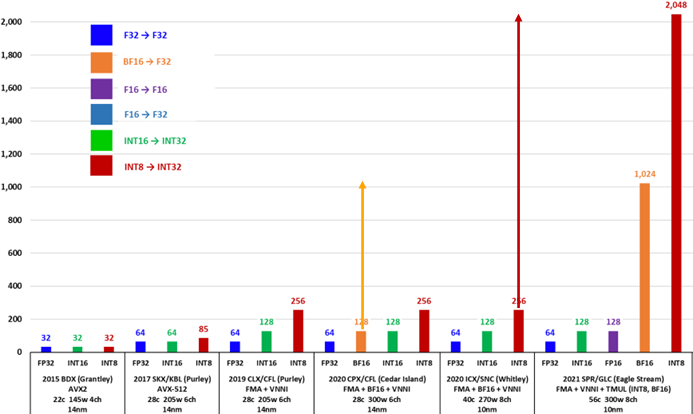

2016 年开始,随着 NV GPU AI 能力的不断加强,隐隐感觉到威胁的 Intel 也不断在面向数据中心的至强系列 CPU 上堆砌计算能力, 增加 core count 、 提高 frequency 、 增强向量协处理器计算能力 三管其下。几乎每一代 CPU 都在 AI 计算能力上有所增强或拓展,从这个方面来讲,如果我们说它没认识到 势 ,没有采取行动,也是不公平的.

从上图不难看到,2015年的 Sky Lake 首次引入了 AVX-512 (Advanced Vector eXtensions)向量协处理器,与上一代 Broadwell 的 AVX2 相比, 每个向量处理器单元的单精度浮点乘加吞吐翻倍。接着的 Cascade Lake 和 Cooper Lake 又拓展了 AVX-512 ,增加了对 INT8 和 BF16 精度的支持,奋力想守住 inference 的基本盘。一直到 Sapphire Rapids ,被市场和客户用脚投票,前有狼( NVIDIA )后有虎( AMD ),都把自己的食盆都快拱翻了,终于意识到在AI的计算能力上不能在按摩尔定律线性发育了,最终也步 Google 和 NVIDIA 的后尘,把 AVX 升一维成了 AMX (Advanced Matrix eXtension),即矩阵协处理器了。充分说明一句老话,你永远叫不醒一个装睡的人,要用火烧他。不管怎么样,这下总算是赛道对齐了,终于不是拿长茅对火枪了.

AI 工作负载 Top-2 的算子:

Convolution 。

MatMul/Fully Connected 。

这俩本质上都是矩阵乘。怎么计算矩阵乘,有两种化归方法:

化归成向量点积的组合,这在CPU中就对应AVX 。

化过程分块矩阵乘的组合,这在CPU就对应AMX 。

我们展开讲讲.

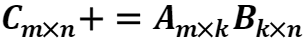

假设有如下矩阵乘问题:

。

AVX把向量作为一等公民,每次计算一个输出元素 ,而该元素等于 的第 行与 的第 列的点积,即有:

的块,多做几次就好了。这个

的块,多做几次就好了。这个

就是区分AVX各代的主要因素。下面以AVX2为例浅释一下。

就是区分AVX各代的主要因素。下面以AVX2为例浅释一下。

。

AVX2 FP32 (k=8) AVX2使用的寄存器长度为256 bit,也就是8个FP32数,此时 。AVX的乘加> 指令操作示意如下: 一个时钟周期可以完成两个8维向量的点积操作,也叫FMA(Fused Multiply > Add)操作。因此每个AVX单元的FLOPS为:16 FLOPS/cycle.

以FP32/BF16为例,AVX算力的代际演进如下,可以看出相邻代际增长是平平无奇的2倍.

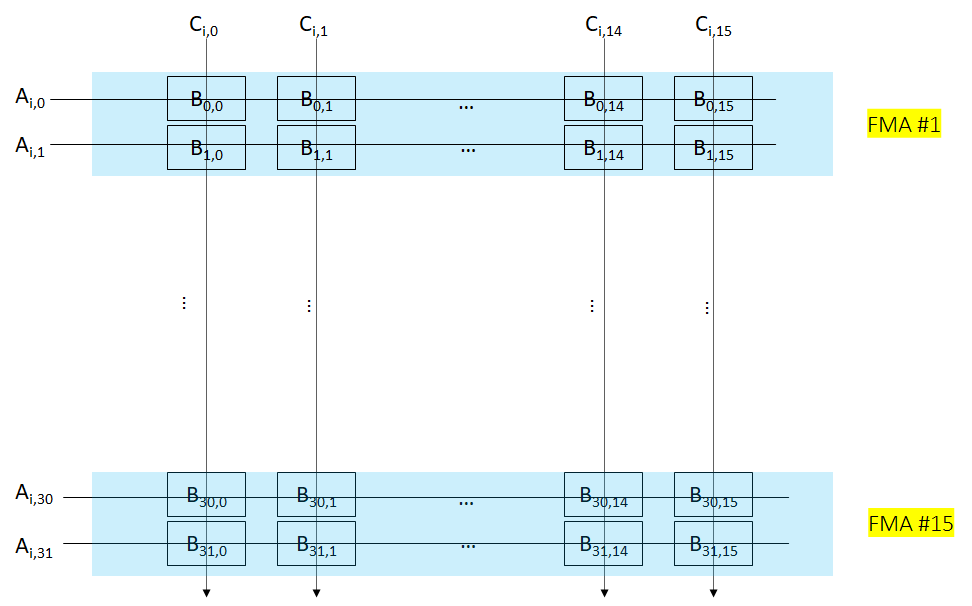

以BF16为例,AMX把矩阵乘操作化归为若干个 的分块矩阵乘的组合,如下所示.

需要注意的是整个操作需要16个cycle完成,因此不难计算每个AMX单元的FLOPS为:1024 OPS/cycle。这下单AMX单元与单AVX单元的每时钟周期的算力提高了16倍,有点像样了。目前Sapphire Rapids每个核有一个AMX单元,而有两个AVX单元,因此每核的每时钟周期算力提高倍数为8倍.

如何计算含有AMX CPU的peak TFLOPS 公式:

假设你有一个56核,每核有1个AMX单元,且AMX频率为1.9 GHz的CPU。其BF16 peak TFLOPS应为:

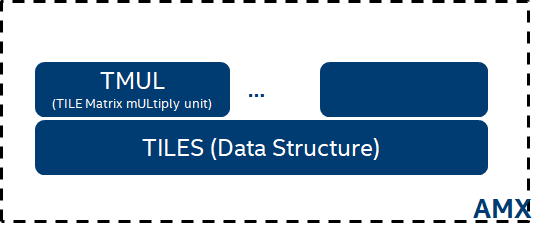

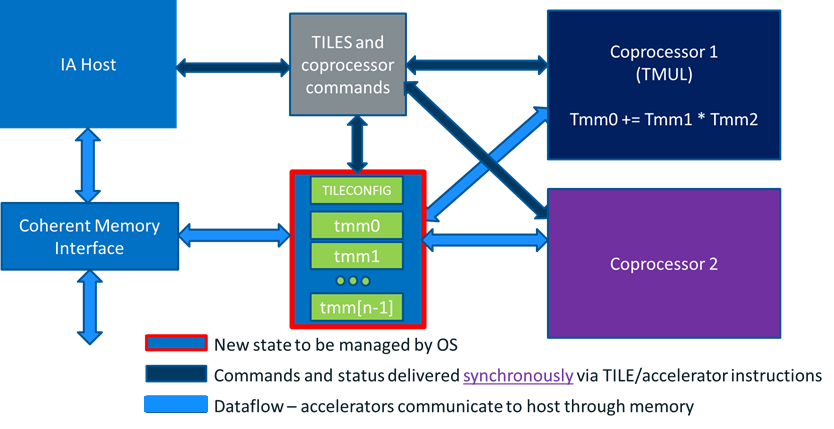

AMX围绕矩阵这一一等公民的支持分为计算和数据两个部分.

计算部分:目前仅有矩阵乘支持,由称为TMUL(Tile Matrix mULtiply Unit)的模块来实现。但也为后面支持其他的矩阵运算留了想像.

数据部分:由一组称为TILES的二维寄存器来承担.

其系统框图如下:

TMUL 硬件层面的实现也比较直观,是一个典型的systolic array设计。比较好的是array的每一行都复用了原来的AVX-512 BF16的设计,堆叠了16个AVX-512 BF16单元,在一个cycle内完成了一个 的运算,因此完成整个 的计算需要16个cycle.

Systolic形式的逻辑图,如下。可以看出每个cycle输出 的一行结果.

每个AMX单元共有8组TILES寄存器,TILE寄存器可以存放一个二维矩阵的子矩阵,有专门的load/store指令.

每个TILE寄存器容量为:16行 64 bytes,因此可用于存放:

的 FP32 矩阵 。

的 BF16 矩阵 。

的 INT8 矩阵 。

迈出脚只是路的开始,而不是结束。后面有的是路( 问题 ):

HW 。

TILE 和 memory 之间的 load 和 save 带宽与TMUL计算能力的匹配度 。

AI workload 一般都是矩阵操作(matmul, conv等)与向量操作混杂,而向量操作有分为 element-wise 操作和 reduce 类操作 。

这3类操作算力的匹配度 。

矩阵寄存器与向量寄存器之间的 data path 通畅度如何 。

…… 。

SW 。

如何提高SW efficiency 。

如何摆平AI框架要求的plain data layout与AMX硬件要求的data layout之间的re-layout开销 。

…… 。

让我们边走边看! 。

最后此篇关于CPUAMX详解的文章就讲到这里了,如果你想了解更多关于CPUAMX详解的内容请搜索CFSDN的文章或继续浏览相关文章,希望大家以后支持我的博客! 。

全称“Java Virtual Machine statistics monitoring tool”(statistics 统计;monitoring 监控;tool 工具) 用于监控虚拟机的各种运

主要是讲下Mongodb的索引的查看、创建、删除、类型说明,还有就是Explain执行计划的解释说明。 可以转载,但请注明出处。

1>单线程或者单进程 相当于短链接,当accept之后,就开始数据的接收和数据的发送,不接受新的连接,即一个server,一个client 不存在并发。 2>循环服务器和并发服务器

详解 linux中的关机和重启命令 一 shutdown命令 shutdown [选项] 时间 选项: ?

首先,将json串转为一个JObject对象: ? 1

matplotlib官网 matplotlib库默认英文字体 添加黑体(‘SimHei')为绘图字体 代码: plt.rcParams['font.sans-serif']=['SimHei'

在并发编程中,synchronized关键字是常出现的角色。之前我们都称呼synchronized关键字为重量锁,但是在jdk1.6中对synchronized进行了优化,引入了偏向锁、轻量锁。本篇

一般我们的项目中会使用1到2个数据库连接配置,同程艺龙的数据库连接配置被收拢到统一的配置中心,由DBA统一配置和维护,业务方通过某个字符串配置拿到的是Connection对象。

实例如下: ? 1

1. MemoryCahe NetCore中的缓存和System.Runtime.Caching很相似,但是在功能上做了增强,缓存的key支持object类型;提供了泛型支持;可以读缓存和单个缓存

argument是javascript中函数的一个特殊参数,例如下文,利用argument访问函数参数,判断函数是否执行 复制代码 代码如下: <script

一不小心装了一个Redis服务,开了一个全网的默认端口,一开始以为这台服务器没有公网ip,结果发现之后悔之莫及啊 某天发现cpu load高的出奇,发现一个minerd进程 占了大量cpu,googl

今天写这个是为了 提醒自己 编程过程 不仅要有逻辑 思想 还有要规范 代码 这样可读性 1、PHP 编程规范与编码习惯最主要的有以下几点: 1 文件说明 2 funct

摘要:虚拟机安装时一般都采用最小化安装,默认没有lspci工具。一台测试虚拟网卡性能的虚拟机,需要lspci工具来查看网卡的类型。本文描述了在一个虚拟机中安装lspci工具的具体步骤。 由于要测试

1、修改用户进程可打开文件数限制 在Linux平台上,无论编写客户端程序还是服务端程序,在进行高并发TCP连接处理时,最高的并发数量都要受到系统对用户单一进程同时可打开文件数量的限制(这是因为系统

目录 算术运算符 基本四则运算符 增量赋值运算符 自增/自减运算符 关系运算符 逻

如下所示: ? 1

MapperScannerConfigurer之sqlSessionFactory注入方式讲解 首先,Mybatis中的有一段配置非常方便,省去我们去写DaoImpl(Dao层实现类)的时间,这个

Linux的网络虚拟化是LXC项目中的一个子项目,LXC包括文件系统虚拟化,进程空间虚拟化,用户虚拟化,网络虚拟化,等等,这里使用LXC的网络虚拟化来模拟多个网络环境。 本文从基本的网络设备讲

? 1

我是一名优秀的程序员,十分优秀!